Solr导入MongoDB数据

数据导入方式:

全量导入和增量导入:

query 是全量导入时,把你的数据中查到的数据全部导入,deltaImportQuery 和 deltaQuery 是增量导入数据所需要的两个查询语句。deltaImportQuery 后面有个过滤条件是数据库中的唯一标识id = '${dataimporter.delta.id}' 后面这个id 是solr索引库中的id ,固定不变的。deltaQuery 的话后面只需要加个数据库中更新时间的字段 例如updateDate>'${dataimporter.last_index_time}' 即可 ,我们每次导入数据的时候会在索引库的conf 目录下的dataimport.properties文件中记录时间点 也就是last_index_time=日期,就是为了方便做增量索引。只要你的数据库中有更新了某些字段或者添加了新的条数(前提是表中必须有个任意更新字段就要更新updateDate 这个字段),我们只要做个定时的增量索引,就可以做到每次增量时,都可保证solr查询到的数据都是最新的。

全量索引和增量索引的配置区别,首先全量索引会把数据库中所有数据进行索引的更新,增量索引只更新数据库中增删改查过的,要使用增量索引,数据库中要有一个标识字段来表示数据的变化,我们可以使用时间戳来表示,数据更新时时间戳也更新,这样,solr通过比较时间戳的变化来增量更新索引。

Solr导入mongodb数据实例

使用开源项目mongo-connector实现Solr的增量导入功能:

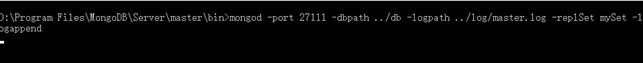

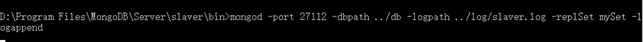

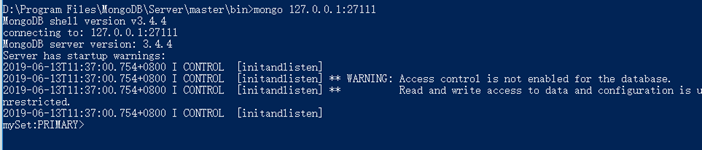

1、 配置mongodb的副本集群模式配置

配置启动mongodb副本集成功;

2、 安装mongo-connector

使用python安装:pip install 'mongo-connector[solr]'

3、solr配置 solrconfig.xml:

<requestHandler name="/admin/luke" class="org.apache.solr.handler.admin.LukeRequestHandler" />

solr配置managed-schema:

<uniqueKey>id</uniqueKey>

//修改为

<uniqueKey>_id</uniqueKey>

//添加

<field name="_id" type="string" indexed="true" stored="true" />

<field name="name" type="string" indexed="true" stored="true" />

<field name="area" type="string" indexed="true" stored="true"/>

//注释原有的

<field name="id" type="string" indexed="true" stored="true" required="true" multiValued="false" />

4、配置好后,访问如下地址,存在JSON数据则成功:

http://127.0.0.1:20001/solr/test01/admin/luke?show=schema&wt=json

5、连接配置

进入mongo-connector目录输入命令:

mongo-connector --auto-commit-interval=0 -m 127.0.0.1:27111 -t http://127.0.0.1:20001/solr/test01 -d solr_doc_manager

6、mongo数据库中插入数据:

7、solr中查询数据:如下图表示mongodb数据导入solr成功

Solr导入MongoDB数据的更多相关文章

- Solr导入数据库数据

接Solr-4.10.2与Tomcat整合.1.在solrconfig.xml中添加数据导入节点,solrconfig.xml路径为D:\solr\data\solr\collection1\conf ...

- solr导入数据库数据-tinyint数据转boolean

solr在导入mysql数据库数据时,遇到一个问题:数据类型为tinyint的数据对应不到solr中的数据类型,因此就需要将tinyint转一下. 修改schema.xml文件,如下: 1.添加boo ...

- Solr导入MySQL数据之dataimport-handler

Solr不借助手动JSolr编程情况下也可以将Mysql的数据导入到Solr中.实现方式是安装dataimport-Handler从关系数据库将数据导入到索引库. 1.向SolrCore中加入jar包 ...

- PowerBi利用Python Script绕过ODBC来导入MongoDB数据

- 【Solr】数据库数据导入索引库

目录 分析框图 配置数据库与solrconfig.xml 回到顶部 分析框图 框图画的粗糙!勿喷啊!勿喷啊! 回到顶部 配置数据库与solrconfig.xml Dataimport插件 可以批量把数 ...

- mongodb数据导入导出以及备份恢复

昨日在公司收到游戏方发来一个1G多的数据文件,要求导入联运账号中.细细一看,纳尼!文件竟然是BSON格式. 哇塞,这不是去年给大家分享的NoSql中的MongoDB的备份文件吗? 于是搭好环境 1.启 ...

- mongoDB 数据导出与导入

一.导出 命令格式:在mongodb/bin目录下 mongoexport -h IP --port 端口 -u 用户名 -p 密码 -d 数据库 -c 表名 -f 字段 -q 条件导出 --csv ...

- .Net程序员 Solr-5.3之旅 (三)Solr 从MSSQ导入索引数据

阅读目录 引言 准备工作 data-config.xml schema.xml 导入数据 结尾 附件下载 引言 Other men live to eat, while I eat to live.- ...

- 通过logstash-input-mongodb插件将mongodb数据导入ElasticSearch

目的很简单,就是将mongodb数据导入es建立相应索引.数据是从特定的网站扒下来,然后进行二次处理,也就是数据去重.清洗,接着再保存到mongodb里,那么如何将数据搞到ElasticSearch中 ...

随机推荐

- Build a Contest-创建比赛 CodeForce1100B

题目链接:Build a Contest 题目原文 Arkady coordinates rounds on some not really famous competitive programmin ...

- 带UI的小初高数学学习软件

结对编程项目总结 一.项目需求分析与功能总结 (1)用户注册功能 用户提供手机号码,点击注册将收到一个注册码,用户可使用该注册码完成注册. (2)设置密码功能 密码6-10位,必须含大小写字母和数 ...

- Centos7搭建Scrapy爬虫环境

写在前面 因为之前的爬虫环境一直是部署在我自己本地的电脑上的,最近,写了一个监控别人空间的爬虫,需要一直线上24小时运行,所有就打算云服务器上部署环境,也捣鼓了好一会才弄好,还是有一些坑,这里先记录一 ...

- visual c++.net 技术内幕 第6版 附带的程序如何在vs2013中编译成功

看vc++技术内幕时 如果你使用的是比此书的附带项目更新版的vs时千万不要使用这种方法,这些对编译都有影响. 请使用当前新版的vs并输入书中改动的代码就Ok,因为vs会生成合理的mfc代码,养成好的习 ...

- 转载:Docker入门只需看这一篇就够了

最近项目中需要用到 Docker 打包,于是上网查找资料学习了 Docker 的基本命令,记录一下自己遇到的一些错误. 准备开始自己写,结果看到了阮一峰老师的文章,瞬间就没有写下去的动力了,转载大佬的 ...

- 前端 NPM常用命令行

1. 登陆npm npm login 2. 将项目发布至npm npm publish 3. 查看已有源; 其中前面带星号的为当前使用的npm源 nrm ls 4. 切换源 nrm use 或 如: ...

- Kubernetes 系列(三):Kubernetes使用Traefik Ingress暴露服务

一.Kubernetes 服务暴露介绍 从 kubernetes 1.2 版本开始,kubernetes提供了 Ingress 对象来实现对外暴露服务:到目前为止 kubernetes 总共有三种暴露 ...

- 使用 BeanDefinition 描述 Spring Bean

什么是BeanDefinition 在Java中,一切皆对象.在JDK中使用java.lang.Class来描述类这个对象. 在Spring中,存在bean这样一个概念,那Spring又是怎么抽象be ...

- 2.css3表示颜色的几种方式

1.css3中表示颜色的几种方式: ⑴颜色名称.十六进制.RGB方式: ⑵RGBA方式:新增了alpha参数,介于0.0(完全透明)到1.0(完全不透明)之间: ⑶HSL方式:分别表示色调.饱和度.亮 ...

- ReentrantLock源码学习总结 (一)

[^ ]: 以下源码分析基于JDK1.8 ReentrantLock 示例 private ReentrantLock lock = new ReentrantLock(true); public v ...