03 什么是预训练(Transformer 前奏)

预训练有什么用

机器学习:偏数学(《统计学习方法》-李航)

深度学习(人工智能)的项目:大数据支持(主流)

我们很多项目没有大数据支持(小数据)

猫狗分类任务:100 张猫和狗的图片 --》给你一张图片,分出是猫还是狗(无法解决的一个问题,精度很低)

100000 张鹅和鸭的图片(已知,有人做过的,通过这10w 张图片做了一个模型 A)

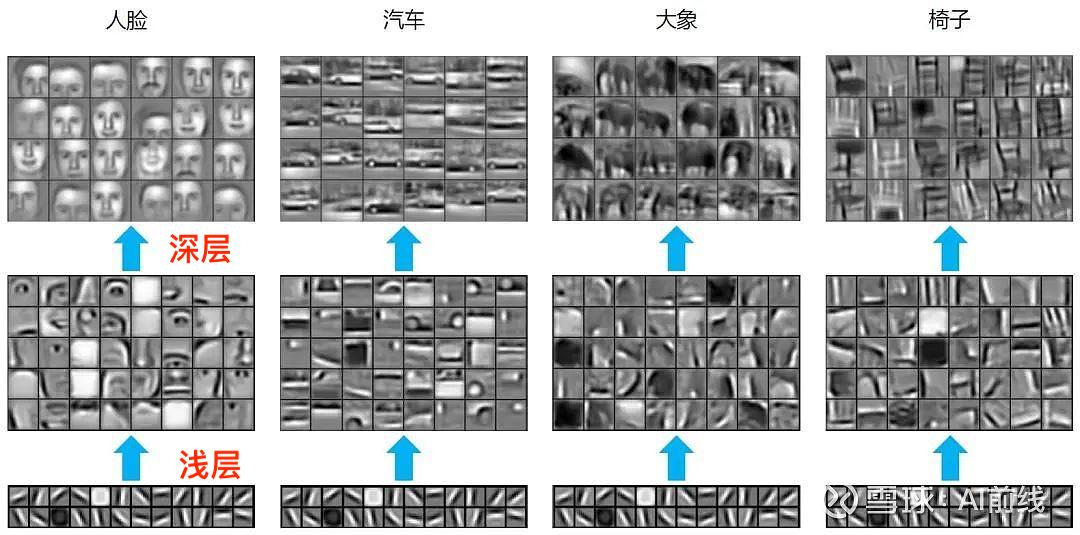

有人发现,浅层通用的(横竖撇捺)

我通过10w个鹅和鸭训练了一个模型 A,100 层的 CNN

任务 B:100 张猫和狗的图片,分类 --》 训练处 100层的 CNN,不可能实现的

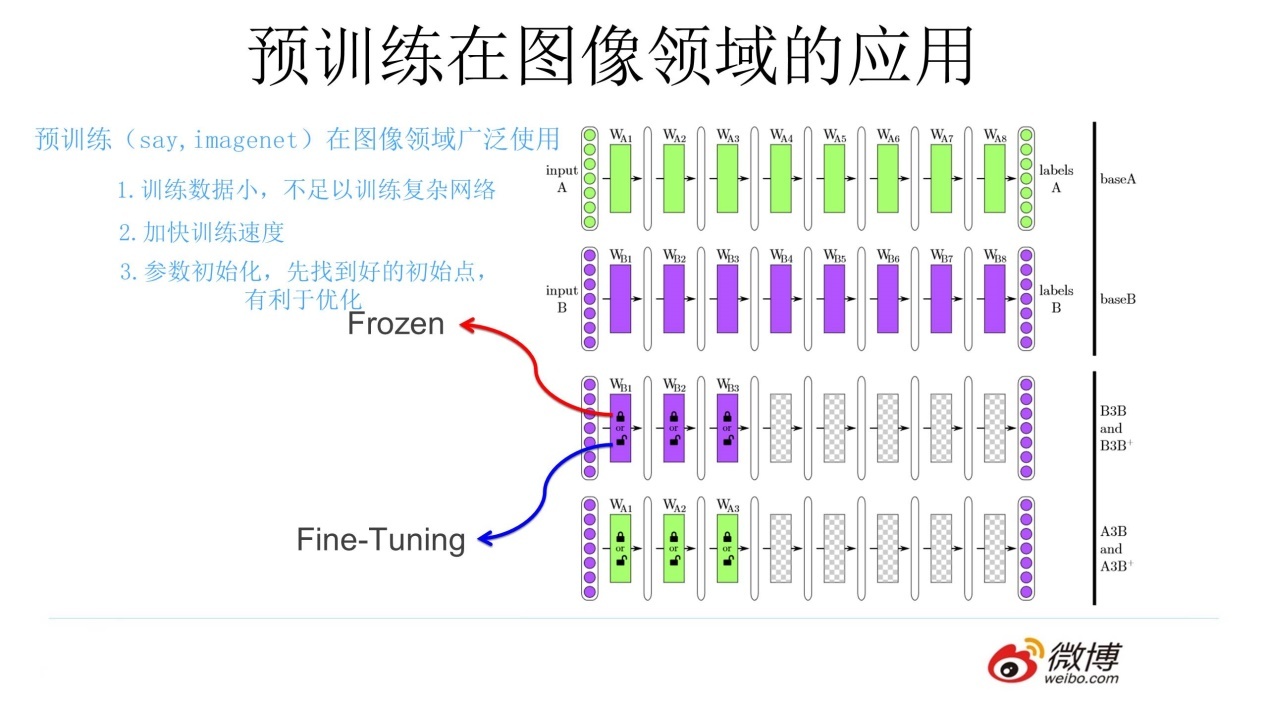

尝试使用 A 的前 50 层,使用 100 层去完成任务 B

- 冻结:浅层参数不变

- 微调:浅层参数会跟着任务 B 训练而改变

预训练是什么

通过一个已经训练好的模型 A,去完成一个小数据量的任务 B(使用了模型 A 的浅层参数)

任务 A 和任务 B 极其相似

预训练怎么用

fairseq 、transformers 库

总结

一个任务 A,一个任务 B,两者极其相似,任务 A 已经训练处一个模型 A,使用模型 A 的浅层参数去训练任务 B,得到模型 B,1.

03 什么是预训练(Transformer 前奏)的更多相关文章

- 【译】深度双向Transformer预训练【BERT第一作者分享】

目录 NLP中的预训练 语境表示 语境表示相关研究 存在的问题 BERT的解决方案 任务一:Masked LM 任务二:预测下一句 BERT 输入表示 模型结构--Transformer编码器 Tra ...

- 【转载】BERT:用于语义理解的深度双向预训练转换器(Transformer)

BERT:用于语义理解的深度双向预训练转换器(Transformer) 鉴于最近BERT在人工智能领域特别火,但相关中文资料却很少,因此将BERT论文理论部分(1-3节)翻译成中文以方便大家后续研 ...

- 知识图谱顶会论文(KDD-2022) kgTransformer:复杂逻辑查询的预训练知识图谱Transformer

论文标题:Mask and Reason: Pre-Training Knowledge Graph Transformers for Complex Logical Queries 论文地址: ht ...

- 【中文版 | 论文原文】BERT:语言理解的深度双向变换器预训练

BERT:Pre-training of Deep Bidirectional Transformers for Language Understanding 谷歌AI语言组论文<BERT:语言 ...

- 预训练语言模型的前世今生 - 从Word Embedding到BERT

预训练语言模型的前世今生 - 从Word Embedding到BERT 本篇文章共 24619 个词,一个字一个字手码的不容易,转载请标明出处:预训练语言模型的前世今生 - 从Word Embeddi ...

- 知识增强的预训练语言模型系列之KEPLER:如何针对上下文和知识图谱联合训练

原创作者 | 杨健 论文标题: KEPLER: A unified model for knowledge embedding and pre-trained language representat ...

- 从Word Embedding到Bert模型—自然语言处理中的预训练技术发展史(转载)

转载 https://zhuanlan.zhihu.com/p/49271699 首发于深度学习前沿笔记 写文章 从Word Embedding到Bert模型—自然语言处理中的预训练技术发展史 张 ...

- 【算法】Bert预训练源码阅读

Bert预训练源码 主要代码 地址:https://github.com/google-research/bert create_pretraning_data.py:原始文件转换为训练数据格式 to ...

- 文本分类实战(一)—— word2vec预训练词向量

1 大纲概述 文本分类这个系列将会有十篇左右,包括基于word2vec预训练的文本分类,与及基于最新的预训练模型(ELMo,BERT等)的文本分类.总共有以下系列: word2vec预训练词向量 te ...

- 第二十四节,TensorFlow下slim库函数的使用以及使用VGG网络进行预训练、迁移学习(附代码)

在介绍这一节之前,需要你对slim模型库有一些基本了解,具体可以参考第二十二节,TensorFlow中的图片分类模型库slim的使用.数据集处理,这一节我们会详细介绍slim模型库下面的一些函数的使用 ...

随机推荐

- 【Java】使用Druid连接池的监控面板排查慢SQL

默认在后台服务的地址: http://localhost:8078/druid/login.html 账号信息放在配置文件中获取: server: port: 8078 spring: datasou ...

- 【Java】【常用类】SimpleDateFormat 简单日期格式化类

Date类的API不易于国际化,大部分基本摈弃了 java.text.SimpleDateFormate 不和语言环境有关的方式来格式化和解析日期的具体类 支持 文本转格式,格式转文本 public ...

- 【转载】 Tensorflow如何直接使用预训练模型(vgg16为例)

版权声明:本文为博主原创文章,遵循 CC 4.0 BY-SA 版权协议,转载请附上原文出处链接和本声明.本文链接:https://blog.csdn.net/weixin_44633882/artic ...

- 基于Unity开发的强化学习环境(游戏环境):ml-agents —— Unity ML-Agents

介绍: https://medium.com/nerd-for-tech/an-introduction-to-machine-learning-with-unity-ml-agents-af7193 ...

- error while loading shared libraries: libxml2.so.2: cannot open shared object file 解决方法

参考: https://blog.csdn.net/qq_39779233/article/details/128215517 ==================================== ...

- 局域网环境下,如何在Ubuntu中发现Windows10下的共享文件夹

参考: https://blog.csdn.net/rangfei/article/details/124225799 ======================================== ...

- baselines算法库common/retro_wrappers.py模块分析

retro_wrappers.py模块代码: from collections import deque import cv2 cv2.ocl.setUseOpenCL(False) from .at ...

- 键盘中上、下、左、右四个光标键所对应的ASCII码值为多少

首先给出ASCII码值表: 上.下.左.右这四个光标键对应的ASCII码值不是一个值而是三个,准确的说光标键的ASCII码值是一个组合. 每个方向键所对应的三个键值为:0x1b + 0x5b + n ...

- Redis存储数组

建议使用PHP自带的序列化函数serialize和unserialize函数 <?php class MyRedis{ private static $handler; private stat ...

- vue 文件流下载

/** * 文件转为文件流 * @param {file} file //文件 */ export function getFileBlob(file) { var dataUrl va ...