hadoop安装入门

1.jdk安装和配置

1.1下载最新jdk文件

http://www.oracle.com/technetwork/java/javase/downloads/jdk7-downloads-1880260.html

1.2配置环境变量

vi /etc/profile

在文件末尾加入如下内容

JAVA_HOME=/usr/local/jdk

JAVA_CLASSPATH=$JAVA_HOME/lib

PATH=$JAVA_HOME/bin:$PATH

export JAVA_HOME JAVA_CLASSPATH PATH

并使上面文件生效

source /etc/profile

java -version

2.hadoop安装

首先需要配置运行环境,在etc/hadoop/hadoop-env.sh文件中增加

export JAVA_HOME=/usr/local/hadoop

一、配置core-site.xml

/usr/local/hadoop/etc/hadoop/core-site.xml 包含了hadoop启动时的配置信息。

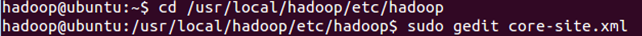

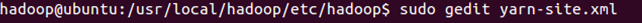

编辑器中打开此文件

sudo gedit /usr/local/hadoop/etc/hadoop/core-site.xml

在该文件的<configuration></configuration>之间增加如下内容:

<property>

<name>fs.default.name</name>

<value>hdfs://localhost:9000</value>

</property>

保存、关闭编辑窗口。

最终修改后的文件内容如下:

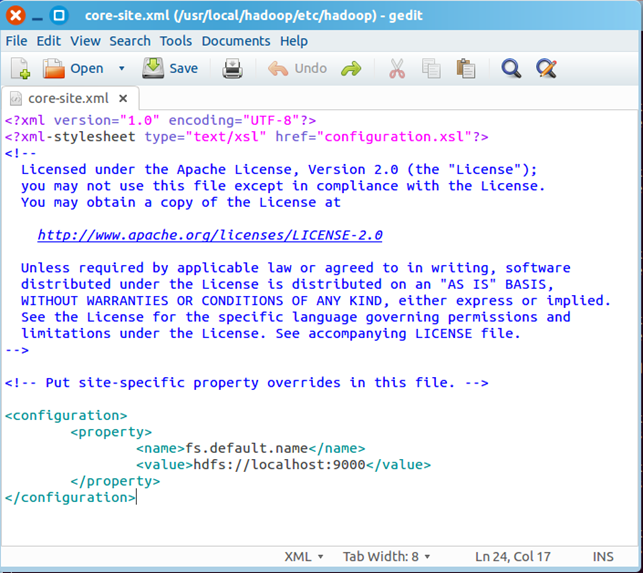

二、配置yarn-site.xml

/usr/local/hadoop/etc/hadoop/yarn-site.xml包含了MapReduce启动时的配置信息。

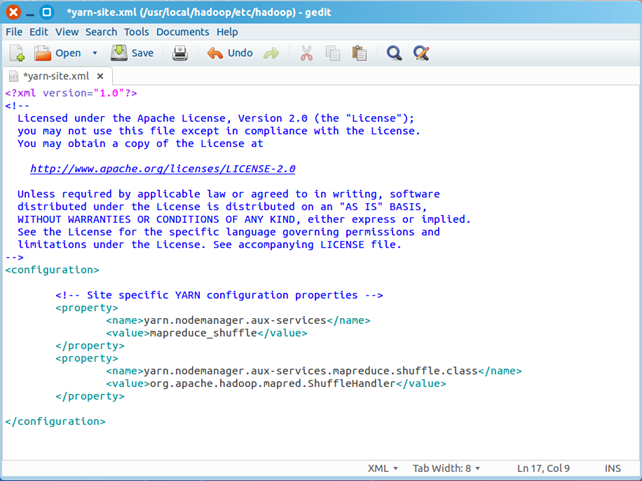

编辑器中打开此文件

sudo gedit yarn-site.xml

在该文件的<configuration></configuration>之间增加如下内容:

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.nodemanager.aux-services.mapreduce.shuffle.class</name>

<value>org.apache.hadoop.mapred.ShuffleHandler</value>

</property>

保存、关闭编辑窗口

最终修改后的文件内容如下

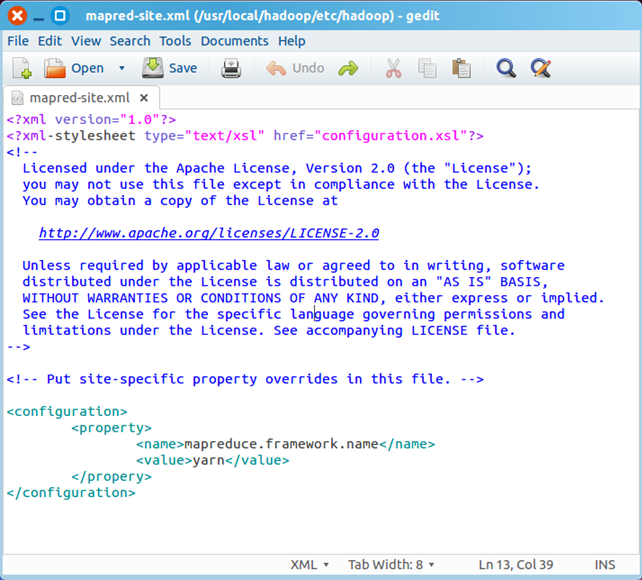

三、创建和配置mapred-site.xml

默认情况下,/usr/local/hadoop/etc/hadoop/文件夹下有mapred.xml.template文件,我们要复制该文件,并命名为mapred.xml,该文件用于指定MapReduce使用的框架。

复制并重命名

cp mapred-site.xml.template mapred-site.xml

编辑器打开此新建文件

sudo gedit mapred-site.xml

在该文件的<configuration></configuration>之间增加如下内容:

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

保存、关闭编辑窗口

最终修改后的文件内容如下

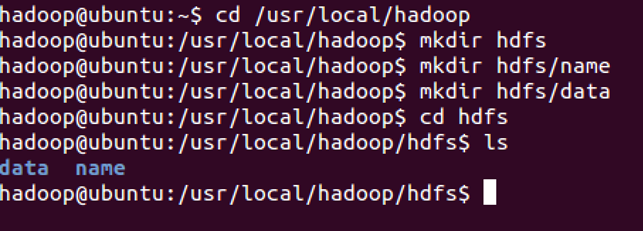

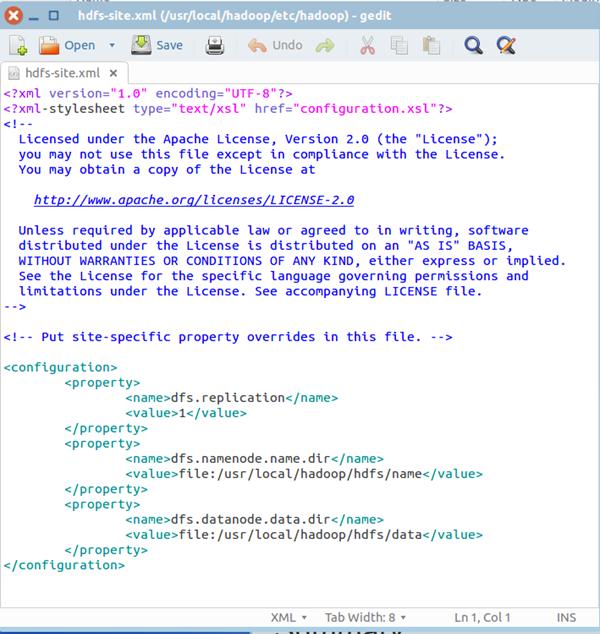

四、配置hdfs-site.xml

/usr/local/hadoop/etc/hadoop/hdfs-site.xml用来配置集群中每台主机都可用,指定主机上作为namenode和datanode的目录。

创建文件夹,如下图所示

你也可以在别的路径下创建上图的文件夹,名称也可以与上图不同,但是需要和hdfs-site.xml中的配置一致。

编辑器打开hdfs-site.xml

在该文件的<configuration></configuration>之间增加如下内容:

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>file:/usr/local/hadoop/hdfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>file:/usr/local/hadoop/hdfs/data</value>

</property>

保存、关闭编辑窗口

最终修改后的文件内容如下:

五、格式化hdfs

hdfs namenode -format

只需要执行一次即可,如果在hadoop已经使用后再次执行,会清除掉hdfs上的所有数据。

六、启动Hadoop

经过上文所描述配置和操作后,下面就可以启动这个单节点的集群

执行启动命令:

sbin/start-dfs.sh

执行该命令时,如果有yes /no提示,输入yes,回车即可。

接下来,执行:

sbin/start-yarn.sh

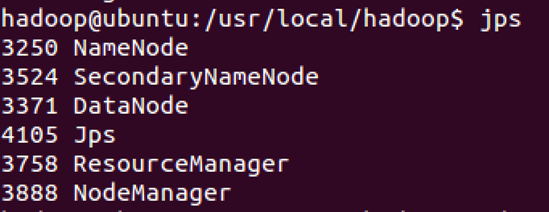

执行完这两个命令后,Hadoop会启动并运行

执行 jps命令,会看到Hadoop相关的进程,如下图:

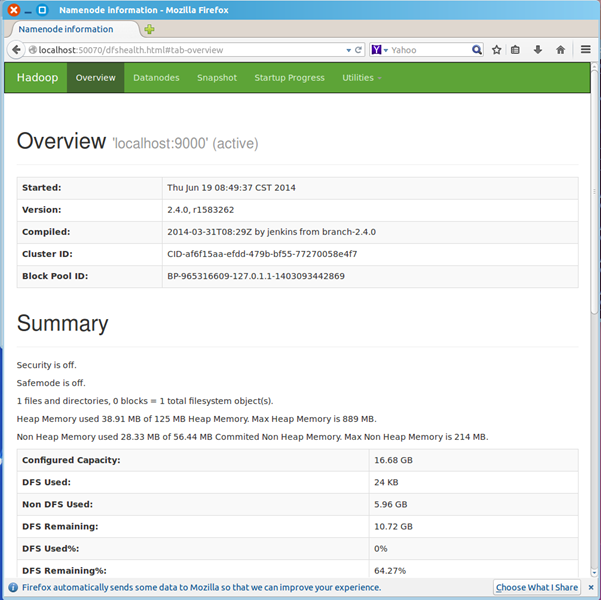

浏览器打开 http://localhost:50070/,会看到hdfs管理页面

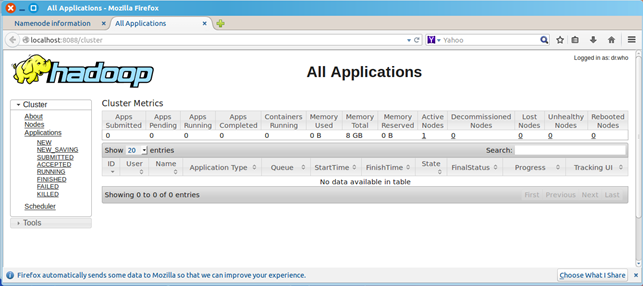

浏览器打开http://localhost:8088,会看到hadoop进程管理页面

七、WordCount验证

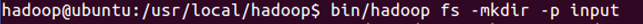

dfs上创建input目录

bin/hadoop fs -mkdir -p input

把hadoop目录下的README.txt拷贝到dfs新建的input里

hadoop fs -copyFromLocal README.txt input

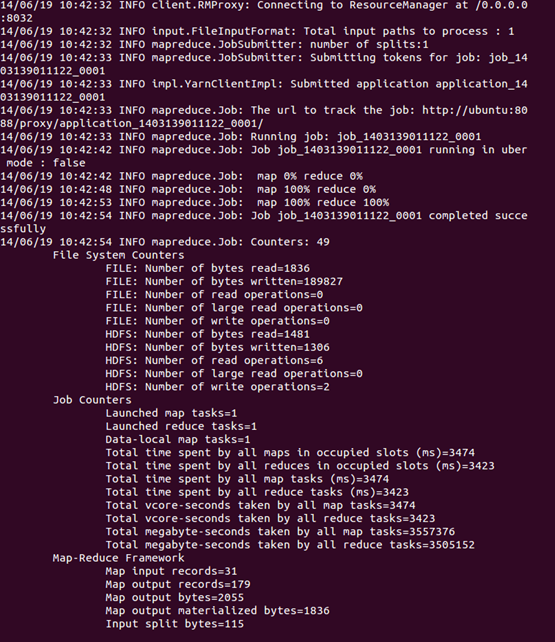

运行WordCount

hadoop jar share/hadoop/mapreduce/sources/hadoop-mapreduce-examples-2.4.0-sources.jar org.apache.hadoop.examples.WordCount input output

可以看到执行过程

运行完毕后,查看单词统计结果

hadoop fs -cat output/*

hadoop安装入门的更多相关文章

- 大数据入门:Hadoop安装、环境配置及检测

目录 1.导包Hadoop包 2.配置环境变量 3.把winutil包拷贝到Hadoop bin目录下 4.把Hadoop.dll放到system32下 5.检测Hadoop是否正常安装 5.1在ma ...

- [Hadoop入门] - 2 ubuntu安装与配置 hadoop安装与配置

ubuntu安装(这里我就不一一捉图了,只引用一个网址, 相信大家能力) ubuntu安装参考教程: http://jingyan.baidu.com/article/14bd256e0ca52eb ...

- Hadoop快速入门

目的 这篇文档的目的是帮助你快速完成单机上的Hadoop安装与使用以便你对Hadoop分布式文件系统(HDFS)和Map-Reduce框架有所体会,比如在HDFS上运行示例程序或简单作业等. 先决条件 ...

- Hadoop高速入门

Hadoop高速入门 先决条件 支持平台 GNU/Linux是产品开发和执行的平台. Hadoop已在有2000个节点的GNU/Linux主机组成的集群系统上得到验证. Win32平台是作为开发平台支 ...

- linux hadoop安装

linux hadoop安装 本文介绍如何在Linux下安装伪分布式的hadoop开发环境. 在一开始想利用cgywin在 windows下在哪, 但是一直卡在ssh的安装上.所以最后换位虚拟机+ub ...

- 转载:Hadoop安装教程_单机/伪分布式配置_Hadoop2.6.0/Ubuntu14.04

原文 http://www.powerxing.com/install-hadoop/ 当开始着手实践 Hadoop 时,安装 Hadoop 往往会成为新手的一道门槛.尽管安装其实很简单,书上有写到, ...

- hadoop安装遇到的各种异常及解决办法

hadoop安装遇到的各种异常及解决办法 异常一: 2014-03-13 11:10:23,665 INFO org.apache.hadoop.ipc.Client: Retrying connec ...

- hadoop安装实战(mac实操)

集群环境配置参考(http://blog.csdn.net/zcf1002797280/article/details/49500027) 参考:http://www.cnblogs.com/liul ...

- Solr安装入门、查询详解

Solr安装入门:http://www.importnew.com/12607.html 查询详解:http://www.360doc.com/content/14/0306/18/203871_35 ...

随机推荐

- vuejs学习--递归组件(树型表格分享)

前言 学习vue有一段时间了,最近使用vue做了一套后台管理系统,其中使用最多就是递归组件,也因为自己对官方文档的不熟悉使得自己踩了不少坑,今天写出来和大家一起分享. 递归组件 组件在它的模板内可以递 ...

- 初始Winsock编程

1.套接字的创建和关闭 使用套接字之前,必须使用socket函数创建一个套接字,此函数调用成功将返回一个套接字句柄. 1 SOCKET socket( 2 int af, //用来指定套接字使用的地址 ...

- PHP版本--HTTP session cookie原理及应用

PHP 的COOKIE cookie 是一种在远程浏览器端储存数据并以此来跟踪和识别用户的机制. PHP在http 协议的头信息里发送cookie,因此 setcookie()函数必须在其它 ...

- 在PHP中gmtime()与time()区别

localtime是把从1970-1-1零点零分到当前时间系统所偏移的秒数时间转换为本地时间,而gmtime函数转换后的时间没有经过时区变换,是UTC时间.2.说明:此函数获得的tm结构体的时间是日历 ...

- Servlet的一点小结

1.什么是servlet servlet是一个Java applet,一个帮助程序.用于帮助浏览器从服务器中获取资源.浏览器-servlet-服务器三者的关系如图所示. 2.servlet的生命周期 ...

- 《Playing hard exploration games by watching YouTube》论文解读

论文链接 油管链接 一.摘要 当环境奖励特别稀疏的时候,强化学习方法通常很难训练(traditionally struggle).一个有效的方式是通过人类示范者(human demonstrato ...

- Kubernetes(k8s)集群部署(k8s企业级Docker容器集群管理)系列之集群部署环境规划(一)

0.前言 整体架构目录:ASP.NET Core分布式项目实战-目录 k8s架构目录:Kubernetes(k8s)集群部署(k8s企业级Docker容器集群管理)系列目录 一.环境规划 软件 版本 ...

- iOS 9应用开发教程之使用开关滑块控件以及滚动部署视图

iOS 9应用开发教程之使用开关滑块控件以及滚动部署视图 使用ios9中的开关.滑块控件 开关和滑块也是用于和用户进行交互的控件.本节将主要讲解这两种控件. ios9开关 开关控件常用来控制某个功能的 ...

- 1005 Spell It Right (20)(20 point(s))

problem Given a non-negative integer N, your task is to compute the sum of all the digits of N, and ...

- JS AngualrJs 指令

本文基于 AngularJs 1.x 版本 内置指令 布尔属性 根据HTML标准的定义,布尔属性代表一个 true 或 false 值. 当这个属性出现时,这个属性的值就是 true (无论实际定义的 ...