Deep Learning of Graph Matching 阅读笔记

Deep Learning of Graph Matching 阅读笔记

CVPR2018的一篇文章,主要提出了一种利用深度神经网络实现端到端图匹配(Graph Matching)的方法. 该篇文章理论性较强,较难读懂。。。

介绍这篇文章之前,需要先了解一下什么是图匹配,图匹配是干嘛的。

图匹配

图匹配简单来说就是将已有的两个图中对应的顶点关联起来实现能量函数最大。以多目标跟踪任务来说,每帧图像中的观测都可以构成一个拓扑图,希望将两帧图像中的拓扑图匹配起来以实现同一条轨迹中的观测成功匹配。

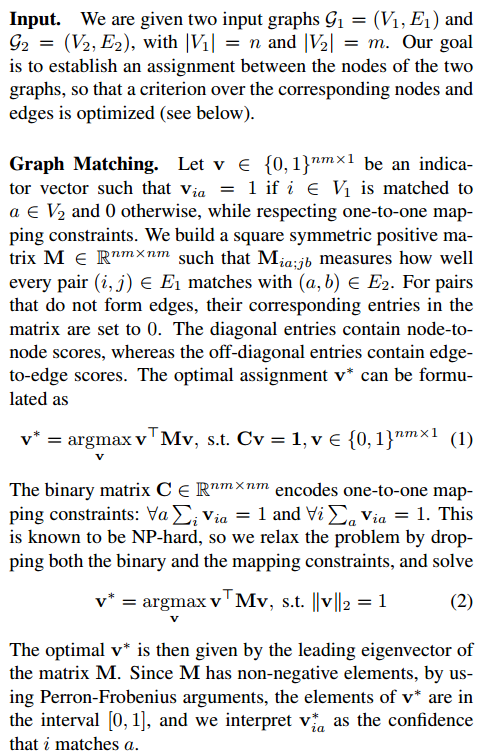

Formulation

这里需要说明的是,一般而言两个图之间节点的匹配,直接根据关联矩阵就可以了,比如 中分别有个节点,那么关联矩阵就决定了节点的匹配结果,但是这样只考虑了两个点之间的相似度而没有考虑更高阶信息。高阶信息,说起来挺玄的,其实就是更全局的信息。比如这里两个点之间是否匹配不仅仅取决这两个点之间的相似度还要考虑这两个点匹配的话对其他匹配的影响,从而选取一种匹配使得总体的能量最大。

举个简单的例子,现在有两个男孩 和两个女孩, 有一个挣钱的工作必须男女搭档完成(一股铜臭味,谁让我掉钱眼里了呢。。。),已知搭档性价比如下:

| 挣钱(元) | A | B |

|---|---|---|

| a | 1000 | 900 |

| b | 800 | 600 |

现在让你分组你怎么分?

那么这里是怎么刻画高阶信息的呢?其实是二阶信息。

还以这个例子来说,构建如下的矩阵

| Aa | Ab | Ba | Bb | |

|---|---|---|---|---|

| Aa | 1000 | 0 | 0 | 1600 |

| Ab | 0 | 800 | 1700 | 0 |

| Ba | 0 | 1700 | 900 | 0 |

| Bb | 1600 | 0 | 0 | 600 |

对角线表示两个点匹配的能量,称为边的unary energy, 非对角线表示对应的两个匹配同时成立的能量,比如(Aa, Bb)=1600表示Aa和Bb同时成立,(Aa,Ab)=0是因为A不可能同时分给两个人。

这里公式(1)其实约束有点问题 . 如果那么约束不可能同时成立。

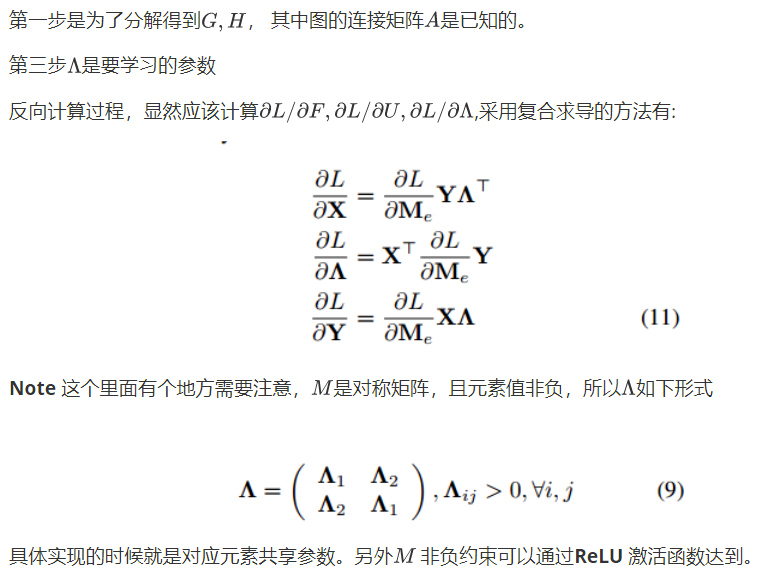

在使用深度学习框架学习的时候牵涉到大量的矩阵求导操作,所以论文首先给出了矩阵求导需要使用的公式:

这段话想说啥?无非就是矩阵的复合求导过程。

Deep Network Optimization for Graph Matching 框架

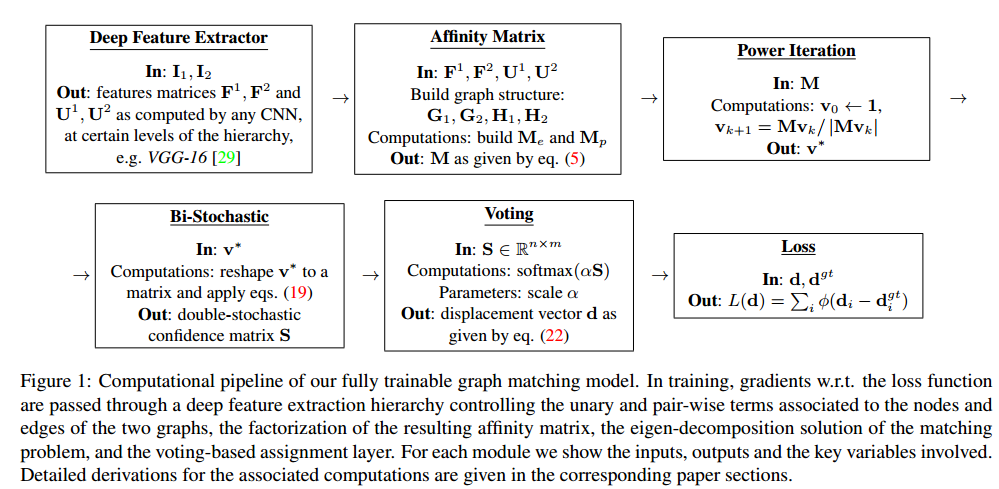

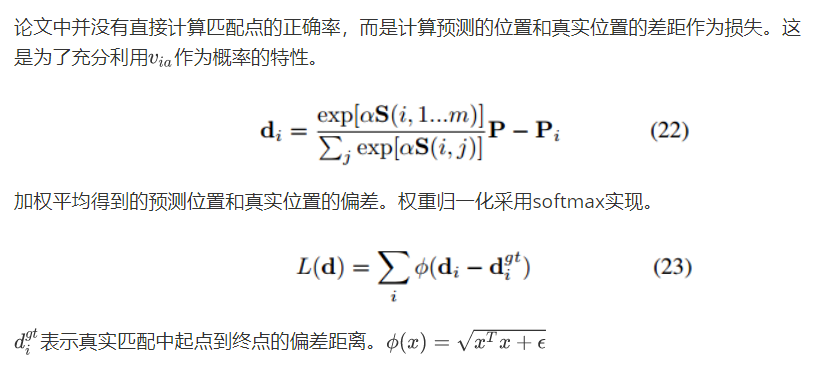

这里我们先来看看框架流程,先别管具体推导过程。首先利用深度学习框架生成每一个顶点的深度特征(Deep Feature Extractor), 然后将这些特征送到Affinity Matrix Layer生成Affinity Matrix, 接着采用幂迭代(Power Iteration)的方法对Affinity Matrix进行分解,再然后通过Bi-Stochastic layer添加 one-to-one约束,最后两层是用于计算网络损失的。

可以参考链接1,看看之前Affinity Matrix是怎么用Power Iteration分解的

可以发现矩阵分解部分就是直接将传统的操作放到了网络里面,所以本文实现的Deep Learning的重点其实是如何用深度网络构建Affinity Matrix。

Deep Network Optimation

OK, 不管愿不愿意,还是介绍到了公式的部分。。。

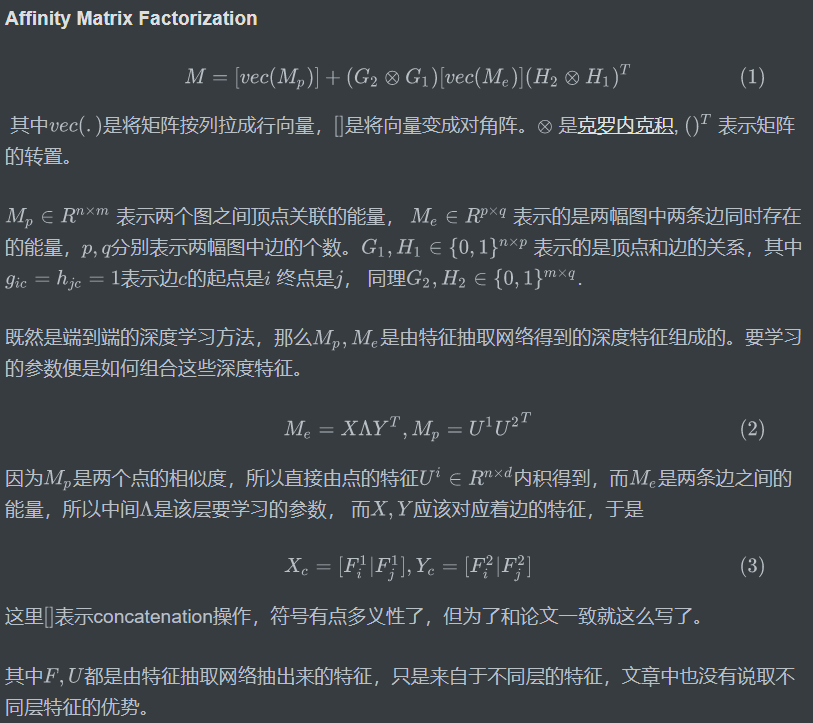

首当其中的就是Affinity Matrix Layer,直观上我们将顶点组合成edge,再由edge组成pairs然后放到网络里自然可以学到对应的能量,但是这样会导致计算规模太大,而且Affinity Matrix还有对称非负(元素非负)约束等。 而正是由于这些特性,可以将Affinity Matrix 分解成了两个较小部分再进行运算。

那么Affinity Matrix Layer的前向计算过程如下:

Power Iteration Layer

Bi-Stochastic Layer

Loss Layer

Experiments

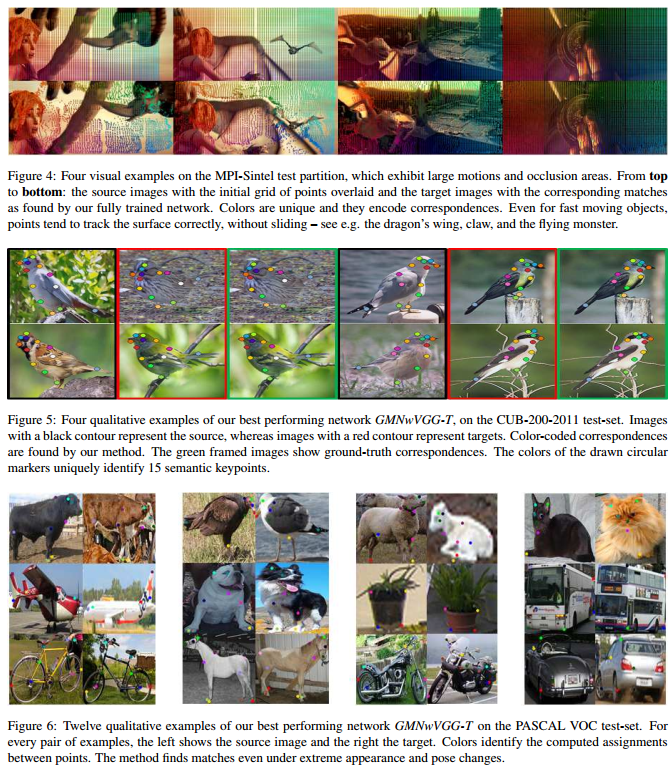

实验数据集我也不了解,具体就不介绍了,只看一下定性结果吧

Conclusion

We have presented an end-to-end learning framework for graph matching with general applicability to models containing deep feature extraction hierarchies and combinatorial optimization layers. We formulate the problem as a quadratic assignment under unary and pair-wise node relations represented using deep parametric feature hierarchies. All model parameters are trainable and the graph matching optimization is included within the learning formulation. As such, the main challenges are the calculation of backpropagated derivatives through complex matrix layers and the implementation of the entire framework (factorization of the affinity matrix, bi-stochastic layers) in a computationally efficient manner. Our experiments and ablation studies on diverse datasets like PASCAL VOC keypoints, Sintel and CUB show that fully learned graph matching models surpass nearest neighbor counterparts, or approaches that use deep feature hierarchies that were not refined jointly with (and constrained by) the quadratic assignment problem.

网络的计算还是相当耗时的,论文中也给出了一些加速的建议,不过这些加速会影响性能。

参考文献

Deep Learning of Graph Matching 阅读笔记的更多相关文章

- 《Deep Learning of Graph Matching》论文阅读

1. 论文概述 论文首次将深度学习同图匹配(Graph matching)结合,设计了end-to-end网络去学习图匹配过程. 1.1 网络学习的目标(输出) 是两个图(Graph)之间的相似度矩阵 ...

- Deep Learning深入研究整理学习笔记五

Deep Learning(深度学习)学习笔记整理系列 zouxy09@qq.com http://blog.csdn.net/zouxy09 作者:Zouxy version 1.0 2013-04 ...

- Deep Learning for NLP学习翻译笔记(2)

Deep Learning for NLP Deep Learning for NLP Lecture 2:Introduction to Teano enter link description h ...

- deep learning深度学习之学习笔记基于吴恩达coursera课程

feature study within neural network 在regression问题中,根据房子的size, #bedrooms原始特征可能演算出family size(可住家庭大小), ...

- 深度学习 Deep Learning UFLDL 最新 Tutorial 学习笔记 1:Linear Regression

1 前言 Andrew Ng的UFLDL在2014年9月底更新了. 对于開始研究Deep Learning的童鞋们来说这真的是极大的好消息! 新的Tutorial相比旧的Tutorial添加了Conv ...

- Deep Learning(深度学习) 学习笔记(四)

神经概率语言模型,内容分为三块:问题,模型与准则,实验结果.[此节内容未完待续...] 1,语言模型问题 语言模型问题就是给定一个语言词典包括v个单词,对一个字串做出二元推断,推断其是否符合该语言表达 ...

- 深度学习 Deep Learning UFLDL 最新Tutorial 学习笔记 5:Softmax Regression

Softmax Regression Tutorial地址:http://ufldl.stanford.edu/tutorial/supervised/SoftmaxRegression/ 从本节開始 ...

- 《Deep Learning》第二章 线性代数 笔记

第二章 线性代数 2.1 名词 标量(scalar).向量(vector).矩阵(matrix).张量(tensor) 2.2 矩阵和向量相乘 1. 正常矩阵乘法: 2. 向量点积: 3. Hadam ...

- 深度学习 Deep Learning UFLDL 最新Tutorial 学习笔记 3:Vectorization

1 Vectorization 简述 Vectorization 翻译过来就是向量化,各简单的理解就是实现矩阵计算. 为什么MATLAB叫MATLAB?大概就是Matrix Lab,最根本的差别于其它 ...

随机推荐

- Linux基础命令---dump

dump 检查ext2/3/4文件系统,确定哪些文件需要备份,这些需要备份的文件将会被复制到指定的磁盘或者其他存储介质.dump检查Ext 2/3/4文件系统上的文件,并确定哪些文件需要备份.这些文件 ...

- QQ群免IDKEY加群PHP源码

加群链接需要idkey的,该源码自动解析idkey,实现免idkey加群. 该源码来自彩虹秒赞系统. 例如:api.yum6.cn/qqun.php?qun=463631294 <?php /* ...

- C/C++之全局、static对象/变量的初始化问题

关于全局.static对象/变量的初始化问题 1. 全局变量.static变量的初始化时机:main()函数执行之前(或者说main中第一个用户语句执行之前). 2. 初始化顺序. 1)全局对象.外部 ...

- Python入门之字符编码

一.字节编码的基础知识 一.计算机基础知识 #1 我们的程序都是运行在特定的操作系统内,例如window,linux,mac等等#2 运行应用程序,需要要操作系统发出请求,我们双击运行的时候会向操作系 ...

- Python学习笔记之在Python中实现单例模式

有些时候你的项目中难免需要一些全局唯一的对象,这些对象大多是一些工具性的东西,在Python中实现单例模式并不是什么难事.以下总结几种方法: 使用类装饰器 使用装饰器实现单例类的时候,类本身并不知道自 ...

- CentOS7安装redis5.0

下载好redis5.0后解压在/tmp目录 cd /tmp/redis-/ make make过程中可能出现make[1]: *** [adlist.o] 错误 127,这是因为CentOS7默认没有 ...

- spring mybatis 3.2调用mysql存储过程返回多结果集(完整、亲测、可用)

最近,有个开发提了个需求,希望中间件支持调用mysql存储过程时支持多结果集返回,因为某些原因我们使用了不少的存储过程,很多复杂的逻辑目前来看交互非常的多,所以从当前的现状来说,这个需求还是蛮合理的. ...

- 20145321 《网络对抗技术》 Web安全基础实践

20145321<网络对抗技术> Web安全基础实践 基础问题回答 1.SQL注入攻击原理,如何防御? SQL注入就是通过把SQL命令插入到“Web表单递交”或“输入域名”或“页面请求”的 ...

- Python3基础 list reversed 列表逆转并输出

Python : 3.7.0 OS : Ubuntu 18.04.1 LTS IDE : PyCharm 2018.2.4 Conda ...

- Slf4j+LogBack使用参考

博文参考: 最简例子:https://blog.csdn.net/johnson_moon/article/details/77532583 Web中配置:https://blog.csdn.net/ ...