Python爬取网址中多个页面的信息

通过上一篇博客了解到爬取数据的操作,但对于存在多个页面的网址来说,使用上一篇博客中的代码爬取下来的资料并不完整。接下来就是讲解该如何爬取之后的页面信息。

一、审查元素

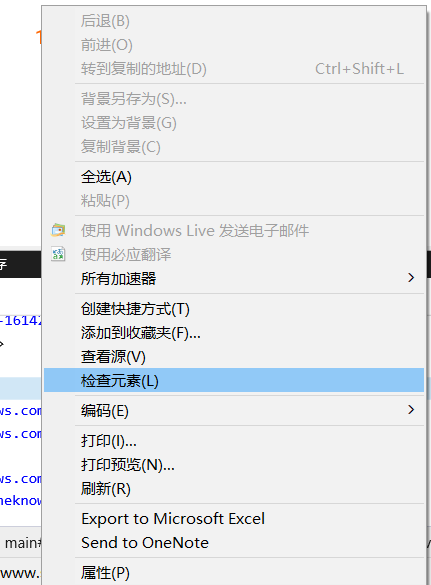

鼠标移至页码处右键,选择检查元素

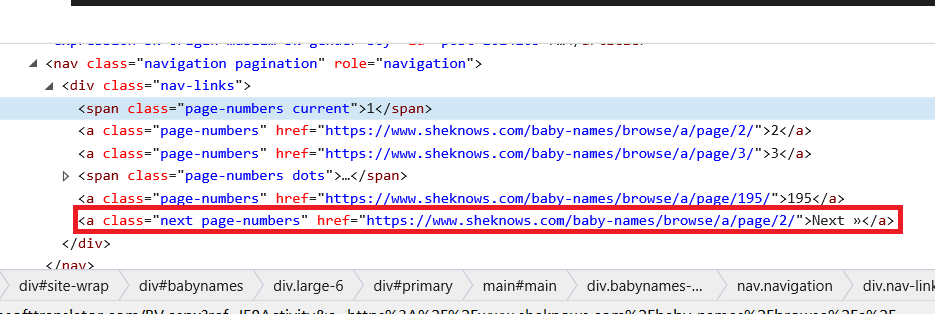

接着屏幕下方就会出现对应的html语句

二、分析html语句与项目要求

本次项目是爬取所有信息,根据第一步中的html语句,我们有两种爬取后续页面信息的方法:

方法一:循环访问本页面中的“下一页”链接直至该标签为空

即

def next_page(url):

soup=get_requests(url)

draw_base_list(soup)

pcxt=soup.find('div',{'class':'babynames-term-articles'}).find('nav')

pcxt1=pcxt.find('div',{'class':'nav-links'}).find('a',{'class':'next page-numbers'})

if pcxt1!=None:

link=pcxt1.get('href')

next_page(link)

else:

print("爬取完成")

方法二:获取总页数,通过更改url来爬取后续信息

通过html语句可以看出不同页数的url只有最后的数字不一样,而最后的数字就代表着这个url中的信息是第几页的信息。

页面中的html语句给出了总页码,我们只需要定位至该标签并获得总页数即可。

即

def get_page_size(soup):

pcxt=soup.find('div',{'class':'babynames-term-articles'}).find('nav')

pcxt1=pcxt.find('div',{'class':'nav-links'}).findAll('a')

for i in pcxt1[:-1]:

link=i.get('href')

s=str(i)

page=re.sub('<a class="page-numbers" href="','',s)

page1=re.sub(link,'',page)

page2=re.sub('">','',page1)

page3=re.sub('</a>','',page2)

pagesize=int(page3)

print(pagesize)

return pagesize

pass

获得总页数后这个模块还没有结束,我们还需要更改url来访问网址,也就是主函数的编写:

if __name__ == '__main__':

url="http://www.sheknows.com/baby-names/browse/a/"

soup=get_requests(url)

page=get_page_size(soup)

for i in range(1,page+1):

url1=url+"page/"+str(i)+"/"

soup1=get_requests(url1)

draw_base_list(soup1)

通过以上的两种方法就可以将多个页面中的信息都爬取下来了,赶紧动手试试吧。

Python爬取网址中多个页面的信息的更多相关文章

- python爬取豌豆荚中的详细信息并存储到SQL Server中

买了本书<精通Python网络爬虫>,看完了第6章,我感觉我好像可以干点什么:学的不多,其中的笔记我放到了GitHub上:https://github.com/NSGUF/PythonLe ...

- Python 爬取网页中JavaScript动态添加的内容(一)

当我们进行网页爬虫时,我们会利用一定的规则从返回的 HTML 数据中提取出有效的信息.但是如果网页中含有 JavaScript 代码,我们必须经过渲染处理才能获得原始数据.此时,如果我们仍采用常规方法 ...

- Python 爬取 北京市政府首都之窗信件列表-[信息展示]

日期:2020.01.25 博客期:133 星期六 [代码说明,如果要使用此页代码,必须在本博客页面评论区给予说明] //博客总体说明 1.准备工作 2.爬取工作 3.数据处理 4.信息展示(本期博客 ...

- Python 爬取网页中JavaScript动态添加的内容(二)

使用 selenium + phantomjs 实现 1.准备环境 selenium(一个用于web应用程测试的工具)安装:pip install seleniumphantomjs(是一种无界面的浏 ...

- python爬取网络中的QQ号码

import urllib.request import ssl import re import os #博客地址:https://blog.csdn.net/qq_36374896 def wri ...

- python 爬取国家粮食局东北地区玉米收购价格监测信息

#!/usr/bin/python# -*- coding: UTF-8 -*-import reimport sysimport timeimport urllibimport urllib.req ...

- 【转载】教你分分钟学会用python爬虫框架Scrapy爬取心目中的女神

原文:教你分分钟学会用python爬虫框架Scrapy爬取心目中的女神 本博文将带领你从入门到精通爬虫框架Scrapy,最终具备爬取任何网页的数据的能力.本文以校花网为例进行爬取,校花网:http:/ ...

- 一个自定义python分布式专用爬虫框架。支持断点爬取和确保消息100%不丢失,哪怕是在爬取进行中随意关停和随意对电脑断电。

0.此框架只能用于爬虫,由框架来调度url请求,必须按照此方式开发,没有做到类似celery的通用分布式功能,也不方便测试.可以使用另外一个,基于函数式编程的,调度一切函数的分布式框架,做到了兼容任何 ...

- 04 Python网络爬虫 <<爬取get/post请求的页面数据>>之requests模块

一. urllib库 urllib是Python自带的一个用于爬虫的库,其主要作用就是可以通过代码模拟浏览器发送请求.其常被用到的子模块在Python3中的为urllib.request和urllib ...

随机推荐

- .net之大文件断点续传

HTML部分 <%@ Page Language="C#" AutoEventWireup="true" CodeBehind="index.a ...

- Windows异常

一.什么是异常 异常指的是在程序运行过程中发生的异常事件,通常是由外部问题(如硬件错误.输入错误)所导致的.简单来说异常就是对于非预期状况的处理,当我们在运行某个程序时出现了异常状况,就会进入异常处理 ...

- 23、CacheManager原理剖析与源码分析

一.图解 二.源码分析 ###org.apache.spark.rdd/RDD.scalal ###入口 final def iterator(split: Partition, context: T ...

- mysql设置主键自增长和自增长初始值

本文主要向大家介绍MySQL数据库之Mysql创建表实现主键自增并且初始值为200,希望对大家学习MySQL数据库有所帮助. 假设已经创建表test,并且主键为id.Mysql ...

- python定制后处理云图

用后处理软件处理的云图会出现这样或那样的不满意,其实我们可以将求解数据导出以后,借助python定制云图. 我们以fluent为例 求解完成之后,我们将我们需要做云图的物理量以ASCII导出 如下的p ...

- .NET Core教程--给API加一个服务端缓存啦

以前给API接口写缓存基本都是这样写代码: // redis key var bookRedisKey = ConstRedisKey.RecommendationBooks.CopyOne(book ...

- RecyclerView 实现快速滚动 (转)

RecyclerView 实现快速滚动 极小光 简书作者 简评:Android Support Library 26 中终于实现了一个等待已久的功能:RecyclerView 的快速滚动. An ...

- 微信小程序开发者工具详解

一.微信小程序web开发工具下载地址 1.1 在微信公众平台-小程序里边去下载开发工具下载地址. 1.2 下载后安装一下就可以使用了: 二.创建项目 2.1 微信小程序web开发工具需要扫码登陆,所以 ...

- (信贷风控九)行为评分卡模型python实现

python信用评分卡建模(附代码,博主录制) https://study.163.com/course/introduction.htm?courseId=1005214003&utm_ca ...

- 小D课堂 - 零基础入门SpringBoot2.X到实战_第8节 数据库操作之整合Mybaties和事务讲解_32..SpringBoot2.x持久化数据方式介绍

笔记 1.SpringBoot2.x持久化数据方式介绍 简介:介绍近几年常用的访问数据库的方式和优缺点 1.原始java访问数据库 开发流程麻烦 ...