注意力机制最新综述:A Comprehensive Overview of the Developments in Attention Mechanism

(零)注意力模型(Attention Model)

1)本质:【选择重要的部分】,注意力权重的大小体现选择概率值,以非均匀的方式重点关注感兴趣的部分。

2)注意力机制已成为人工智能的一个重要概念,其在计算机视觉、自然语言处理等众多领域得到了广泛的研究和应用。

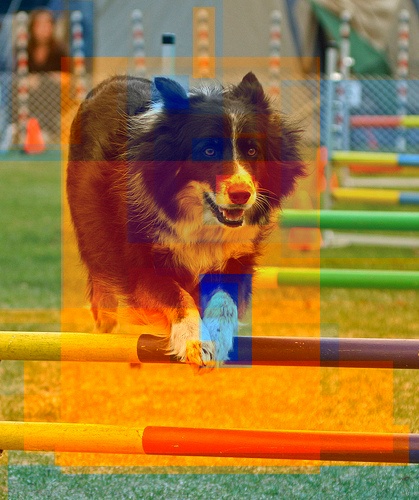

3)注意力机制模仿了生物观察行为的内部过程。例如,视觉处理系统倾向于有选择地关注图像某些部分,而忽略其他无关的信息,以一种有助于感知的方式(our visual processing system tends to focus selectively on some parts of the image, while ignoring other irrelevant information in a manner that can assist in perception.)如下图所示。

输入的某些部分比其余部分更重要,这种性质在大多数的任务中是通用和重要的,例如,在机器翻译和摘要任务(machine translation and summarization)中,只有输入序列中的特定单词可能与预测下一个单词有关。同样的,在视觉字幕(image captioning)中,输入图像中某些区域可能对于生成字幕中的下一个单词更重要。

4)注意力机制是上述直觉的具体实现:整合相关部分,使模型动态地仅关注输入的重要部分,从而更有效地实现任务(allowing the model to dynamically pay attention to only certain parts of the input )。

5)了解了注意力的起因和作用后,下面分别介绍:(一)通用注意力模型,(二)不同类型的注意力模型分类,(三)不同架构的注意力模型。

(一)通用注意力模型(Generalized Attention Model)

通用的注意力模型包括两个输入:查询Query ($q$) 和内容Keys(表示为: $\bf{k}$$=k_1,$ $k_2,$ $\ldots,$ $k_n$),而注意力模型可以看做:相对于查询 $q$,将 $q$与一系列内容Keys 的相关性 $\bf{s}=\{s_i\}_{i=1}^{n}$(也称为对齐),映射为注意力分布 $\bf{\alpha}$$=\{ \alpha_i\}_{i=1}^{n}$ 的过程。注意力分布$\alpha_i$强调的是:相对于查询$q$,每个内容$k_i$与其的相关程度。

因此,关于两个输入 $q$ 和 $\bf{k}$,通用注意力的计算过程涉及到两个计算步骤:1)确定Query和Keys的相关性,即$s_i = s(q, k_i)$,其中$s(\cdot)$为对齐函数(Alignment function);2)将一系列相关程度映射为注意力分布$\bf{\alpha}=p(\bf{s})$,其中$p(\cdot)$为分布函数(Distribution function)。因此,注意力模型可以表示为:

s_1, s_2, \ldots,s_i

$k_1,$ $ k_2,$ $ \ldots,$ $ k_n$)

$s_i = s(q, k_i)$,

($\bf{\alpha}=p(\bf{s})$)

注意力机制最新综述:A Comprehensive Overview of the Developments in Attention Mechanism的更多相关文章

- TensorFlow LSTM 注意力机制图解

TensorFlow LSTM Attention 机制图解 深度学习的最新趋势是注意力机制.在接受采访时,现任OpenAI研究主管的Ilya Sutskever提到,注意力机制是最令人兴奋的进步之一 ...

- 自适应注意力机制在Image Caption中的应用

在碎片化阅读充斥眼球的时代,越来越少的人会去关注每篇论文背后的探索和思考. 在这个栏目里,你会快速 get 每篇精选论文的亮点和痛点,时刻紧跟 AI 前沿成果. 点击本文底部的「阅读原文」即刻加入社区 ...

- (转)注意力机制(Attention Mechanism)在自然语言处理中的应用

注意力机制(Attention Mechanism)在自然语言处理中的应用 本文转自:http://www.cnblogs.com/robert-dlut/p/5952032.html 近年来,深度 ...

- 注意力机制(Attention Mechanism)在自然语言处理中的应用

注意力机制(Attention Mechanism)在自然语言处理中的应用 近年来,深度学习的研究越来越深入,在各个领域也都获得了不少突破性的进展.基于注意力(attention)机制的神经网络成为了 ...

- Deep Learning论文笔记之(八)Deep Learning最新综述

Deep Learning论文笔记之(八)Deep Learning最新综述 zouxy09@qq.com http://blog.csdn.net/zouxy09 自己平时看了一些论文,但老感觉看完 ...

- 自然语言处理中的自注意力机制(Self-attention Mechanism)

自然语言处理中的自注意力机制(Self-attention Mechanism) 近年来,注意力(Attention)机制被广泛应用到基于深度学习的自然语言处理(NLP)各个任务中,之前我对早期注意力 ...

- 深度学习之注意力机制(Attention Mechanism)和Seq2Seq

这篇文章整理有关注意力机制(Attention Mechanism )的知识,主要涉及以下几点内容: 1.注意力机制是为了解决什么问题而提出来的? 2.软性注意力机制的数学原理: 3.软性注意力机制. ...

- Pytorch系列教程-使用Seq2Seq网络和注意力机制进行机器翻译

前言 本系列教程为pytorch官网文档翻译.本文对应官网地址:https://pytorch.org/tutorials/intermediate/seq2seq_translation_tutor ...

- DeepLearning.ai学习笔记(五)序列模型 -- week2 序列模型和注意力机制

一.基础模型 假设要翻译下面这句话: "简将要在9月访问中国" 正确的翻译结果应该是: "Jane is visiting China in September" ...

随机推荐

- JavaCV的摄像头实战之七:推流(带声音)

欢迎访问我的GitHub 这里分类和汇总了欣宸的全部原创(含配套源码):https://github.com/zq2599/blog_demos 本篇概览 本文是<JavaCV的摄像头实战> ...

- 1.1 Qt Creater使用Python开发桌面软件的操作流程

Qt Creater及Python的下载与安装过程不再赘述,读者可自行在网上搜索相应的下载与安装方法. 首先我们打开Qt Creater,单击"Create Project"按钮或 ...

- 3.2 常用Linux命令

1.ifconfig命令 ifconfig命令用于获取网卡配置与网络状态等信息,英文全称为"interface config",语法格式为"ifconfig [参数] [ ...

- 攻防世界-MISC:hit-the-core

这是攻防世界MISC高手进阶区的题目,题目如下: 点击下载附件一,解压后得到一个后缀为.core的文件,用string分离一下,得到如下结果: 通过观察发现,每隔四个小写字母就可以看到一个大写字母,刚 ...

- Spring mvc 使用@RequestBody 500错误

今天在使用@RequestBody的时候,遇到一个http500错误,记录一下 让我们来看看我是怎么样错的,贴上代码 @PostMapping("/User") public Us ...

- OA办公软件篇(三)—审批流

背景 作用 迭代历程 具体实现 写在最后 背景 在前面两篇文章中,我们分别讲了组织架构和权限管理,今天我们来讲一个跟组织架构关系比较密切的功能-审批流. 审批流,通俗来说就是一个完整的审批流程,是 ...

- Linux-流程控制语法-函数-属组

1.流程控制 1.1 条件选择 1.1.1选择执行if语句 格式: if COMMANDS; then COMMANDS; [ elif COMMANDS; then COMMANDS; ] ... ...

- range内部代码

def my_range(a, b=None, c=1): if not b: b = a a = 0 while a < b: yield a a += c

- Json序列化与反序列化导致多线程运行速度和单线程运行速度一致问题

紧跟上篇文章 十个进程开启十个bash后一致写入命令执行完毕之后产生了很多很多的文件,博主需要对这些文件同意处理,也就是说对几十万个文件进行处理,想了又想,单线程处理那么多数据肯定不行,于是乎想到了使 ...

- 在vue-cli中安装scss,且可以全局引入scss的步骤

简历魔板__个人简历模板在线生成 在写vue的css样式时,觉得需要css预处理器让自己的css更加简洁.适应性更强.可读性更佳,更易于代码的维护,于是在vue-cli脚手架采用scss.写过的人都知 ...