Spark项目之电商用户行为分析大数据平台之(十二)Spark上下文构建及模拟数据生成

一、模拟生成数据

package com.bw.test; import java.util.ArrayList;

import java.util.Arrays;

import java.util.List;

import java.util.Random;

import java.util.UUID; import com.bw.util.DateUtils;

import com.bw.util.StringUtils;

import org.apache.spark.api.java.JavaRDD;

import org.apache.spark.api.java.JavaSparkContext;

import org.apache.spark.sql.DataFrame;

import org.apache.spark.sql.Row;

import org.apache.spark.sql.RowFactory;

import org.apache.spark.sql.SQLContext;

import org.apache.spark.sql.types.DataTypes;

import org.apache.spark.sql.types.StructType; /**

* 模拟数据程序

* @author Administrator

*

*/

public class MockData { /**

* 模拟数据

* @param sc

* @param sqlContext

*/

public static void mock(JavaSparkContext sc,

SQLContext sqlContext) {

List<Row> rows = new ArrayList<Row>(); String[] searchKeywords = new String[] {"火锅", "蛋糕", "重庆辣子鸡", "重庆小面",

"呷哺呷哺", "新辣道鱼火锅", "国贸大厦", "太古商场", "日本料理", "温泉"};

String date = DateUtils.getTodayDate();

String[] actions = new String[]{"search", "click", "order", "pay"};

Random random = new Random(); for(int i = 0; i < 100; i++) {

//生产100个userID

long userid = random.nextInt(100); for(int j = 0; j < 10; j++) {

//每个userID有10个sessionID

String sessionid = UUID.randomUUID().toString().replace("-", "");

String baseActionTime = date + " " + random.nextInt(23); Long clickCategoryId = null;

//每个sessionID可能会做0-100之间的action操作

for(int k = 0; k < random.nextInt(100); k++) {

long pageid = random.nextInt(10);

String actionTime = baseActionTime + ":" + StringUtils.fulfuill(String.valueOf(random.nextInt(59))) + ":" + StringUtils.fulfuill(String.valueOf(random.nextInt(59)));

String searchKeyword = null;

Long clickProductId = null;

String orderCategoryIds = null;

String orderProductIds = null;

String payCategoryIds = null;

String payProductIds = null; String action = actions[random.nextInt(4)];

if("search".equals(action)) {

searchKeyword = searchKeywords[random.nextInt(10)];

} else if("click".equals(action)) {

if(clickCategoryId == null) {

clickCategoryId = Long.valueOf(String.valueOf(random.nextInt(100)));

}

clickProductId = Long.valueOf(String.valueOf(random.nextInt(100)));

} else if("order".equals(action)) {

orderCategoryIds = String.valueOf(random.nextInt(100));

orderProductIds = String.valueOf(random.nextInt(100));

} else if("pay".equals(action)) {

payCategoryIds = String.valueOf(random.nextInt(100));

payProductIds = String.valueOf(random.nextInt(100));

} Row row = RowFactory.create(date, userid, sessionid,

pageid, actionTime, searchKeyword,

clickCategoryId, clickProductId,

orderCategoryIds, orderProductIds,

payCategoryIds, payProductIds,

Long.valueOf(String.valueOf(random.nextInt(10))));

rows.add(row);

}

}

} JavaRDD<Row> rowsRDD = sc.parallelize(rows); StructType schema = DataTypes.createStructType(Arrays.asList(

DataTypes.createStructField("date", DataTypes.StringType, true),

DataTypes.createStructField("user_id", DataTypes.LongType, true),

DataTypes.createStructField("session_id", DataTypes.StringType, true),

DataTypes.createStructField("page_id", DataTypes.LongType, true),

DataTypes.createStructField("action_time", DataTypes.StringType, true),

DataTypes.createStructField("search_keyword", DataTypes.StringType, true),

DataTypes.createStructField("click_category_id", DataTypes.LongType, true),

DataTypes.createStructField("click_product_id", DataTypes.LongType, true),

DataTypes.createStructField("order_category_ids", DataTypes.StringType, true),

DataTypes.createStructField("order_product_ids", DataTypes.StringType, true),

DataTypes.createStructField("pay_category_ids", DataTypes.StringType, true),

DataTypes.createStructField("pay_product_ids", DataTypes.StringType, true),

DataTypes.createStructField("city_id", DataTypes.LongType, true))); DataFrame df = sqlContext.createDataFrame(rowsRDD, schema); df.registerTempTable("user_visit_action");

for(Row _row : df.take(1)) {

System.out.println(_row);

} /**

* ==================================================================

*/ rows.clear();

String[] sexes = new String[]{"male", "female"};

for(int i = 0; i < 100; i ++) {

long userid = i;

String username = "user" + i;

String name = "name" + i;

int age = random.nextInt(60);

String professional = "professional" + random.nextInt(100);

String city = "city" + random.nextInt(100);

String sex = sexes[random.nextInt(2)]; Row row = RowFactory.create(userid, username, name, age,

professional, city, sex);

rows.add(row);

} rowsRDD = sc.parallelize(rows); StructType schema2 = DataTypes.createStructType(Arrays.asList(

DataTypes.createStructField("user_id", DataTypes.LongType, true),

DataTypes.createStructField("username", DataTypes.StringType, true),

DataTypes.createStructField("name", DataTypes.StringType, true),

DataTypes.createStructField("age", DataTypes.IntegerType, true),

DataTypes.createStructField("professional", DataTypes.StringType, true),

DataTypes.createStructField("city", DataTypes.StringType, true),

DataTypes.createStructField("sex", DataTypes.StringType, true))); DataFrame df2 = sqlContext.createDataFrame(rowsRDD, schema2);

for(Row _row : df2.take(1)) {

System.out.println(_row);

} df2.registerTempTable("user_info"); /**

* ==================================================================

*/

rows.clear(); int[] productStatus = new int[]{0, 1}; for(int i = 0; i < 100; i ++) {

long productId = i;

String productName = "product" + i;

String extendInfo = "{\"product_status\": " + productStatus[random.nextInt(2)] + "}"; Row row = RowFactory.create(productId, productName, extendInfo);

rows.add(row);

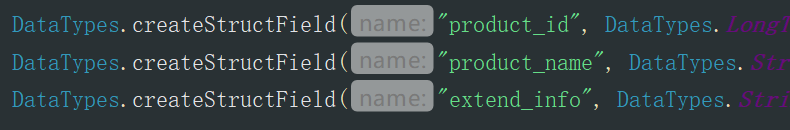

} rowsRDD = sc.parallelize(rows); StructType schema3 = DataTypes.createStructType(Arrays.asList(

DataTypes.createStructField("product_id", DataTypes.LongType, true),

DataTypes.createStructField("product_name", DataTypes.StringType, true),

DataTypes.createStructField("extend_info", DataTypes.StringType, true))); DataFrame df3 = sqlContext.createDataFrame(rowsRDD, schema3);

for(Row _row : df3.take(1)) {

System.out.println(_row);

} df3.registerTempTable("product_info");

} }

二、构建Spark上下文

import com.bw.conf.ConfigurationManager;

import com.bw.constant.Constants;

import com.bw.test.MockData;

import org.apache.spark.SparkConf;

import org.apache.spark.api.java.JavaSparkContext;

import org.apache.spark.sql.SQLContext; /**

* 用户访问session分析Spark作业

*

* */

public class UserVisitSessionAnalyzeSpark { public static void main(String[] args) {

//构建Spark上下文

SparkConf sparkConf = new SparkConf();

//Spark作业本地运行

sparkConf.setMaster("local");

//为了符合大型企业的开发需求,不能出现硬编码,创建一个Constants接口类,定义一些常量

sparkConf.setAppName(Constants.SPARK_APP_NAME_SESSION); JavaSparkContext jsc = new JavaSparkContext(sparkConf);

SQLContext sqlContext = new SQLContext(jsc); mockData(jsc,sqlContext);

jsc.stop();

} /**

* 生成模拟数据(只有本地模式,才会去生成模拟数据)

* @param sc

* @param sqlContext

*/

private static void mockData(JavaSparkContext sc, SQLContext sqlContext) {

boolean local = ConfigurationManager.getBoolean(Constants.SPARK_LOCAL);

if(local) {

MockData.mock(sc, sqlContext);

}

}

}

三、打印的测试数据

3.1 user_visit_action

用户下的订单

[2018-05-23,34,4ad62c0824194e5687467bb84b9beeb9,3,2018-05-23 18:27:37,null,null,null,null,null,8,64,8]

3.2 user_info

[0,user0,name0,26,professional11,city4,male]

3.3 product_info

[0,product0,{"product_status": 1}]

Spark项目之电商用户行为分析大数据平台之(十二)Spark上下文构建及模拟数据生成的更多相关文章

- Spark项目之电商用户行为分析大数据平台之(六)用户访问session分析模块介绍

一.对用户访问session进行分析 1.可以根据使用者指定的某些条件,筛选出指定的一些用户(有特定年龄.职业.城市): 2.对这些用户在指定日期范围内发起的session,进行聚合统计,比如,统计出 ...

- Spark项目之电商用户行为分析大数据平台之(七)数据调研--基本数据结构介绍

一.user_visit_action(Hive表) 1.1 表的结构 date:日期,代表这个用户点击行为是在哪一天发生的user_id:代表这个点击行为是哪一个用户执行的session_id :唯 ...

- Spark项目之电商用户行为分析大数据平台之(十)IDEA项目搭建及工具类介绍

一.创建Maven项目 创建项目,名称为LogAnalysis 二.常用工具类 2.1 配置管理组建 ConfigurationManager.java import java.io.InputStr ...

- Spark项目之电商用户行为分析大数据平台之(一)项目介绍

一.项目概述 本项目主要用于互联网电商企业中,使用Spark技术开发的大数据统计分析平台,对电商网站的各种用户行为(访问行为.购物行为.广告点击行为等)进行复杂的分析.用统计分析出来的数据,辅助公司中 ...

- Spark项目之电商用户行为分析大数据平台之(九)表的设计

一.概述 数据设计,往往包含两个环节: 第一个:就是我们的上游数据,就是数据调研环节看到的项目基于的基础数据,是否要针对其开发一些Hive ETL,对数据进行进一步的处理和转换,从而让我们能够更加方便 ...

- Spark项目之电商用户行为分析大数据平台之(八)需求分析

1.按条件筛选session 搜索过某些关键词的用户.访问时间在某个时间段内的用户.年龄在某个范围内的用户.职业在某个范围内的用户.所在某个城市的用户,发起的session.找到对应的这些用户的ses ...

- Spark项目之电商用户行为分析大数据平台之(三)大数据集群的搭建

Zookeeper集群搭建 http://www.cnblogs.com/qingyunzong/p/8619184.html Hadoop集群搭建 http://www.cnblogs.com/qi ...

- Spark项目之电商用户行为分析大数据平台之(十一)JSON及FASTJSON

一.概述 JSON的全称是”JavaScript Object Notation”,意思是JavaScript对象表示法,它是一种基于文本,独立于语言的轻量级数据交换格式.XML也是一种数据交换格式, ...

- Spark项目之电商用户行为分析大数据平台之(五)实时数据采集

随机推荐

- SQL Server T—SQL 学生选课数据库SQL语句考试题(45道题)

题目 设有一数据库,包括四个表:学生表(Student).课程表(Course).成绩表(Score)以及教师信息表(Teacher).四个表的结构分别如表1-1的表(一)~表(四)所示,数据如表1 ...

- 《剑指offer》(第二版)Java实现

Github链接: <剑指offer>(第二版)Java实现 欢迎star!

- 【公众号转载】MyBatis拦截器原理探究

MyBatis拦截器介绍 MyBatis提供了一种插件(plugin)的功能,虽然叫做插件,但其实这是拦截器功能.那么拦截器拦截MyBatis中的哪些内容呢? 我们进入官网看一看: MyBatis 允 ...

- leetcode916

单词子集 我们给出两个单词数组 A 和 B.每个单词都是一串小写字母. 现在,如果 b 中的每个字母都出现在 a 中,包括重复出现的字母,那么称单词 b是单词 a 的子集. 例如,“wrr” 是 “w ...

- Improving the GPA(hdu4968)dfs

Improving the GPA Time Limit: 2000/1000 MS (Java/Others) Memory Limit: 131072/131072 K (Java/Others) ...

- linux系统编程:自己动手写一个ls命令

ls用于列举目录内容,要实现这个功能,毫无疑问,需要读取目录,涉及到两个api: opendir:DIR *opendir(const char *name), 传文件名,返回一个指针,指向目录序列 ...

- HDU4845(SummerTrainingDay02-C 状态压缩bfs)

拯救大兵瑞恩 Time Limit: 3000/1000 MS (Java/Others) Memory Limit: 65535/32768 K (Java/Others)Total Subm ...

- Codeforces485D(SummerTrainingDay01-K)

D. Maximum Value time limit per test:1 second memory limit per test:256 megabytes input:standard inp ...

- POJ1811(SummerTrainingDay04-G miller-rabin判断素性 && pollard-rho分解质因数)

Prime Test Time Limit: 6000MS Memory Limit: 65536K Total Submissions: 35528 Accepted: 9479 Case ...

- 2016计蒜之道复赛 百度地图的实时路况(Floyd 分治)

题意 题目链接 Sol 首先一个结论:floyd算法的正确性与最外层\(k\)的顺序无关(只要保证是排列即可) 我大概想到一种证明方式就是把最短路树上的链拿出来,不论怎样枚举都会合并其中的两段,所以正 ...