TensorFlow笔记二:线性回归预测(Linear Regression)

代码:

import tensorflow as tf

import numpy as np

import xlrd

import matplotlib.pyplot as plt DATA_FILE = 'fire_theft.xls' # 1.read from data file

book=xlrd.open_workbook(DATA_FILE,encoding_override="utf-8")

sheet=book.sheet_by_index(0)

data=np.asarray([sheet.row_values(i) for i in range(1,sheet.nrows)])

n_samples=sheet.nrows-1 # 2.creat placeholders for input x(number of file) and label Y(number of theft)

X=tf.placeholder(tf.float32,name='X')

Y=tf.placeholder(tf.float32,name='Y') # 3.creat weight and bias ,init to 0

w=tf.Variable(0.0,name='weights')

b=tf.Variable(0.0,name='bias') # 4.build model to predict Y

Y_predicted = X* w +b # 5.use square error as the lose function

loss=tf.square(Y-Y_predicted,name='loss') # 6.using gradient descent with learning rate 0.01 to minimize loss

optimizer=tf.train.GradientDescentOptimizer(learning_rate=0.001).minimize(loss) with tf.Session() as sess:

# 7.init necessary variables (w and b)

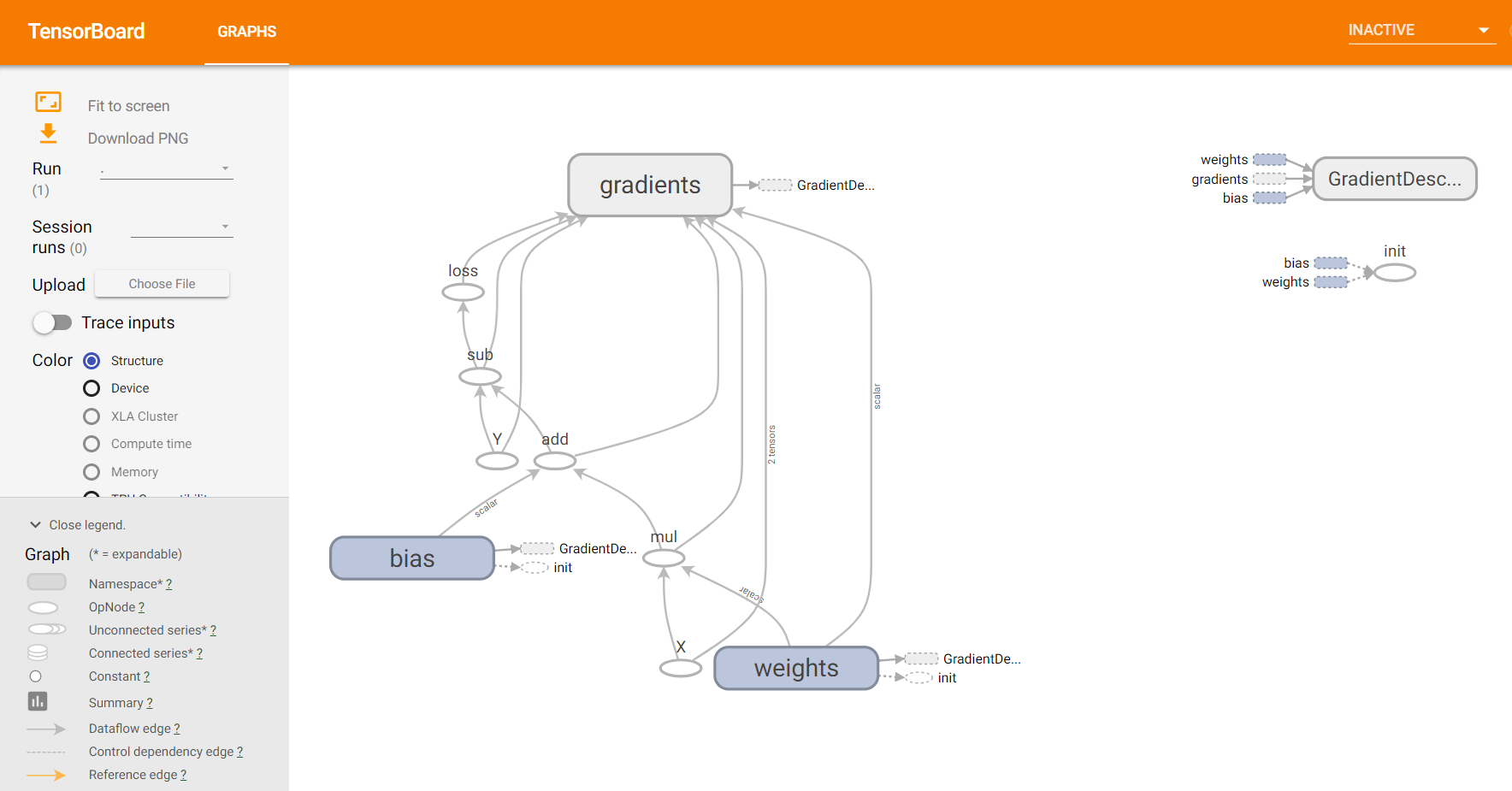

sess.run(tf.global_variables_initializer()) writer=tf.summary.FileWriter('./my_graph/linear_reg',sess.graph) # 8.train the model 100 times

for i in range(100):

total_loss =0

for x,y in data:

#session runs train_op and fetch values of loss

_,l=sess.run([optimizer,loss],feed_dict={X:x,Y:y})

total_loss +=l

print('Epoch {0}:{1}'.format(i,total_loss/n_samples)) # close the writer

writer.close() # 9.output the value of w and b

w_value,b_value=sess.run([w,b]) # plot the result

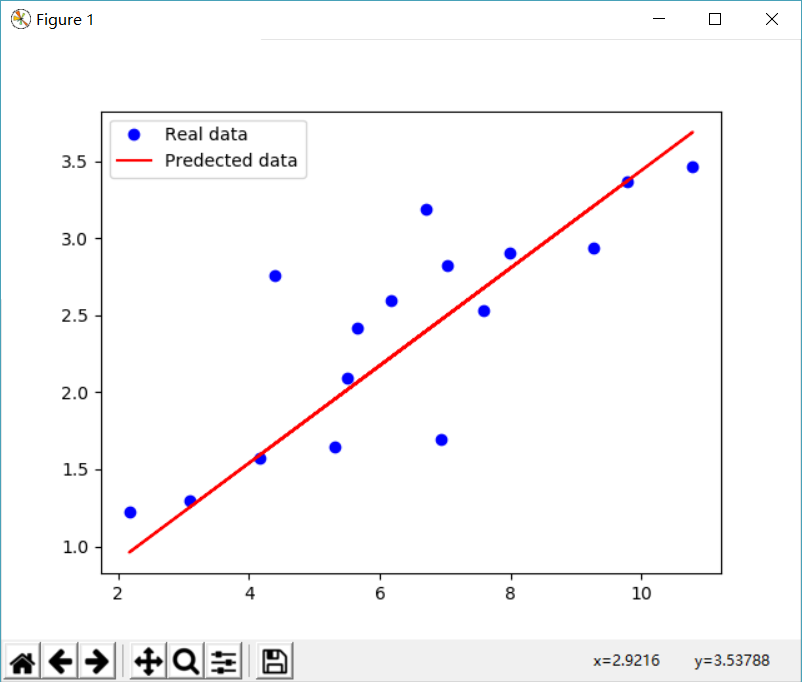

X,Y=data.T[0],data.T[1]

plt.plot(X,Y,'bo',label='Real data')

plt.plot(X,X*w_value+b_value,'r',label='Predected data')

plt.legend()

plt.show()

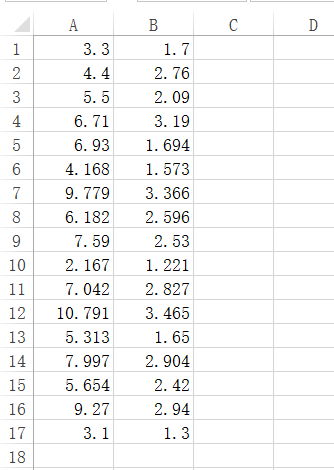

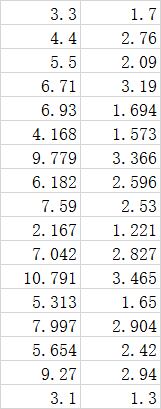

fire_theft.xls

图例:

TFboard: tensorboard --logdir="./my_graph/linear_reg" --port 6006

TensorFlow笔记二:线性回归预测(Linear Regression)的更多相关文章

- 机器学习 (二) 多变量线性回归 Linear Regression with Multiple Variables

文章内容均来自斯坦福大学的Andrew Ng教授讲解的Machine Learning课程,本文是针对该课程的个人学习笔记,如有疏漏,请以原课程所讲述内容为准.感谢博主Rachel Zhang 的个人 ...

- 斯坦福CS229机器学习课程笔记 Part1:线性回归 Linear Regression

机器学习三要素 机器学习的三要素为:模型.策略.算法. 模型:就是所要学习的条件概率分布或决策函数.线性回归模型 策略:按照什么样的准则学习或选择最优的模型.最小化均方误差,即所谓的 least-sq ...

- 【ML】求解线性回归方程(Linear Regression)

参考资料:openclassroom 线性回归(Linear Regression) 为了拟合10岁以下儿童年龄(x1)与身高(y)之间的关系,我们假设一个关于x的函数h(x): h(x) = Θ0+ ...

- 斯坦福机器学习视频笔记 Week2 多元线性回归 Linear Regression with Multiple Variables

相比于week1中讨论的单变量的线性回归,多元线性回归更具有一般性,应用范围也更大,更贴近实际. Multiple Features 上面就是接上次的例子,将房价预测问题进行扩充,添加多个特征(fea ...

- 数据结构 浙大MOOC 笔记二 线性结构

线性表及其表现 第二章的内容是关于三种最基本的数据结构 结合<DDSA>第三章 表.栈和队列做一个总结 首先简单说明一下各个数据结构的特点: 数组:连续存储,遍历快且方便,长度固定,缺点是 ...

- Tensorflow笔记二

MNIST手写体识别 (Mixed National Institute of Standards and Technology database)的28*28字符识别共0-9类. 在ipython命 ...

- torch学习笔记(二) nn类结构-Linear

Linear 是module的子类,是参数化module的一种,与其名称一样,表示着一种线性变换. 创建 parent 的init函数 Linear的创建需要两个参数,inputSize 和 outp ...

- 吴恩达机器学习笔记8-多变量线性回归(Linear Regression with Multiple Variables)--多维特征

我们探讨了单变量/特征的回归模型,现在我们对房价模型增加更多的特征,例如房间数楼层等,构成一个含有多个变量的模型,模型中的特征为(

- 吴恩达机器学习笔记1-单变量线性回归(Linear Regression with One Variable)

在监督学习中我们有一个数据集,这个数据集被称训练集.

随机推荐

- 菜鸟之路——机器学习之线性回归个人理解及Python实现

这一节很简单,都是高中讲过的东西 简单线性回归:y=b0+b1x+ε.b1=(Σ(xi-x–)(yi-y–))/Σ(xi-x–)ˆ2 b0=y--b1x- 其中ε取 为均值为0的正态 ...

- aspx页面直接访问后台方法

在方法上面机上[WebMethod]就可以直接请求该方法了.

- P4513 小白逛公园

题目背景 小新经常陪小白去公园玩,也就是所谓的遛狗啦… 题目描述 在小新家附近有一条“公园路”,路的一边从南到北依次排着 nnn 个公园,小白早就看花了眼,自己也不清楚该去哪些公园玩了. 一开始,小白 ...

- [HNOI2007][bzoj1187] 神奇游乐园 [插头dp]

题面: 传送门 给定一个四联通棋盘图,每个格子有权值,求一条总权值最大的回路 思路: 插头dp基础教程 棋盘? 回路? n,m<=10? 当然是插头dp啦~\(≧▽≦)/~ 然后发现这道题并不是 ...

- [canvas入坑2]模糊效果

查看效果请到 http://philippica.github.io/ 点击blur 模糊效果比较好的应该是高斯模糊,一个点的值变成了以该点为圆心的一个圆内所有像素的加权平均,权重由二维正态分布计算 ...

- Linux系统——常见的系统调用

本文列出了大部分常见的Linux系统调用,并附有简要中文说明. 以下是Linux系统调用的一个列表,包含了大部分常用系统调用和由系统调用派生出的的函数.这可能是你在互联网上所能看到的唯一一篇中文注释的 ...

- oracle 修改数据 保险方法

oracle 中修改比较安全的方法:(pl/sql) 第一种方法: select * from temp where id=9 for update; 第二种方法: select t.*,rowid ...

- python获取目录下文件夹名称

path = '/opt' dirs = os.listdir(path) for dir in dirs: print dir

- 关于设置组件的state时遇到的一些问题

在使用react-bootstrap的时候设置showModel的值来控制Model的显示与隐藏,但是setState这个函数是异步的. 当你进行数据更新的时候,接着执行函数获取这个模态框的dom是获 ...

- PowerDesigner常用快捷键

一般快捷键 F4 打开检查模型窗口,检查模型 F5 如果图窗口内的图改变过大小,恢复为原有大小即正常大小 F6 放大图窗口内的图 F7 缩小图窗口内的图 F8 在图窗口内中查看全部 ...