TensorFlow 深度学习笔记 卷积神经网络

Convolutional Networks

转载请注明作者:梦里风林

Github工程地址:https://github.com/ahangchen/GDLnotes

欢迎star,有问题可以到Issue区讨论

官方教程地址

视频/字幕下载

deep dive into images and convolutional models

Convnet

BackGround

- 人眼在识别图像时,往往从局部到全局

- 局部与局部之间联系往往不太紧密

- 我们不需要神经网络中的每个结点都掌握全局的知识,因此可以从这里减少需要学习的参数数量

Weight share

- 但这样参数其实还是挺多的,所以有了另一种方法:权值共享

Share Parameters across space

取图片的一小块,在上面做神经网络分析,会得到一些预测

将切片做好的神经网络作用于图片的每个区域,得到一系列输出

可以增加切片个数提取更多特征

在这个过程中,梯度的计算跟之前是一样的

Concept

- Patch/Kernel:一个局部切片

- Depth: 数据的深度,图像数据是三维的,长宽和RGB,神经网络的预测输出也属于一维

- Feature Map:每层Conv网络,因为它们将前一层的feature映射到后一层(Output map)

- Stride: 移动切片的步长,影响取样的数量

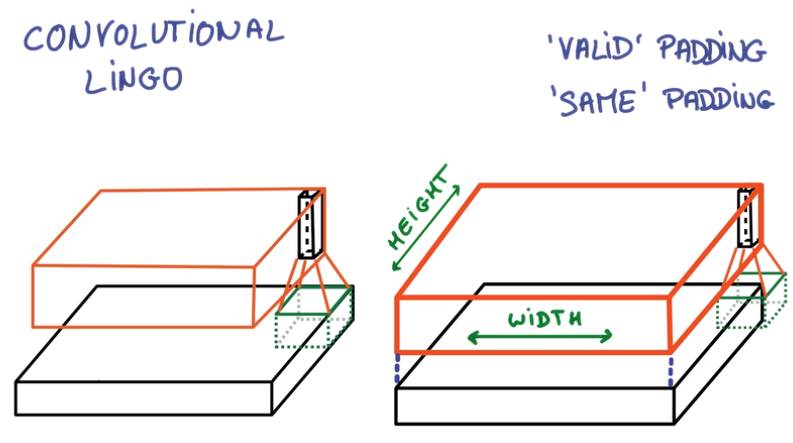

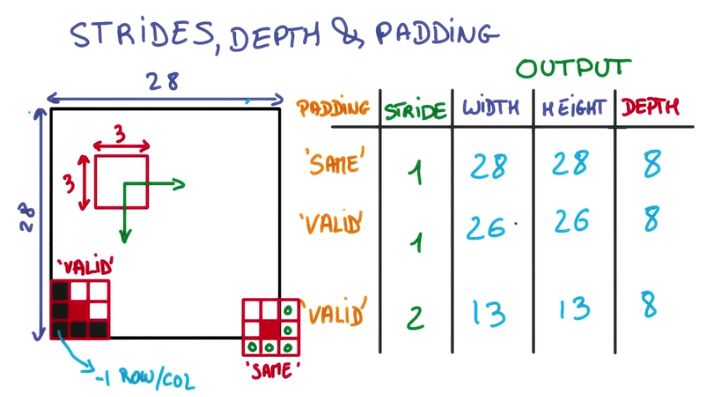

- 在边缘上的取样影响Conv层的面积,由于移动步长不一定能整除整张图的像素宽度,不越过边缘取样会得到Valid Padding, 越过边缘取样会得到Same Padding

- Example

- 用一个3x3的网格在一个28x28的图像上做切片并移动

- 移动到边缘上的时候,如果不超出边缘,3x3的中心就到不了边界

- 因此得到的内容就会缺乏边界的一圈像素点,只能得到26x26的结果

- 而可以越过边界的情况下,就可以让3x3的中心到达边界的像素点

- 超出部分的矩阵补零就行

Deep Convnet

在Convnet上套Convnet,就可以一层一层综合局部得到的信息

OutPut

将一个deep and narrow的feature层作为输入,传给一个Regular神经网络

Optimization

Pooling

将不同Stride的卷积用某种方式合并起来,节省卷积层的空间复杂度。

- Max Pooling

在一个卷积层的输出层上取一个切片,取其中最大值代表这个切片 - 优点

- 不增加需要调整的参数

- 通常比其他方法准确

- 缺点:更多Hyper Parameter,包括要取最值的切片大小,以及去切片的步长

LENET-5, ALEXNET

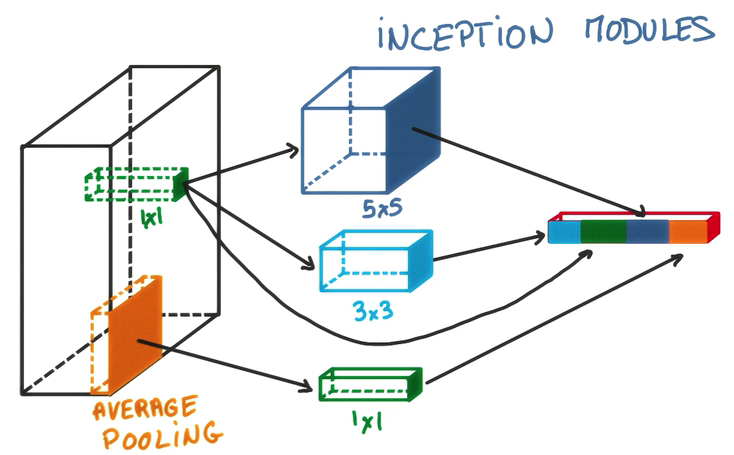

- Average Pooling

在卷积层输出中,取切片,取平均值代表这个切片

1x1 Convolutions

在一个卷积层的输出层上,加一个1x1的卷积层,这样就形成了一个小型的神经网络。

- cheap for deeper model

- 结合Average Pooling食用效果更加

Inception

对同一个卷积层输出,执行各种二次计算,将各种结果堆叠到新输出的depth方向上

TensorFlow卷积神经网络实践

数据处理

- dataset处理成四维的,label仍然作为one-hot encoding

def reformat(dataset, labels, image_size, num_labels, num_channels):

dataset = dataset.reshape(

(-1, image_size, image_size, num_channels)).astype(np.float32)

labels = (np.arange(num_labels) == labels[:, None]).astype(np.float32)

return dataset, labels

- 将lesson2的dnn转为cnn很简单,只要把WX+b改为conv2d(X)+b即可

- 关键在于conv2d

`conv2d

tf.nn.conv2d(input, filter, strides, padding, use_cudnn_on_gpu=None, data_format=None, name=None)

给定四维的input和filter tensor,计算一个二维卷积

Args:

input: ATensor. type必须是以下几种类型之一:half,float32,float64.filter: ATensor. type和input必须相同strides: A list ofints.一维,长度4, 在input上切片采样时,每个方向上的滑窗步长,必须和format指定的维度同阶padding: Astringfrom:"SAME", "VALID". padding 算法的类型use_cudnn_on_gpu: An optionalbool. Defaults toTrue.data_format: An optionalstringfrom:"NHWC", "NCHW", 默认为"NHWC"。

指定输入输出数据格式,默认格式为"NHWC", 数据按这样的顺序存储:

[batch, in_height, in_width, in_channels]

也可以用这种方式:"NCHW", 数据按这样的顺序存储:

[batch, in_channels, in_height, in_width]name: 操作名,可选.

Returns:

A Tensor. type与input相同

Given an input tensor of shape [batch, in_height, in_width, in_channels]

and a filter / kernel tensor of shape

[filter_height, filter_width, in_channels, out_channels]

conv2d实际上执行了以下操作:

- 将filter转为二维矩阵,shape为

[filter_height * filter_width * in_channels, output_channels]. - 从input tensor中提取image patches,每个patch是一个virtual tensor,shape

[batch, out_height, out_width, filter_height * filter_width * in_channels]. - 将每个filter矩阵和image patch向量相乘

具体来讲,当data_format为NHWC时:

output[b, i, j, k] =

sum_{di, dj, q} input[b, strides[1] * i + di, strides[2] * j + dj, q] *

filter[di, dj, q, k]

input 中的每个patch都作用于filter,每个patch都能获得其他patch对filter的训练

需要满足strides[0] = strides[3] = 1. 大多数水平步长和垂直步长相同的情况下:strides = [1, stride, stride, 1].

- 然后再接一个WX+b连Relu连WX+b的全连接神经网络即可

Max Pooling

在tf.nn.conv2d后面接tf.nn.max_pool,将卷积层输出减小,从而减少要调整的参数

max_pool

tf.nn.max_pool(value, ksize, strides, padding, data_format='NHWC', name=None)

Performs the max pooling on the input.

Args:

value: A 4-DTensorwith shape[batch, height, width, channels]and

typetf.float32.ksize: A list of ints that has length >= 4. 要执行取最值的切片在各个维度上的尺寸strides: A list of ints that has length >= 4. 取切片的步长padding: A string, either'VALID'or'SAME'. padding算法data_format: A string. 'NHWC' and 'NCHW' are supported.name: 操作名,可选

Returns:

A Tensor with type tf.float32. The max pooled output tensor.

优化

仿照lesson2,添加learning rate decay 和 drop out,可以将准确率提高到90.6%

参考链接

- Tensorflow 中 conv2d 都干了啥

- TensorFlow Example

- 张雨石 Conv神经网络

- Bill Xia 卷积神经网络(CNN)

觉得我的文章对您有帮助的话,给个star可好?

土豪可以打赏支持,一分也是爱:

TensorFlow 深度学习笔记 卷积神经网络的更多相关文章

- TensorFlow深度学习笔记 循环神经网络实践

转载请注明作者:梦里风林 Github工程地址:https://github.com/ahangchen/GDLnotes 欢迎star,有问题可以到Issue区讨论 官方教程地址 视频/字幕下载 加 ...

- 深度学习之卷积神经网络CNN及tensorflow代码实例

深度学习之卷积神经网络CNN及tensorflow代码实例 什么是卷积? 卷积的定义 从数学上讲,卷积就是一种运算,是我们学习高等数学之后,新接触的一种运算,因为涉及到积分.级数,所以看起来觉得很复杂 ...

- 深度学习之卷积神经网络CNN及tensorflow代码实现示例

深度学习之卷积神经网络CNN及tensorflow代码实现示例 2017年05月01日 13:28:21 cxmscb 阅读数 151413更多 分类专栏: 机器学习 深度学习 机器学习 版权声明 ...

- 深度学习之卷积神经网络(CNN)的应用-验证码的生成与识别

验证码的生成与识别 本文系作者原创,转载请注明出处:https://www.cnblogs.com/further-further-further/p/10755361.html 目录 1.验证码的制 ...

- 【神经网络与深度学习】卷积神经网络(CNN)

[神经网络与深度学习]卷积神经网络(CNN) 标签:[神经网络与深度学习] 实际上前面已经发布过一次,但是这次重新复习了一下,决定再发博一次. 说明:以后的总结,还应该以我的认识进行总结,这样比较符合 ...

- Google TensorFlow深度学习笔记

Google Deep Learning Notes Google 深度学习笔记 由于谷歌机器学习教程更新太慢,所以一边学习Deep Learning教程,经常总结是个好习惯,笔记目录奉上. Gith ...

- 深度学习之卷积神经网络(CNN)

卷积神经网络(CNN)因为在图像识别任务中大放异彩,而广为人知,近几年卷积神经网络在文本处理中也有了比较好的应用.我用TextCnn来做文本分类的任务,相比TextRnn,训练速度要快非常多,准确性也 ...

- 深度学习之卷积神经网络(CNN)详解与代码实现(二)

用Tensorflow实现卷积神经网络(CNN) 本文系作者原创,转载请注明出处:https://www.cnblogs.com/further-further-further/p/10737065. ...

- 深度学习之卷积神经网络(CNN)详解与代码实现(一)

卷积神经网络(CNN)详解与代码实现 本文系作者原创,转载请注明出处:https://www.cnblogs.com/further-further-further/p/10430073.html 目 ...

随机推荐

- layer 模版使用

function doReply(id){ var url = "/Feedback/Feedback/reply"; var content = $("#reply_c ...

- 在virtualenv中安装libxml2和libxslt

在使用python的工作中,需要使用到libxml2和libxslt库.原来在实际环境中已经安装完成了,但是在virtualenv中还没有,现在正在整理virtualenv的环境.下面把在virtua ...

- POJ 2488 A Knight's Journey(DFS)

A Knight's Journey Time Limit: 1000MSMemory Limit: 65536K Total Submissions: 34633Accepted: 11815 De ...

- 1008 Gnome Tetravex

练习使用DPS的题,不知道有无别的做法,思路不复杂.形式是统计并且进行数字配对. #include <stdio.h> ][],note[],ans[]; void ini(){ int ...

- pm2安装及常用命令

安装:npm install -g pm2 启动程序:pm2 start <app_name|id|all> 列举进程:pm2 list 退出程序:pm2 stop <app_nam ...

- ajax请求解析springmvc返回的json数据

需要使用的框架 spring3.0 jquery1.9.0(简化ajax开发的js库) Jackson(json处理器):jackson-core-asl-1.9.2.jar,jackson-mapp ...

- 常用数据结构及复杂度 array、LinkedList、List、Stack、Queue、Dictionary、SortedDictionary、HashSet、SortedSet

原文地址:http://www.cnblogs.com/gaochundong/p/data_structures_and_asymptotic_analysis.html 常用数据结构的时间复杂度 ...

- poj 1001 求高精度幂

本题的测试用例十分刁钻,必须要考虑到很多的细节问题,在这里给出一组测试用例及运行结果: 95.123 12 548815620517731830194541.899025343415715973535 ...

- LeeCode-Delete Node in a Linked List

Write a function to delete a node (except the tail) in a singly linked list, given only access to th ...

- PC和ARM平台编译Qt的命令

编译for PC 的Qt过程是: (1)qmake -project (qmake命令,用于创建hello.pro,将所有的文件编译成一个与平台无关的工程文件).(注意:按照前面步骤安装好Qt环境之后 ...