机器学习-- Logistic回归 Logistic Regression

转载自:http://blog.csdn.net/linuxcumt/article/details/8572746

1.假设随Tumor Size变化,预测病人的肿瘤是恶性(malignant)还是良性(benign)的情况。

给出8个数据如下:

2.假设进行linear regression得到的hypothesis线性方程如上图中粉线所示,则可以确定一个threshold:0.5进行predict

y=1, if h(x)>=0.5

y=0, if h(x)<0.5

即malignant=0.5的点投影下来,其右边的点预测y=1;左边预测y=0;则能够很好地进行分类。

那么,如果数据集是这样的呢?

这种情况下,假设linear regression预测为蓝线,那么由0.5的boundary得到的线性方程中,不能很好地进行分类(5,6个点均不能满足)。因为不满足

y=1, h(x)>0.5

y=0, h(x)<=0.5

============Hypothesis Representation==================

1.logistic regression model

注意:

========================Decision Boundary =================================

1.logistic regression model的深入解释

2.所谓Decision Boundary就是能够将所有数据点进行很好地分类的h(x)边界。

如下图所示,假设形如h(x)=g(θ0+θ1x1+θ2x2)的hypothesis参数θ=[-3,1,1]T,

则有

predict Y=1, if -3+x1+x2>=0

predict Y=0, if -3+x1+x2<0

刚好能够将图中所示数据集进行很好地分类

3.小问题,注意,所有逻辑回归都这么处理。参见(1.logistic regression model的深入解释)

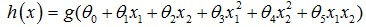

4.除了线性boundary还有非线性decision boundaries,比如

。训练集的作用

。训练集的作用

就是找这些参数θ。但这个曲线该怎么找??由此可见,logistic

regression 的

boundary可以是任意的曲线。而所谓的线性可分、不可分实则指的就是

boundary是否为线性或非线性(参数),而不是logistic函数自身。下图中,

进行分类的decision boundary就是一个半径为1的圆,如图所示:

======================Cost Function=====================

1.问题提出,如何求参数θ?但这个曲线该怎么找??

2.对于logistic regression其COST函数不能像线性回归的最小二乘那样

选择。因为其 logistic是非线性函数。非要这样取的话,COST函数是非凸

函数,见下图。无法用梯度下降求极值。

3.logistic

regression其COST函数的定义。在给定了h(θ,x),y后,其COST函数

值即可确定。注意:h(θ,x)为logistic曲线,其取值范围在0-1之间。

4.当h(θ,x)接近1,而y=1,表明分类正确,故不“惩罚”,COST=0;

反之,h(θ,x)接近0,而y=1,,表明分类错误,故大大“惩罚”,COST=无限大;

同理对y=0

5.小题目

===========Simplified

Cost Function and Gradient Descent==============

1.求出最小J(θ)时的θ,然后计算h(θ,x),若其>=0.5(或θTx>=0),则y=1;否则y=0.

参考logistic regression model

2.不管h(x)的表达式是线性的还是logistic

regression model, 都能得到如下的参数更新过程。

写的详细些:

3.归一化(Feature scaling)同样会使得logistic regression 跑的更快。

=============Advanced Optimization ==================

1.除了gradient descent 方法之外,我们还有很多方法可以使用,如下图所示,

左边是另外三种方法,右边是这三种方法共同的优缺点,无需选择学习率α,更快,

但是更复杂。

2.代码小例

3.实际matlab中已经帮我们实现好了一些优化参数θ的方法,那么这里我们需要完成的事情

只是写好cost function,并告诉系统,要用哪个方法进行最优化参数。比如我们用‘GradObj’

, Use the GradObj option to specify that FUN also returns a second output argument

G that is the partial derivatives of the function df/dX, at the point X.

函数costFunction, 定义jVal=J(θ)和对两个θ的gradient:

- function [ jVal,gradient ] = costFunction( theta )

- %COSTFUNCTION Summary of this function goes here

- % Detailed explanation goes here

- jVal= (theta(1)-5)^2+(theta(2)-5)^2;

- gradient = zeros(2,1);

- %code to compute derivative to theta

- gradient(1) = 2 * (theta(1)-5);

- gradient(2) = 2 * (theta(2)-5);

- end

编写函数Gradient_descent,进行参数优化

- function [optTheta,functionVal,exitFlag]=Gradient_descent( )

- %GRADIENT_DESCENT Summary of this function goes here

- % Detailed explanation goes here

- options = optimset('GradObj','on','MaxIter',100);

- initialTheta = zeros(2,1)

- [optTheta,functionVal,exitFlag] = fminunc(@costFunction,initialTheta,options);

- end

matlab主窗口中调用,得到优化厚的参数(θ1,θ2)=(5,5),即hθ(x)=θ1x1+θ2x2=5*x1+5*x2

- [optTheta,functionVal,exitFlag] = Gradient_descent()

- initialTheta =

- 0

- 0

- Local minimum found.

- Optimization completed because the size of the gradient is less than

- the default value of the function tolerance.

- <stopping criteria details>

- optTheta =

- 5

- 5

- functionVal =

- 0

- exitFlag =

- 1

最后得到的结果显示出优化参数optTheta=[5,5], functionVal = costFunction(迭代后) = 0

===========Multiclass Classification: One-vs-all =================

1.所谓one-vs-all method就是将binary分类的方法应用到多类分类中。

比如我想分成K类,那么就将其中一类作为positive,另(k-1)合起来作为negative,

这样进行K个h(θ)的参数优化,每次得到的一个hθ(x)是指给定θ和x,它属于positive的

类的概率。按照上面这种方法,给定一个输入向量x,获得最大hθ(x)的类就是

x所分到的类。

机器学习-- Logistic回归 Logistic Regression的更多相关文章

- 【机器学习实战】第5章 Logistic回归

第5章 Logistic回归 Logistic 回归 概述 Logistic 回归虽然名字叫回归,但是它是用来做分类的.其主要思想是: 根据现有数据对分类边界线建立回归公式,以此进行分类. 须知概念 ...

- Logistic回归(逻辑回归)和softmax回归

一.Logistic回归 Logistic回归(Logistic Regression,简称LR)是一种常用的处理二类分类问题的模型. 在二类分类问题中,把因变量y可能属于的两个类分别称为负类和正类, ...

- Logistic 回归(sigmoid函数,手机的评价,梯度上升,批处理梯度,随机梯度,从疝气病症预测病马的死亡率

(手机的颜色,大小,用户体验来加权统计总体的值)极大似然估计MLE 1.Logistic回归 Logistic regression (逻辑回归),是一种分类方法,用于二分类问题(即输出只有两种).如 ...

- Logistic回归模型和Python实现

回归分析是研究变量之间定量关系的一种统计学方法,具有广泛的应用. Logistic回归模型 线性回归 先从线性回归模型开始,线性回归是最基本的回归模型,它使用线性函数描述两个变量之间的关系,将连续或离 ...

- 《转》Logistic回归 多分类问题的推广算法--Softmax回归

转自http://ufldl.stanford.edu/wiki/index.php/Softmax%E5%9B%9E%E5%BD%92 简介 在本节中,我们介绍Softmax回归模型,该模型是log ...

- 机器学习总结之逻辑回归Logistic Regression

机器学习总结之逻辑回归Logistic Regression 逻辑回归logistic regression,虽然名字是回归,但是实际上它是处理分类问题的算法.简单的说回归问题和分类问题如下: 回归问 ...

- 机器学习入门11 - 逻辑回归 (Logistic Regression)

原文链接:https://developers.google.com/machine-learning/crash-course/logistic-regression/ 逻辑回归会生成一个介于 0 ...

- Coursera公开课笔记: 斯坦福大学机器学习第六课“逻辑回归(Logistic Regression)” 清晰讲解logistic-good!!!!!!

原文:http://52opencourse.com/125/coursera%E5%85%AC%E5%BC%80%E8%AF%BE%E7%AC%94%E8%AE%B0-%E6%96%AF%E5%9D ...

- 机器学习 (三) 逻辑回归 Logistic Regression

文章内容均来自斯坦福大学的Andrew Ng教授讲解的Machine Learning课程,本文是针对该课程的个人学习笔记,如有疏漏,请以原课程所讲述内容为准.感谢博主Rachel Zhang 的个人 ...

随机推荐

- Java自定义异常信息

通常在开发过程中,会遇到很多异常,对于一些知道异常的原因,这时候想要返回给浏览器,就需要自定义系统的异常 1.Spring 注入异常处理类 <bean id ="commonExce ...

- java使用apache-poi生成excel表格

public static void main(String[] args) throws IOException { // TODO Auto-generated method stub //创建一 ...

- JavaScript---ECMA对象

1.对象的概念及分类 1.1 ECMAScript中没有类,但定义了“对象”,逻辑上等价于其他程序设计语言中的类. var o = new Object(); 1.2 本地对象(native obje ...

- 【vlan-端口配置】

搭建好拓扑图如下: 分别配置两台终端的ip地址 创建vlan把e0/4/0接口加入到新的vlan中 连通性失败 . 同理在把e0/4/1加入到vlan视图中 连通性成功 : 搭建好拓扑图如下 进入e0 ...

- 【PHP基础】序列化serialize()与反序列化unserialize()

序列化serialize()与反序列化unserialize(): 序列化serialize():就是将一个变量所代表的 “内存数据”转换为“字符串”的形式,并持久保存在硬盘(写入文件中保存)上的一种 ...

- 39.VUE学习--组件,子组件中data数据的使用,x-template模板的使用,改变for循环里的某条数据里的值

多处引用相同组件时,操作data不会相互影响 <!DOCTYPE html> <html> <head> <meta charset="utf-8& ...

- python——闰年的判断

写一个程序,判断给定年份是否为闰年. 这样定义闰年的:能被4整除但不能被100整除,或者能被400整除都是闰年. while(1): year = input("请输入一个年份,让我判断一下 ...

- javascript类式继承模式#2——借用构造函数

<!DOCTYPE html PUBLIC "-//W3C//DTD XHTML 1.0 Transitional//EN" "http://www.w3.org/ ...

- USACO Section2.2 Preface Numbering 解题报告 【icedream61】

preface解题报告----------------------------------------------------------------------------------------- ...

- Git上手:四种常见的Git协同工作方式

1.集中式工作流 适用人群:开发小团队(4-5人),习惯使用SVN工具的小团队. 工作方式:团队组长创建远程仓库,创建一个master分支,组员可读可写. 每个开发人员都git clone远程仓库到本 ...