Scrapy+selenium爬取简书全站

Scrapy+selenium爬取简书全站

环境

Ubuntu 18.04

Python 3.8

Scrapy 2.1

爬取内容

- 文字标题

- 作者

- 作者头像

- 发布日期

- 内容

- 文章连接

- 文章ID

思路

- 分析简书文章的url规则

- 使用selenium请求页面

- 使用xpath获取需要的数据

- 异步存储数据到MySQL(提高存储效率)

实现

前戏:

- 创建scrapy项目

- 建立crawlsipder爬虫文件

- 打开

pipelines和middleware

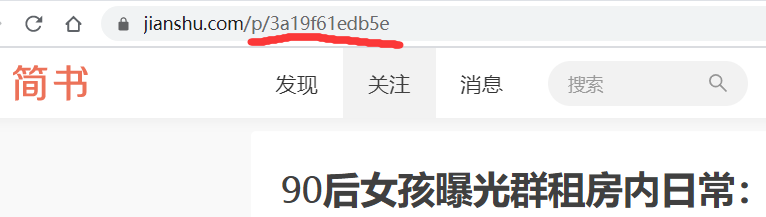

第一步:分析简书文章的url

可以看到url规则为jianshu.com/p/文章ID,然后再crawlsipder中设置url规则

class JsSpider(CrawlSpider):

name = 'js'

allowed_domains = ['jianshu.com']

start_urls = ['http://jianshu.com/']

rules = (

Rule(LinkExtractor(allow=r'.+/p/[0-9a-z]{12}.*'), callback='parse_detail', follow=True),

)

第二步:使用selenium请求页面

设置下载器中间件

由于作者、发布日期等数据由Ajax加载,所以使用selenium来获取页面源码以方便xpath解析

有时候请求会卡在一个页面,一直未加载完成,所以需要设置超时时间

同理Ajax也可能未加载完成,所以需要显示等待加载完成

from selenium import webdriver

from scrapy.http.response.html import HtmlResponse

from selenium.webdriver.support.ui import WebDriverWait

from selenium.webdriver.support import expected_conditions

from selenium.webdriver.common.by import By

class SeleniumDownloadMiddleware(object):

def __init__(self):

self.driver = webdriver.Chrome()

def process_request(self, request, spider):

while True:

# 超时重新请求

try:

self.driver.set_page_load_timeout(1)

self.driver.get(request.url)

except:

pass

finally:

try:

# 等待ajax加载,超时了就重来

WebDriverWait(self.driver, 1).until(

expected_conditions((By.CLASS_NAME, 'rEsl9f'))

)

except:

continue

finally:

break

url = self.driver.current_url

source = self.driver.page_source

response = HtmlResponse(url=url, body=source, request=request, encoding='utf-8')

return response

注意提前将 chromedriver 放到/user/bin下,或者自行指定执行路径。windows下可以讲其添加到环境变量下。

第三步:使用xpath获取需要的数据

设置好item

import scrapy

class JianshuCrawlItem(scrapy.Item):

title = scrapy.Field()

content = scrapy.Field()

author = scrapy.Field()

avatar = scrapy.Field()

pub_time = scrapy.Field()

origin_url = scrapy.Field()

article_id = scrapy.Field()

分析所需数据的xpath路径,进行获取需要的数据,并交给pipelines处理

from scrapy.linkextractors import LinkExtractor

from scrapy.spiders import CrawlSpider, Rule

from ..items import JianshuCrawlItem as Jitem

class JsSpider(CrawlSpider):

name = 'js'

allowed_domains = ['jianshu.com']

start_urls = ['http://jianshu.com/']

rules = (

Rule(LinkExtractor(allow=r'.+/p/[0-9a-z]{12}.*'), callback='parse_detail', follow=True),

)

def parse_detail(self, response):

# 使用xpath获取数据

title = response.xpath("//h1[@class='_2zeTMs']/text()").get()

author = response.xpath("//a[@class='_1OhGeD']/text()").get()

avatar = response.xpath("//img[@class='_13D2Eh']/@src").get()

pub_time = response.xpath("//div[@class='s-dsoj']/time/text()").get()

content = response.xpath("//article[@class='_2rhmJa']").get()

origin_url = response.url

article_id = origin_url.split("?")[0].split("/")[-1]

print(title) # 提示爬取的文章

item = Jitem(

title=title,

author=author,

avatar=avatar,

pub_time=pub_time,

origin_url=origin_url,

article_id=article_id,

content=content,

)

yield item

第四步:存储数据到数据库中

我这里用的数据库是MySQL,其他数据同理,操作数据的包是pymysql

提交数据有两种思路,顺序存储和异步存储

由于scrapy是异步爬取,所以顺序存储效率就会显得比较慢,推荐采用异步存储

顺序存储:实现简单、效率低

class JianshuCrawlPipeline(object):

def __init__(self):

dbparams = {

'host': '127.0.0.1',

'port': 3306,

'user': 'debian-sys-maint',

'password': 'lD3wteQ2BEPs5i2u',

'database': 'jianshu',

'charset': 'utf8mb4',

}

self.conn = pymysql.connect(**dbparams)

self.cursor = self.conn.cursor()

self._sql = None

def process_item(self, item, spider):

self.cursor.execute(self.sql, (item['title'], item['content'], item['author'],

item['avatar'], item['pub_time'],

item['origin_url'], item['article_id']))

self.conn.commit()

return item

@property

def sql(self):

if not self._sql:

self._sql = '''

insert into article(id,title,content,author,avatar,pub_time,origin_url,article_id)\

values(null,%s,%s,%s,%s,%s,%s,%s)'''

return self._sql

异步存储:复杂、效率高

import pymysql

from twisted.enterprise import adbapi

class JinshuAsyncPipeline(object):

'''

异步储存爬取的数据

'''

def __init__(self):

# 连接本地mysql

dbparams = {

'host': '127.0.0.1',

'port': 3306,

'user': 'debian-sys-maint',

'password': 'lD3wteQ2BEPs5i2u',

'database': 'jianshu',

'charset': 'utf8mb4',

'cursorclass': pymysql.cursors.DictCursor

}

self.dbpool = adbapi.ConnectionPool('pymysql', **dbparams)

self._sql = None

@property

def sql(self):

# 初始化sql语句

if not self._sql:

self._sql = '''

insert into article(id,title,content,author,avatar,pub_time,origin_url,article_id)\

values(null,%s,%s,%s,%s,%s,%s,%s)'''

return self._sql

def process_item(self, item, spider):

defer = self.dbpool.runInteraction(self.insert_item, item) # 提交数据

defer.addErrback(self.handle_error, item, spider) # 错误处理

def insert_item(self, cursor, item):

# 执行SQL语句

cursor.execute(self.sql, (item['title'], item['content'], item['author'],

item['avatar'],

item['pub_time'],

item['origin_url'], item['article_id']))

def handle_error(self, item, error, spider):

print('Error!')

总结

- 类似简书这种采用Ajax技术的网站可以使用selenium轻松爬取,不过效率相对解析接口的方式要低很多,但实现简单,如果所需数据量不大没必要费劲去分析接口。

- selenium方式访问页面时,会经常出现加载卡顿的情况,使用超时设置和显示等待避免浪费时间

Github:https://github.com/aduner/jianshu-crawl

博客地址:https://www.cnblogs.com/aduner/p/12852616.html

Scrapy+selenium爬取简书全站的更多相关文章

- Node爬取简书首页文章

Node爬取简书首页文章 博主刚学node,打算写个爬虫练练手,这次的爬虫目标是简书的首页文章 流程分析 使用superagent发送http请求到服务端,获取HTML文本 用cheerio解析获得的 ...

- python3 爬取简书30日热门,同时存储到txt与mongodb中

初学python,记录学习过程. 新上榜,七日热门等同理. 此次主要为了学习python中对mongodb的操作,顺便巩固requests与BeautifulSoup. 点击,得到URL https: ...

- Python爬取简书主页信息

主要学习如何通过抓包工具分析简书的Ajax加载,有时间再写一个Multithread proxy spider提升效率. 1. 关键点: 使用单线程爬取,未登录,爬取简书主页Ajax加载的内容.主要有 ...

- python2.7 爬取简书30日热门专题文章之简单分析_20170207

昨天在简书上写了用Scrapy抓取简书30日热门文章,对scrapy是刚接触,跨页面抓取以及在pipelines里调用settings,连接mysql等还不是很熟悉,今天依旧以单独的py文件区去抓取数 ...

- 【python3】爬取简书评论生成词云

一.起因: 昨天在简书上看到这么一篇文章<中国的父母,大都有毛病>,看完之后个人是比较认同作者的观点. 不过,翻了下评论,发现评论区争议颇大,基本两极化.好奇,想看看整体的评论是个什么样, ...

- scrapy爬取简书整站文章

在这里我们使用CrawlSpider爬虫模板, 通过其过滤规则进行抓取, 并将抓取后的结果存入mysql中,下面直接上代码: jianshu_spider.py # -*- coding: utf-8 ...

- 使用scrapy+selenium爬取淘宝网

--***2019-3-27测试有效***---- 第一步: 打开cmd,输入scrapy startproject taobao_s新建一个项目. 接着cd 进入我们的项目文件夹内输入scrapy ...

- 爬虫第六篇:scrapy框架爬取某书网整站爬虫爬取

新建项目 # 新建项目$ scrapy startproject jianshu# 进入到文件夹 $ cd jainshu# 新建spider文件 $ scrapy genspider -t craw ...

- 爬取简书图片(使用BeautifulSoup)

import requests from bs4 import BeautifulSoup url_list = [] kv = {'User-Agent':'Mozilla/5.0'} r = re ...

随机推荐

- AtomicInteger的并发处理

AtomicInteger的并发处理 博客分类: Effective Java JDK1.5之后的java.util.concurrent.atomic包里,多了一批原子处理类.主要用于在高并发环 ...

- 数据表记录包含表索引和数值(int范围的整数),请对表索引相同的记录进行合并,即将相同索引的数值进行求和运算,输出按照key值升序进行输出

此题如果直接使用有序的TreeMap就不需要这样折腾: 1.map的key值唯一性,故就不在需要set集合来去重 2.使用map后利用key的唯一性,把序列号相同的数据直接加在一起,代码会很简洁 pa ...

- 【python实现卷积神经网络】全连接层实现

代码来源:https://github.com/eriklindernoren/ML-From-Scratch 卷积神经网络中卷积层Conv2D(带stride.padding)的具体实现:https ...

- webWMS开发过程记录(五)- 详细设计之系统界面框架设计

界面区域划分 使用frameset分了上中下三个区域 上:显示系统名称和用户信息,以及一些提示信息(需通过Ajax定时更新提示信息),显示高度固定 中:再次使用frameset分成左右区域 左:显示导 ...

- 第三章:shell变量知识进阶

特殊变量:位置变量大于9的时候,需要加上(),例如$(10)$*获取脚本的所有参数,如果不加""和$@是一样的效果,如果加上"",则表示所有参数组成一个字符串$ ...

- EF-三种映射

更改实体的类名称,字段名称,来映射表名称,表字段. 1,用EF自带的特性方式: 直接加上特性,更新对应的类名,字段名以及引用类,字段名的相关地方 2,参考NHibernate建立一个EF自带的映射 ...

- 全球数字高程数据(DEM)详解,还有地形晕渲、等高线等干货

1 基本概念 DEM是数字高程模型的英文简称(Digital Elevation Model),是研究分析地形.流域.地物识别的重要原始资料.由于DEM 数据能够反映一定分辨率的局部地形特征,因此通过 ...

- Centos 7服务器搭建MySQL(mariadb)服务

1.下载并安装MySQL yum install mariadb mariadb-server -y 2.启动MySQL systemctl start mariadb 3.对mariadb进行初始化 ...

- Mac安装Nginx、Mysql、PHP、Redis

安装xcode命令行工具的命令 xcode-select --install 安装homebrew: ruby -e "$(curl -fsSL https://raw.githubus ...

- ansible的清单管理与模块应用(三)