【CART与GBDT】

一、CART(分类回归树)

1.思想:

一种采用基尼信息增益作为划分属性的二叉决策树。基尼指数越小,表示纯度越高。

2.回归:

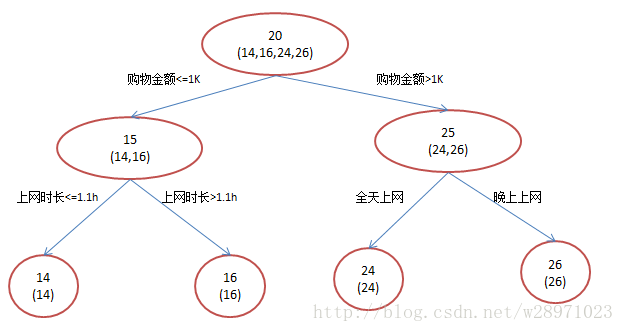

每个节点都有一个预测值,预测值等于属于该节点的所有样例的平均值,分支时,选择每个属性的每个阈值的最好分割点,衡量的标准是最小化均方差。

训练:对训练样本的第i(1<=i<=n)个属性,穷举每个分割点,找到均方差最小的分割点进行分割,该节点的值设为落到该节点的训练样本的平均值,直到不可分或者到一定高度或者属性使用完或者均方差不下降。

测试:对测试样本按照训练时的分割点进行下落,落到叶节点,叶节点的平均值即为预测值。

二、GBDT(梯度提升决策树)

1.原理:

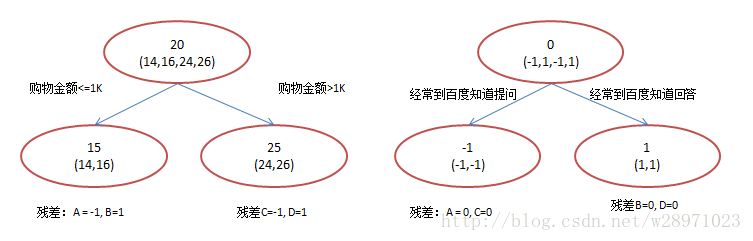

用多棵回归树(或多个弱分类器)进行集成,其中的多棵树不是独立的,而是后面的树在前者的基础上学习误差,所有树的结果加起来是预测得到的结果。弱分类器一般采用CART。

2.过程:

原始回归树:

GBDT:

3.依据:

防止过拟合;

残差计算变相增大了分错样本的权重,分对的趋于0,这样后续的树就能专注于学习分错的样本;

每一步都用残差作为全局最优的梯度方向,并没有真实计算梯度;

每一次都走一小步,逐渐逼近目标,比每次都走一大步逼近目标更能防止过拟合。

4.优缺点:

优点:鲁棒性比较好,准确率比较高。

缺点:弱分类器间存在依赖关系,无法并行训练。

5.问题:

(1)训练过程:

gbdt通过多轮迭代,每轮迭代产生一个弱分类器,每个分类器在上一轮分类器的残差基础上进行训练,通过降低偏差来不断提高最终分类器的精度。

(2)如何选择特征:

如CART,对每个节点的每个切分点进行遍历,选择基尼指数最小的。

(3)如何构建特征:

利用gbdt去产生特征的组合,以叶子结点为基,在基下的表示即为特征。

(4)如何用于分类:

针对样本 X 每个可能的类都训练一个分类回归树。

6.参考:

https://www.cnblogs.com/peizhe123/p/6105696.html

https://www.cnblogs.com/pinard/p/6140514.html

https://www.cnblogs.com/ModifyRong/p/7744987.html

三、Xgboost

1.思想:

Xgboost是GB算法的高效实现,xgboost中的基学习器除了可以是CART(gbtree)也可以是线性分类器(gblinear)

2.区别:

(1)xgboost在目标函数中显示的加上了正则化项,基学习为CART时,正则化项与树的叶子节点的数量T和叶子节点的值有关。

(2)GB中使用Loss Function对f(x)的一阶导数计算出伪残差用于学习生成fm(x),xgboost不仅使用到了一阶导数,还使用二阶导数。

(3)CART回归树中寻找最佳分割点的衡量标准是最小化均方差,xgboost寻找分割点的标准是最大化一个函数。

3.参考:

https://www.cnblogs.com/wxquare/p/5541414.html

【CART与GBDT】的更多相关文章

- 决策树和基于决策树的集成方法(DT,RF,GBDT,XGBT)复习总结

摘要: 1.算法概述 2.算法推导 3.算法特性及优缺点 4.注意事项 5.实现和具体例子 内容: 1.算法概述 1.1 决策树(DT)是一种基本的分类和回归方法.在分类问题中它可以认为是if-the ...

- 决策树和基于决策树的集成方法(DT,RF,GBDT,XGB)复习总结

摘要: 1.算法概述 2.算法推导 3.算法特性及优缺点 4.注意事项 5.实现和具体例子 内容: 1.算法概述 1.1 决策树(DT)是一种基本的分类和回归方法.在分类问题中它可以认为是if-the ...

- GBDT学习笔记

GBDT(Gradient Boosting Decision Tree,Friedman,1999)算法自提出以来,在各个领域广泛使用.从名字里可以看到,该算法主要涉及了三类知识,Gradient梯 ...

- GBDT笔记

GBDT笔记 GBDT是Boosting算法的一种,谈起提升算法我们熟悉的是Adaboost,它和AdaBoost算法不同: 区别如下: AdaBoost算法是利用前一轮的弱学习器的误差来更新样本权重 ...

- CART分类与回归树与GBDT(Gradient Boost Decision Tree)

一.CART分类与回归树 资料转载: http://dataunion.org/5771.html Classification And Regression Tree(CART)是决策 ...

- scikit-learn 梯度提升树(GBDT)调参小结

在梯度提升树(GBDT)原理小结中,我们对GBDT的原理做了总结,本文我们就从scikit-learn里GBDT的类库使用方法作一个总结,主要会关注调参中的一些要点. 1. scikit-learn ...

- 梯度提升树(GBDT)原理小结

在集成学习之Adaboost算法原理小结中,我们对Boosting家族的Adaboost算法做了总结,本文就对Boosting家族中另一个重要的算法梯度提升树(Gradient Boosting De ...

- Adaboost\GBDT\GBRT\组合算法

Adaboost\GBDT\GBRT\组合算法(龙心尘老师上课笔记) 一.Bagging (并行bootstrap)& Boosting(串行) 随机森林实际上是bagging的思路,而GBD ...

- [Machine Learning & Algorithm] 决策树与迭代决策树(GBDT)

谈完数据结构中的树(详情见参照之前博文<数据结构中各种树>),我们来谈一谈机器学习算法中的各种树形算法,包括ID3.C4.5.CART以及基于集成思想的树模型Random Forest和G ...

随机推荐

- Mac 环境 Vue 开发 CPU 占用率高 问题

Mac开发Vue应用时,发现CPU风扇转的老高. htop查看一下: 问题找到了,就是这个dev-server.js,node起的进程. 然后就是 dtruss -p 1230(进程ID) 命名跟踪一 ...

- C#获取路径总结

一.获取当前文件的路径 1. System.Diagnostics.Process.GetCurrentProcess().MainModule.FileName 获取模块的完整路径,包括文件名. ...

- Keepalived 配置高可用集群

一.Keepalived 简介 (1) Keepalived 能实现高可用也能实现负载均衡,Keepalived 是通过 VRRP 协议 ( Virtual Router Redundancy Pro ...

- Github安卓开源项目编译运行

转:http://blog.csdn.net/laihuan99/article/details/9054985 很多新手朋友朋友在Github搜索开源项目时,有时候不明白怎么导入eclipse.的确 ...

- TransmittableThreadLocal 解决 线程池线程复用 无法复制 InheritableThreadLocal 的问题.

ThreadLoacl,InheritableThreadLocal,原理,以及配合线程池使用的一些坑 TransmittableThreadLocal 原理 之前为了能让InheritableThr ...

- Fiddler如何捕捉DefaultHttpClient的HTTP请求

实际开发中为了解决Ajax跨域请求问题,会通过一个同域的控制器在服务端代理请求目标的Web API并将结果返回.为了便于调试这类请求,我们希望通过Fiddler可以监控到这些请求.Fiddler官方给 ...

- MySQL 环境搭建之解压方式安装

一 .MySQL服务 安装 1.下载: 地址: http://dev.mysql.com/downloads/mysql/ 2.安装: 将下载的mysql-5.7.16-winx64压缩包解压后的整 ...

- 10.16 正式开发stark组件(一)

2018-10-16 17:26:44 Django MTV 路由配置里面有 反向解析 参考连接:https://www.cnblogs.com/yuanchenqi/articles/762993 ...

- 关于ICO的一些理解

第一次看到ICO,估计很多人都处于懵逼的状态,感觉很抽象. 提到IOC可能想到的下一个词语就是DI IOC:控制反转 DI:依赖注入 那么什么是控制反转呢? 我以前对这个概念也很模糊,最近在知乎上看到 ...

- 网络通信协议三之TCP/IP模型详解

TCP/IP模型 注:PDU:Protocol Date Unit:表示对等层之间传递的数据单位 TCP:Transmission Control Protocol:传输控制协议 UDP:User D ...