N-gram统计语言模型(总结)

N-gram统计语言模型

1.统计语言模型

自然语言从它产生開始,逐渐演变成一种上下文相关的信息表达和传递的方式。因此让计算机处理自然语言。一个主要的问题就是为自然语言这样的上下文相关特性建立数学模型。

这个数学模型就是自然语言处理中常说的统计语言模型,它是今天全部自然语言处理的基础,而且广泛应用与机器翻译、语音识别、印刷体和手写体识别、拼写纠错、汉字输入和文献查询。

2.N-Gram

N-Gram是大词汇连续语音识别中经常使用的一种语言模型。对中文而言,我们称之为汉语语言模型(CLM,

Chinese Language Model)。汉语语言模型利用上下文中相邻词间的搭配信息,在须要把连续无空格的拼音、笔划,或代表字母或笔划的数字,转换成汉字串(即句子)时。能够计算出具有最大概率的句子,从而实现到汉字的自己主动转换。无需用户手动选择。避开了很多汉字相应一个同样的拼音(或笔划串,或数字串)的重码问题。

搜狗拼音和微软拼音的主要思想就是N-gram模型的,只是在里面多增加了一些语言学规则而已。

3.用数学的方法描写叙述语言规律

第一个句子出现的概率最大,因此。第一个句子最有可能句子结构合理。这种方法更普通而严格的描写叙述是:

假定S表示某一个有意义的句子,由一连串特定顺序排列的词w1,w2,w3,...,wn组成。这里n是句子的长度。如今,我想知道S在文本中(语料库)出现的可能性,也就是数学上所说的S的概率P(S)。我们须要一个模型来估算概率。既然S=w1,w2,w3,...,wn。那么最好还是把P(S)展开表示: P(S)=P(w1,w2,w3,...,wn)

那么对于当中的非常多词对的组合,在语料库中都没有出现,依据最大似然估计得到的概率将会是0。这会造成非常大的麻烦,在算句子的概率时一旦当中的某项为0。那么整个句子的概率就会为0,最后的结果是,我们的模型仅仅能算可怜兮兮的几个句子,而大部分的句子算得的概率是0.

因此,我们要进行数据平滑(data Smoothing),数据平滑的目的有两个:一个是使全部的N-gram概率之和为1,使全部的N-gram概率都不为0,有关数据平滑处理的方法能够參考《数学之美》第33页的内容。

4.马尔科夫如果

为了解决參数空间过大的问题。引入了马尔科夫如果:随意一个词的出现的概率只与它前面出现的有限的一个或者几个词有关。

如果一个词的出现的概率仅于它前面出现的一个词有关。那么我们就称之为bigram model(二元模型)。

即

P(S) = P(W1,W2,W3,…,Wn)=P(W1)P(W2|W1)P(W3|W1,W2)…P(Wn|W1W2…Wn-1)

≈P(W1)P(W2|W1)P(W3|W2)…P(Wi)|P(Wi-1)...P(Wn|Wn-1)

假设一个词的出现仅依赖于它前面出现的两个词,那么我们就称之为trigram(三元模型)。

在实践中用的最多的就是bigram和trigram了,并且效果非常不错。

高于四元的用的非常少,由于训练它(求出參数)须要更庞大的语料。并且数据稀疏严重,时间复杂度高,精度却提高的不多。当然,也能够如果一个词的出现由前面N-1个词决定,相应的模型略微复杂些,被称为N元模型。

5.怎样预计条件概率问题

(C(W1, W2,…,Wn-1)) 。

C(w1,w2,...,wn)即序列w1,w2,...,wn在语料库中出现的次数。

6.在一个语料库样例

在训练语料库中统计序列C(W1 W2…Wn) 出现的次数和C(W1 W2…Wn-1)出现的次数。

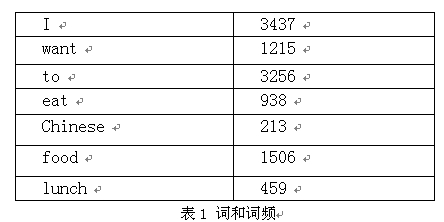

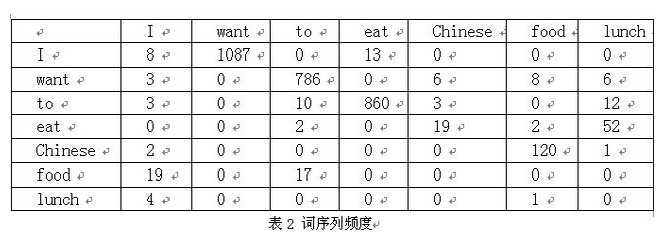

以下我们用bigram举个样例。如果语料库总词数为13,748

P(I want to eat Chinese food)

=P(I)*P(want|I)*P(to|want)*P(eat|to)*P(Chinese|eat)*P(food|Chinese)

=0.25*1087/3437*786/1215*860/3256*19/938*120/213

=0.000154171

对与 I to Chinese want food eat 的概率远低于I want to eat Chinese food,所以后者句子结构更合理。

注:P(wang|I)=C(I want)|C(I)=1087/3437

网上非常多资料中,表1 词与词频和表2 词序列频度是没有的,所以造成文章表意不清。

对于 1).高阶语言模型 2).模型的训练、零概率问题和平滑方法 3).语料库的选取等问题,《数学之美》中都有具体解说,在此不再概述。

版权声明:本文博主原创文章,博客,未经同意不得转载。

N-gram统计语言模型(总结)的更多相关文章

- NLP(三)_统计语言模型

概念 统计语言模型:是描述自然语言内在的规律的数学模型.广泛应用于各种自然语言处理问题,如语音识别.机器翻译.分词.词性标注,等等.简单地说,语言模型就是用来计算一个句子的概率的模型 即P(W1,W2 ...

- [IR课程笔记]统计语言模型

Basic idea 1.一个文档(document)只有一个主题(topic) 2.主题指的是这个主题下文档中词语是如何出现的 3.在某一主题下文档中经常出现的词语,这个词语在这个主题中也是经常出现 ...

- 语言模型(Language Modeling)与统计语言模型

1. n-grams 统计语言模型研究的是一个单词序列出现的概率分布(probability distribution).例如对于英语,全体英文单词构成整个状态空间(state space). 边缘概 ...

- [转]语言模型训练工具SRILM

SRILM是一个建立和使用统计语言模型的开源工具包,从1995年开始由SRI 口语技术与研究实验室(SRI Speech Technology and Research Laboratory)开发,现 ...

- 斯坦福大学自然语言处理第四课“语言模型(Language Modeling)”

http://52opencourse.com/111/斯坦福大学自然语言处理第四课-语言模型(language-modeling) 一.课程介绍 斯坦福大学于2012年3月在Coursera启动了在 ...

- DeepNLP的核心关键/NLP词的表示方法类型/NLP语言模型 /词的分布式表示/word embedding/word2vec

DeepNLP的核心关键/NLP语言模型 /word embedding/word2vec Indexing: 〇.序 一.DeepNLP的核心关键:语言表示(Representation) 二.NL ...

- NLP问题特征表达基础 - 语言模型(Language Model)发展演化历程讨论

1. NLP问题简介 0x1:NLP问题都包括哪些内涵 人们对真实世界的感知被成为感知世界,而人们用语言表达出自己的感知视为文本数据.那么反过来,NLP,或者更精确地表达为文本挖掘,则是从文本数据出发 ...

- language model —— basic model 语言模型之基础模型

一.发展 起源:统计语言模型起源于 Ponte 和 Croft 在 1998年的 SIGIR上发表的论文 应用:语言模型的应用很多: corsslingual retrieval distribute ...

- OCR技术浅探: 语言模型(4)

由于图像质量等原因,性能再好的识别模型,都会有识别错误的可能性,为了减少识别错误率,可以将识别问题跟统计语言模型结合起来,通过动态规划的方法给出最优的识别结果.这是改进OCR识别效果的重要方法之一. ...

随机推荐

- 使用QT 4.8.6 + Cmake 3.0.0 编译 最新版本OpenCv3.0.0

mingw32 (x32) gcc g++ qt opencv- -- cmake -rc1 windows x64 参考文章: http://blog.csdn.net/qiurisuixiang/ ...

- gcc #define 学习记录

//test.c #include <stdio.h> #include <stdlib.h> //字符串化运算符 #define EXPAND(name) ({ \ prin ...

- MySql语句大全:创建、授权、查询、修改等(转)

林炳文Evankaka原创作品.转载请注明出处http://blog.csdn.net/evankaka 一.用户创建.权限.删除 1.连接MySql操作 连接:mysql -h 主机地址 -u 用户 ...

- 让你的字ScrollView、ListView充分伸展

android默认ScrollView.ListView在最顶部的下拉上拉时或底部,未与反弹效应,很僵,让你无法继续拖累,不比iOS至于能否反弹.个人觉得,iOS互动还是略胜一筹.因此,我们已经走在A ...

- Gmail POP3设定

好几个同事在问我怎样使用ThunderBird和OE收取IT CHT的邮箱,因为IT CHT就是用Gmail的功能,因此收发邮件是跟Gmail一样,下面是Gmail的POP&SMTP的设置方法 ...

- String和StringBuffer 常用方法总结

String和StringBuffer 常用方法总结 一.不可变长度String 1.字符串---->char数组 char[] chars=str.toCharArray(); 2.字符串中 ...

- [LeetCode92]Reverse Linked List II

题目: Reverse a linked list from position m to n. Do it in-place and in one-pass. For example:Given 1- ...

- JFileChooser

http://www.cnblogs.com/dyllove98/archive/2012/03/05/2461895.html package swing.choose; import java.a ...

- 使用bootbox.js(二级务必提交书面和数字到数字中国)

页面文件 <#-- 页头 --> <#assign currNav = "deposit"> <#assign title="网校充值&qu ...

- HYSBZ 2243 染色 (树链拆分)

主题链接~~> 做题情绪:这题思路好想.调试代码调试了好久.第一次写线段树区间合并. 解题思路: 树链剖分 + 线段树区间合并 线段树的端点记录左右区间的颜色.颜色数目.合并的时候就用区间合并的 ...