AlexNet论文总结

论文链接:https://papers.nips.cc/paper/2012/file/c399862d3b9d6b76c8436e924a68c45b-Paper.pdf

Q1:解决了什么?

目前主要利用机器学习来解决目标识别任务;

机器学习可以通过“扩充数据集”、“强化训练模型”、“充实预防过拟合的手段”等多种技巧去提高训练性能。

之前机器学习所使用的数据集太小,只能完成简单的识别任务,但是实际场景中识别任务要复杂得多,因此需要更加大型的数据集去训练;

直到最近出现了符合条件的大型数据集(如LabelMe、ImageNet),但是之前的方法都是针对小型数据集的,因此需要更加强大的方法模型来训练大型数据集;

于是,CNN模型闪亮登场!

本文提出的AlexNet模型,正是对传统CNN进行改善来训练大型数据集ImageNet,实现将 ImageNet LSVRC-2010 竞赛中的120万张高分辨率图像分为1000个不同的类别,使得深度学习开始在各个领域大显身手,为后续优秀的网络的提出奠定基础(后面的ImageNet冠军都是用CNN来做的)。

Q2:怎么解决的?

1、网络结构

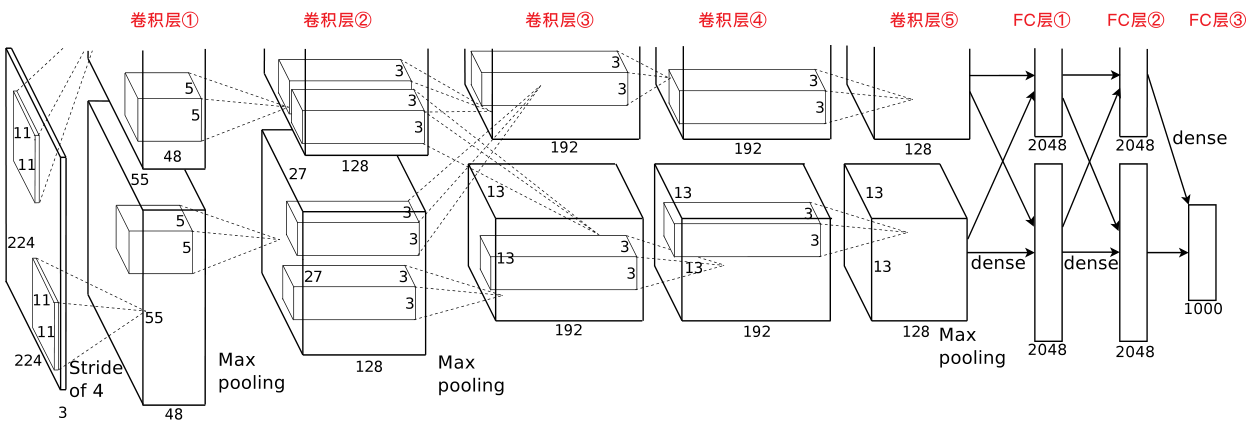

- 5层卷积层+3层全连接层:

- 第2、4、5层卷积层中的内核仅连接到前一层中位于同于同一GPU上的特征图;

- 第3层卷积层中的内核与前一层中所有的特征图相连接。

- 各卷积层的完整操作:

- 第1层、第2层卷积层的完整操作:Conv→LRN→MaxPooling→ReLU;

- 第3层、第4层卷积层的完整操作:Conv→ReLU;

- 第5层卷积层的完整操作:Conv→MaxPooling→ReLU。

2、创新点

1)非饱和激活函数

使用了非饱和激活函数ReLU,有效防止了梯度消失。

关于非饱和激活函数的解释:https://blog.csdn.net/qq_40824311/article/details/103017760

2)多个GPU并行训练

采用了2块GPU进行训练,每个GPU负责一半的神经元,2个GPU只在第3层卷积层进行通信。有效降低了top-1 error和top-5 error。

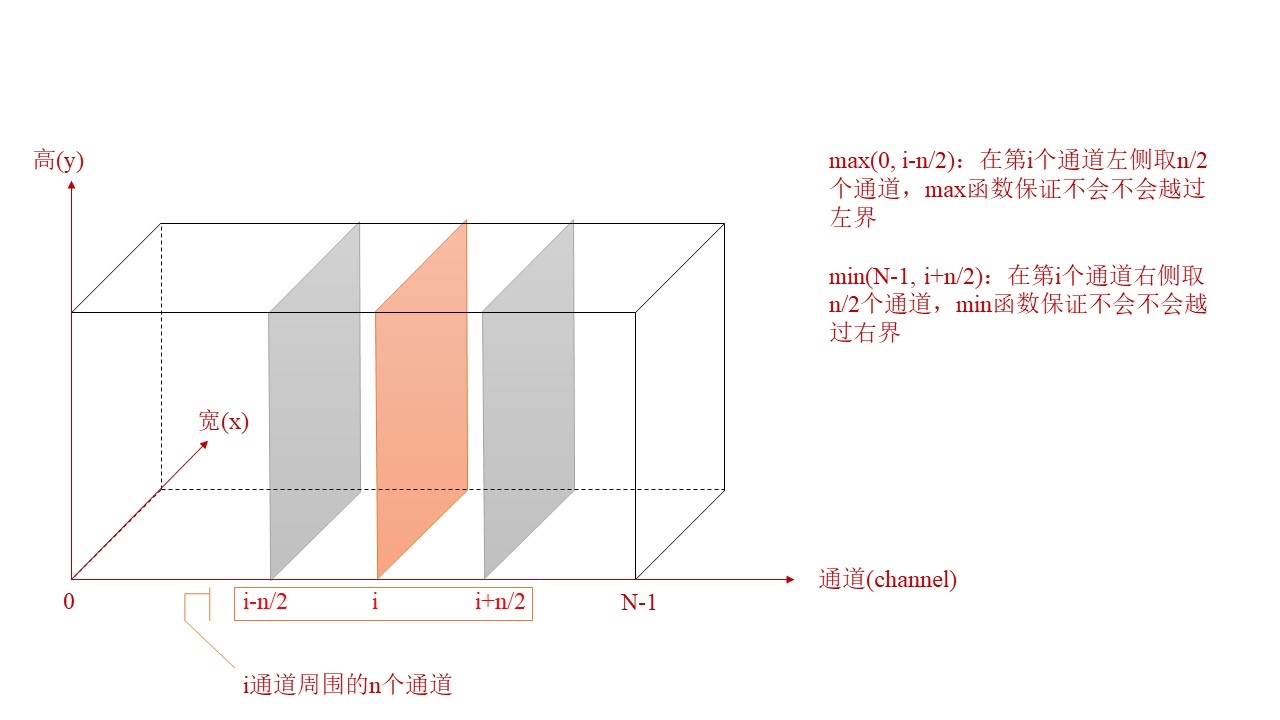

3)LRN(局部响应标准化)

采用了LRN(局部相应标准化),使AlexNet的top-1和top-5错误率分别降低了1.4%和1.2%;

局部响应标准化:有助于提升AlexNet的泛化能力,这种方法受真实神经侧抑制(later inhibition)的启发。

侧抑制:一个细胞分化为不同细胞时,它会对周围的细胞产生抑制信号,组织它们向相同方向分化,最终表现为细胞分化命运的不同。

LRN对局部神经元的活动创建竞争机制,使得响应较大的值变得相对更大,并抑制其他反馈较小的神经元,增强了模型的泛化能力。

LRN公式:$b_{x,y}{i}={a_{x,y}{i}}/{(k+\alpha\sum_{j=max(0,i-n/2)}{min(N-1,i+n/2)}(a_{x,y}{j}){2}){\beta}} $

注:\(a_{x,y}^{i}\)表示第i个通道第x行,第y列对应像素的具体值

4)带重叠的池化

采用了“带重叠的池化(overlapping pooling)”(即令池化步长<池化窗口边长),不易产生过拟合。

5)数据集增强

利用“图片平移&水平翻转”和“改变RGB色差”,实现数据集增强。

6)引入“Dropout失活”

利用dropout(失活率=0.5),有效预防了过拟合。

Dropout介绍:https://www.jianshu.com/p/21d4c64fb8b5

AlexNet论文总结的更多相关文章

- < AlexNet - 论文研读个人笔记 >

Alexnet - 论文研读个人笔记 一.论文架构 摘要: 简要说明了获得成绩.网络架构.技巧特点 1.introduction 领域方向概述 前人模型成绩 本文具体贡献 2.The Dataset ...

- 【分类】AlexNet论文总结

目录 0. 论文链接 1. 概述 2. 对数据集的处理 3. 网络模型 3.1 ReLU Nonlinearity 3.2 Training on multiple GPUs 3.3 Local Re ...

- AlexNet—论文分析及复现

AlexNet卷积神经网络是由Alex Krizhevsky等人在2012年的ImagNet图像识别大赛获得冠军的一个卷积神经网络,该网络放到现在相对简单,但也是深度学习不错的卷积神经网络.论文:&l ...

- AlexNet论文翻译-ImageNet Classification with Deep Convolutional Neural Networks

ImageNet Classification with Deep Convolutional Neural Networks 深度卷积神经网络的ImageNet分类 Alex Krizhevsky ...

- 【深度学习 论文篇 01-1 】AlexNet论文翻译

前言:本文是我对照原论文逐字逐句翻译而来,英文水平有限,不影响阅读即可.翻译论文的确能很大程度加深我们对文章的理解,但太过耗时,不建议采用.我翻译的另一个目的就是想重拾英文,所以就硬着头皮啃了.本文只 ...

- tensorflow学习笔记——AlexNet

1,AlexNet网络的创新点 AlexNet将LeNet的思想发扬光大,把CNN的基本原理应用到了很深很宽的网络中.AlexNet主要使用到的新技术点如下: (1)成功使用ReLU作为CNN的激活函 ...

- 从AlexNet(2012)开始

目录 写在前面 网络结构 创新点 其他有意思的点 参考 博客:blog.shinelee.me | 博客园 | CSDN 写在前面 本文重点在于回顾深度神经网络在CV领域的First Blood--A ...

- 四大网络之Alexnet

本文主要介绍AlextNet的一些知识,这些知识经常被忽略 一.AlextNet的创新点 (1)成功使用ReLU作为CNN的激活函数,并验证其效果在较深的网络超过了Sigmoid,成功解决了Si ...

- 深入理解AlexNet网络

原文地址:https://blog.csdn.net/luoluonuoyasuolong/article/details/81750190 AlexNet论文:<ImageNet Classi ...

随机推荐

- Robot Framework中SSHLibrary 学习与总结

一.安装SSHLibrary 二.关键字 1.与连接相关的 Open Connection Get Connection Get Connections Switch Connection Clos ...

- bugKu变量1

重点:两个$$,这暗示着第二个$变量的值,作为第一个$的名称. 而且代码审计之后,发现只含有字母. 又暗示在变量中,那么猜想是在全局变量中,而php中全局变量是$GLOBALS.

- IT面试最全逻辑题,收藏后成功率提高10%

这是小学二年级的数学题: 猫妈妈钓到一些鱼,平均分给了7只小猫,每只小猫分到的鱼和剩下的鱼刚好一样多.猫妈妈最多钓到了多少条鱼? 这个是出来工作后的现场面试题: [1]假设有一个池塘,里面有无穷多的水 ...

- runtime使用总结

runtime这个东西,项目是很少用到的,但面试又避不可少,了解其内部的机制对底层的理解还是很有必要的. 1.动态添加属性 拓展类别属性的简单实现 a.定义字面量指针 static char dyna ...

- QT. 学习之路 二

Qt 的信号槽机制并不仅仅是使用系统提供的那部分,还会允许我们自己设计自己的信号和槽. 举报纸和订阅者的例子:有一个报纸类 Newspaper,有一个订阅者类 Subscriber.Subscribe ...

- C语言:for语句原理及具体执行过程

#include <stdio.h> int main() { int i,s=0; for(i=1;;i*=2) { s=s+i; if(i%3==0) break; i=i+2; pr ...

- C语言:位运算加密

数据加密解密是一个常用的功能,如果你不希望让别人看到文件中的内容,可以通过密钥(也称"密码")将文件的内容加密.比如文本文件(.txt),加密前的内容是能够读懂的,加密后的内容是& ...

- 实验 1 Linux 系统的安装和常用命令

实验 1 Linux 系统的安装和常用命令 (题目) 一.实验目的 (1)掌握 Linux 虚拟机的安装方法.Spark 和 Hadoop 等大数据软件在 Linux 操作系统 上运行可以发挥最佳性能 ...

- 详解API Gateway流控实现,揭开ROMA平台高性能秒级流控的技术细节

摘要:ROMA平台的核心系统ROMA Connect源自华为流程IT的集成平台,在华为内部有超过15年的企业业务集成经验. 本文分享自华为云社区<ROMA集成关键技术(1)-API流控技术详解& ...

- pagehelper插件使用时查询不到数据

刚用mybatis 的分页插件时,老项目中分页封装的分页类起始为( pageno-1)* pagesize 于是直直接在pagehelper.start(start,pagesize)来进行分页.结 ...