Flume对接Kafka

一.简单实现

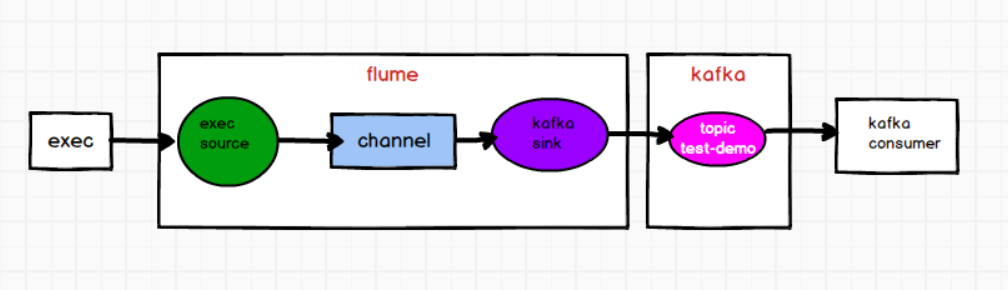

需求:根据 flume 监控 exec 文件的追加数据,写入 kafka 的 test-demo 分区,然后启用 kafka-consumer 消费 test-demo 分区数据。

需求分析

1)flume的配置文件

在hadoop102上创建flume的配置文件

# define

a1.sources = r1

a1.sinks = k1

a1.channels = c1

# source

a1.sources.r1.type = exec

a1.sources.r1.command = tail -F /opt/module/testdata/3.txt

# sink

a1.sinks.k1.type = org.apache.flume.sink.kafka.KafkaSink

#kafka的broker主机和端口

a1.sinks.k1.kafka.bootstrap.servers = hadoop102:9092,hadoop103:9092,hadoop104:9092

#kafka sink发送数据的topic

a1.sinks.k1.kafka.topic = test-demo

a1.sinks.k1.kafka.flumeBatchSize = 20

a1.sinks.k1.kafka.producer.acks = 1

a1.sinks.k1.kafka.producer.linger.ms = 1

# channel

a1.channels.c1.type = memory

a1.channels.c1.capacity = 1000

a1.channels.c1.transactionCapacity = 100

# bind

a1.sources.r1.channels = c1

a1.sinks.k1.channel = c1

2)启动 zk、kafka集群

3)创建 test-demo 主题

bin/kafka-topics.sh --create --bootstrap-server hadoop102:9092 --topic test-demo --partitions 2 --replication-factor 2

4)启动 kafka consumer 去消费 test-demo 主题

bin/kafka-console-consumer.sh --bootstrap-server hadoop102:9092 --topic test-demo

aaa

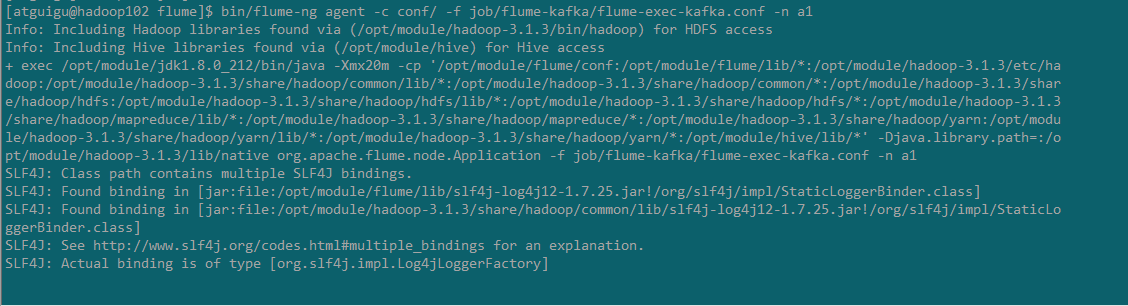

5)启动 flume,并且往 3.txt 中追加数据

bin/flume-ng agent -c conf/ -f job/flume-kafka/flume-exec-kafka.conf -n a1

echo hello >> /opt/module/testdata/3.txt

6)观察 kafka consumer 的消费情况

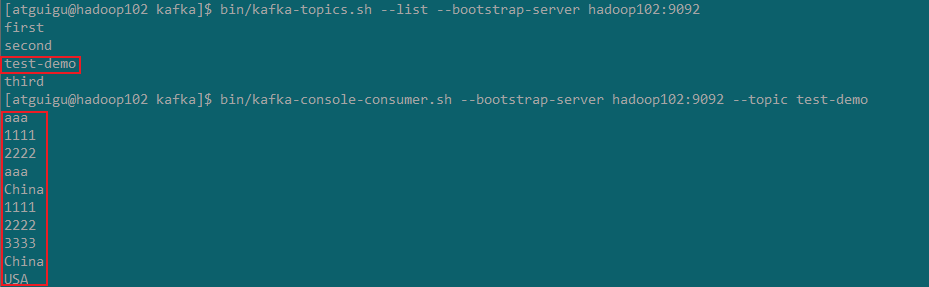

二.自定义interceptor(使用kafka sink)

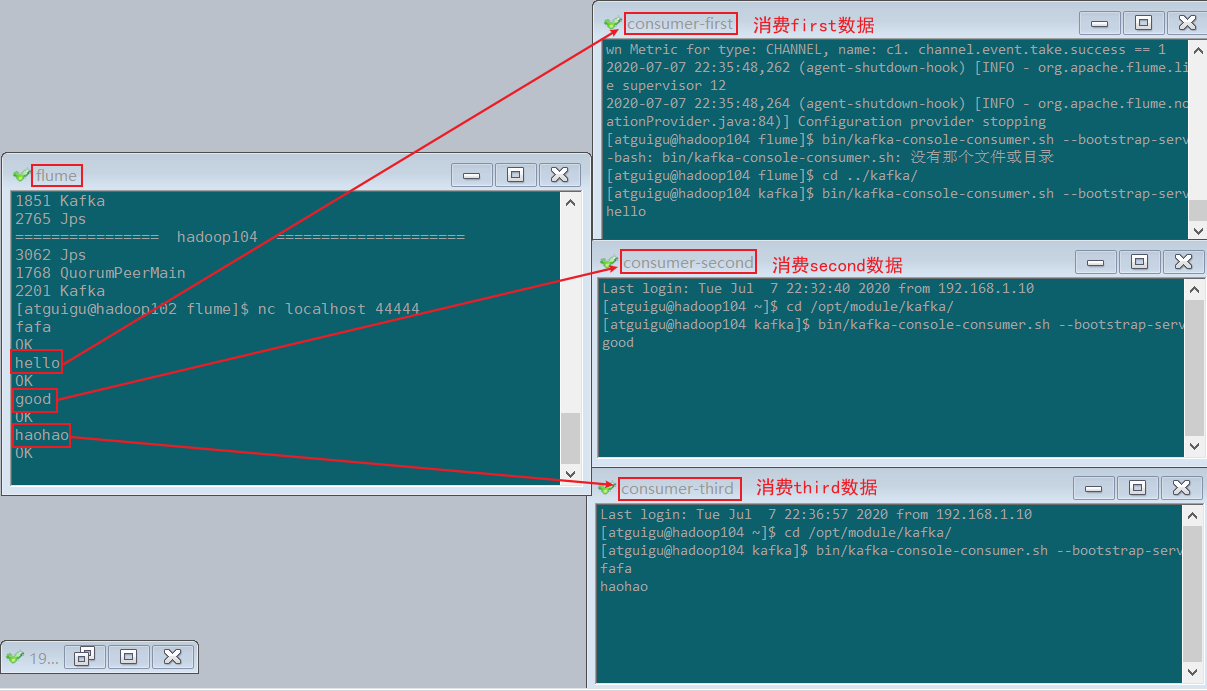

需求:flume监控 exec 文件的追加数据,将flume采集的数据按照不同的类型输入到不同的topic中

将日志数据中带有的 hello 的,输入到kafka的 first 主题中,

将日志数据中带有 good 的,输入到kafka的 second 主题中,

其他的数据输入到kafka的 third 主题中

需求分析

通过自定义 flume 的拦截器,往 header 增加 topic 信息 ,配置文件中 kafka sink 增加 topic 配置,实现将数据按照指定 topic 发送。

1)自定义 flume 拦截器

创建工程,pom依赖

<dependencies>

<dependency>

<groupId>org.apache.flume</groupId>

<artifactId>flume-ng-core</artifactId>

<version>1.9.0</version>

</dependency>

</dependencies>

<build>

<plugins>

<plugin>

<artifactId>maven-compiler-plugin</artifactId>

<version>2.3.2</version>

<configuration>

<source>1.8</source>

<target>1.8</target>

</configuration>

</plugin>

</plugins>

</build>

自定义拦截器类,并打包上传至/opt/module/flume/lib包下

package com.bigdata.intercepter;

import org.apache.flume.Context;

import org.apache.flume.Event;

import org.apache.flume.interceptor.Interceptor;

import java.util.ArrayList;

import java.util.List;

import java.util.Map;

/**

* @description: TODO 自定义flume拦截器

* @author: HaoWu

* @create: 2020/7/7 20:32

*/

public class FlumeKafkaInterceptorDemo implements Interceptor {

private List<Event> events;

//初始化

@Override

public void initialize() {

events = new ArrayList<>();

}

@Override

public Event intercept(Event event) {

// 获取event的header

Map<String, String> header = event.getHeaders();

// 获取event的boby

String body = new String(event.getBody());

// 根据body中的数据设置header

if (body.contains("hello")) {

header.put("topic", "first");

} else if (body.contains("good")) {

header.put("topic", "second");

}

return event;

}

@Override

public List<Event> intercept(List<Event> events) {

// 对每次批数据进来清空events

events.clear();

// 循环处理单个event

for (Event event : events) {

events.add(intercept(event));

}

return events;

}

@Override

public void close() {

}

// 静态内部类创建自定义拦截器对象

public static class Builder implements Interceptor.Builder{

@Override

public Interceptor build() {

return new FlumeKafkaInterceptorDemo();

}

@Override

public void configure(Context context) {

}

}

}

2)编写 flume 的配置文件

flume-netstat-kafka.conf

# Name the components on this agent

a1.sources = r1

a1.sinks = k1

a1.channels = c1

# Describe/configure the source

a1.sources.r1.type = netcat

a1.sources.r1.bind = localhost

a1.sources.r1.port = 44444

#Interceptor

a1.sources.r1.interceptors = i1

#自定义拦截器全类名+$Builder

a1.sources.r1.interceptors.i1.type = com.bigdata.intercepter.FlumeKafkaInterceptorDemo$Builder

# Describe the sink

a1.sinks.k1.type = org.apache.flume.sink.kafka.KafkaSink

#默认发往的topic

a1.sinks.k1.kafka.topic = third

a1.sinks.k1.kafka.bootstrap.servers = hadoop102:9092,hadoop103:9092,hadoop104:9092

a1.sinks.k1.kafka.flumeBatchSize = 20

a1.sinks.k1.kafka.producer.acks = 1

a1.sinks.k1.kafka.producer.linger.ms = 1

# # Use a channel which buffers events in memory

a1.channels.c1.type = memory

a1.channels.c1.capacity = 1000

a1.channels.c1.transactionCapacity = 100

# Bind the source and sink to the channel

a1.sources.r1.channels = c1

a1.sinks.k1.channel = c1

3)创建topic

在kafka中创建 first , second , third 这3个topic

[hadoop@hadoop102 kafka]$ bin/kafka-topics.sh --list --bootstrap-server hadoop102:9092

__consumer_offsets

first

second

test-demo

third

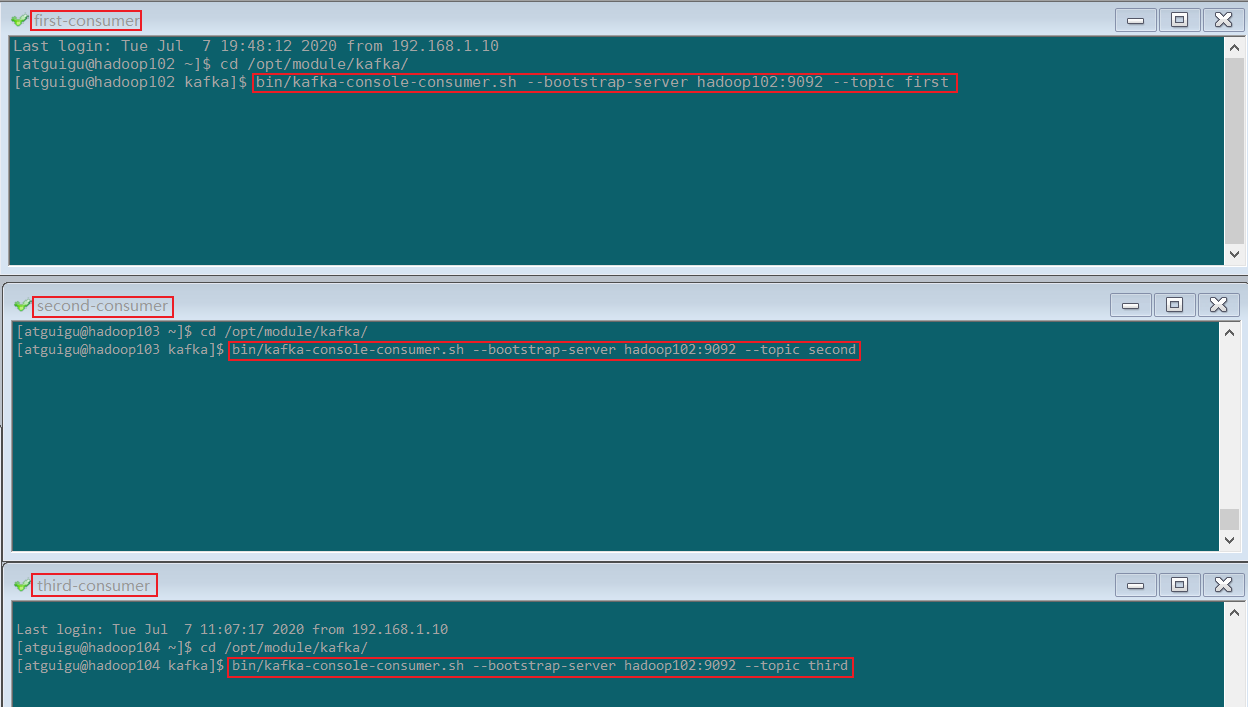

4)启动各组件

启动3个 kafka consumer 分别消费 first , second , third 中的数据

bin/kafka-console-consumer.sh --bootstrap-server hadoop102:9092 --topic first

bin/kafka-console-consumer.sh --bootstrap-server hadoop102:9092 --topic second

bin/kafka-console-consumer.sh --bootstrap-server hadoop102:9092 --topic third

5)启动 flume,通过netstat发送数据到flume

bin/flume-ng agent -c conf/ -f job/flume-kafka/flume-netstat-kafka.conf -n a1

nc localhost 44444

6)观察消费者的消费情况

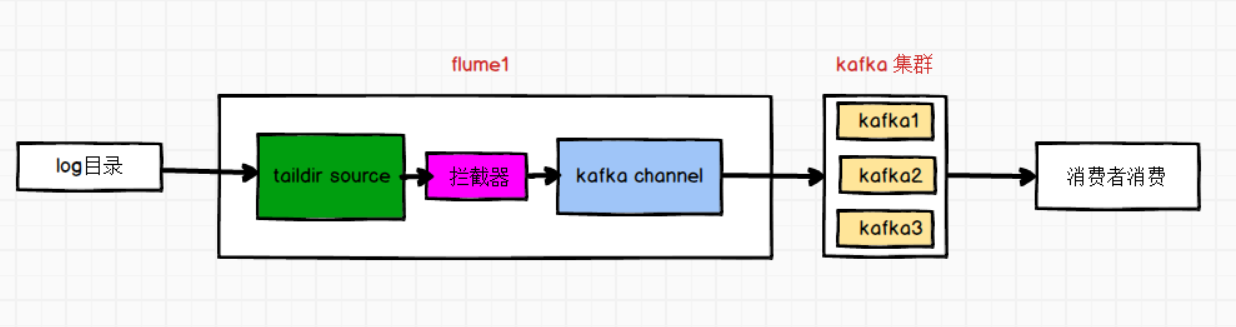

三.自定义interceptor(使用kafka channel)

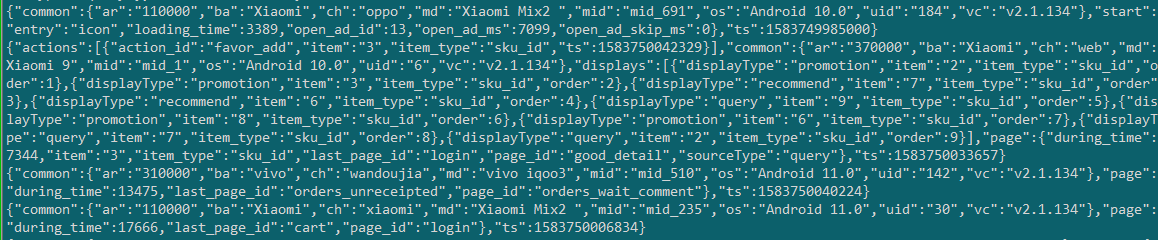

需求:使用taildir source监控/opt/module/applog/log文件夹下的文件,使用拦截器过滤非json的数据,使用kafka channel对接 kafka,将数据发往指定topic。

需求分析

使用kafka channel不需要sink

1)自定义拦截器

创建maven工程

pom文件

<dependencies>

<dependency>

<groupId>org.apache.flume</groupId>

<artifactId>flume-ng-core</artifactId>

<version>1.9.0</version>

<scope>provided</scope>

</dependency>

<dependency>

<groupId>com.alibaba</groupId>

<artifactId>fastjson</artifactId>

<version>1.2.62</version>

</dependency>

</dependencies>

<build>

<plugins>

<plugin>

<artifactId>maven-compiler-plugin</artifactId>

<version>2.3.2</version>

<configuration>

<source>1.8</source>

<target>1.8</target>

</configuration>

</plugin>

<plugin>

<artifactId>maven-assembly-plugin</artifactId>

<configuration>

<descriptorRefs>

<descriptorRef>jar-with-dependencies</descriptorRef>

</descriptorRefs>

</configuration>

<executions>

<execution>

<id>make-assembly</id>

<phase>package</phase>

<goals>

<goal>single</goal>

</goals>

</execution>

</executions>

</plugin>

</plugins>

</build>

编写拦截器类:ETLInterceptor.java

package com.bigdata;

import com.alibaba.fastjson.JSON;

import org.apache.flume.Context;

import org.apache.flume.Event;

import org.apache.flume.interceptor.Interceptor;

import java.util.Iterator;

import java.util.List;

/**

* @description: TODO 自定义拦截器,简单的ETL清洗

* @author: HaoWu

* @create: 2020/7/10 18:14

*/

public class ETLInterceptor implements Interceptor {

@Override

public void initialize() {

}

@Override

public Event intercept(Event event) {

String s = new String(event.getBody());

try {

JSON.toJSON(s);

return event;

} catch (Exception e) {

return null;

}

}

@Override

public List<Event> intercept(List<Event> events) {

Iterator<Event> iterator = events.iterator();

while (iterator.hasNext()){

Event e = iterator.next();

if(e==null){

iterator.remove();

}

}

return events;

}

@Override

public void close() {

}

public static class Builder implements Interceptor.Builder{

@Override

public Interceptor build() {

return new ETLInterceptor();

}

@Override

public void configure(Context context) {

}

}

}

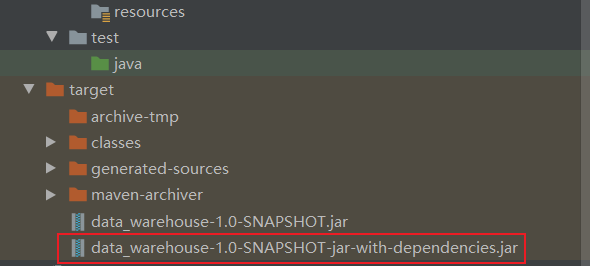

打包,将有依赖的包上传到%Flume_HOME%/lib目录下

2)flume配置

bigdata-applog-kafka.conf

#描述agent

a1.sources = r1

a1.channels = c1

#描述source

a1.sources.r1.type = TAILDIR

a1.sources.r1.positionFile = /opt/module/flume/taildir_position.json

a1.sources.r1.filegroups = f1

a1.sources.r1.filegroups.f1 = /opt/module/applog/log/app.*

#拦截器

a1.sources.r1.interceptors = i1

a1.sources.r1.interceptors.i1.type = com.bigdata.ETLInterceptor$Builder

#描述channel

a1.channels.c1.type = org.apache.flume.channel.kafka.KafkaChannel

a1.channels.c1.kafka.bootstrap.servers = hadoop102:9092,hadoop103:9092,hadoop104:9092

a1.channels.c1.kafka.topic = applog

a1.channels.c1.parseAsFlumeEvent = false

#关联source->channel->sink

a1.sources.r1.channels = c1

3)启动各组件

启动zookeeper、kafka-->启动消费者消费applog主题-->启动flume-->观察消费者

#消费者消费applog

kafka-console-consumer.sh --bootstrap-server hadoop102:9092 --topic applog --from-beginning

#启动flume

bin/flume-ng agent -n a1 -c conf/ -f job/bigdata-applog-kafka.conf

consumer消费到数据

Flume对接Kafka的更多相关文章

- 基于Flume+LOG4J+Kafka的日志采集架构方案

本文将会介绍如何使用 Flume.log4j.Kafka进行规范的日志采集. Flume 基本概念 Flume是一个完善.强大的日志采集工具,关于它的配置,在网上有很多现成的例子和资料,这里仅做简单说 ...

- Flume+LOG4J+Kafka

基于Flume+LOG4J+Kafka的日志采集架构方案 本文将会介绍如何使用 Flume.log4j.Kafka进行规范的日志采集. Flume 基本概念 Flume是一个完善.强大的日志采集工具, ...

- 大数据平台架构(flume+kafka+hbase+ELK+storm+redis+mysql)

上次实现了flume+kafka+hbase+ELK:http://www.cnblogs.com/super-d2/p/5486739.html 这次我们可以加上storm: storm-0.9.5 ...

- Kafka实战-Flume到Kafka

1.概述 前面给大家介绍了整个Kafka项目的开发流程,今天给大家分享Kafka如何获取数据源,即Kafka生产数据.下面是今天要分享的目录: 数据来源 Flume到Kafka 数据源加载 预览 下面 ...

- flume+kafka+hbase+ELK

一.架构方案如下图: 二.各个组件的安装方案如下: 1).zookeeper+kafka http://www.cnblogs.com/super-d2/p/4534323.html 2)hbase ...

- flume到kafka和hbase配置

# Flume test file# Listens via Avro RPC on port 41414 and dumps data received to the logagent.channe ...

- flume从kafka中读取数据

a1.sources = r1 a1.sinks = k1 a1.channels = c1 #使用内置kafka source a1.sources.r1.type = org.apache.flu ...

- flume整合kafka

# Please paste flume.conf here. Example: # Sources, channels, and sinks are defined per # agent name ...

- spark streaming 对接kafka记录

spark streaming 对接kafka 有两种方式: 参考: http://group.jobbole.com/15559/ http://blog.csdn.net/kwu_ganymede ...

随机推荐

- (转载)linux chmod命令用法

chmod----改变一个或多个文件的存取模式(mode) chmod [options] mode files 只能文件属主或特权用户才能使用该功能来改变文件存取模式.mode可以是数字形式(八 ...

- Python NameError:name ‘xrange’ is not defined

在python3 中会出这个问题,而xrange( )函数时在python 2.x中的一个函数,在Python 3中,range()的实现方式与xrange()函数相同,所以就不存在专用的xrange ...

- Luogu P2982 [USACO10FEB]慢下来 Slowing down | dfs序、线段树

题目链接 题目大意: 有一棵N个结点树和N头奶牛,一开始所有奶牛都在一号结点,奶牛们将按从编号1到编号N的顺序依次前往自己的目的地,求每头奶牛在去往自己目的地的途中将会经过多少已经有奶牛的结点. 题解 ...

- SI Macro

获取 buf 里的 symbol cbuf = BufListCount() msg(cbuf) ibuf = 0 while (ibuf < cbuf) { hbuf = BufListIte ...

- 我的笔记本电脑瞬间扩大一个T的容量!

前言 不知道有多少人在家里搭建中央存储设备的,也就是NAS.这个东西在我日常生活中,存储了大量的个人资料,家人们的照片,技术的资料,还有各种高清影视剧.搭配公网的IP,可以真正做到,任何时候任何地点的 ...

- Mac搭建以太坊私有链

记录过程与问题 一.安装 以go版本的ethereum进行安装 brew tap ethereum/ethereum brew install ethereum # 如果希望基于ethereum的de ...

- 变量命名网站 Codelf

程序员最头疼的事情除了头发以外就是给变量或函数命名,一开始学编程语言的时候还可以 abc.a1.x2 等方式命名,等到工作过程中开始真正的项目开发时,如果还是这样随意的命名,即使同事可以忍受你的 ab ...

- 痞子衡嵌入式:聊聊i.MXRT1xxx上的普通GPIO与高速GPIO差异及其用法

大家好,我是痞子衡,是正经搞技术的痞子.今天痞子衡给大家介绍的是i.MXRT上的普通GPIO与高速GPIO差异. GPIO 可以说是 MCU 上最简单最常用的外设模块了,当一些原生功能外设接口模块不能 ...

- 匿名函数托管器 spring-boot-func-starter

spring-boot-func-starter spring-boot-func-starter 介绍 项目地址: https://gitee.com/yiur/spring-boot-func-s ...

- vue-router 4 你真的熟练吗?

虽然 vue-router 4 大多数 API 保持不变,但是在 vue3 中以插件形式存在,所以在使用时有一定的变化.接下来就学习学习它是如何使用的. 一.安装并创建实例 安装最新版本的 vue-r ...