高可用OpenStack(Queen版)集群-15.Glance&Cinder集成Ceph

参考文档:

- Install-guide:https://docs.openstack.org/install-guide/

- OpenStack High Availability Guide:https://docs.openstack.org/ha-guide/index.html

- 理解Pacemaker:http://www.cnblogs.com/sammyliu/p/5025362.html

十九.Glance集成Ceph

1. 配置glance-api.conf

# 在运行glance-api服务的节点修改glance-api.conf文件,含3个控制节点,以controller01节点为例

# 以下只列出涉及glance集成ceph的section

[root@controller01 ~]# vim /etc/glance/glance-api.conf

# 打开copy-on-write功能

[DEFAULT]

show_image_direct_url = True # 变更默认使用的本地文件存储为ceph rbd存储;

# 注意红色字体部分前后一致

[glance_store]

#stores = file,http

#default_store = file

#filesystem_store_datadir = /var/lib/glance/images/

stores = rbd

default_store = rbd

rbd_store_chunk_size = 8

rbd_store_pool = images

rbd_store_user = glance

rbd_store_ceph_conf = /etc/ceph/ceph.conf # 变更配置文件,重启服务

[root@controller01 ~]# systemctl restart openstack-glance-api.service

[root@controller01 ~]# systemctl restart openstack-glance-registry.service

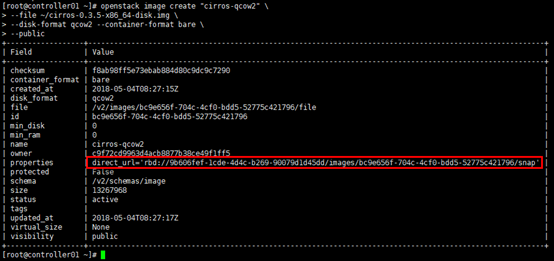

2. 上传镜像

# 镜像上传后,默认地址为ceph集群(ID)的images pool下

[root@controller01 ~]# openstack image create "cirros-qcow2" \

--file ~/cirros-0.3.5-x86_64-disk.img \

--disk-format qcow2 --container-format bare \

--public

# 检查

[root@controller01 ~]# rbd ls images

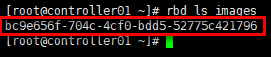

3. 定义pool类型

# images启用后,ceph集群状态变为:HEALTH_WARN

[root@controller01 ~]# ceph -s

# 使用”ceph health detail”,能给出解决办法;

# 未定义pool池类型,可定义为'cephfs', 'rbd', 'rgw'等

[root@controller01 ~]# ceph health detail

# 同时解决volumes与vms两个pool的问题

[root@controller01 ~]# ceph osd pool application enable images rbd

[root@controller01 ~]# ceph osd pool application enable volumes rbd

[root@controller01 ~]# ceph osd pool application enable vms rbd # 查看

[root@controller01 ~]# ceph health detail

[root@controller01 ~]# ceph osd pool application get images

[root@controller01 ~]# ceph osd pool application get volumes

[root@controller01 ~]# ceph osd pool application get vms

二十.Cinder集成Ceph

1. 配置cinder.conf

# cinder利用插件式结构,支持同时使用多种后端存储;

# 在cinder-volume所在节点设置cinder.conf中设置相应的ceph rbd驱动即可;

# 含3个计算(存储)节点,以compute01节点为例;

# 以下只列出涉及cinder集成ceph的section

[root@compute01 ~]# vim /etc/cinder/cinder.conf

# 后端使用ceph存储

[DEFAULT]

enabled_backends = ceph # 新增[ceph] section;

# 注意红色字体部分前后一致

[ceph]

# ceph rbd驱动

volume_driver = cinder.volume.drivers.rbd.RBDDriver

rbd_pool = volumes

rbd_ceph_conf = /etc/ceph/ceph.conf

rbd_flatten_volume_from_snapshot = false

rbd_max_clone_depth = 5

rbd_store_chunk_size = 4

rados_connect_timeout = -1

# 如果配置多后端,则“glance_api_version”必须配置在[DEFAULT] section

glance_api_version = 2

rbd_user = cinder

rbd_secret_uuid = 10744136-583f-4a9c-ae30-9bfb3515526b

volume_backend_name = ceph # 变更配置文件,重启服务

[root@controller01 ~]# systemctl restart openstack-glance-api.service

[root@controller01 ~]# systemctl restart openstack-glance-registry.service

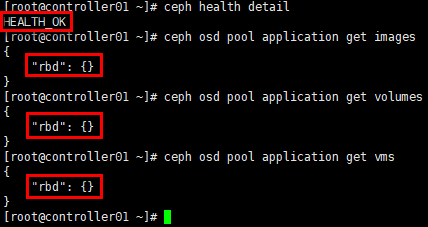

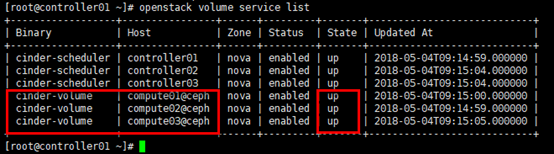

2. 验证

# 查看cinder服务状态,cinder-volume集成ceph后,状态”up”;

# 或:cinder service-list

[root@controller01 ~]# openstack volume service list

3. 生成volume

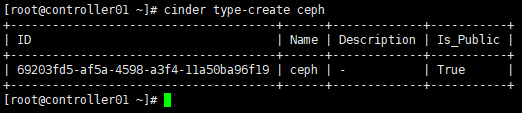

1)设置卷类型

# 在控制节点为cinder的ceph后端存储创建对应的type,在配置多存储后端时可区分类型;

# 可通过“cinder type-list”查看

[root@controller01 ~]# cinder type-create ceph

# 为ceph type设置扩展规格,键值” volume_backend_name”,value值”ceph”

[root@controller01 ~]# cinder type-key ceph set volume_backend_name=ceph

[root@controller01 ~]# cinder extra-specs-list

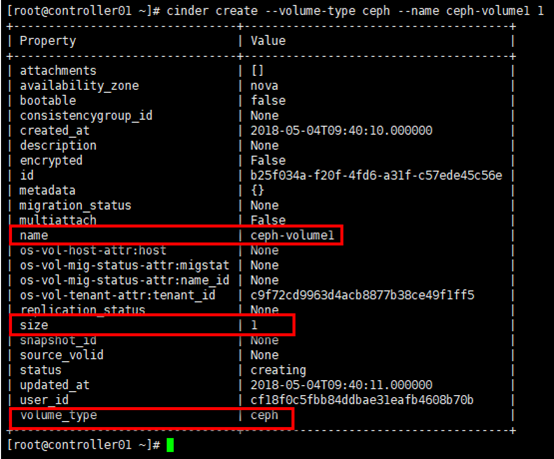

2)生成volume

# 生成volume;

# 最后的数字”1”代表容量为1G

[root@controller01 ~]# cinder create --volume-type ceph --name ceph-volume1 1

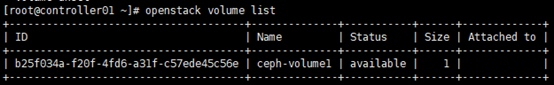

# 检查生成的volume;

# 或:cinder list

[root@controller01 ~]# openstack volume list

# 检查ceph集群的volumes pool

[root@controller01 ~]# rbd ls volumes

高可用OpenStack(Queen版)集群-15.Glance&Cinder集成Ceph的更多相关文章

- Corosync+Pacemaker+DRBD+MySQL 实现高可用(HA)的MySQL集群

大纲一.前言二.环境准备三.Corosync 安装与配置四.Pacemaker 安装与配置五.DRBD 安装与配置六.MySQL 安装与配置七.crmsh 资源管理 推荐阅读: Linux 高可用(H ...

- 高可用,完全分布式Hadoop集群HDFS和MapReduce安装配置指南

原文:http://my.oschina.net/wstone/blog/365010#OSC_h3_13 (WJW)高可用,完全分布式Hadoop集群HDFS和MapReduce安装配置指南 [X] ...

- 16套java架构师,高并发,高可用,高性能,集群,大型分布式电商项目实战视频教程

16套Java架构师,集群,高可用,高可扩展,高性能,高并发,性能优化,设计模式,数据结构,虚拟机,微服务架构,日志分析,工作流,Jvm,Dubbo ,Spring boot,Spring cloud ...

- 通过LVS+Keepalived搭建高可用的负载均衡集群系统

1. 安装LVS软件 (1)安装前准备操作系统:统一采用Centos6.5版本,地址规划如下: 服务器名 IP地址 网关 虚拟设备名 虚拟ip Director Server 192.168 ...

- 分布式架构高可用架构篇_03-redis3集群的安装高可用测试

参考文档 Redis 官方集群指南:http://redis.io/topics/cluster-tutorial Redis 官方集群规范:http://redis.io/topics/cluste ...

- 分布式架构高可用架构篇_01_zookeeper集群的安装、配置、高可用测试

参考: 龙果学院http://www.roncoo.com/share.html?hamc=hLPG8QsaaWVOl2Z76wpJHp3JBbZZF%2Bywm5vEfPp9LbLkAjAnB%2B ...

- Linux 高可用(HA)集群之keepalived详解

http://freeloda.blog.51cto.com/2033581/1280962 大纲 一.前言 二.Keepalived 详解 三.环境准备 四.LVS+Keepalived 实现高可用 ...

- LVS+keeplived+nginx+tomcat高可用、高性能jsp集群

原创作品,允许转载,转载时请务必以超链接形式标明文章 原始出处 .作者信息和本声明.否则将追究法律责任.http://kerry.blog.51cto.com/172631/557749 #!/bin ...

- 【线上测试之后的应用】基于MySQL+MHA+Haproxy构建高可用负载均衡数据库集群(详解)

这里我们先介绍一下MHA是什么,其次就是它的应用与测试,同时为了大家呈现了数据备份案例,最后总结了使用情况以及注意事项和解决办法 一.MHA 概述 MHA(Master High Availabili ...

随机推荐

- django CBV模式下如何去掉csrf验证

方式一:from django.views.decorators.csrf import csrf_exemptfrom django.utils.decorators import method_d ...

- ASP.NET Core读取appsettings.json配置文件信息

1.在配置文件appsettings.json里新增AppSettings节点 { "Logging": { "LogLevel": { "Defau ...

- [luogu2312] 解方程

题面 秦九韶公式 看了上面这个之后大家应该都会了, 就是读入的时候边读入边取模, 从\(1\)到\(m\)间将每一个数带进去试一下就可以了, 复杂度是\(O(nm)\)的. 古人的智慧是无 ...

- Zookeeper入门(一)之概述

今天主要讲这么几个方面? 1.分布式应用: 2.什么是Zookeeper: 3.使用Zookkeeper有什么好处: ZooKeeper是一种分布式协调服务,用于管理大型主机.在分布式环境中协调和管理 ...

- CentOS中配置xrdp,通过微软远程桌面访问CentOS桌面

环境:CentOS 6.4 1.安装相关软件 yum groupinstall "Desktop" (已安装桌面的就可以缺略这条命令) yum install xrdp yum i ...

- Linux进程管理——fork()和写时复制

写时复制技术最初产生于Unix系统,用于实现一种傻瓜式的进程创建:当发出fork( )系统调用时,内核原样复制父进程的整个地址空间并把复制的那一份分配给子进程.这种行为是非常耗时的,因为它需要: · ...

- 生死系列--WuJie

WuJie,高中和中专时期的同学,篮球队的队友. 在高三时认识的,我们隔壁班的,但仅限于认识,并未打过交道.高中毕业后考在同一所学校,同一个班,象棋下的很好,喜欢打扑克牌,在班上任团支部书记. 球队时 ...

- (文章转载)MCI编程

使用MCI API,源文件中需要包含头文件 Mmsystem.h,在Project->Settings->Link->Object/libray module中加入库 Winmm.l ...

- springboot快速入门(一)——HelloWorld搭建

一.起步 1.先导 凡技术必登其官网的原则,官网走一波:https://projects.spring.io/spring-boot/#quick-start 极力推荐一个springboot教程:h ...

- 复制web项目时注意修改web项目名

改web项目的项目名可以右击->properties->搜索web找到settings->修改context name