机器学习——Day 3 多元线性回归

写在开头

由于某些原因开始了机器学习,为了更好的理解和深入的思考(记录)所以开始写博客。

学习教程来源于github的Avik-Jain的100-Days-Of-MLCode

英文版:https://github.com/Avik-Jain/100-Days-Of-ML-Code

中文翻译版:https://github.com/MLEveryday/100-Days-Of-ML-Code

本人新手一枚,所以学习的时候遇到不懂的会经常百度,查看别人的博客现有的资料。但是由于不同的人思维和写作风格都不一样,有时候看到一些长篇大论就不想看,杂乱不想看(实力懒癌患者+挑剔)。看到别人写的不错的就不想再费时间打字了,所以勤奋的找了自认为简洁明了的文章分享在下面,希望能帮助到大家。

注意这是一篇记录博客,非教学。

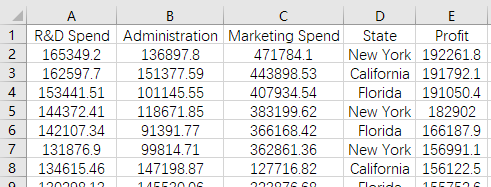

数据部分截图:

Step 1:数据预处理

部分详情请看前两篇:

Day1: https://www.cnblogs.com/hidari26/p/10923822.html

Day2:https://www.cnblogs.com/hidari26/p/10927574.html

#导入库

import pandas as pd

import numpy as np

#导入数据集

dataset = pd.read_csv('50_Startups.csv')

print(dataset[:])

X = dataset.iloc[ : , :-].values

Y = dataset.iloc[ : , ].values

#将类别数据数字化

from sklearn.preprocessing import LabelEncoder, OneHotEncoder

labelencoder = LabelEncoder()

X[ : , ] = labelencoder.fit_transform(X[ : , ])

onehotencoder = OneHotEncoder(categorical_features = [])

X = onehotencoder.fit_transform(X).toarray()

#躲避虚拟变量陷阱

X1 = X[ : , : ]

虚拟变量的内容在图片中有说明,这里不重复。

说实话,这里我不是很懂。这里居然采用的是去掉第一列的数据???有人能告诉我是为什么吗?

#拆分数据集为训练集和测试集

from sklearn.model_selection import train_test_split

X_train, X_test, Y_train, Y_test = train_test_split(X, Y, test_size = 0.2, random_state = )

X1_train, X1_test, Y1_train, Y1_test = train_test_split(X1, Y, test_size = 0.2, random_state = )

Step 2: 在训练集上训练多元线性回归模型

这里和简单线性回归模型一样使用就好了。

from sklearn.linear_model import LinearRegression

regressor = LinearRegression()

regressor.fit(X_train, Y_train)

regressor1 = LinearRegression()

regressor1.fit(X1_train, Y1_train)

Step 3: 在测试集上预测结果

Y_pred表示原始预测结果,Y1_pred表示躲避虚拟变量陷阱后的预测结果。

Y_pred = regressor.predict(X_test)

Y1_pred = regressor1.predict(X1_test)

print(Y_pred)

print(Y1_pred)

Step 4: 输出误差

最后我们比较一下两个数据哪个得出的模型更好,更精确。这里介绍一个新的类 sklearn.metrics.r2_score 相关指数R2(也称决定系数 coefficient of determinantion), 表示一元多项式回归方程拟合度的高低,或者说表示一元多项式回归方程估测的可靠程度的高低。越接近1,模型越好;越接近0,模型越差。

英文说明:https://scikit-learn.org/stable/modules/generated/sklearn.metrics.r2_score.html

from sklearn.metrics import r2_score

print(r2_score(Y_test, Y_pred))

print(r2_score(Y1_test, Y1_pred))

0.9347068473282246

0.9347068473282292

可一看出,虽然差别不大,但是Y1_pred更精确一些。

总结

这一章的内容和上一章相似,主要在数据预处理时,有必要的话编辑虚拟变量并注意避免虚拟变量陷阱。至于这里为什么采用这种方式避免虚拟变量陷阱,不懂啊~

欢迎评论中提问,相关问题将在此更新!

机器学习——Day 3 多元线性回归的更多相关文章

- coursera机器学习笔记-多元线性回归,normal equation

#对coursera上Andrew Ng老师开的机器学习课程的笔记和心得: #注:此笔记是我自己认为本节课里比较重要.难理解或容易忘记的内容并做了些补充,并非是课堂详细笔记和要点: #标记为<补 ...

- [机器学习Lesson4]多元线性回归

1. 多元线性回归定义 多元线性回归也被称为多元线性回归. 我们现在介绍方程的符号,我们可以有任意数量的输入变量. 这些多个特征的假设函数的多变量形式如下: hθ(x)=θ0+θ1x1+θ2x2+θ3 ...

- 【TensorFlow篇】--Tensorflow框架初始,实现机器学习中多元线性回归

一.前述 TensorFlow是谷歌基于DistBelief进行研发的第二代人工智能学习系统,其命名来源于本身的运行原理.Tensor(张量)意味着N维数组,Flow(流)意味着基于数据流图的计算,T ...

- 100天搞定机器学习|Day3多元线性回归

前情回顾 [第二天100天搞定机器学习|Day2简单线性回归分析][1],我们学习了简单线性回归分析,这个模型非常简单,很容易理解.实现方式是sklearn中的LinearRegression,我们也 ...

- Andrew Ng机器学习课程笔记--week2(多元线性回归&正规公式)

1. 内容概要 Multivariate Linear Regression(多元线性回归) 多元特征 多元变量的梯度下降 特征缩放 Computing Parameters Analytically ...

- 斯坦福机器学习视频笔记 Week2 多元线性回归 Linear Regression with Multiple Variables

相比于week1中讨论的单变量的线性回归,多元线性回归更具有一般性,应用范围也更大,更贴近实际. Multiple Features 上面就是接上次的例子,将房价预测问题进行扩充,添加多个特征(fea ...

- 多元线性回归----Java简单实现

http://www.cnblogs.com/wzm-xu/p/4062266.html 多元线性回归----Java简单实现 学习Andrew N.g的机器学习课程之后的简单实现. 课程地址:h ...

- machine learning 之 多元线性回归

整理自Andrew Ng的machine learning课程 week2. 目录: 多元线性回归 Multivariates linear regression /MLR Gradient desc ...

- 【R】多元线性回归

R中的线性回归函数比较简单,就是lm(),比较复杂的是对线性模型的诊断和调整.这里结合Statistical Learning和杜克大学的Data Analysis and Statistical I ...

随机推荐

- Java 中 break和 continue 的使用方法及区别

break break可用于循环和switch...case...语句中. 用于switch...case中: 执行完满足case条件的内容内后结束switch,不执行下面的语句. eg: publi ...

- 全面了解cookie和session

http协议: http即超文本传输协议(万维网定义的),一种基于浏览器请求与服务器响应的链接,它是一个很纯粹的传输协议.http协议主要的特征就是它是一种无状态的协议(只针对cookie与sessi ...

- python经典书籍:Python编程实战 运用设计模式、并发和程序库创建高质量程序

Python编程实战主要关注了四个方面 即:优雅编码设计模式.通过并发和编译后的Python(Cython)使处理速度更快.高层联网和图像.书中展示了在Python中已经过验证有用的设计模式,用专家级 ...

- LINUX-用户和群组

groupadd group_name 创建一个新用户组 groupdel group_name 删除一个用户组 groupmod -n new_group_name old_group_name 重 ...

- Packages on Ubuntu OS

openSSH https://help.ubuntu.com/lts/serverguide/openssh-server.html

- lombok 插件安装

1. 下载地址: https://plugins.jetbrains.com/plugin/6317-lombok-plugin 2. 选择从本地安装.

- 《Noisy Activation Function》噪声激活函数(一)

本系列文章由 @yhl_leo 出品,转载请注明出处. 文章链接: http://blog.csdn.net/yhl_leo/article/details/51736830 Noisy Activa ...

- RDLC报表总结

这2天纠结的报表基本上已近完成大部分功能.现在总结一下自己近期的学习成果 首先制作微软RDLC报表由以下三部分构成:1.制作自己的DateSet集合(就是报表的数据集):2.制作自己的报表文件.rdl ...

- 交换机是干嘛的!!交换机如何学习MAC地址过程?

1.它收到一个帧的时候,先检查源MAC地址,看看自己维护的一个地址表中有没有这个地址.如果有,则2:如果没有,则将这个MAC地址.进入的端口.进入的时间放入这个表中: 2.检查目的MAC地址,然后到该 ...

- easyui 后台框架搭建

近期公司要搭建一个后台管理项目.因为美工缺少 选择使用easyui jquery 框架 仅仅要懂点html js 这个用起来不是难事,看过API.在网上看了些 将它们组装起来 进行改动.因为本人也是第 ...