python 爬虫学习之路

2016-6-18

--今天实现了第一个用urllib2实现的爬虫程序。

--过程中发现

req = urllib2.Request(url,headers = headers)

总是报错: 主要原因在于 url 地址错误。

例如:http://www.neihan8.com/wenzi/index_1.html

这个网址打开的是404网页错误。

但是 http://www.neihan8.com/wenzi/index_2.html 这个网页却可以了。

源代码如下:

#-*- coding:utf-8 -*-

import urllib2

class Spider:

'''

内涵段子吧。。。

'''

def load_page(self,page):

'''

发送内涵段子url

'''

url = 'http://www.neihan8.com/wenzi/index_'+ str(page) +'.html'

headers = {"User-Agent": "Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/51.0.2704.63 Safari/537.36"}

req = urllib2.Request(url,headers = headers)

response = urllib2.urlopen(req)

html = response.read()

return html

#main

''' '''

if __name__ == '__main__':

mySpider = Spider()

the_page = mySpider.load_page(2)

print the_page

综上,我们可以在代码中加一个判断 url 是否打开正常的代码,这个需要学习。

-----------------------------------------------------------华丽丽的分割线-------------------------------------------------------------------------------------------------

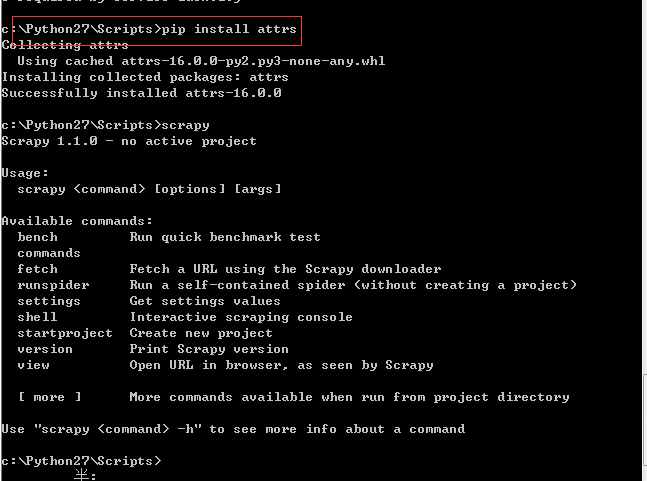

安装Scrapy

--安装scrapy 都要快被安装死了

首先会发现提示 一下问题:

1.版本问题,就是说 Scrapy 所依赖的模块版本太低。'>=1.00' 表明你要使用大于1.0的版本

2.

说明 你有一个包 attrs 没有安装。

那就使用 pip install attrs 安装即可

安装完之后终于正常了。。。。

Python教程:pywin32下载安装

下载链接http://sourceforge.net/projects/pywin32/files/pywin32/Build%20218/pywin32-218.win32-py2.7.exe/download

-------------------------开启爬虫之路----------------------------------------------

首先先说明当中可能遇到的问题:

1.String or binary data would be truncated.解决方法

步骤:在执行插入语句时,会提示上面的error。

原因:是因为数据库中定义的字段长度比较小,在插入或者更新的时候,用一个比这个字段长度大的值去操作,就会引起这个错误。

2.

python向数据库插入中文乱码问题

第一步:数据库那边总得把字段类型设置为utf8之类类的吧。

python 爬虫学习之路的更多相关文章

- python爬虫学习之路-遇错笔记-1

当在运行爬虫时同时开启了Fidder解析工具时(此爬虫并不是用于爬取手机端那内容,而是爬去电脑访问的网页时),访问目标站点会遇到以下错误: File "C:\Users\litao\AppD ...

- python爬虫学习(1) —— 从urllib说起

0. 前言 如果你从来没有接触过爬虫,刚开始的时候可能会有些许吃力 因为我不会从头到尾把所有知识点都说一遍,很多文章主要是记录我自己写的一些爬虫 所以建议先学习一下cuiqingcai大神的 Pyth ...

- python爬虫学习 —— 总目录

开篇 作为一个C党,接触python之后学习了爬虫. 和AC算法题的快感类似,从网络上爬取各种数据也很有意思. 准备写一系列文章,整理一下学习历程,也给后来者提供一点便利. 我是目录 听说你叫爬虫 - ...

- Python爬虫学习:三、爬虫的基本操作流程

本文是博主原创随笔,转载时请注明出处Maple2cat|Python爬虫学习:三.爬虫的基本操作与流程 一般我们使用Python爬虫都是希望实现一套完整的功能,如下: 1.爬虫目标数据.信息: 2.将 ...

- Python爬虫学习:四、headers和data的获取

之前在学习爬虫时,偶尔会遇到一些问题是有些网站需要登录后才能爬取内容,有的网站会识别是否是由浏览器发出的请求. 一.headers的获取 就以博客园的首页为例:http://www.cnblogs.c ...

- Python爬虫学习:二、爬虫的初步尝试

我使用的编辑器是IDLE,版本为Python2.7.11,Windows平台. 本文是博主原创随笔,转载时请注明出处Maple2cat|Python爬虫学习:二.爬虫的初步尝试 1.尝试抓取指定网页 ...

- 《Python爬虫学习系列教程》学习笔记

http://cuiqingcai.com/1052.html 大家好哈,我呢最近在学习Python爬虫,感觉非常有意思,真的让生活可以方便很多.学习过程中我把一些学习的笔记总结下来,还记录了一些自己 ...

- python爬虫学习视频资料免费送,用起来非常666

当我们浏览网页的时候,经常会看到像下面这些好看的图片,你是否想把这些图片保存下载下来. 我们最常规的做法就是通过鼠标右键,选择另存为.但有些图片点击鼠标右键的时候并没有另存为选项,或者你可以通过截图工 ...

- python爬虫学习笔记(一)——环境配置(windows系统)

在进行python爬虫学习前,需要进行如下准备工作: python3+pip官方配置 1.Anaconda(推荐,包括python和相关库) [推荐地址:清华镜像] https://mirrors ...

随机推荐

- ES6+转ES5

npm init //创建package.json文件 下载转换babel库及其100+依赖 npm install babel-cli -D npm install babel-preset-env ...

- Docker容器学习与分享08

Docker容器网络 Docker除了默认创建的三种网络外,还可以自定义网络. 首先创建一个bridge类型的网络,使用docker network create命令. [root@promote ~ ...

- Hash问题----Hash强碰撞

包含内容:hellowword,byeworld文件md5,pdf1,2的sha1值. 等待笔记...

- git pull与本地修改冲突

1.先将本地修改存储起来 $ git stash 这样本地的所有修改就都被暂时存储起来 . $ git stash list 可以看到保存的信息: git stash暂 ...

- HTML5API之获取地理位置详解

在使用地理位置API之前先来了解一下什么是经度和纬度以及地理位置获取的原理 首先经度指的是南北极的连接线,纬度指的是东西的连接线 地理位置的获取原理是通过IP地址(基于ISP记录,能够知道这个IP地址 ...

- Windows连接Linux虚拟机里面的Docker容器

一.Windows.Linux虚拟机.docker关系图 如果此时在Windows宿主机中pingDocker容器是ping不同的,因为在宿主机上没有通往172.17.0.0/24网络的路由,宿主机会 ...

- HackerRake平台说明和介绍

这是之前调研的时候稍微做了一个大致的总结,现在将其分享出去,感觉放在自己的文档管理库中,用处有限.分享出去,说不定能给一些朋友带来有益的启发. 另外我们团队最近也在考虑开发OJ平台.HackerRak ...

- QT学习笔记8:QDir类及其用法总结

简介 QDir类提供了访问系统目录结构及其内容的与平台无关的方式. 头文件:#include <qdir.h> QDir类用来操作路径名及底层文件系统,获取关于目录路径及文件的相关信息,也 ...

- JAVA springmvc 转换器

一.有时候springmvc给咱们提供的数据转换并不能转换所有类型比如说由字符串类型转换Date类型,这时候需要我们自定义转换器,帮助springmvc转换我们需要的类型. 二.1)定义我们的转换器: ...

- Kafka设计解析(二十一)Kafka水位(high watermark)与leader epoch的讨论

转载自 huxihx,原文链接 Kafka水位(high watermark)与leader epoch的讨论 本文主要讨论0.11版本之前Kafka的副本备份机制的设计问题以及0.11是如何解决的. ...