5分钟学习spark streaming之 轻松在浏览器运行和修改Word Counts

方案一:根据官方实例,下载预编译好的版本,执行以下步骤:

- nc -lk 9999 作为实时数据源

- ./bin/run-example org.apache.spark.examples.sql.streaming.StructuredNetworkWordCount localhost 9999

- 在第一步的terminal 窗口输入一些句子

- 第二步的output 就是实时执行结果

此方案的问题有

- 探索其中的api 比较困难,比如我想试试另外一种写法,需要改源码,然后编译,时间就变长了

- 如果是一个裸机的话,需要安装好java 环境,spark和java版本之间的依赖也要特别小心

方案二(2个docker 命令,你就可以为所欲为的在浏览器里面运行,更改Word counts这个hello word了)

除去下载docker img的时间,5min没法完成以下步骤,请立即私信给我,有奖,哈哈

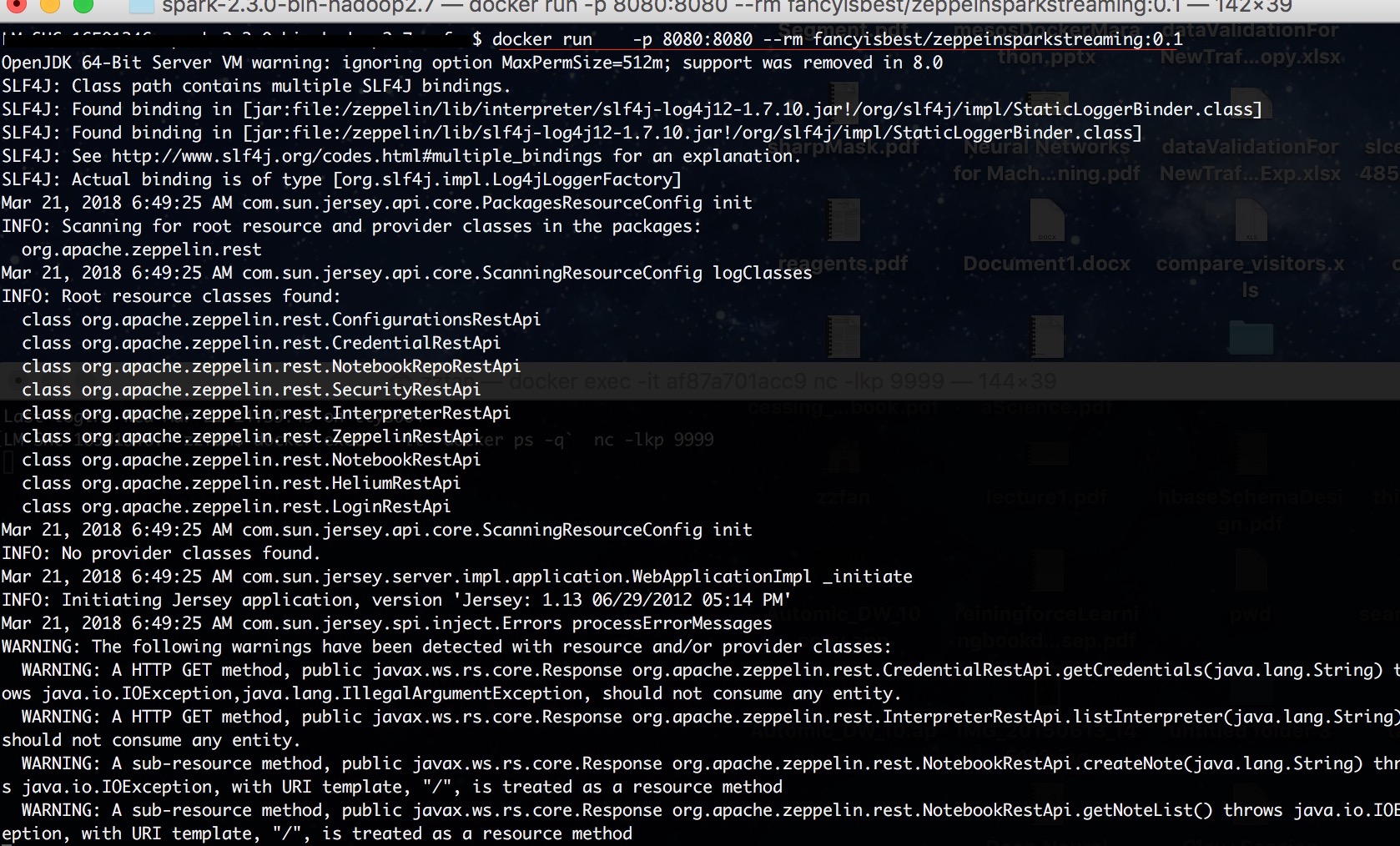

- docker run -p 8080:8080 --rm fancyisbest/zeppeinsparkstreaming:0.1 (第一次会花很长时间在pull img)

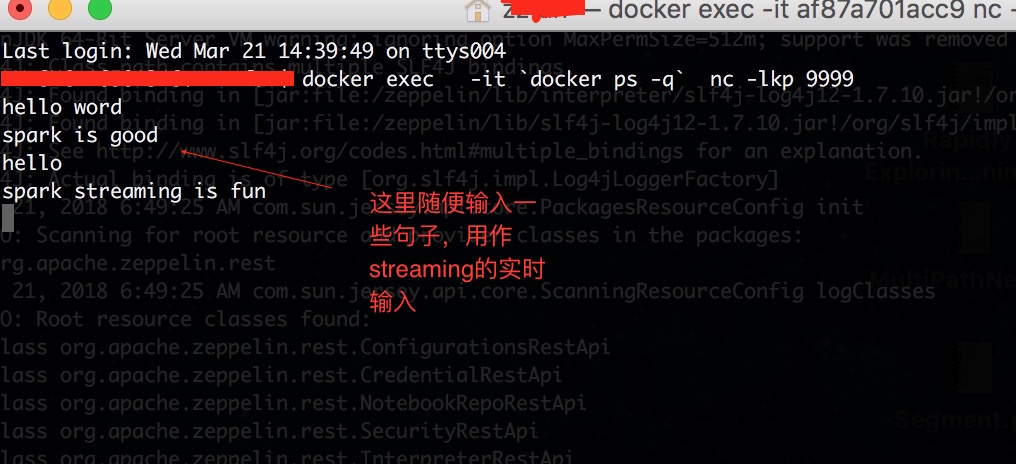

- docker exec -it `docker ps -q` nc -lkp 9999 (注意如果你有多个container在运行,请把`docker ps -q` 替换成上一个的container id)

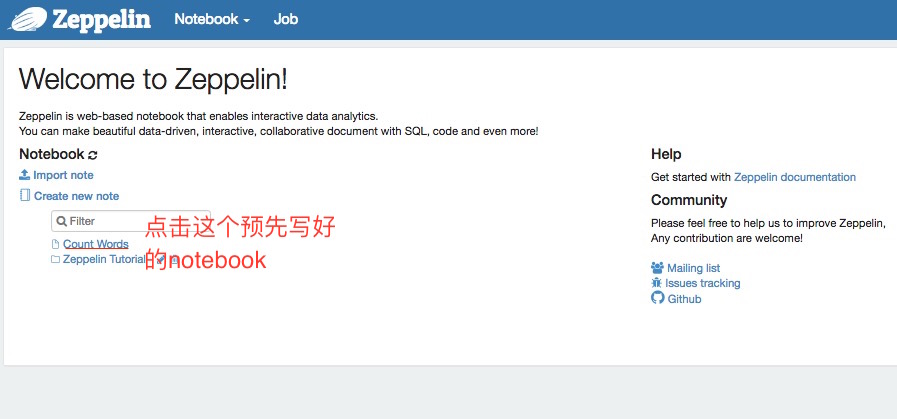

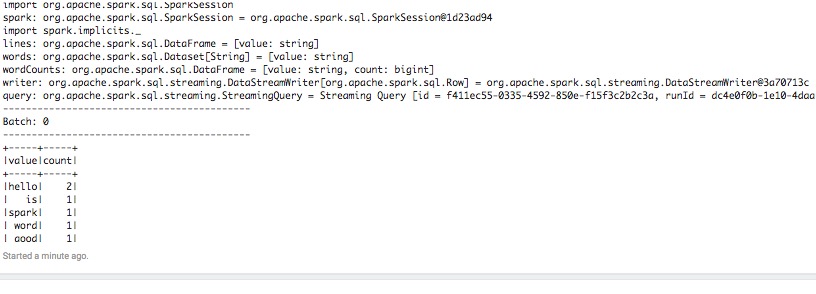

- 打开浏览器输入http://localhost:8080/#/, 左下角有Word counts,点击进入notebook,点击运行所有段落。

- 在第二步termial输入些句子,你就可以在notebook里面观察到streaming 在执行。

此方案的优势

- 除了docker,不需要安装任何依赖,这很dev ops

- 可以狠狠地改代码,改完就可以立即执行,不用担心会破坏任何环境,探索你的世界,你做主。

提示:

- 此方案的技术堆是:docker+zeppelin+spark

- docker img是我在zeppelin img上加入了必要的命令和notebook 打包成的img,请放心使用。

- 如果你对docker,zeppelin不熟悉,不要担心,它们都很简单,只要稍微花点时间就可以掌握,请记住我们的目标是学习spark streaming

参考:

zeppelin 官网http://zeppelin.apache.org/

5分钟学习spark streaming之 轻松在浏览器运行和修改Word Counts的更多相关文章

- 5分钟学习spark streaming 表格和图形化的文档-概览

看图回答以下问题: 1. spark streaming 架构以及功能特性 2. spark streaming mode?以及每个mode主要特性?包括延迟和语义保证.

- Dream_Spark-----Spark 定制版:005~贯通Spark Streaming流计算框架的运行源码

Spark 定制版:005~贯通Spark Streaming流计算框架的运行源码 本讲内容: a. 在线动态计算分类最热门商品案例回顾与演示 b. 基于案例贯通Spark Streaming的运 ...

- 【Streaming】30分钟概览Spark Streaming 实时计算

本文主要介绍四个问题: 什么是Spark Streaming实时计算? Spark实时计算原理流程是什么? Spark 2.X下一代实时计算框架Structured Streaming Spark S ...

- 基于案例贯通 Spark Streaming 流计算框架的运行源码

本期内容 : Spark Streaming+Spark SQL案例展示 基于案例贯穿Spark Streaming的运行源码 一. 案例代码阐述 : 在线动态计算电商中不同类别中最热门的商品排名,例 ...

- 5.Spark Streaming流计算框架的运行流程源码分析2

1 spark streaming 程序代码实例 代码如下: object OnlineTheTop3ItemForEachCategory2DB { def main(args: Array[Str ...

- 贯通Spark Streaming流计算框架的运行源码

本章节内容: 一.在线动态计算分类最热门商品案例回顾 二.基于案例贯通Spark Streaming的运行源码 先看代码(源码场景:用户.用户的商品.商品的点击量排名,按商品.其点击量排名前三): p ...

- Spark Streaming概念学习系列之SparkStreaming运行原理

SparkStreaming运行原理 Spark Streaming不断的从数据源获取数据(连续的数据流),并将这些数据按照周期划分为batch. Spark Streaming将每个batch的数据 ...

- spark streaming 接收kafka消息之四 -- 运行在 worker 上的 receiver

使用分布式receiver来获取数据使用 WAL 来实现 exactly-once 操作: conf.set("spark.streaming.receiver.writeAheadLog. ...

- Spark Streaming:大规模流式数据处理的新贵(转)

原文链接:Spark Streaming:大规模流式数据处理的新贵 摘要:Spark Streaming是大规模流式数据处理的新贵,将流式计算分解成一系列短小的批处理作业.本文阐释了Spark Str ...

随机推荐

- PAT乙级1065 map

思路:检查某个客人是否有伴侣,如果有,伴侣是否也出现即可. 注意:0个单身狗的时候,不要输出多余的'\n', 否则会出现格式错误. AC代码 #include <stdio.h> #inc ...

- 【BZOJ2959】长跑 (LCT+并查集)

Time Limit: 1000 ms Memory Limit: 256 MB Description 某校开展了同学们喜闻乐见的阳光长跑活动.为了能“为祖国健康工作五十年”,同学们纷纷离开寝室 ...

- 在SpringBoot中存放session到Redis

前言 今天你们将再一次领略到SpringBoot的开发到底有多快,以及SpringBoot的思想(默认配置) 我们将使用redis存放用户的session,用户session存放策略有很多,有存放到内 ...

- js将汉字转为相应的拼音

<!DOCTYPE html> <html lang="zh"> <head> <meta charset="UTF-8&quo ...

- 极限学习机︱R语言快速深度学习进行回归预测

本文转载于张聪的博客,链接:https://ask.hellobi.com/blog/zason/4543. 深度学习在过去几年,由于卷积神经网络的特征提取能力让这个算法又火了一下,其实在很多年以前早 ...

- linux下编译sphinx拓展

编译libsphinxclient sphinx 源码包里的api文件夹下的libsphinxclient cd /root/api/libsphinxclient/ ./configure make ...

- Java中的表达式运算

1.问题背景 以下代码运行的结果为: A.a的值:8 b的值:7 B.a的值:8 b的值:8 C.a的值:9 b的值:7 D.a的值 ...

- Linux显示一个二进制文件或可执行文件的完整路径

Linux显示一个二进制文件或可执行文件的完整路径 youhaidong@youhaidong-ThinkPad-Edge-E545:~$ which halt /sbin/halt

- C# 枚举使用和对应说明获取实例

1.定义枚举 /// <summary> /// 订单状态 /// </summary> public enum OrderState { 待支付 = 1, 待处理 = 2, ...

- INT_MAX (2147483647) 和INT_MIN (-2147483648)溢出

c语言中32位int型数据在运算的时候可能会出现溢出的情况,如: -2147483648-1会得到什么结果? -2147483648乘(-1)会得到什么结果? 2147483647+1会得到什么结果? ...