机器学习(十九)— xgboost初试kaggle

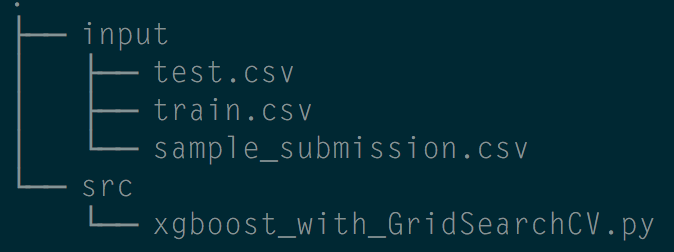

1、官网下载kaggle数据集Homesite Competition数据集,文件结构大致如下:

2、代码实战

#Parameter grid search with xgboost

#feature engineering is not so useful and the LB is so overfitted/underfitted

#so it is good to trust your CV #go xgboost, go mxnet, go DMLC! http://dmlc.ml #Credit to Shize's R code and the python re-implementation import pandas as pd

import numpy as np

import xgboost as xgb

from sklearn import preprocessing

from sklearn.cross_validation import train_test_split from sklearn.cross_validation import *

from sklearn.grid_search import GridSearchCV train = pd.read_csv("input/train.csv")[:1000]

test = pd.read_csv("input/test.csv")[:100] #去掉无意义的feature

train = train.drop('QuoteNumber', axis=1)

test = test.drop('QuoteNumber', axis=1) # Lets play with some dates

#转换feature到更有物理含义的格式

train['Date'] = pd.to_datetime(pd.Series(train['Original_Quote_Date']))

train = train.drop('Original_Quote_Date', axis=1) test['Date'] = pd.to_datetime(pd.Series(test['Original_Quote_Date']))

test = test.drop('Original_Quote_Date', axis=1) #如果我们将 datetime 转为年月日,则为物理含义更好的 feature:

train['Year'] = train['Date'].apply(lambda x: int(str(x)[:4]))

train['Month'] = train['Date'].apply(lambda x: int(str(x)[5:7]))

train['weekday'] = train['Date'].dt.dayofweek

#

test['Year'] = test['Date'].apply(lambda x: int(str(x)[:4]))

test['Month'] = test['Date'].apply(lambda x: int(str(x)[5:7]))

test['weekday'] = test['Date'].dt.dayofweek train = train.drop('Date', axis=1)

test = test.drop('Date', axis=1) #fill -999 to NAs

#这里先简单处理一下,把所有缺失值填上一个不太可能出现的取值:

train = train.fillna(-999)

test = test.fillna(-999) features = list(train.columns[1:]) #la colonne 0 est le quote_conversionflag

print(features) #对类别性质的feature做LabelEncode

#现实数据中很多特征并不是数值类型,而是类别类型,

#比如红色/蓝色/白色之类,虽然决策树天然擅长处理类别类型的特征,

#但是还是需要我们把原始的字符串值转为类别编号。

for f in train.columns:

if train[f].dtype=='object':

print(f)

lbl = preprocessing.LabelEncoder()

# lbl.fit(list(train[f].values))

lbl.fit(list(train[f].values) + list(test[f].values))

train[f] = lbl.transform(list(train[f].values))

test[f] = lbl.transform(list(test[f].values)) xgb_model = xgb.XGBClassifier() #brute force scan for all parameters, here are the tricks

#usually max_depth is 6,7,8

#learning rate is around 0.05, but small changes may make big diff

#tuning min_child_weight subsample colsample_bytree can have

#much fun of fighting against overfit

#n_estimators is how many round of boosting

#finally, ensemble xgboost with multiple seeds may reduce variance

parameters = {'nthread':[4], #when use hyperthread, xgboost may become slower

'objective':['binary:logistic'],

'learning_rate': [0.05], #so called `eta` value

'max_depth': [6],

'min_child_weight': [11],

'silent': [1],

'subsample': [0.8],

'colsample_bytree': [0.7],

'n_estimators': [5], #number of trees, change it to 1000 for better results

'missing':[-999],

'seed': [1337]} #使用 CV (cross validation) 做 xgb 分类器模型的调参

clf = GridSearchCV(xgb_model, parameters, n_jobs=5,

cv=StratifiedKFold(train['QuoteConversion_Flag'], n_folds=5, shuffle=True),

scoring='roc_auc',

verbose=2, refit=True) clf.fit(train[features], train["QuoteConversion_Flag"]) #trust your CV!

best_parameters, score, _ = max(clf.grid_scores_, key=lambda x: x[1])

print('Raw AUC score:', score)

for param_name in sorted(best_parameters.keys()):

print("%s: %r" % (param_name, best_parameters[param_name])) test_probs = clf.predict_proba(test[features])[:,1] sample = pd.read_csv('input/sample_submission.csv')

sample.QuoteConversion_Flag = test_probs

sample.to_csv("xgboost_best_parameter_submission.csv", index=False)

机器学习(十九)— xgboost初试kaggle的更多相关文章

- 剑指Offer(十九):顺时针打印矩阵

剑指Offer(十九):顺时针打印矩阵 搜索微信公众号:'AI-ming3526'或者'计算机视觉这件小事' 获取更多算法.机器学习干货 csdn:https://blog.csdn.net/baid ...

- 剑指Offer(二十九):最小的K个数

剑指Offer(二十九):最小的K个数 搜索微信公众号:'AI-ming3526'或者'计算机视觉这件小事' 获取更多算法.机器学习干货 csdn:https://blog.csdn.net/baid ...

- Alink漫谈(十九) :源码解析 之 分位点离散化Quantile

Alink漫谈(十九) :源码解析 之 分位点离散化Quantile 目录 Alink漫谈(十九) :源码解析 之 分位点离散化Quantile 0x00 摘要 0x01 背景概念 1.1 离散化 1 ...

- 无废话ExtJs 入门教程十九[API的使用]

无废话ExtJs 入门教程十九[API的使用] extjs技术交流,欢迎加群(201926085) 首先解释什么是 API 来自百度百科的官方解释:API(Application Programmin ...

- Python之路【第十九章】:Django进阶

Django路由规则 1.基于正则的URL 在templates目录下创建index.html.detail.html文件 <!DOCTYPE html> <html lang=&q ...

- Bootstrap <基础二十九>面板(Panels)

Bootstrap 面板(Panels).面板组件用于把 DOM 组件插入到一个盒子中.创建一个基本的面板,只需要向 <div> 元素添加 class .panel 和 class .pa ...

- Bootstrap <基础十九>分页

Bootstrap 支持的分页特性.分页(Pagination),是一种无序列表,Bootstrap 像处理其他界面元素一样处理分页. 分页(Pagination) 下表列出了 Bootstrap 提 ...

- Web 开发人员和设计师必读文章推荐【系列二十九】

<Web 前端开发精华文章推荐>2014年第8期(总第29期)和大家见面了.梦想天空博客关注 前端开发 技术,分享各类能够提升网站用户体验的优秀 jQuery 插件,展示前沿的 HTML5 ...

- Web 前端开发精华文章集锦(jQuery、HTML5、CSS3)【系列十九】

<Web 前端开发精华文章推荐>2013年第七期(总第十九期)和大家见面了.梦想天空博客关注 前端开发 技术,分享各种增强网站用户体验的 jQuery 插件,展示前沿的 HTML5 和 C ...

随机推荐

- bzoj4069【APIO2015】巴厘岛的雕塑

4069: [Apio2015]巴厘岛的雕塑 Time Limit: 10 Sec Memory Limit: 64 MB Submit: 192 Solved: 89 [Submit][Stat ...

- Log4J 基本使用

Log4j由三个重要的组件 构 成:日志 信息 的优先级,日志信息的输出目的地,日志信息的输出格式. 日志信息的优先级 从高到低有ERROR . WARN . INFO . DEBUG ,分别用来指定 ...

- 【PHP】富文本HTML过滤器:HTMLPurifier使用教程(防止XSS)

在编程开发时安全问题是及其重要的,对于用户提交的数据要进行过滤,XSS就是需要重视的一点,先说一下什么是XSS,简单来说就是用户提交数据(例如发 表评论,发表日志)时往Web页面里插入恶意javasc ...

- 使用虚拟环境 virtualenv

1.安装 $ sudo apt-get install python-virtualenv 2.重命名,一般虚拟环境会被命名为venv $ virtualenv venv 3. 激活 $ sour ...

- 开源项目之easyrtmp

https://github.com/bigbluebutton86/EasyRTMP/tree/master/src http://dl.linux-sunxi.org/SDK/A20/A20_SD ...

- Python读取文件数据

1题目要求: 文本文件有这些数据,需要的只有其中的5个属性,如下颜色标记 像以下的数据达到75万组: 1product/productId: B0000UIXZ4 2product/title: Ti ...

- eclipse 导入maven 父子项目

你先要确认svn上是否是maven项目,否则要自己重新建一个maven项目然后直接引入目录了.如果确认是maven项目,那么有个两个方案.案一:先用任何client软件将svn下载.然后在eclips ...

- unity中动态生成网格

以下是绘制正方形面片的一个例子,方便之后查阅: 效果如图所示: 红轴为x方向,蓝轴为z方向. 代码如下: using System.Collections; using System.Collecti ...

- Ant自己主动编译打包&公布 android项目

Eclipse用起来尽管方便,可是编译打包android项目还是比較慢,尤其将应用打包公布到各个渠道时,用Eclipse手动打包各种渠道包就有点不切实际了,这时候我们用到Ant帮我们自己主动编译打包了 ...

- ThoughtWorks(中国) 程序员读书雷达

ThoughtWorks(中国)程序员读书雷达 软件业的特点是变化.若要提高软件开发的技能,就必须跟上技术发展的步伐.埋首醉心于项目开发与实战,固然能够锤炼自己的开发技巧,却难免受限于经验与学识.世界 ...