HDFS 2.X新特性

1 集群间数据拷贝

1.scp实现两个远程主机之间的文件复制

scp -r hello.txt root@hadoop103:/user/atguigu/hello.txt // 推 push

scp -r root@hadoop103:/user/atguigu/hello.txt hello.txt // 拉 pull

scp -r root@hadoop103:/user/atguigu/hello.txt root@hadoop104:/user/atguigu //是通过本地主机中转实现两个远程主机的文件复制;如果在两个远程主机之间ssh没有配置的情况下可以使用该方式。

2.采用distcp命令实现两个Hadoop集群之间的递归数据复制

[atguigu@hadoop102 hadoop-2.7.]$ bin/hadoop distcp

hdfs://haoop102:9000/user/atguigu/hello.txt hdfs://hadoop103:9000/user/atguigu/hello.txt

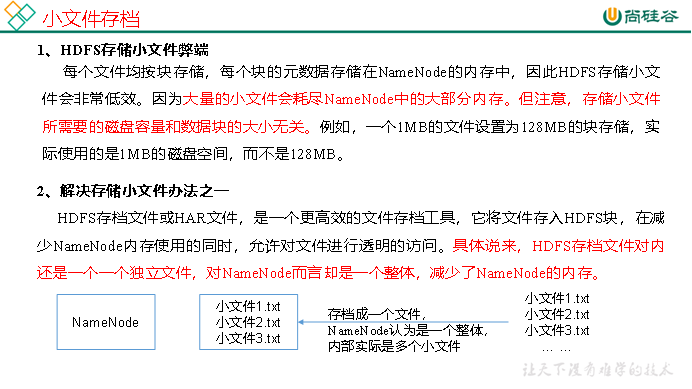

2 小文件存档

3.案例实操

(1)需要启动YARN进程

[atguigu@hadoop102 hadoop-2.7.]$ start-yarn.sh

(2)归档文件

把/user/atguigu/input目录里面的所有文件归档成一个叫input.har的归档文件,并把归档后文件存储到/user/atguigu/output路径下。

[atguigu@hadoop102 hadoop-2.7.]$ bin/hadoop archive -archiveName input.har –p /user/atguigu/input /user/atguigu/output

(3)查看归档

[atguigu@hadoop102 hadoop-2.7.]$ hadoop fs -lsr /user/atguigu/output/input.har [atguigu@hadoop102 hadoop-2.7.]$ hadoop fs -lsr har:///user/atguigu/output/input.har

(4)解归档文件

[atguigu@hadoop102 hadoop-2.7.]$ hadoop fs -cp har:/// user/atguigu/output/input.har/* /user/atguigu

7.3 回收站

开启回收站功能,可以将删除的文件在不超时的情况下,恢复原数据,起到防止误删除、备份等作用。

1.回收站参数设置及工作机制

2.启用回收站

修改core-site.xml,配置垃圾回收时间为1分钟。

<property>

<name>fs.trash.interval</name>

<value>1</value>

</property>

3.查看回收站

回收站在集群中的路径:/user/atguigu/.Trash/….

4.修改访问垃圾回收站用户名称

进入垃圾回收站用户名称,默认是dr.who,修改为atguigu用户

[core-site.xml]

<property>

<name>hadoop.http.staticuser.user</name>

<value>atguigu</value>

</property>

5. 通过程序删除的文件不会经过回收站,需要调用moveToTrash()才进入回收站

Trash trash = New Trash(conf);

trash.moveToTrash(path);

6.恢复回收站数据

[atguigu@hadoop102 hadoop-2.7.]$ hadoop fs -mv

/user/atguigu/.Trash/Current/user/atguigu/input /user/atguigu/input

7.清空回收站

[atguigu@hadoop102 hadoop-2.7.]$ hadoop fs -expunge

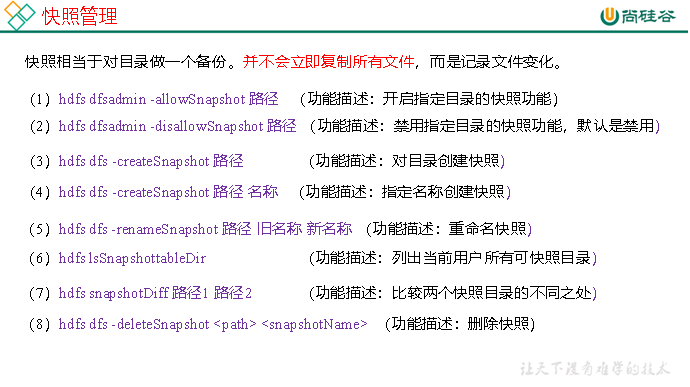

7.4 快照管理

2.案例实操

(1)开启/禁用指定目录的快照功能

[atguigu@hadoop102 hadoop-2.7.]$ hdfs dfsadmin -allowSnapshot /user/atguigu/input [atguigu@hadoop102 hadoop-2.7.]$ hdfs dfsadmin -disallowSnapshot /user/atguigu/input

(2)对目录创建快照

[atguigu@hadoop102 hadoop-2.7.]$ hdfs dfs -createSnapshot /user/atguigu/input

通过web访问hdfs://hadoop102:50070/user/atguigu/input/.snapshot/s…..// 快照和源文件使用相同数据

[atguigu@hadoop102 hadoop-2.7.]$ hdfs dfs -lsr /user/atguigu/input/.snapshot/

(3)指定名称创建快照

[atguigu@hadoop102 hadoop-2.7.]$ hdfs dfs -createSnapshot /user/atguigu/input miao170508

(4)重命名快照

[atguigu@hadoop102 hadoop-2.7.]$ hdfs dfs -renameSnapshot /user/atguigu/input/ miao170508 atguigu170508

(5)列出当前用户所有可快照目录

[atguigu@hadoop102 hadoop-2.7.]$ hdfs lsSnapshottableDir

(6)比较两个快照目录的不同之处

[atguigu@hadoop102 hadoop-2.7.]$ hdfs snapshotDiff

/user/atguigu/input/ . .snapshot/atguigu170508

(7)恢复快照

[atguigu@hadoop102 hadoop-2.7.]$ hdfs dfs -cp

/user/atguigu/input/.snapshot/s20170708-134303.027 /user

HDFS 2.X新特性的更多相关文章

- DataNode 详解及HDFS 2.X新特性

1. 工作机制 一个数据块在 DataNode 上以文件形式存储在磁盘上,包括两个文件,一个是数据本身,一个是元数据包括数据块的长度,块数据的校验和,以及时间戳. DataNode 启动后向 Name ...

- Hadoop 2.x HDFS新特性

Hadoop 2.x HDFS新特性 1.HDFS联邦 2. HDFS HA(要用到zookeeper等,留在后面再讲) 3.HDFS快照 回顾: HDFS两层模型 Namespa ...

- 详解Hadoop3.x新特性功能-HDFS纠删码

文章首发于微信公众号:五分钟学大数据 EC介绍 Erasure Coding 简称EC,中文名:纠删码 EC(纠删码)是一种编码技术,在HDFS之前,这种编码技术在廉价磁盘冗余阵列(RAID)中应用 ...

- Hadoop3.0新特性介绍,比Spark快10倍的Hadoop3.0新特性

Hadoop3.0新特性介绍,比Spark快10倍的Hadoop3.0新特性 Apache hadoop 项目组最新消息,hadoop3.x以后将会调整方案架构,将Mapreduce 基于内存+io+ ...

- Spark1.0.0新特性

Spark1.0.0 release于2014-05-30日正式公布,标志Spark正式进入1.X的时代.Spark1.0.0带来了各种新的特性,并提供了更好的API支持:Spark1 ...

- Spark1.2新特性概述

http://mp.weixin.qq.com/s?__biz=MjM5NTc2MTg3Mw==&mid=201641685&idx=1&sn=1b75be3d774bb3f2 ...

- Hadoop 3.x 新特性剖析系列1

1.概述 目前从Hadoop官网的Wiki来看,稳定版本已经发行到Hadoop2.9.0,最新版本为Hadoop3.1.0,查阅JIRA,社区已经着手迭代Hadoop3.2.0.那么,今天笔者就带着大 ...

- Hadoop 3.x 新特性剖析系列2

1.概述 接着上一篇博客的内容,继续介绍Hadoop3的其他新特性.其内容包含:优化Hadoop Shell脚本.重构Hadoop Client Jar包.支持等待Container.MapReduc ...

- Matlab 2018b 新特性

新特性简要介绍 一.实时编辑器 所创建的脚本不仅可以捕获代码,还可以讲述与人分享的故事.自动化的上下文提示可让您在编程时快速推进,并且将结果与可视化内容和您的代码一起显示. 二.App Designe ...

随机推荐

- Linux系统安装Samba共享服务器详解及安装配置

一.简介 Samba服务程序是一款基于SMB协议并由服务端和客户端组成的开源文件共享软件,实现了Linux和windows系统间的文件共享.SMB(Server Messages Block,信息服务 ...

- cmd 安装第三方库问题

pip install 包名 -i http://pypi.douban.com/simple/ --trusted-host pypi.douban.com 一定要指定 信任豆瓣源,不然就算换了源 ...

- Python元组运算符

Python元组运算符: len(元组名): 返回元组对象的长度 # len(元组名): # 返回元组对象的长度 tuple_1 = (1,4,5,2,3,6) print(len(tuple_1)) ...

- 记一次mysql关于limit和orderby的优化

针对于大数据量查询,我们一般使用分页查询,查询出对应页的数据即可,这会大大加快查询的效率: 在排序和分页同时进行时,我们一定要注意效率问题,例如: select a.* from table1 a i ...

- PHP stripslashes() 函数

实例 删除反斜杠: <?php高佣联盟 www.cgewang.comecho stripslashes("Who's Peter Griffin?");0.000.00.. ...

- Chrome IDM下载插件安装使用方法

一. 下载IDM (1)官方网站: http://www.internetdownloadmanager.com/download.html 二.安装IDM IDM安装 (1)运行安装程序 前进 ...

- P4274 [NOI2004]小H的小屋 dp 贪心

LINK:小H的小屋 尽管有论文 但是 其证明非常的不严谨 结尾甚至还是大胆猜测等字样... 先说贪心:容易发现m|n的时候此时均分两个地方就是最优的. 关于这个证明显然m在均分的时候的分点一定是n的 ...

- luogu P3403 跳楼机 同余最短路

LINK:跳楼机 很早之前就想学的一个东西.发现这个东西果然神奇. 我们要找到 所有的 w满足 \(w=1+ax+by+cz\).且 \(1\leq w\leq h\) 暴力枚举是不行的. 做法是这样 ...

- NCoreCoder.Aop 国庆更新

原本的IAopActors如下 public interface IAopActors { object Execute(AopContext context); Task<TResult> ...

- dos下mybatis自动生成代码

今天来介绍下怎么用mybatis-gennerator插件自动生成mybatis所需要的dao.bean.mapper xml文件,这样我们可以节省一部分精力,把精力放在业务逻辑上. 之前看过很多文章 ...