Spider--动态网页抓取--审查元素

# 静态网页在浏览器中展示的内容都在HTML的源码中,但主流网页使用 Javascript时,很多内容不出现在HTML的源代码中,我们需要使用动态网页抓取技术。

# Ajax: Asynchronous Javascript And XML,异步JvvaScript和 XML; 在不重新加载整个网页的情况下对网页的某部分进行更新,节省流量,速度快。

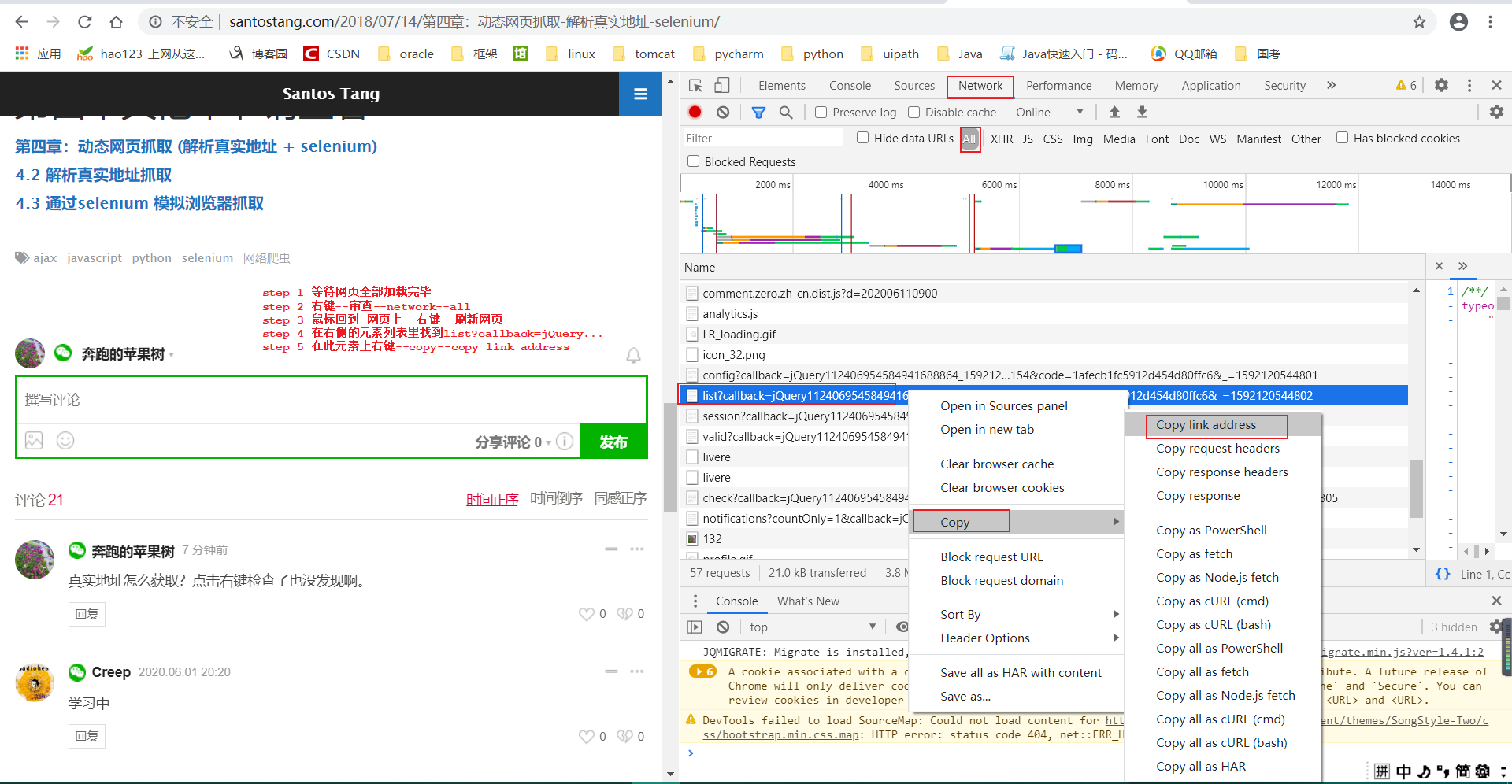

# 加大了 爬虫的难度。为解决这个问题,可以采用两种技术: 1)通过浏览器审查元素解析真实网页的地址。2)使用 Selenium模拟浏览器的方法。

# 1--通过浏览器审查元素解析真实网页的地址:

第一页和第二页最明显的区别在于 offset (虽然有其他地方也不一样,但不影响,只有 offset起决定作用),所以可以通过控制 offset来翻页。

请求头:

Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/70.0.3538.102 Safari/537.36 Edge/18.18362

# 根据上面信息,我们将代码设计为:

import requests

url = """https://api-zero.livere.com/v1/comments/list?callback=jQuery112406954584941688864_1592120544800&limit=10&repSeq=4547710&requestPath=%2Fv1%2Fcomments%2Flist&consumerSeq=1020&livereSeq=28583&smartloginSeq=5154&code=1afecb1fc5912d454d80ffc6&_=1592120544802"""

headers = {'User-Agent' : 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/70.0.3538.102 Safari/537.36 Edge/18.18362'}

r = requests.get(url, headers= headers)

print (r.text)

# 只获取第一页评论:

# 解析得到的字符串r.text(即 json字符串)可以使用json库来完成解析:

import json

import requests

url = """https://api-zero.livere.com/v1/comments/list?callback=jQuery112406954584941688864_1592120544800&limit=10&repSeq=4547710&requestPath=%2Fv1%2Fcomments%2Flist&consumerSeq=1020&livereSeq=28583&smartloginSeq=5154&code=1afecb1fc5912d454d80ffc6&_=1592120544802"""

headers = {'User-Agent' : 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/70.0.3538.102 Safari/537.36 Edge/18.18362'}

r = requests.get(url, headers= headers)

json_data_dict=json.loads(r.text[r.text.find('{'):-2]) # 将从左大括号开始至倒数第三个字符(即将字符串末尾的括号和分号去除掉)load反序列化成字典。

# json_data_dict是一个字典嵌套字典的数据结构(字典的value是字典)。

# 其中外部字典的results键对应一个字典,该字典的parents键对应一个值是列表(列表的元素又是字典)。

comments_list=json_data_dict['results']['parents']

for comment_dict in comments_list:

print(comment_dict['content'])

# 真实地址怎么获取?点击右键检查了也没发现啊。

# 学习中

# 一起学习

# 一句话,给我爬!!!!

# 为什么不多放几个回帖

# 哎,还要多少啊。

# 我不知道要多少帖子才能翻篇啊,你们没有买他的书吗

# 我要疯了。作者拜托你能不能改一下啊

# 一页到底能装多少回帖啊?

# 好累啊

# 获取两页评论:

import json

import requests

def get_comments(page_num):

global comments_list

headers = {'User-Agent' : 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/70.0.3538.102 Safari/537.36 Edge/18.18362'}

url='https://api-zero.livere.com/v1/comments/list?callback=jQuery1124042695935490813275_1592128347126&limit=10&offset='\

+page_num+\

'&repSeq=4547710&requestPath=%2Fv1%2Fcomments%2Flist&consumerSeq=1020&livereSeq=28583&smartloginSeq=5154&code=1afecb1fc5912d454d80ffc6&_=1592128347133'

r = requests.get(url, headers= headers)

json_data_dict=json.loads(r.text[r.text.find('{'):-2]) # 将从左大括号开始至倒数第三个字符(即将字符串末尾的 ');'括号和分号去除掉)load反序列化成字典。

# json_data_dict是一个字典嵌套字典的数据结构(字典的value是字典)。

# 其中外部字典的results键对应一个字典,该字典的parents键对应一个值是列表(列表的元素又是字典)。

comments_list.extend(json_data_dict['results']['parents']) # 列表

if __name__=='__main__':

comments_list=[]

for page_num in range(1,3):

get_comments(str(page_num))

for comment_dict in comments_list:

print(comment_dict['content'])

真实地址怎么获取?点击右键检查了也没发现啊。

# 学习中

# 一起学习

# 一句话,给我爬!!!!

# 为什么不多放几个回帖

# 哎,还要多少啊。

# 我不知道要多少帖子才能翻篇啊,你们没有买他的书吗

# 我要疯了。作者拜托你能不能改一下啊

# 一页到底能装多少回帖啊?

# 好累啊

# 还不够哦

# 如果这样违反了你的规定,请原谅,我也是没有办法,只能帮你把水灌上

# 不然好多代码我没有办法去按照你书上的内容操作。很郁闷

# 主人可能忘记爬虫的跟帖必须要翻过两页才能测试啊

# 是不是要10页才翻篇

# 我要追加多少评论才够两页呢

# 为什么我能看到评论呢??

# 学习

# 不是

# 我是第一个来的吗?

# 回顾:

# 1)--代码在 IDE里的换行:

a='aaaaaaaaaaaaaaaaaaaaabbbbbbccc\

ggggg'

print(a) # aaaaaaaaaaaaaaaaaaaaabbbbbbcccggggg

b='aaaaaaaaaaaaaaaaaaaaabbbbbbccc'\

+\

'ggggg'

print(b) # aaaaaaaaaaaaaaaaaaaaabbbbbbcccggggg

# 2)--在输出里换行,换行符是字符串本身的一部分:

c='aaaaaaaaaaaaaaaaaaaaabbbbbbccc\nggggg'

print(c)

# aaaaaaaaaaaaaaaaaaaaabbbbbbccc

# ggggg

i=True

if\

i==True:

print('haha')

Spider--动态网页抓取--审查元素的更多相关文章

- python网络爬虫-动态网页抓取(五)

动态抓取的实例 在开始爬虫之前,我们需要了解一下Ajax(异步请求).它的价值在于在与后台进行少量的数据交换就可以使网页实现异步更新. 如果使用Ajax加载的动态网页抓取,有两种方法: 通过浏览器审查 ...

- Python开发爬虫之动态网页抓取篇:爬取博客评论数据——通过Selenium模拟浏览器抓取

区别于上篇动态网页抓取,这里介绍另一种方法,即使用浏览器渲染引擎.直接用浏览器在显示网页时解析 HTML.应用 CSS 样式并执行 JavaScript 的语句. 这个方法在爬虫过程中会打开一个浏览器 ...

- 面向初学者的Python爬虫程序教程之动态网页抓取

目的是对所有注释进行爬网. 下面列出了已爬网链接.如果您使用AJAX加载动态网页,则有两种方式对其进行爬网. 分别介绍了两种方法:(如果对代码有任何疑问,请提出改进建议)解析真实地址爬网示例是参考链接 ...

- java+phantomjs实现动态网页抓取

1.下载地址:http://phantomjs.org/download.html 2.java代码 public void getHtml(String url) { HTML="&quo ...

- Spider_基础总结5--动态网页抓取--元素审查--json--字典

# 静态网页在浏览器中展示的内容都在HTML的源码中,但主流网页使用 Javascript时,很多内容不出现在HTML的源代码中,此时仍然使用 # requests+beautifulsoup是不能够 ...

- 动态网页爬取例子(WebCollector+selenium+phantomjs)

目标:动态网页爬取 说明:这里的动态网页指几种可能:1)需要用户交互,如常见的登录操作:2)网页通过JS / AJAX动态生成,如一个html里有<div id="test" ...

- Python爬虫之三种网页抓取方法性能比较

下面我们将介绍三种抓取网页数据的方法,首先是正则表达式,然后是流行的 BeautifulSoup 模块,最后是强大的 lxml 模块. 1. 正则表达式 如果你对正则表达式还不熟悉,或是需要一些提 ...

- 网页抓取小工具(IE法)

网页抓取小工具(IE法)—— 吴姐 http://club.excelhome.net/thread-1095707-1-1.html 用IE提取网页资料的好处在于:所见即所得,网页上能看到的信息一般 ...

- find_elements后点击不了抓取的元素

1.莫名其妙抓不到元素,要去看句柄,是不是没有切换 h=driver.current_window_handle nh=driver.window_handles for i in nh: if i! ...

随机推荐

- vue超出8个字符,显示省略号

显示的数据

- 你想了解的《javaScript语言精粹》(三)

# javaScript语言精粹 # 第三章 对象 - javaScript 数据类型 1. 基础数据类型 Number String Boolean Undefined N ...

- 多测师讲解unittest介绍及自动化测试实现流程_高级讲师肖sir

unittest框架介绍 unittest框架是python中一个标准的库中的一个模块,该模块包括许多的类如 test case类.test suit类.texttest runner类.textte ...

- Git hub加载慢?下载慢?浏览慢?几个小技巧让你一键起飞!

记得,那是一个风和日丽,艳阳高照的夜晚,只因为当初的一次回眸,于是便决然走向了程序员的道路,从此,CV大法心中记,代码伴我身. 这一天,正当我打开电脑准备开开心心的使用CV大法完成任务的时候,却恼人的 ...

- Pythonic【15个代码示例】

Python由于语言的简洁性,让我们以人类思考的方式来写代码,新手更容易上手,老鸟更爱不释手. 要写出 Pythonic(优雅的.地道的.整洁的)代码,还要平时多观察那些大牛代码,Github 上有很 ...

- File、Blob、ArrayBuffer等文件类的对象有什么区别和联系

前言 在前端中处理文件时会经常遇到File.Blob.ArrayBuffer以及相关的处理方法或方式如FileReader.FormData等等这些名词,对于这些常见而又不常见的名词,我相信大多数人对 ...

- docker-阿里云加速

系统版本 centos7 阿里云登录 ->容器镜像服务->镜像加速器 复制下面的直接执行即可 sudo mkdir -p /etc/docker sudo tee /etc/doc ...

- selenium 设置代理ip

from selenium import webdriver options = webdriver.ChromeOptions() options.add_argument("--prox ...

- buuctf-misc-刷新过的图片

知识点:F5隐写 kali中安装F5-steganography 工具 git clone https://github.com/matthewgao/F5-steganography 解密的时候输入 ...

- sqlserver安装失败,此计算机上安装了 Microsoft Visual Studio 2008 的早期版本解决方法

安装sql server 2008 management,提示错误:此计算机上安装了 Microsoft Visual Studio 2008 的早期版本.请在安装 SQL Server 2008 前 ...