MongoDB高可用模式部署

首先准备机器,我这里是在公司云平台创建了三台DB server,ip分别是10.199.144.84,10.199.144.89,10.199.144.90。

分别安装mongodb最新稳定版本:

wget https://fastdl.mongodb.org/linux/mongodb-linux-x86_64-2.4.12.tgz

tar -xzvf mongodb-linux-x86_64-2.4.12.tgz

mv mongodb-linux-x86_64-2.4.12 /usr/lib

做个软连接或者按照官方的做法把mongo shell都添加到环境变量:

ln -s /usr/lib/mongodb-linux-x86_64-2.4.12/bin/mongo /usr/bin/mongo

ln -s /usr/lib/mongodb-linux-x86_64-2.4.12/bin/mongos /usr/bin/mongos

ln -s /usr/lib/mongodb-linux-x86_64-2.4.12/bin/mongod /usr/bin/mongod

分别创建存储数据的目录:

mkdir -p /data/mongodb && cd /data/mongodb/ && mkdir -p conf/data conf/log mongos/log shard{1..3}/data shard{1..3}/log

分别配置启动config服务器:

mongod --configsvr --dbpath /data/mongodb/conf/data --port 27100 --logpath /data/mongodb/conf/confdb.log --fork --directoryperdb

确保config服务都启动之后,启动路由服务器(mongos):

mongos --configdb 10.199.144.84:27100,10.199.144.89:27100,10.199.144.90:27100 --port 27000 --logpath /data/mongodb/mongos/mongos.log --fork

分别配置启动各个分片副本集,这里副本集名分别叫shard1,shard2,shard3:

mongod --shardsvr --replSet shard1 --port 27001 --dbpath /data/mongodb/shard1/data --logpath /data/mongodb/shard1/log/shard1.log --directoryperdb --fork mongod --shardsvr --replSet shard2 --port 27002 --dbpath /data/mongodb/shard2/data --logpath /data/mongodb/shard2/log/shard2.log --directoryperdb --fork mongod --shardsvr --replSet shard3 --port 27003 --dbpath /data/mongodb/shard3/data --logpath /data/mongodb/shard3/log/shard3.log --directoryperdb --fork

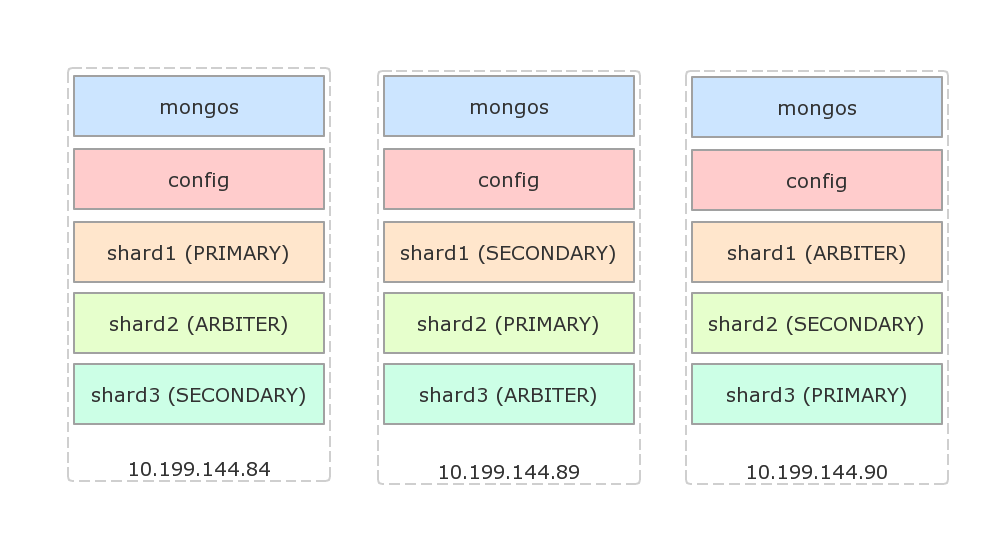

接下来配置副本集,假设使用如下的架构,每台物理机都有一个主节点,一个副本节点和一个仲裁节点:

配置shard1(登陆84,没有显式指定主节点时,会选择登陆的机器为主节点):

mongo --port 27001

use admin

rs.initiate({

_id: 'shard1',

members: [

{_id: 84, host: '10.199.144.84:27001'},

{_id: 89, host: '10.199.144.89:27001'},

{_id: 90, host: '10.199.144.90:27001', arbiterOnly: true}

]

});

配置shard2(登陆89):

mongo --port 27001

use admin

rs.initiate({

_id: 'shard2',

members: [

{_id: 84, host: '10.199.144.84:27002', arbiterOnly: true},

{_id: 89, host: '10.199.144.89:27002'},

{_id: 90, host: '10.199.144.90:27002'}

]

});

配置shard3(登陆90):

mongo --port 27001

use admin

rs.initiate({

_id: 'shard3',

members: [

{_id: 84, host: '10.199.144.84:27002'},

{_id: 89, host: '10.199.144.89:27002', arbiterOnly: true},

{_id: 90, host: '10.199.144.90:27002'}

]

});

下面设置路由到分片集群配置,随便登陆一台机器,假设是84:

mongo --port 27000

use admin

db.runCommand({addShard: 'shard1/10.199.144.84:27001,10.199.144.89:27001,10.199.144.90:27001'});

db.runCommand({addShard: 'shard2/10.199.144.84:27002,10.199.144.89:27002,10.199.144.90:27002'});

db.runCommand({addShard: 'shard3/10.199.144.84:27003,10.199.144.89:27003,10.199.144.90:27003'});

查看配置好的shard:

mongo --port 27000

use admin

db.runCommand({listshards: 1});

结果:

{

"shards" : [

{

"_id" : "shard1",

"host" : "shard1/10.199.144.84:27001,10.199.144.89:27001"

},

{

"_id" : "shard2",

"host" : "shard2/10.199.144.89:27002,10.199.144.90:27002"

},

{

"_id" : "shard3",

"host" : "shard3/10.199.144.90:27003,10.199.144.84:27003"

}

],

"ok" : 1

}

其中仲裁(ARBITER)节点没有列出来。

下面测试分片:

mongo --port 27000

use admin

db.runCommand({enablesharding: 'dbtest'});

db.runCommand({shardcollection: 'dbtest.coll1', key: {id: 1}});

use dbtest;

for(var i=0; i<10000; i++) db.coll1.insert({id: i, s: 'str_' + i});

如果dbtest已经存在,需要确保它已经以id建立了索引!

过上一段时间之后,运行db.coll1.stats()显式分片状态:

{

"sharded" : true,

"ns" : "dbtest.coll1",

"count" : 10000,

...

"shards" : {

"shard1" : {

"ns" : "dbtest.coll1",

"count" : 0,

"size" : 0,

...

},

"shard2" : {

"ns" : "dbtest.coll1",

"count" : 10000,

"size" : 559200,

...

}

}

...

}

可以看到,这里分片已经生效,只是分配不均匀,所有的数据都存在了shard2中了。分片key的选择策略可以参考官方文档。在2.4版本中,使用hashed shard key算法保证文档均匀分布:

mongo --port 27000

use admin

sh.shardCollection('dbtest.coll1', {id: 'hashed'});

使用hashed算法之后,做同样的测试,插入的数据基本均匀分布:

{

"sharded" : true,

"ns" : "dbtest.coll1",

"count" : 10000,

...

"shards" : {

"shard1" : {

"ns" : "dbtest.coll1",

"count" : 3285,

"size" : 183672,

...

},

"shard2" : {

"ns" : "dbtest.coll1",

"count" : 3349,

"size" : 187360,

...

},

"shard3" : {

"ns" : "dbtest.coll1",

"count" : 3366,

"size" : 188168,

...

}

}

}

更多资料,请参考MongoDB Sharding。

在应用程序里,使用MongoClient创建db连接:

MongoClient.connect('mongodb://10.199.144.84:27000,10.199.144.89:27000,10.199.144.90:27000/dbtest?w=1', function(err, db) {

;

});

MongoDB高可用模式部署的更多相关文章

- hadoop和hbase高可用模式部署

记录apache版本的hadoop和hbase的安装,并启用高可用模式. 1. 主机环境 我这里使用的操作系统是centos 6.5,安装在vmware上,共三台. 主机名 IP 操作系统 用户名 安 ...

- CentOS6下OpenLDAP+PhpLdapAdmin基本安装及主从/主主高可用模式部署记录

下面测试的部署机ip地址为:192.168.10.2051)yum安装OpenLDAP [root@openldap-server ~]# yum install openldap openldap- ...

- Haproxy+Keepalived高可用环境部署梳理(主主和主从模式)

Nginx.LVS.HAProxy 是目前使用最广泛的三种负载均衡软件,本人都在多个项目中实施过,通常会结合Keepalive做健康检查,实现故障转移的高可用功能. 1)在四层(tcp)实现负载均衡的 ...

- LVS+Keepalived 高可用环境部署记录(主主和主从模式)

之前的文章介绍了LVS负载均衡-基础知识梳理, 下面记录下LVS+Keepalived高可用环境部署梳理(主主和主从模式)的操作流程: 一.LVS+Keepalived主从热备的高可用环境部署 1)环 ...

- openstack pike 集群高可用 安装 部署 目录汇总

# openstack pike 集群高可用 安装部署#安装环境 centos 7 史上最详细的openstack pike版 部署文档欢迎经验分享,欢迎笔记分享欢迎留言,或加QQ群663105353 ...

- MongoDB 高可用集群副本集+分片搭建

MongoDB 高可用集群搭建 一.架构概况 192.168.150.129192.168.150.130192.168.150.131 参考文档:https://www.cnblogs.com/va ...

- MogoDB(6)--mongoDB高可用和4.0特性

5.1.MongoDB 用户管理 1.用户管理1.1.添加用户为 testdb 添加 tom 用户 use testdb db.createUser({user:"tom",pwd ...

- MongoDB 高可用集群架构简介

在大数据的时代,传统的关系型数据库要能更高的服务必须要解决高并发读写.海量数据高效存储.高可扩展性和高可用性这些难题.不过就是因为这些问题Nosql诞生了. 转载自严澜的博文——<如何搭建高效的 ...

- gitlab高可用模式

高可用模式 企业版 社区版 我们这里说一下成本比较低的主备模式,它主要依赖的是DRBD方式进行数据同步,需要2台ALL IN ONE的GitLab服务器,也就是通过上面安装方式把所有组件都安装在一起的 ...

随机推荐

- poj_2674 弹性碰撞

题目大意 给定一条直线,长度为L 表示区间[0, L].在直线上开始放置N个人,每个人有一个初始位置pos(用到直线上端点0的距离表示)和初始方向dir('p' 或 'P' 表示向端点L行走, 'n' ...

- Deeplink做不出效果,那是你不会玩!

最近魔Sir听一些有些同学说之前用过Deeplink,但效果并没有想象中的那么好,在了解了小伙伴的使用场景后,魔Sir觉得有必要出这么篇东西告诉大家,Deeplink效果差,那是因为你不会玩! 对于已 ...

- Linux 底下使用C 对文件进行遍历

#include <stdio.h>#include <stdlib.h>main (int argc,char *argv[]){char ch;FILE *fp;int i ...

- MySQL auto-extending data file

http://blog.csdn.net/hw_libo/article/details/39215723 http://blog.sina.com.cn/s/blog_5037eacb0102vjm ...

- php变量的几种写法

一.最简单的 $str = 'Hello World!'; 二.来个变种 $str = 'good'; $good = 'test'; $test = 'Hello World!'; echo $$$ ...

- 无需u盘和光盘安装linux

今天折腾linux引导的时候发现一个不用任何移动介质的linux安装方法,即直接在硬盘中启动安装系统. 1.首先下载一个easyBCD.进入“添加新条目”选项选择“NeoGrub”条目,然后选择“添加 ...

- [杂]SQL Server 之命名管道连接

命名管道是通过进程间通信(IPC)机制实现通信.具体来说,命名管道建立在服务器的IPC$共享基础上,通过IPC$共享来进行通信. SQL Server命名管道 SQL Server 首先在服务器上创建 ...

- 基于superagent 与 cheerio 的node简单爬虫

最近重新玩起了node,便总结下基本的东西,在本文中通过node的superagent与cheerio来抓取分析网页的数据. 目的 superagent 抓取网页 cheerio 分析网页 准备 N ...

- 谈敏捷,谈开发 --《Agile Software Development》读后感

谈敏捷,谈开发 --<Agile Software Development>读后感 北航计算机学院 110616班 11061171 毛宇 联系方式:maoyu815930@sina.co ...

- JAVA反射机制(转)

JAVA反射机制是在运行状态中,对于任意一个类,都能够知道这个类的所有属性和方法: 对于任意一个对象,都能够调用它的任意一个方法和属性: 这种动态获取的信息以及动态调用对象的方法的功能称为java语言 ...