使用TensorFlow实现MNIST数据集分类

1 MNIST数据集

MNIST数据集由70000张28x28像素的黑白图片组成,每一张图片都写有0~9中的一个数字,每个像素点的灰度值在0 ~ 255(0是黑色,255是白色)之间。

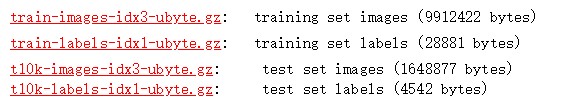

MINST数据集是由Yann LeCun教授提供的手写数字数据库文件,其官方下载地址THE MNIST DATABASE of handwritten digits

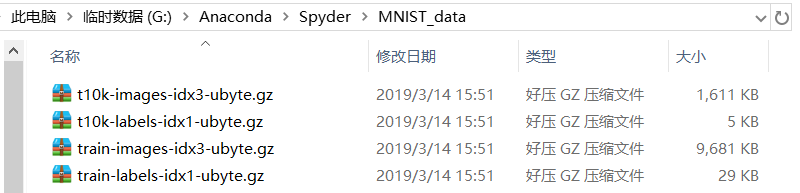

下载好MNIST数据集后,将其放在Spyder工作目录下(若使用Jupyter编程,则放在Jupyter工作目录下),如图:

G:\Anaconda\Spyder为笔者Spyder工作目录,MNIST_data为新建文件夹,读者也可以自行命名。

2 实验

为方便设计神经网络输入层,将每张28x28像素图片的像素值按行排成一行,故输入层设计28x28=784个神经元,隐藏层设计600个神经元,输出层设计10个神经元。使用read_data_sets()函数载入数据集,并返回一个类,这个类将MNIST数据集划分为train、validation、test 3个数据集,对应图片数分别为55000、5000、10000。本文采用交叉熵损失函数,并且为防止过拟合问题产生,引入正则化方法。

mnist.py

import tensorflow as tf

from tensorflow.examples.tutorials.mnist import input_data

#载入数据集

mnist=input_data.read_data_sets("MNIST_data",one_hot=True)

#每批次的大小

batch_size=100

#总批次数

batch_num=mnist.train.num_examples//batch_size

#训练轮数

training_step = tf.Variable(0,trainable=False)

#定义两个placeholder

x=tf.placeholder(tf.float32, [None,784])

y=tf.placeholder(tf.float32, [None,10])

#神经网络layer_1

w1=tf.Variable(tf.random_normal([784,600]))

b1=tf.Variable(tf.constant(0.1,shape=[600]))

z1=tf.matmul(x,w1)+b1

a1=tf.nn.tanh(z1)

#神经网络layer_2

w2=tf.Variable(tf.random_normal([600,10]))

b2=tf.Variable(tf.constant(0.1,shape=[10]))

z2=tf.matmul(a1,w2)+b2

#交叉熵代价函数

cross_entropy=tf.nn.sparse_softmax_cross_entropy_with_logits(labels=tf.argmax(y,1),logits=z2)

#cross_entropy=tf.nn.softmax_cross_entropy_with_logits_v2(labels=y,logits=z2)

#L2正则化函数

regularizer=tf.contrib.layers.l2_regularizer(0.0001)

#总损失

loss=tf.reduce_mean(cross_entropy)+regularizer(w1)+regularizer(w2)

#学习率(指数衰减法)

laerning_rate = tf.train.exponential_decay(0.8,training_step,batch_num,0.999)

#梯度下降法优化器

train=tf.train.GradientDescentOptimizer(laerning_rate).minimize(loss,global_step=training_step)

#预测精度

correct_prediction=tf.equal(tf.argmax(y,1),tf.argmax(z2,1))

accuracy=tf.reduce_mean(tf.cast(correct_prediction, tf.float32))

#初始化变量

init=tf.global_variables_initializer()

with tf.Session() as sess:

sess.run(init)

test_feed={x:mnist.test.images,y:mnist.test.labels}

for epoch in range(51):

for batch in range(batch_num):

x_,y_=mnist.train.next_batch(batch_size)

sess.run(train,feed_dict={x:x_,y:y_})

acc=sess.run(accuracy,feed_dict=test_feed)

if epoch%10==0:

print("epoch:",epoch,"accuracy:",acc)

迭代50次后,精度达到97.68%。

声明:本文转自使用TensorFlow实现MNIST数据集分类

使用TensorFlow实现MNIST数据集分类的更多相关文章

- 机器学习与Tensorflow(3)—— 机器学习及MNIST数据集分类优化

一.二次代价函数 1. 形式: 其中,C为代价函数,X表示样本,Y表示实际值,a表示输出值,n为样本总数 2. 利用梯度下降法调整权值参数大小,推导过程如下图所示: 根据结果可得,权重w和偏置b的梯度 ...

- 3.keras-简单实现Mnist数据集分类

keras-简单实现Mnist数据集分类 1.载入数据以及预处理 import numpy as np from keras.datasets import mnist from keras.util ...

- 6.keras-基于CNN网络的Mnist数据集分类

keras-基于CNN网络的Mnist数据集分类 1.数据的载入和预处理 import numpy as np from keras.datasets import mnist from keras. ...

- 一个简单的TensorFlow可视化MNIST数据集识别程序

下面是TensorFlow可视化MNIST数据集识别程序,可视化内容是,TensorFlow计算图,表(loss, 直方图, 标准差(stddev)) # -*- coding: utf-8 -*- ...

- 深度学习原理与框架-Tensorflow基本操作-mnist数据集的逻辑回归 1.tf.matmul(点乘操作) 2.tf.equal(对应位置是否相等) 3.tf.cast(将布尔类型转换为数值类型) 4.tf.argmax(返回最大值的索引) 5.tf.nn.softmax(计算softmax概率值) 6.tf.train.GradientDescentOptimizer(损失值梯度下降器)

1. tf.matmul(X, w) # 进行点乘操作 参数说明:X,w都表示输入的数据, 2.tf.equal(x, y) # 比较两个数据对应位置的数是否相等,返回值为True,或者False 参 ...

- TensorFlow 训练MNIST数据集(2)—— 多层神经网络

在我的上一篇随笔中,采用了单层神经网络来对MNIST进行训练,在测试集中只有约90%的正确率.这次换一种神经网络(多层神经网络)来进行训练和测试. 1.获取MNIST数据 MNIST数据集只要一行代码 ...

- 《Hands-On Machine Learning with Scikit-Learn&TensorFlow》mnist数据集错误及解决方案

最近在看这本书看到Chapter 3.Classification,是关于mnist数据集的分类,里面有个代码是 from sklearn.datasets import fetch_mldata m ...

- TensorFlow训练MNIST数据集(1) —— softmax 单层神经网络

1.MNIST数据集简介 首先通过下面两行代码获取到TensorFlow内置的MNIST数据集: from tensorflow.examples.tutorials.mnist import inp ...

- 基于 tensorflow 的 mnist 数据集预测

1. tensorflow 基本使用方法 2. mnist 数据集简介与预处理 3. 聚类算法模型 4. 使用卷积神经网络进行特征生成 5. 训练网络模型生成结果 how to install ten ...

- TensorFlow 下 mnist 数据集的操作及可视化

from tensorflow.examples.tutorials.mnist import input_data 首先需要连网下载数据集: mnsit = input_data.read_data ...

随机推荐

- [转帖]Oracle Exadata X10M 数据库一体机发布,树立 OLTP 数据库性能新标杆

https://www.modb.pro/db/653936 2023年6月25日消息,Oracle 公司继续以其专用的 Exadata 平台重新定义 OLTP 数据库性能.上周,该公司延续了这一传统 ...

- [转帖]什么是ClickHouse?

什么是ClickHouse? ClickHouse是一个用于联机分析(OLAP)的列式数据库管理系统(DBMS). 在传统的行式数据库系统中,数据按如下顺序存储: Row WatchID JavaEn ...

- 【转帖】nginx变量使用方法详解-5

https://www.diewufeiyang.com/post/579.html 前面在 (二) 中我们已经了解到变量值容器的生命期是与请求绑定的,但是我当时有意避开了"请求" ...

- [转帖]Windows版本vcenter server6.0的SSO密码重置

Windows版本的SSO重置与vCenter Server Appliance的重置类似 登录vcenter服务器,打开DOS窗口,输入 cd c:\Program Files\VMware\vCe ...

- [转帖]巧用 Docker Buildx 构建多种系统架构镜像

http://www.taodudu.cc/news/show-4511396.html?action=onClick Docker Buildx 是一个 Docker CLI 插件,其扩展了 Doc ...

- [转帖]Linux下AWK、SED、GREP、FIND命令详解

https://www.jianshu.com/p/d54e0359db01 AWK AWK是一个优良的文本处理工具,Linux和Unix环境中现有的功能最强大的数据处理引擎之一. 语法 awk [选 ...

- 在vscode中运行bat文件(执行bat)并解决中文乱码问题

使用vscode编写bat脚本让工作流得到了极大的改善 以前:在文本编辑器中写完,保存,回到资源管理器双击bat运行,再循环重复 现在:在vscode中编写bat,按下快捷键执行bat 在vscode ...

- TienChin-系统功能介绍

线索管理 添加线索 查看线索 删除线索 修改线索 分配线索: 将录入到系统的线索,分配给某一个市场专员去处理 跟进线索: 持续跟进一条线索 1.判断是否伪线索 2.持续跟进,每次跟进需要有记录 3 ...

- 小白学k8s(10)-k8s中ConfigMap理解

理解ConfigMap 什么是ConfigMap ConfigMap的创建 使用key-value 字符串创建 从env文件创建 从目录创建 通过Yaml/Json创建 ConfigMap使用 用作环 ...

- centos7下安装postgresql-10.3

centos7下安装pgsql10.3 前言 下载pgsql-10.3 安装 解压 安装基本的工具 编译 安装 创建目录 data.log 加入系统环境变量 增加用户 postgres 并赋权 初始化 ...