Keras 自定义层

1.对于简单的定制操作,可以通过使用layers.core.Lambda层来完成。该方法的适用情况:仅对流经该层的数据做个变换,而这个变换本身没有需要学习的参数.

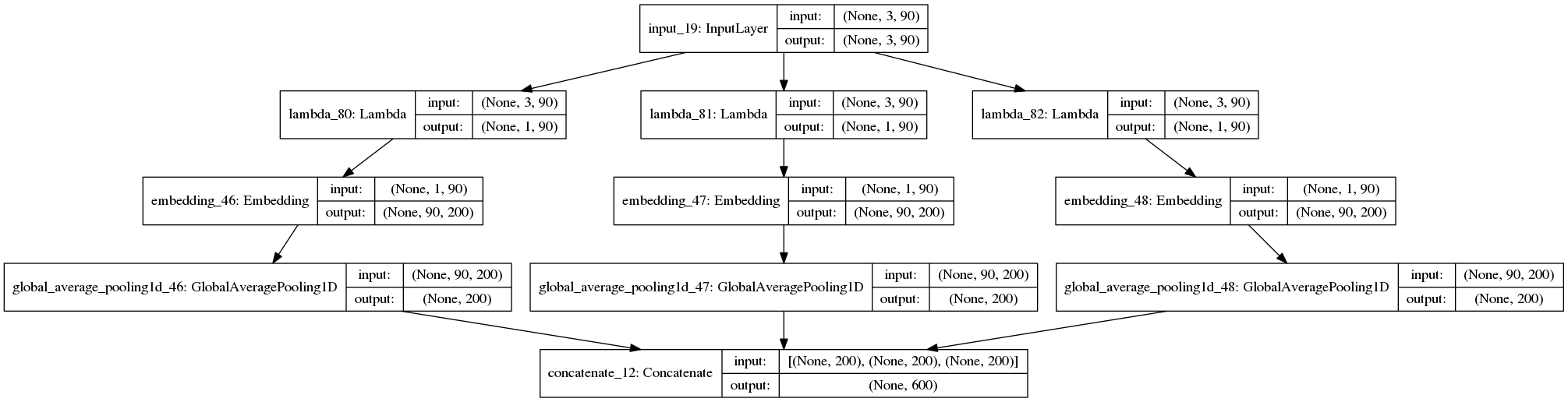

# 切片后再分别进行embedding和average pooling

import numpy as np

from keras.models import Sequential

from keras.layers import Dense, Activation,Reshape

from keras.layers import merge

from keras.utils import plot_model

from keras.layers import *

from keras.models import Model def get_slice(x, index):

return x[:, index] keep_num = 3

field_lens = 90

input_field = Input(shape=(keep_num, field_lens))

avg_pools = []

for n in range(keep_num):

block = Lambda(get_slice,output_shape=(1,field_lens),arguments={'index':n})(input_field)

x_emb = Embedding(input_dim=100, output_dim=200, input_length=field_lens)(block)

x_avg = GlobalAveragePooling1D()(x_emb)

avg_pools.append(x_avg)

output = concatenate([p for p in avg_pools])

model = Model(input_field, output)

plot_model(model, to_file='model/lambda.png',show_shapes=True) plt.figure(figsize=(21, 12))

im = plt.imread('model/lambda.png')

plt.imshow(im)

这里用Lambda定义了一个对张量进行切片操作的层

2.对于具有可训练权重的定制层,需要自己来实现。

from keras import backend as K

from keras.engine.topology import Layer

import numpy as np class MyLayer(Layer): def __init__(self, output_dim, **kwargs):

self.output_dim = output_dim

super(MyLayer, self).__init__(**kwargs) def build(self, input_shape):

# Create a trainable weight variable for this layer.

self.kernel = self.add_weight(name='kernel',

shape=(input_shape[1], self.output_dim),

initializer='uniform',

trainable=True)

super(MyLayer, self).build(input_shape) # Be sure to call this somewhere! def call(self, x):

return K.dot(x, self.kernel) def compute_output_shape(self, input_shape):

return (input_shape[0], self.output_dim)

参考:

Writing your own Keras layers Keras官方文档,中文文档

keras Lambda自定义层实现数据的切片,Lambda传参数

Keras 自定义层的更多相关文章

- Keras处理已保存模型中的自定义层(或其他自定义对象)

如果要加载的模型包含自定义层或其他自定义类或函数,则可以通过 custom_objects 参数将它们传递给加载机制: from keras.models import load_model # 假设 ...

- 『开发技巧』Keras自定义对象(层、评价函数与损失)

1.自定义层 对于简单.无状态的自定义操作,你也许可以通过 layers.core.Lambda 层来实现.但是对于那些包含了可训练权重的自定义层,你应该自己实现这种层. 这是一个 Keras2.0 ...

- keras Lambda 层

Lambda层 keras.layers.core.Lambda(function, output_shape=None, mask=None, arguments=None) 本函数用以对上一层的输 ...

- keras自定义网络层

在深度学习领域,Keras是一个高度封装的库并被广泛应用,可以通过调用其内置网络模块(各种网络层)实现针对性的模型结构:当所需要的网络层功能不被包含时,则需要通过自定义网络层或模型实现. 如何在ker ...

- MXNET:深度学习计算-自定义层

虽然 Gluon 提供了大量常用的层,但有时候我们依然希望自定义层.本节将介绍如何使用 NDArray 来自定义一个 Gluon 的层,从而以后可以被重复调用. 不含模型参数的自定义层 我们先介绍如何 ...

- 『MXNet』第四弹_Gluon自定义层

一.不含参数层 通过继承Block自定义了一个将输入减掉均值的层:CenteredLayer类,并将层的计算放在forward函数里, from mxnet import nd, gluon from ...

- Keras网络层之“关于Keras的层(Layer)”

关于Keras的“层”(Layer) 所有的Keras层对象都有如下方法: layer.get_weights():返回层的权重(numpy array) layer.set_weights(weig ...

- 从头学pytorch(十一):自定义层

自定义layer https://www.cnblogs.com/sdu20112013/p/12132786.html一文里说了怎么写自定义的模型.本篇说怎么自定义层. 分两种: 不含模型参数的la ...

- keras中保存自定义层和loss

在keras中保存模型有几种方式: (1):使用callbacks,可以保存训练中任意的模型,或选择最好的模型 logdir = './callbacks' if not os.path.exists ...

随机推荐

- word里怎么删除某一列

光标定位在第二列第一个字的前面,然后按住Alt键,拖动鼠标,选中第二列字,松开Alt键,点击Delete键即可

- SaltStack应用grains和jinja模板-第四篇

目标需求 1.使用jinja模板让apache配置监听本地ip地址 2.了解grains的基本使用方法 说明:实验环境是在前面的第二篇和第三篇基础上完成 实现步骤 使用grains获取ip地址信息 使 ...

- Linux禁止普通用户使用crontab命令

cron计划任务默认root用户与非root用户都可以执行,当然如果在安全方面想禁用这部分用户,则可以通过两个文件来解决: cron.allow cron.deny cron.allow:定义允许使用 ...

- Idea 切换git账号

重置一下账号设置,再次执行拉取或推送会提示重新输入账号密码 进入项目根目录执行:git config --system --unset credential.helper

- validateJarFile jar not loaded. See Servlet Spec 2.3, section 9.7.2. Offending class: javax/servlet/Servlet.class

项目环境 Maven.Tomcat7.0.27.jdk1.8.0_111 报这个错误的原因是项目中依赖 javax.servlet-api 包和Tomcat本身的包冲突了,Tomcat本身也有这个包 ...

- CentOS 6.2配置本地yum源

转载自http://www.cnblogs.com/centoser/articles/2411694.html#undefined 一.挂载本地光盘到系统:把Cent6.2安装光盘放入光驱,在终端命 ...

- 【目标检测】R-CNN系列与SPP-Net总结

目录 1. 前言 2. R-CNN 2.0 论文链接 2.1 概述 2.2 pre-training 2.3 不同阶段正负样本的IOU阈值 2.4 关于fine-tuning 2.5 对文章的一些思考 ...

- [笔记整理]SQL Server 索引碎片 和 重建索引

铺垫知识点: 数据库存储本身是无序的,建立了聚集索引,会按照聚集索引物理顺序存入硬盘.既键值的逻辑顺序决定了表中相应行的物理顺序 多数情况下,数据库读取频率远高于写入频率,索引的存在 为了读取速度牺牲 ...

- Gym - 100712H Bridges(边—双连通分量)

https://vjudge.net/problem/Gym-100712H 题意: 给出一个图,求添加一条边后最少的桥数量. 思路: 参考了ZSQ大神的题解http://blog.csdn.net/ ...

- sass快速入门 - 笔记

一.使用变量 1.使用$符号来标识变量. 例: $nav-color:#F90; .nav{ $width:100px; width:$width; color:$nav-color; }