Multi-attention Network for One Shot Learning

Multi-attention Network for One Shot Learning

2018-05-15 22:35:50

本文的贡献点在于:

1. 表明类别标签信息对 one shot learning 可以提供帮助,并且设计一种方法来挖掘该信息;

2. 提出一种 attention network 来产生 attention maps for creating the image representation of an exemplar image in novel class based on its class tag.

3. 进一步的提出一种 multi-attention scheme 来提升模型的表现;

4. 收集了两个新的数据集,并且构建了一个评价标准。

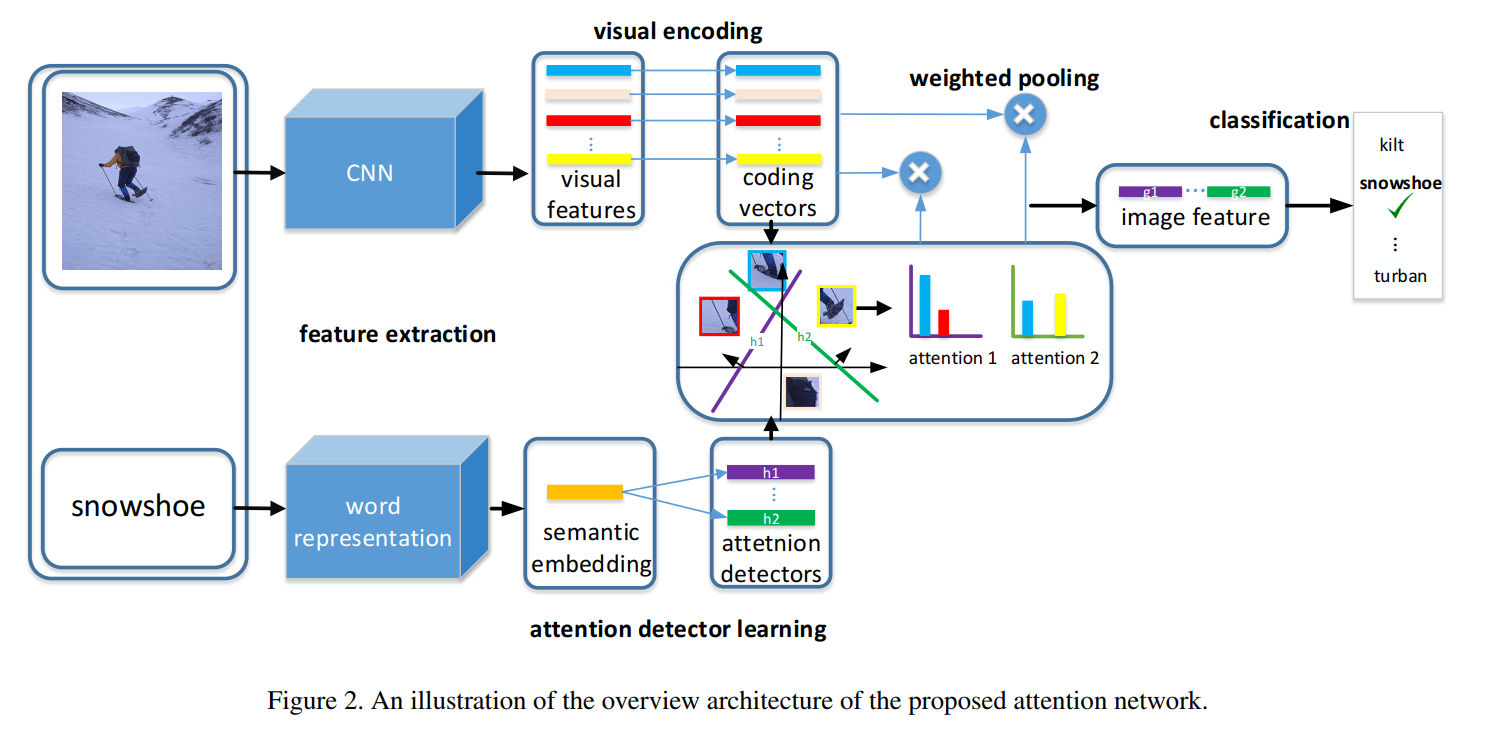

本文的流程图:

Attention Map Generation:

本文 attention value 的计算也是依赖于 visual feature 和 language feature 之间的响应。大致过程如下:

1. 首先用 Word embedding 的方法,得到类别标签的特征 c,然后将该 feature 进一步的学习,可以用 lstm 或者 fc layer,即:

其中,w 和 b 都是可学习的模型参数。

2. 在得到 hidden state 之后,我们将其与 visual feature 进行相乘,得到响应:

3. 将 attention value 进行归一化处理:

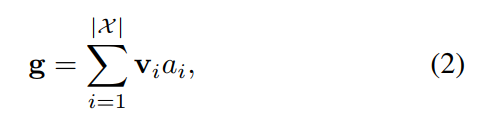

4. 将attention values 和 features 进行相乘,得到加权之后的 feature:

Multi-Attention Mechanism:

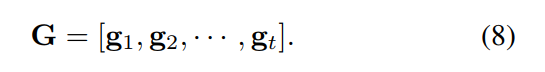

此处的 multi-attention mechanism 就是刚刚那个机制的一个拓展,用不同的参数,得到不同角度的 attention value。

--- Done !

Multi-attention Network for One Shot Learning的更多相关文章

- (转)Paper list of Meta Learning/ Learning to Learn/ One Shot Learning/ Lifelong Learning

Meta Learning/ Learning to Learn/ One Shot Learning/ Lifelong Learning 2018-08-03 19:16:56 本文转自:http ...

- Dual Attention Network for Scene Segmentation

Dual Attention Network for Scene Segmentation 原始文档 https://www.yuque.com/lart/papers/onk4sn 在本文中,我们通 ...

- 语义分割之Dual Attention Network for Scene Segmentation

Dual Attention Network for Scene Segmentation 在本文中,我们通过 基于自我约束机制捕获丰富的上下文依赖关系来解决场景分割任务. 与之前通过多尺 ...

- 论文解读(FedGAT)《Federated Graph Attention Network for Rumor Detection》

论文信息 论文标题:Federated Graph Attention Network for Rumor Detection论文作者:Huidong Wang, Chuanzheng Bai, Ji ...

- Paper | Residual Attention Network for Image Classification

目录 1. 相关工作 2. Residual Attention Network 2.1 Attention残差学习 2.2 自上而下和自下而上 2.3 正则化Attention 最近看了些关于att ...

- Residual Attention Network for Image Classification(CVPR 2017)详解

一.Residual Attention Network 简介 这是CVPR2017的一篇paper,是商汤.清华.香港中文和北邮合作的文章.它在图像分类问题上,首次成功将极深卷积神经网络与人类视觉注 ...

- Semantic Segmentation on Remotely Sensed Images Using an Enhanced Global Convolutional Network with Channel Attention and Domain Specific Transfer Learning

创新点: 1.在GCN(global convolutional network)基础上,把他的backbone替换成更多层的,使其适应中分辨率影像,resnet50,101,152 2.利用 cha ...

- 5、AFM(Attention+FM)-----Attentional Factorization Machines:Learning the Weight of Feature Interactions via Attention Network

1.摘要: 提出一个Attentional FM,Attention模型+因子分解机,其通过Attention学习到特征交叉的权重.因为很显然不是所有的二阶特征交互的重要性都是一样的,如何通过机器自动 ...

- Matching Networks for One Shot Learning

1. Introduction In this work, inspired by metric learning based on deep neural features and memory a ...

随机推荐

- Spring Security实现RBAC权限管理

Spring Security实现RBAC权限管理 一.简介 在企业应用中,认证和授权是非常重要的一部分内容,业界最出名的两个框架就是大名鼎鼎的 Shiro和Spring Security.由于Spr ...

- hive的find_in_set函数

集合查找函数: find_in_set语法: find_in_set(string str, string strList) 返回值: int说明: 返回str在strlist第一次出现的位置,str ...

- python的print函数自动换行及其避免

print函数自带换行功能,即在输出内容后会自动换行,但是有时我们并不需要这个功能,那怎么办呢?这时候就需要用到end这个参数了,使用方法参考下面这段打印$矩阵的代码: i = 1 while i&l ...

- window、linux安装jdk,excel 导入oracle,WebService,window 端口查看,svn服务安装,oracle用户解锁

内存泄露分析插件http://download.eclipse.org/mat/1.3/update-site/birt插件http://download.eclipse.org//birt/upda ...

- [转载]oracle 数据类型详解---日期型

1.常用日期型数据类型1.1.DATE这是ORACLE最常用的日期类型,它可以保存日期和时间,常用日期处理都可以采用这种类型.DATE表示的日期范围可以是公元前4712年1月1日至公元9999年12月 ...

- Icarscan VCI is definitely the update variation of Start iDiag

Start iCarScan is alternative of Super X431 iDiag, it’ll make your Android smartphone or tablet righ ...

- 怎样从外网访问内网Jetty?

本地安装了一个Jetty,只能在局域网内访问,怎样从外网也能访问到本地的Jetty呢?本文将介绍具体的实现步骤. 准备工作 安装并启动Jetty 默认安装的Jetty端口是8080. 实现步骤 下载并 ...

- javaweb笔记—01(编程英语、常识、Tomcat配置问题)

第一部分: 编程英语: legal:adj. 法律的:合法的:法定的 Userful :出版商 sponsor: n. 赞助者:主办者:保证人 | vt. 赞助:发起 essential:n. 本质 ...

- mysqldump 使用小结

语法: 备份某个数据库: mysqldump -uroot -p*** [options] –-databases DB_name > back_db_name.sql --databases: ...

- 禁止单个IP或ip段访问

//IP禁止判断接口,返回true则为找到 function checkIp($ip, $ipbanned) { $ipbannedFlag = false; if (!empty($ipbanned ...