Spark 集群安装部署

安装准备

Spark 集群和 Hadoop 类似,也是采用主从架构,Spark 中的主服务器进程就叫 Master(standalone 模式),从服务器进程叫 Worker

Spark 集群规划如下:

- node-01:Master

- node-02:Worker

- node-03:Worker

安装步骤

1. 上传并解压 Spark 安装文件

将 spark-2.4.7-bin-hadoop2.7.tgz 安装包上传到 node-01 的 /root 目录下,并将其解压

# 解压到 /apps 目录中

[root@node-01 ~]# tar -zxvf spark-2.4.7-bin-hadoop2.7.tgz -C apps/

# 删除安装压缩包

[root@node-01 ~]# rm -rf spark-2.4.7-bin-hadoop2.7.tgz

[root@node-03 ~]# cd /root/apps/

# 改名

[root@node-01 apps]# mv spark-2.4.7-bin-hadoop2.7/ spark-2.4.7

2. 配置环境变量

[root@node-01 ~]# vim /etc/profile

#行尾添加

export SPARK_HOME=/root/apps/spark-2.4.7

export PATH=$PATH:$SPARK_HOME/bin:$SPARK_HOME/sbin

[root@node-01 ~]# source /etc/profile

3. 配置运行环境

[root@node-01 ~]# cd /root/apps/spark-2.4.7/conf/

# 改名(去掉后面的 template 模板后缀名)

[root@node-01 conf]# mv spark-env.sh.template spark-env.sh

[root@node-01 conf]# vi spark-env.sh

# 行尾添加

export JAVA_HOME=/root/apps/jdk1.8.0_141/

# 设置 Spark Master 所在的主机名(或IP地址)

export SPARK_MASTER_HOST=node-01

export SPARK_MASTER_PORT=7077

4. 修改 slaves 配置

该脚本文件用于设置 Master 下面的 Worker 的主机名(或IP地址)

[root@node-01 ~]# cd /root/apps/spark-2.4.7/conf/

# 改名(去掉后面的 template 模板后缀名)

[root@node-01 conf]# mv slaves.template slaves

[root@node-01 conf]# vi slaves

node-02

node-03

5. 创建启动和关闭 Spark 集群脚本软连接

创建软连接的原因是 hadoop/sbin 目录和 spark/sbin 目录脚本可能命名相同,导致执行命令冲突

[root@node-01 ~]# cd /root/apps/spark-2.4.7/sbin/

[root@node-01 sbin]# ln -s start-all.sh start-all-spark.sh

[root@node-01 sbin]# ln -s stop-all.sh stop-all-spark.sh

5. 将 Spark 安装包复制到集群其他主机上

[root@node-01 ~]# cd /etc

[root@node-01 etc]# scp profile node-02:$PWD

[root@node-01 etc]# scp profile node-03:$PWD

[root@node-02 ~]# source /etc/profile

[root@node-03 ~]# source /etc/profile

[root@node-01 ~]# cd apps/

[root@node-01 apps]# scp -r spark-2.4.7/ node-02:$PWD

[root@node-01 apps]# scp -r spark-2.4.7/ node-03:$PWD

6. 启动 Spark 集群

Spark 的 sbin 目录(里面存放各种 Spark 操作命令)

[root@node-01 ~]# start-all-spark.sh

starting org.apache.spark.deploy.master.Master, logging to /root/apps/spark-2.4.7/logs/spark-root-org.apache.spark.deploy.master.Master-1-hdp-01.out

hdp-03: starting org.apache.spark.deploy.worker.Worker, logging to /root/apps/spark-2.4.7/logs/spark-root-org.apache.spark.deploy.worker.Worker-1-hdp-03.out

hdp-02: starting org.apache.spark.deploy.worker.Worker, logging to /root/apps/spark-2.4.7/logs/spark-root-org.apache.spark.deploy.worker.Worker-1-hdp-02.out

[root@hdp-01 sbin]# jps

1690 Master

1742 Jps

再去查看 node-02 和 node-03

[root@node-02 ~]# jps

1557 Jps

1512 Worker

[root@node-03 ~]# jps

1538 Worker

1583 Jps

说明 Spark 集群已经启动成功

- 单独启动 Master:# start-master.sh

- 单独启动 Worker:# start-slave.sh spark://node-01:7077

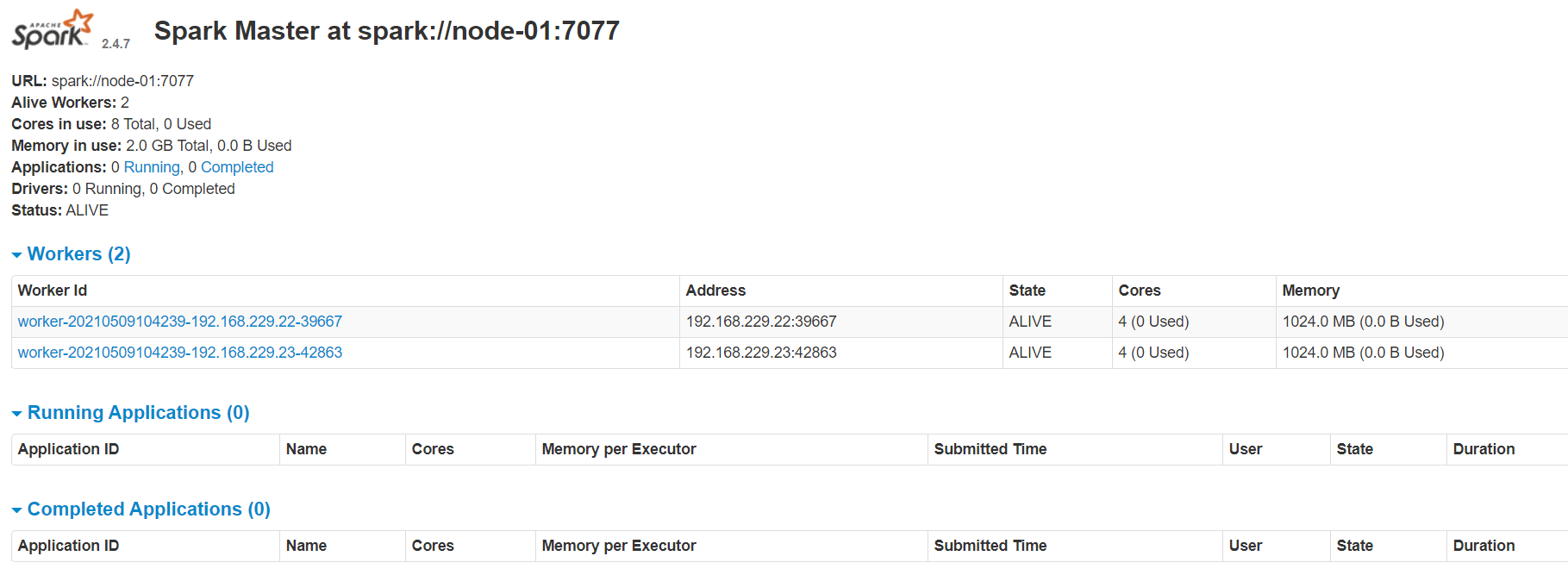

6. 启动 Spark 的浏览器 Web 页面

这里 Web 的服务器端口号是 8080(端口号 7077 是 RPC 远程调用的通信端口)

打开浏览器输入:http://node-01:8080/ 回车

默认情况下 Spark 会占用机器上的所有 cores(CPU)和 memory(内存)

Spark 集群安装部署的更多相关文章

- Hadoop2.2集群安装配置-Spark集群安装部署

配置安装Hadoop2.2.0 部署spark 1.0的流程 一.环境描写叙述 本实验在一台Windows7-64下安装Vmware.在Vmware里安装两虚拟机分别例如以下 主机名spark1(19 ...

- spark集群安装部署

通过Ambari(HDP)或者Cloudera Management (CDH)等集群管理服务安装和部署在此不多介绍,只需要在界面直接操作和配置即可,本文主要通过原生安装,熟悉安装配置流程. 1.选取 ...

- [bigdata] spark集群安装及测试

在spark安装之前,应该已经安装了hadoop原生版或者cdh,因为spark基本要基于hdfs来进行计算. 1. 下载 spark: http://mirrors.cnnic.cn/apache ...

- CentOS6安装各种大数据软件 第十章:Spark集群安装和部署

相关文章链接 CentOS6安装各种大数据软件 第一章:各个软件版本介绍 CentOS6安装各种大数据软件 第二章:Linux各个软件启动命令 CentOS6安装各种大数据软件 第三章:Linux基础 ...

- Spark入门:第2节 Spark集群安装:1 - 3;第3节 Spark HA高可用部署:1 - 2

三. Spark集群安装 3.1 下载spark安装包 下载地址spark官网:http://spark.apache.org/downloads.html 这里我们使用 spark-2.1.3-bi ...

- Spark 个人实战系列(1)--Spark 集群安装

前言: CDH4不带yarn和spark, 因此需要自己搭建spark集群. 这边简单描述spark集群的安装过程, 并讲述spark的standalone模式, 以及对相关的脚本进行简单的分析. s ...

- 大数据技术之_19_Spark学习_01_Spark 基础解析 + Spark 概述 + Spark 集群安装 + 执行 Spark 程序

第1章 Spark 概述1.1 什么是 Spark1.2 Spark 特点1.3 Spark 的用户和用途第2章 Spark 集群安装2.1 集群角色2.2 机器准备2.3 下载 Spark 安装包2 ...

- spark集群安装配置

spark集群安装配置 一. Spark简介 Spark是一个通用的并行计算框架,由UCBerkeley的AMP实验室开发.Spark基于map reduce 算法模式实现的分布式计算,拥有Hadoo ...

- HBase集群安装部署

0x01 软件环境 OS: CentOS6.5 x64 java: jdk1.8.0_111 hadoop: hadoop-2.5.2 hbase: hbase-0.98.24 0x02 集群概况 I ...

随机推荐

- 安装Dynamics CRM Report出错二

提示账户不是本地用户且不受支持 找到所需的服务,使用域管理员用户更改服务运行的账户.应用和确定 重新启动服务 重新运行安装向导,环境验证成功

- Day17_100_IO_FileWriter文件字符输入流

FileWriter文件字符输入流 继承结构 Java.lang.Object - java.io.Writer; 抽象类 java.io.OutputStreamWriter; <转换流: 将 ...

- BeetleX数据分析中间服务V3

V3版可以对更多的数据场景分析,可以用在系统日志,销售数据,医疗门诊等不同行业的数据进行分析透视.而它的目标并不是简单地进行数据汇总,更注重于不同时间段和不同标签之前的数据的汇总和差异对比,通过数据的 ...

- K8S(18)容器环境下资源限制与jvm内存回收

K8S(18)容器环境下资源限制与jvm内存回收 目录 K8S(18)容器环境下资源限制与jvm内存回收 一.k8s中的java资源限制与可能的问题 方案1:通过JVM的Xms和Xmx参数限制 方案2 ...

- CSS快速入门基础篇,让你快速上手(附带代码案例)

1.什么是CSS 学习思路 CSS是什么 怎么去用CSS(快速上手) CSS选择器(难点也是重点) 网页美化(文字,阴影,超链接,列表,渐变等) 盒子模型 浮动 定位 网页动画(特效效果) 项目格式: ...

- 100多个很有用的JavaScript函数以及基础写法大集合

100多个很有用的JavaScript函数以及基础写法大集合 1.document.write("");为 输出语句2.JS中的注释为//3.传统的HTML文档顺序是:docume ...

- Python socket(TCP阻塞模式)基础程式

前置知识:Python基础语法,socket库 tips: 1. 默认HOST_IP:127.0.0.1 2. 默认HOST_PORT:7676 参考代码: 1. 客户端程式 #!/usr/bin/e ...

- xxl-job滥用netty导致的问题和解决方案

netty作为一种高性能的网络编程框架,在很多开源项目中大放异彩,十分亮眼,但是在有些项目中却被滥用,导致使用者使用起来非常的难受. 本篇文章将会讲解xxl-job作为一款分布式任务调度系统是如何滥用 ...

- web技术培训(一)-云服务器、域名相关

云服务器 什么是云服务器(这部分可以跳过) 云服务器(Elastic Compute Service, ECS)是一种简单高效.安全可靠.处理能力可弹性伸缩的计算服务.其管理方式比物理服务器更简单高效 ...

- [LeetCode每日一题]1143. 最长公共子序列

[LeetCode每日一题]1143. 最长公共子序列 问题 给定两个字符串 text1 和 text2,返回这两个字符串的最长 公共子序列 的长度.如果不存在 公共子序列 ,返回 0 . 一个字符串 ...