Python-beautifulsoup库

#beautifulsoup库的安装

pip install beautifulsoup4

python -m pip install --upgrage pip

from bs4 import BeautifulSoup #----------------beautifulsoup库的使用--------------------------------------

import requests

from bs4 import BeautifulSoup

url = "http://python123.io/ws/demo.html"

r = requests.get(url)

# print(r.text)

demo = r.text

soup = BeautifulSoup(demo,"html.parser") #熬一锅`粥

#print(soup.prettify()) #打印这锅粥 #下行遍历函数:.contents() .children()用于循环 .descendants()

soup.head #获取head标签

soup.head.contents #获取head的子节点,返回类型是列表

soup.body.contents #

len(soup.body.contents) #terurn 5

soup.body.contents[2]

print('以下输出子节点:')

for child in soup.body.children:

print('##',child)

print('以下输出子孙节点:')

for child in soup.body.descendants:

print('**',child) #---上行遍历 .parent .parents(用于循环)

soup.title.parent #return <head><title>This is a python demo page</title></head>

soup.html.parents #返回 html所有内容

soup.parent #返回为空

print('以下输出父节点:')

for par in soup.a.parents:

if par is None:

print('$$$',par)

else:

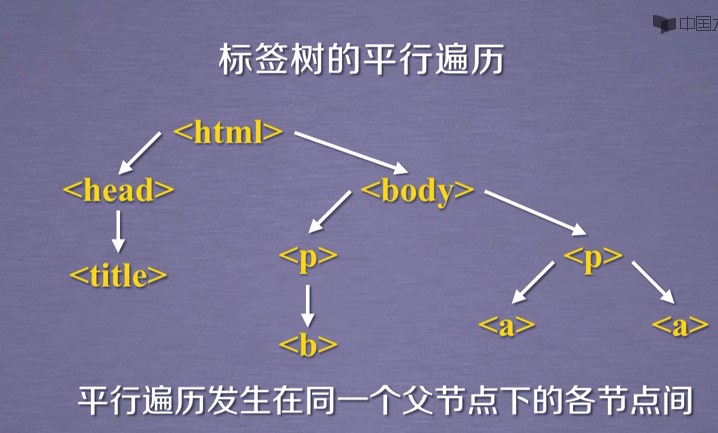

print('%',par.name) #----平行遍历----

# 向后.next_sibling 向前.previous_sibling 加 s 用于遍历

#title 与 p标签 不构成平行关系

soup.a.next_sibling #return ' and ' 所以<a>标签的下一个标签不一定是<a>标签,需要判断

soup.a.next_sibling.next_sibling #return <a ...</a> soup.a.previous_sibling

soup.a.previous_sibling.previous_sibling

print('以下输出下行遍历:')

for sibling in soup.a.next_siblings:

print('##',sibling)

print('以下输出上行遍历:')

for sibling in soup.a.previous_siblings:

print('**',sibling)

Python-beautifulsoup库的更多相关文章

- python BeautifulSoup库的基本使用

Beautiful Soup 是用Python写的一个HTML/XML的解析器,它可以很好的处理不规范标记并生成剖析树(parse tree). 它提供简单又常用的导航(navigating),搜索以 ...

- python BeautifulSoup库用法总结

1. Beautiful Soup 简介 简单来说,Beautiful Soup是python的一个库,最主要的功能是从网页抓取数据.官方解释如下: Beautiful Soup提供一些简单的.pyt ...

- Python BeautifulSoup库的用法

BeautifulSoup是一个可以从HTML或者XML文件中提取数据的Python库,它通过解析器把文档解析为利于人们理解的文档导航模式,有利于查找和修改文档. BeautifulSoup3目前已经 ...

- Python爬虫-- BeautifulSoup库

BeautifulSoup库 beautifulsoup就是一个非常强大的工具,爬虫利器.一个灵活又方便的网页解析库,处理高效,支持多种解析器.利用它就不用编写正则表达式也能方便的实现网页信息的抓取 ...

- Python爬虫小白入门(三)BeautifulSoup库

# 一.前言 *** 上一篇演示了如何使用requests模块向网站发送http请求,获取到网页的HTML数据.这篇来演示如何使用BeautifulSoup模块来从HTML文本中提取我们想要的数据. ...

- python爬虫从入门到放弃(六)之 BeautifulSoup库的使用

上一篇文章的正则,其实对很多人来说用起来是不方便的,加上需要记很多规则,所以用起来不是特别熟练,而这节我们提到的beautifulsoup就是一个非常强大的工具,爬虫利器. beautifulSoup ...

- python爬虫学习之使用BeautifulSoup库爬取开奖网站信息-模块化

实例需求:运用python语言爬取http://kaijiang.zhcw.com/zhcw/html/ssq/list_1.html这个开奖网站所有的信息,并且保存为txt文件和excel文件. 实 ...

- python下载安装BeautifulSoup库

python下载安装BeautifulSoup库 1.下载https://www.crummy.com/software/BeautifulSoup/bs4/download/4.5/ 2.解压到解压 ...

- python爬虫学习(一):BeautifulSoup库基础及一般元素提取方法

最近在看爬虫相关的东西,一方面是兴趣,另一方面也是借学习爬虫练习python的使用,推荐一个很好的入门教程:中国大学MOOC的<python网络爬虫与信息提取>,是由北京理工的副教授嵩天老 ...

- python库:bs4,BeautifulSoup库、Requests库

Beautiful Soup https://www.crummy.com/software/BeautifulSoup/bs4/doc.zh/ Beautiful Soup 4.2.0 文档 htt ...

随机推荐

- 《编写可维护的JavaScript》 笔记

<编写可维护的JavaScript> 笔记 我的github iSAM2016 概述 本书的一开始介绍了大量的编码规范,并且给出了最佳和错误的范例,大部分在网上的编码规范看过,就不在赘述 ...

- CSS盒子模型+box-sizing

当对文档进行布局时,浏览器渲染引擎会根据css-Box模型(CSS Basic Box model)将所有元素表示为一个矩形盒子.CSS决定这些盒子的大小,位置以及属性(颜色,背景,边框尺寸) 标准盒 ...

- anaconda重装jupyter notebook后启动jupyter报错的问题

问题描述: 由于jupyter出现难以解决的问题,采用重新安装来解决问题,但是重装之后启动jupyter报错ImportError: libsodium.so.23: cannot open shar ...

- Node配合WebSocket做多文件下载以及进度回传

起因 为什么做这个东西,是突然间听一后端同事说起Annie这个东西,发现这个东西下载视频挺方便的,会自动爬取网页中的视频,然后整理成列表.发现用命令执行之后是下面的样子: 心里琢磨了下,整一个界面玩一 ...

- Apache Tomcat 远程代码执行漏洞(CVE-2019-0232)漏洞复现

Apache Tomcat 远程代码执行漏洞(CVE-2019-0232)漏洞复现 一. 漏洞简介 漏洞编号和级别 CVE编号:CVE-2019-0232,危险级别:高危,CVSS分值:官方 ...

- [考试反思]0803NOIP模拟测试12:偿还

嗯,rank5.没什么可评价的,高不算高低不算低. 一套好题,被我浪费了. 离上面280的大神差的有点远. 分机房的绝响就要来临. 越来越感觉自己变菜了,整体的能力水平在下滑. 说的不只是考试,包括平 ...

- 最新JetBrains PyCharm 使用教程--常用快捷键和设置PyCharm为Eclipse快捷键(四)

PyCharm常用快捷键使用 Ctrl + D:复制当前行 Ctrl + Y:删除当前行 Ctrl + Z 撤销 Shift + Enter:快速换行 Ctrl + /:快速注释 Ctrl + F: ...

- css3 svg路径蒙版动画

css3 svg路径蒙版动画 具体看https://www.cnblogs.com/oubenruing/p/9568954.html 还有个更好控制的写法<pre><!DOCTYP ...

- .NET Core3.0 EF 连接 MySql

一:创建项目 添加 csproj (或者直接NuGet 引用) <ItemGroup> <PackageReference Include="Microsoft.Entit ...

- MySql——使用where子句过滤数据

示例使用的数据表在上一个博客中创建的https://www.cnblogs.com/lbhym/p/11895968.html 参考资料:<Mysql必知必会> 1.使用where子句 示 ...