02篇ELK日志系统——升级版集群之kibana和logstash的搭建整合

【

前言:01篇LK日志系统已经把es集群搭建好了,接下来02篇搭建kibana和logstash,并整合完成整个ELK日志系统的初步搭建。

】

1、安装kibana

3台服务器:

192.168.2.119 (119服务器当做集群的主服务器)

192.168.2.115

192.168.2.116

我在119服务器,也就是elasticsearch主节点机上安装kibana

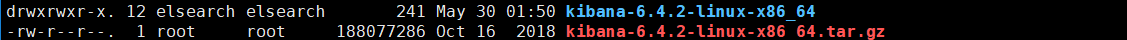

把kibana的安装包放在/usr/local/dev/kibana/目录 下并解压如下:

1.1、修改kibana的配置,内容如下:

#配置kibana的端口

server.port: 5601

#配置kibana监听的ip

server.host: 192.168.2.119

#配置es服务器的ip,如果是es集群,则配置该集群的主节点ip

elasticsearch.url: "http://192.168.2.119:9200"

#配置kibana的日志文件路径,不然默认的是messages文件夹里记录日志

logging.dest: /usr/local/dev/kibana/kibana-6.4.2-linux-x86_64/logs/kibana.log

1.2、配置完kibana.yml之后,就可以直接启动了,不过我要用service kibana start 命令启动,需要配置此服务命令,如下:

#使用service kibana start 命令来启动kibana服务 (跟昨天配置elasticsearch命令一样,logstash配置此命令也是如此)

cd /etc/init.d

touch kibana

chmod +x kibana #打开kibana

vi kibana #输入以下配置内容: 》》》》》》》》》》》》》》》》》》》》》》》》》》》

#!/bin/bash

# chkconfig: 2345 98 02

# description: kibana

KIBANA_HOME=/usr/local/dev/kibana/kibana-6.4.2-linux-x86_64

case $1 in

start) $KIBANA_HOME/bin/kibana &;;

*) echo "require start";;

esac

》》》》》》》》》》》》》》》》》》》》》》》》》》》

1.3、使用service kibana start命令启动:

1.4、查看是否成功启动了kibana服务:

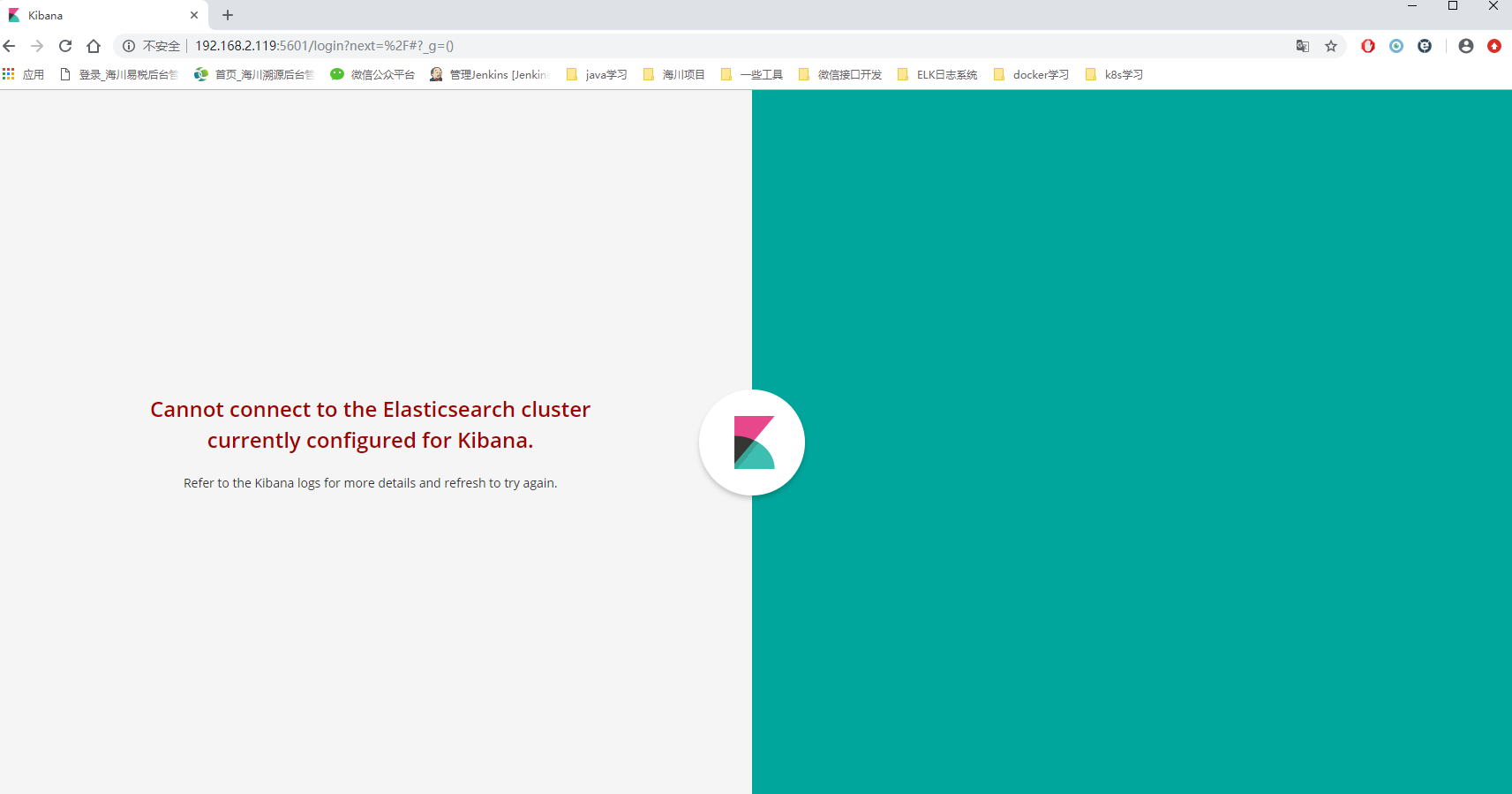

kibana启动成功,浏览器输入192.168.2.119:5601,成功如下:

》》》kibana配置成功搞定》》》》》》》》》》》》》》》》》》》》》》》》》》》》》》》》》

2、安装logstash

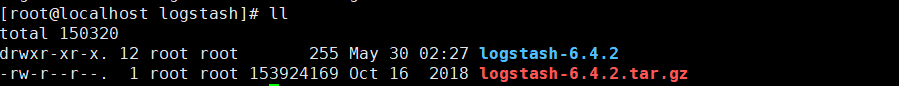

2.1、接下来在115上安装logstash,我把logstash的安装包放在了/usr/local/dev/logstash/目录下,如下:

2.2、logstash的配置,内容如下:

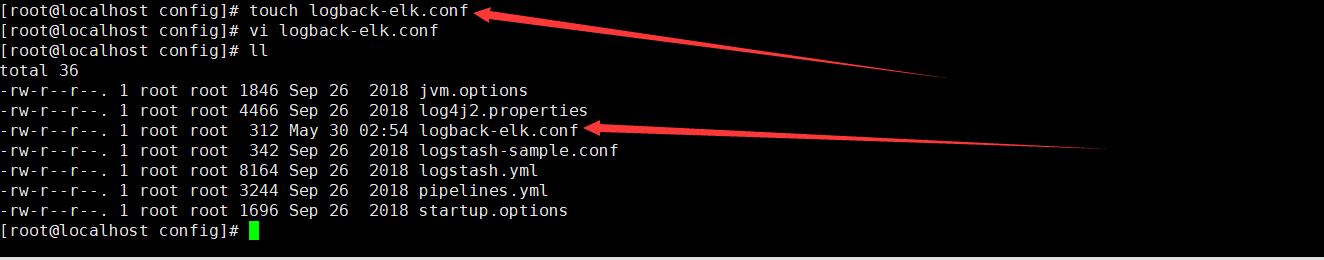

要先在logstash的config目录下,新建一个logback-elk.conf配置文件,应该我暂时用logback传输日志到logstash,所以就建了个logback-elk.conf的配置文件,命名随意。

(暂时还没玩透kafka,所以当前先不用kafka传输日志)

logback-elk.conf配置的内容如下:

input {

tcp {

port => #logstash服务开启的端口号

mode => "server"

tags => ['tags']

codec => json_lines #解析方式为json格式打印

}

}

output {

elasticsearch {

hosts => ["192.168.2.119:9200"] #elasticsearch 主节点

index =>"%{[appname]}-%{+YYYY.MM.dd}" #appname 为在springboot项目中配置logback时用到,指向项目名

}

stdout { codec => rubydebug}

}

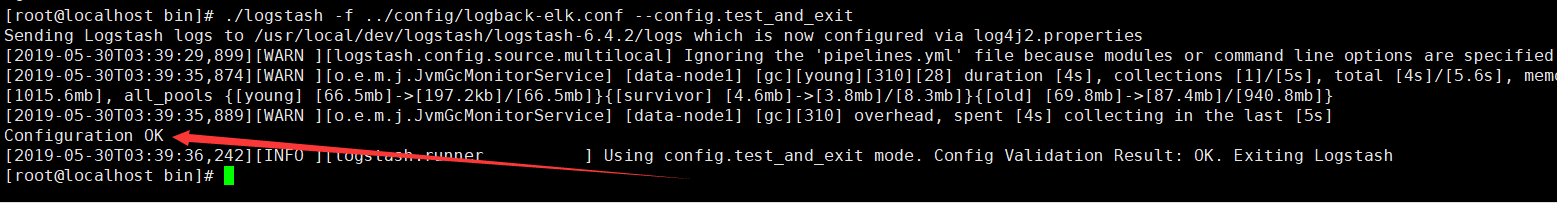

2.3、检查logback-elk.conf的配置是否有错:出现Configuration OK说明内容配置没什么问题

#进入logstash安装目录的bin目录中,使用下面命令检查

./logstash -f ../config/logback-elk.conf --config.test_and_exit

命令说明:

–path.settings 用于指定logstash的配置文件所在的目录

-f 指定需要被检测的配置文件的路径

–config.test_and_exit 指定检测完之后就退出,不然就会直接启动了

2.4、然后再配置logstash的命令启动:service logstash start

#使用service logstash start 命令来启动kibana服务 (跟昨天配置elasticsearch命令一样,logstash配置此命令也是如此)

cd /etc/init.d

touch logstash

chmod +x logstash #打开logstash

vi logstash #输入以下配置内容: 》》》》》》》》》》》》》》》》》》》》》》》》》》》

#!/bin/bash

# chkconfig: 2345 50 50

# description: logstash

#JAVA_HOME=/usr/local/dev/java/jdk1.8.0_141

LS_HOME=/usr/local/dev/logstash/logstash-6.4.2

case $1 in

start) $LS_HOME/bin/logstash -f $LS_HOME/config/logback-elk.conf &;;

*) echo "require start";;

esac

》》》》》》》》》》》》》》》》》》》》》》》》》》》

2.5、启动logstash服务:service logstash start

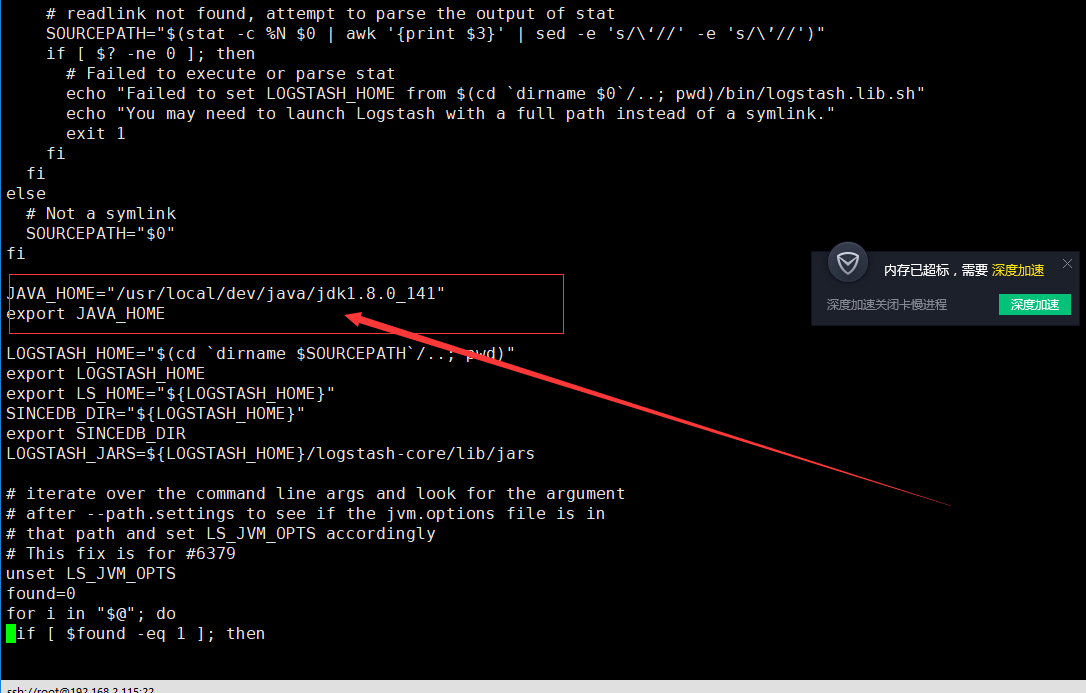

可能会报错:

could not find java; set JAVA_HOME or ensure java is in PATH

解决办法:进入logstash的bin目录,打开logstash.lib.sh文件

vi logstash.lib.sh #在文件里加入JAVA_HOME的地址

JAVA_HOME="/usr/local/dev/java/jdk1.8.0_141"

export JAVA_HOME

成功如下:发现没有打开ERROR的日志,然后再查看logstash服务进程是否开启

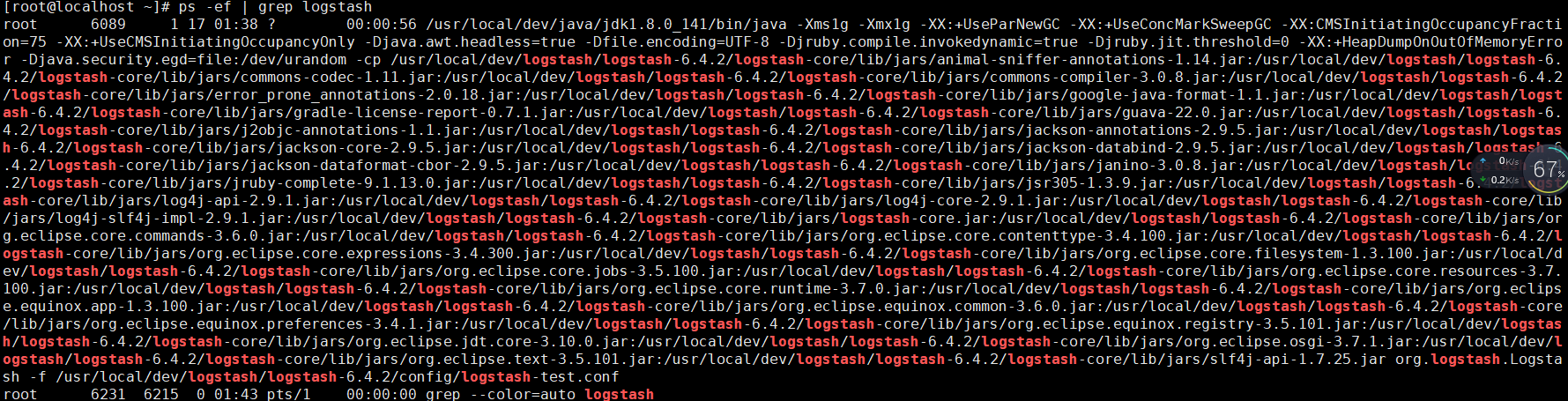

查看logstash的服务进程:ps -ef | grep logstash

》》》》》》》到此logstash的安装和启动就完成了》》》》》》》》》》》》》》》》》》》》》》》》

当3台服务器上的es集群启动、logstash服务启动、kibana服务启动,都完全启动成功,完美整合,浏览器打开kibana:192.168.2.119:5601,如下:kibana还没有整合配置x-Pack权限插件所以是不用登录的

搞完放牛去

02篇ELK日志系统——升级版集群之kibana和logstash的搭建整合的更多相关文章

- 01篇ELK日志系统——升级版集群之elasticsearch集群的搭建

[ 前言:以前搭了个简单的ELK日志系统,以我个人的感觉来说,ELK日志系统还是非常好用的.以前没有弄这个ELK日志系统的时候,线上的项目出了bug,报错了,要定位错误是什么,错误出现在哪个java代 ...

- 03篇ELK日志系统——升级版集群之ELK日志系统整合springboot项目

[ 前言:整个ELK日志系统已经搭建好了,接下来的流程就是: springboot项目中的logback日志配置通过tcp传输,把springboot项目中所有日志数据传到————>logsta ...

- elk 日志收集 filebeat 集群搭建 php业务服务日志 nginx日志 json 7.12版本 ELK 解决方案

难的不是技术,难的是业务.熟悉业务流程才是最难的. 其实搜索进来的每一个人的需求不一样,希望你能从我的这篇文章里面收获到. 建议还是看官方文档,更全面一些. 一.背景 1,收集nginx acces ...

- Docker部署ELK 7.0.1集群之Kibana安装介绍

1.下载镜像 [root@vanje-dev01 ~]# docker pull kibana: 2.安装部署 2.1 创建宿主机映射目录 [root@vanje-dev01 ~]# mkdir /e ...

- ELK日志系统:Filebeat使用及Kibana如何设置登录认证

根据elastic上的说法: Filebeat is a lightweight, open source shipper for log file data. As the next-generat ...

- ELK日志系统:Filebeat使用及Kibana如何设置登录认证(转)

原文地址:http://www.cnblogs.com/yjmyzz/p/filebeat-turorial-and-kibana-login-setting-with-nginx.html 根据el ...

- ELK日志系统之kibana的使用操作

1.ELK日志系统打开后,打开kibana的操作界面,第一步创建索引模式: 第2步:创建日志索引 第3步:创建成功 第4步:查看30分钟时间段内的日志数据,也可以查今天的,今月的,今年的 放牛去

- Redis高可用集群-哨兵模式(Redis-Sentinel)搭建配置教程【Windows环境】

No cross,no crown . 不经历风雨,怎么见彩虹. Redis哨兵模式,用现在流行的话可以说就是一个"哨兵机器人",给"哨兵机器人"进行相应的配置 ...

- 创业公司做数据分析(四)ELK日志系统 (转)

http://blog.csdn.net/zwgdft/article/details/53842574 作为系列文章的第四篇,本文将重点探讨数据采集层中的ELK日志系统.日志,指的是后台服务中产生的 ...

随机推荐

- mysql版本引起的驱动问题

mysql版本引起的驱动问题 com.mysql.jdbc.Driver 是 mysql-connector-java 5中的, com.mysql.cj.jdbc.Driver 是 mysql-co ...

- 本地jar包在maven工程中pom引用

背景 在使用Maven的过程中,经常碰到有些jar包在中央仓库没有的情况.如果公司有私服,那么就把jar包安装到私服上.如果没有私服,那就把jar包安装到本地Maven仓库.下面是如何把jar包导 ...

- LeetCode 153. Find Minimum in Rotated Sorted Array寻找旋转排序数组中的最小值 (C++)

题目: Suppose an array sorted in ascending order is rotated at some pivot unknown to you beforehand. ( ...

- <Trie> 212 <Array> 229

212. Word Search II class TrieNode{ char val; TrieNode[] children; String word; public TrieNode(char ...

- python中使用redis模块, 设置过期时间

# 链接数据库self.handle = redis.Redis(host=host, port=port, db=db, password=password, decode_responses=Tr ...

- mission3--dp

A---母牛的故事 题目大意:第一年有一头母牛,每年年初母牛生小母牛,小母牛第四个年头可以开始生小牛. 问第n年有多少头牛. 题解: (1)列出前几项来找规律(2)第i年牛的数量=第i-1年牛的数量+ ...

- [LeetCode] 763. Partition Labels 分割标签

A string S of lowercase letters is given. We want to partition this string into as many parts as pos ...

- oracle--delete truncate drop的区别

一.delete 1.delete是DML,执行delete操作时,每次从表中删除一行,并且同时将该行的的删除操作记录在redo和undo表空间中以便进行回滚(rollback)和重做操作,但要注意表 ...

- JDK Mac 安装

JDK安装步骤 一台mac os 环境 jdk.sdk.Android studio 1.打开终端-输入命令Java 2.从下面的图中可以看到,终端会自动给出提示,没有可以使用的java命令 ...

- Nginx配置max_fails fail_timeout

目的: 通过配置max_fails.fail_timeout来达到当一台服务器访问出现非200时可以跳转到另一台服务器 操作: 配置nginx.conf文件 具体配置如下 upstream Site ...