单机配置kafka和zookeeper

1:环境准备

jdk 推荐oracle,不建议open sdk

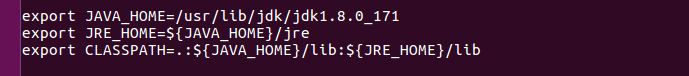

在/etc/profile加入下列环境变量

在PATH中将jdk和jre的bin加入path里面

$JAVA_HOME/bin:$JRE_HOME/bin

2:安装zookeeper

下载zookeeper tar

url: https://archive.apache.org/dist/zookeeper/zookeeper-3.4.5/zookeeper-3.4.5.tar.gz

将压缩包移动到/usr/local下面

tar -zxvf ***

更改配置文件

(1)将conf/zoo_sample.cfg更改为zoo.cfg

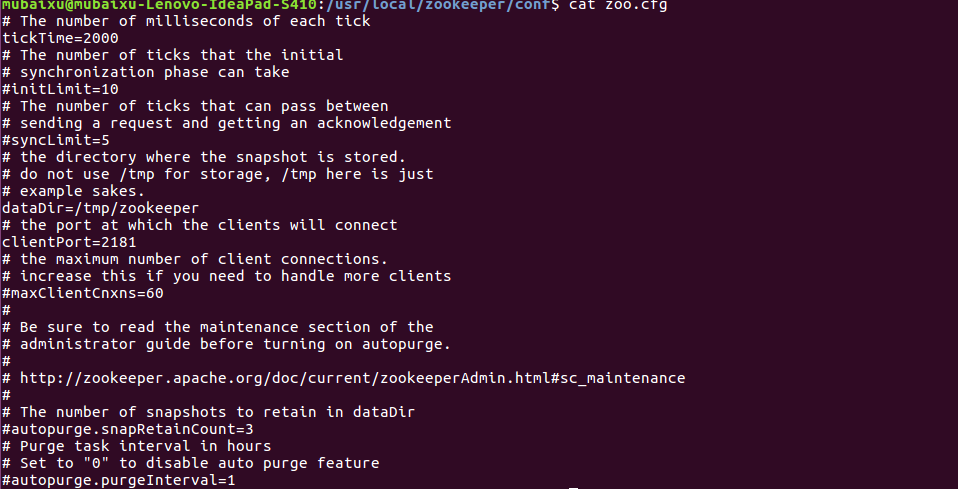

(2)更改配置如下

注意:

*其中默认port为2181。

*datadir需手动创建 mkdir -p datadir

*注释掉的参数在单机中无用

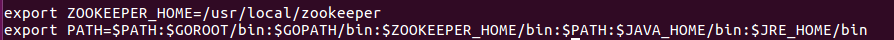

(3)加入环境变量 /etc/profile

测试:

可以cd 到bin目录下通过执行 zkServer.sh shell脚本启动、停止或者查看状态

eg:

./zkServer.sh start/stop/status

3:安装kafka

先下载tar包、解压、mv到/usr/local下面

wget https://www.apache.org/dyn/closer.cgi?path=/kafka/0.11.0.0/kafka_2.11-0.11.0.0.tgz

sudo mv *** /usr/local

cd /usr/local

sudo tar -zxvf ****

sudo rm **.tar.gz

修改config目录下配置文件

vim server.properties

修改如下参数

#broker.id需改成正整数,单机为1就好

broker.id=

#指定端口号

port=

#localhost这一项还有其他要修改,详细见下面说明

host.name=localhost

#指定kafka的日志目录

log.dirs=/usr/local/kafka_2.-0.11.0.0/kafka-logs

#连接zookeeper配置项,这里指定的是单机,所以只需要配置localhost,若是实际生产环境,需要在这里添加其他ip地址和端口号

zookeeper.connect=localhost:

vim zookeeper.properties

修改如下参数

#数据目录

dataDir=/usr/local/kafka_2.-0.11.0.0/zookeeper/data

#客户端端口

clientPort=

host.name=localhost

producer.properties and consumer.properties

zookeeper.connect=localhost:

4:启动kafka

bin/zookeeper-server-start.sh config/zookeeper.properties

bin/kafka-server-start.sh config/server.properties

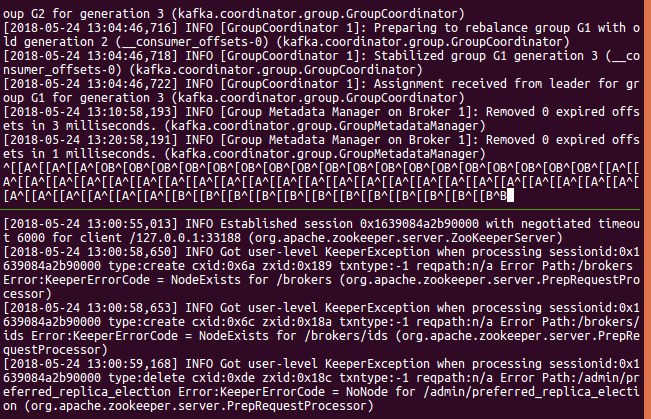

终端都是info log

注意:如果是非root用户,可能会使用到sudo去启动zookeeper和kafka,但是那样会失败必须将kafka整个目录下的文件的owner和group都改为自己的用户。

可以通过jps命令查看两者是否启动成功

2576 QuorumPeerMain表示zookeeper

如果发现没启动成功,可以在zookeeper/config/zookeeper.out里debug。

成功启动后,可以简单通过demo进行测试

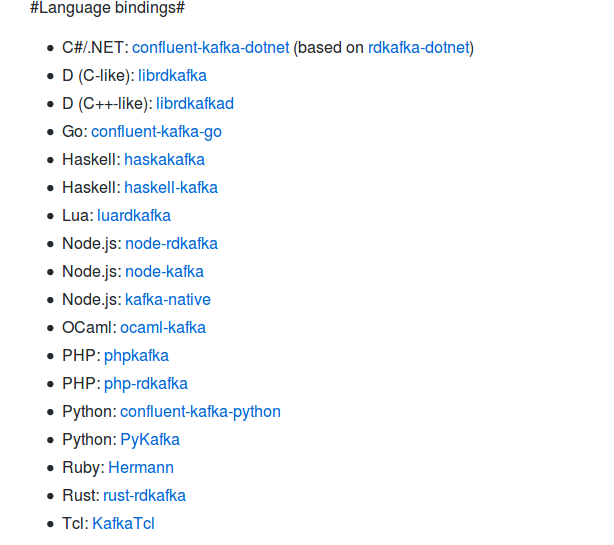

github有各种语言的kafka支持

url:https://github.com/edenhill/librdkafka/tree/v0.9.5

可以简单通过go的demo进行测试

consumer

import (

"fmt"

"github.com/confluentinc/confluent-kafka-go/kafka"

) func main() { c, err := kafka.NewConsumer(&kafka.ConfigMap{

"bootstrap.servers": "localhost",

"group.id": "myGroup",

"auto.offset.reset": "earliest",

}) if err != nil {

panic(err)

} c.SubscribeTopics([]string{"myTopic", "^aRegex.*[Tt]opic"}, nil) for {

msg, err := c.ReadMessage(-)

if err == nil {

fmt.Printf("Message on %s: %s\n", msg.TopicPartition, string(msg.Value))

} else {

fmt.Printf("Consumer error: %v (%v)\n", err, msg)

break

}

} c.Close()

}

producer

import (

"fmt"

"github.com/confluentinc/confluent-kafka-go/kafka"

) func main() { p, err := kafka.NewProducer(&kafka.ConfigMap{"bootstrap.servers": "localhost"})

if err != nil {

panic(err)

} go func() {

for e := range p.Events() {

switch ev := e.(type) {

case *kafka.Message:

if ev.TopicPartition.Error != nil {

fmt.Printf("Delivery failed: %v\n", ev.TopicPartition)

} else {

fmt.Printf("Delivered message to %v\n", ev.TopicPartition)

}

}

}

}() topic := "myTopic"

for _, word := range []string{"Welcome", "to", "the", "Confluent", "Kafka", "Golang", "client"} {

p.Produce(&kafka.Message{

TopicPartition: kafka.TopicPartition{Topic: &topic, Partition: kafka.PartitionAny},

Value: []byte(word),

}, nil)

} p.Flush( * )

}

单机配置kafka和zookeeper的更多相关文章

- Windows单机配置Kafka环境

首先确保机器已经安装好Zookeeper,Zookeeper安装参考 Windows单机配置Zookeeper环境 然后确保Zookeeper是正常启动状态 下载Kafka http://kafka. ...

- centOS7安装kafka和zookeeper

wget http://mirrors.hust.edu.cn/apache/kafka/2.0.0/kafka_2.11-2.0.0.tgz tar zxvf kafka_2.-.tgz cd ka ...

- Kafka单机配置部署

摘要:上节 学习了Kafka的理论知识,这里安装单机版以便后续的测试. 首先安装jdk 一.单机部署zk 1.1安装: tar -zxf zookeeper-3.4.10.tar.gz -C /opt ...

- 使用kafka bin目录中的zookeeper-shell.sh来查看kafka在zookeeper中的配置

cd kafka_2.11-0.10.2.1\bin\windowsecho ls /brokers/ids | zookeeper-shell.bat localhost:2181 使用kafka ...

- hadoop+yarn+hbase+storm+kafka+spark+zookeeper)高可用集群详细配置

配置 hadoop+yarn+hbase+storm+kafka+spark+zookeeper 高可用集群,同时安装相关组建:JDK,MySQL,Hive,Flume 文章目录 环境介绍 节点介绍 ...

- kafka与zookeeper

kafka简介 kafka (官网地址:http://kafka.apache.org)是一款分布式消息发布和订阅的系统,具有高性能和高吞吐率. 下载地址:http://kafka.apache.or ...

- centos7单机安装kafka,进行生产者消费者测试

[转载请注明]: 原文出处:https://www.cnblogs.com/jstarseven/p/11364852.html 作者:jstarseven 码字挺辛苦的..... 一.k ...

- linux单机部署kafka(filebeat+elk组合)

filebeat+elk组合之kafka单机部署 准备: kafka下载链接地址:http://kafka.apache.org/downloads.html 在这里下载kafka_2.12-2.10 ...

- Java面试题(Kafka篇+zookeeper 篇)

Kafka 152.kafka 可以脱离 zookeeper 单独使用吗?为什么? kafka 不能脱离 zookeeper 单独使用,因为 kafka 使用 zookeeper 管理和协调 kafk ...

随机推荐

- javaScript(6)---流程控制语句

学习要点: 1.语句的定义 2.if 语句 3.switch语句 4.do...while语句 5.while语句 6.for语句 7.for...in语句 8.break和continue语句 9. ...

- Linux的pwd命令详解

在Linux层次结构中,用户可以在被授权的任意目录下利用mkdir命令创建新目录,也可以利用cd命令从一个目录转换到另一个目录.然而,没有提示符来告知用户目前处于哪一个目录中.想要知道当前所处的目录, ...

- 关于国际化时报org.springframework.context.NoSuchMessageException错,具体到No message found under code '你的键名' for locale 'zh_CN'.的解决方案

使用IntelliJ IDEA开发工具解决方案: 总结原因,解决方案: 1,在使用messageSource.getMessage方法时,参数1的键名跟属性文件中键名不一致,比如Controller中 ...

- mac上php版本切换

目标:Mac 环境下完成 php 版本之间的切换 在本地开发中很多时候我们需要多个版本的 php 开发环境.在公司中习惯用自己电脑开发的伙伴们,常常因为公司线上环境被迫更换php版本.但有不想降低自己 ...

- nginx配置 location及rewrite规则详解

1. location正则写法 语法规则: location [=|~|~*|^~] /uri/ { … } = 开头表示精确匹配 ^~ 开头表示uri以某个常规字符串开头,理解为匹配 url ...

- 关于前端本地压缩图片,兼容IOS/Android/PC且自动按需加载文件之lrz.bundle.js

一.介绍说明主要特点: ①在前端压缩好要上传的图片可以更快的发送给后端,因此也特别适合在移动设备上使用. ②兼容IOS/Android,修复了IOS/Android某些版本已知的BUG. ③按需加载文 ...

- ScalaPB(2): 在scala中用gRPC实现微服务

gRPC是google开源提供的一个RPC软件框架,它的特点是极大简化了传统RPC的开发流程和代码量,使用户可以免除许多陷阱并聚焦于实际应用逻辑中.作为一种google的最新RPC解决方案,gRPC具 ...

- Java基础系列--桶排序

原创作品,可以转载,但是请标注出处地址:http://www.cnblogs.com/V1haoge/p/9045967.html 1.算法简介 桶排序可以算是最简单快速的排序算法了,只是限定条件要多 ...

- 【转】深入理解margin

由浅入深漫谈margin属性 2007-3-18 上午 - HTML/CSS/XML/XSL - CSS - margin margin 在中文中我们翻译成外边距或者外补白(本文中引用外边距).他是元 ...

- 向Oracle数据库插入中文乱码解决方法

解决方法: 第一步:sqlplus下执行:select userenv('language') from dual;//查看oracle字符集 注:如果oracle字符集与后台代码设置的 ...