PCL关键点(1)

关键点也称为兴趣点,它是2D图像或是3D点云或者曲面模型上,可以通过定义检测标准来获取的具有稳定性,区别性的点集,从技术上来说,关键点的数量相比于原始点云或图像的数据量减小很多,与局部特征描述子结合在一起,组成关键点描述子常用来形成原始数据的表示,而且不失代表性和描述性,从而加快了后续的识别,追踪等对数据的处理了速度,故而,关键点技术成为在2D和3D 信息处理中非常关键的技术

NARF(Normal Aligned Radial Feature)关键点是为了从深度图像中识别物体而提出的,对NARF关键点的提取过程有以下要求:

a) 提取的过程考虑边缘以及物体表面变化信息在内;

b)在不同视角关键点可以被重复探测;

c)关键点所在位置有足够的支持区域,可以计算描述子和进行唯一的估计法向量。

其对应的探测步骤如下:

(1) 遍历每个深度图像点,通过寻找在近邻区域有深度变化的位置进行边缘检测。

(2) 遍历每个深度图像点,根据近邻区域的表面变化决定一测度表面变化的系数,及变化的主方向。

(3) 根据step(2)找到的主方向计算兴趣点,表征该方向和其他方向的不同,以及该处表面的变化情况,即该点有多稳定。

(4) 对兴趣值进行平滑滤波。

(5) 进行无最大值压缩找到的最终关键点,即为NARF关键点。

关于NARF的更为具体的描述请查看这篇博客www.cnblogs.com/ironstark/p/5051533.html。

PCL中keypoints模块及类的介绍

(1)class pcl::Keypoint<PointInT,PointOutT> 类keypoint是所有关键点检测相关类的基类,定义基本接口,具体实现由子类来完成,其继承关系时下图:

具体介绍:

Public Member Functions |

|

| virtual void | setSearchSurface (const PointCloudInConstPtr &cloud) |

| 设置搜索时所用搜索点云,cloud为指向点云对象的指针引用 | |

| void | setSearchMethod (const KdTreePtr &tree) 设置内部算法实现时所用的搜索对象,tree为指向kdtree或者octree对应的指针 |

| void | setKSearch (int k) 设置K近邻搜索时所用的K参数 |

| void | setRadiusSearch (double radius) 设置半径搜索的半径的参数 |

| int | searchForNeighbors (int index, double parameter, std::vector< int > &indices, std::vector< float > &distances) const |

|

采用setSearchMethod设置搜索对象,以及setSearchSurface设置搜索点云,进行近邻搜索,返回近邻在点云中的索引向量, indices以及对应的距离向量distance其中为查询点的索引,parameter为搜索时所用的参数半径或者K |

|

(2)class pcl::HarrisKeypoint2D<PointInT,PointOutT,IntensityT>

类HarrisKeypoint2D实现基于点云的强度字段的harris关键点检测子,其中包括多种不同的harris关键点检测算法的变种,其关键函数的说明如下:

Public Member Functions |

|

| HarrisKeypoint2D (ResponseMethod method=HARRIS, int window_width=3, int window_height=3, int min_distance=5, float threshold=0.0) | |

| 重构函数,method需要设置采样哪种关键点检测方法,有HARRIS,NOBLE,LOWE,WOMASI四种方法,默认为HARRIS,window_width window_height为检测窗口的宽度和高度min_distance 为两个关键点之间 容许的最小距离,threshold为判断是否为关键点的感兴趣程度的阀值,小于该阀值的点忽略,大于则认为是关键点 | |

| void | setMethod (ResponseMethod type)设置检测方式 |

| void | setWindowWidth (int window_width) 设置检测窗口的宽度 |

| void | setWindowHeight (int window_height) 设置检测窗口的高度 |

| void | setSkippedPixels (int skipped_pixels) 设置在检测时每次跳过的像素的数目 |

| void | setMinimalDistance (int min_distance) 设置候选关键点之间的最小距离 |

| void | setThreshold (float threshold) 设置感兴趣的阀值 |

| void | setNonMaxSupression (bool=false) 设置是否对小于感兴趣阀值的点进行剔除,如果是true则剔除,否则返回这个点 |

| void | setRefine (bool do_refine)设置是否对所得的关键点结果进行优化, |

| void | setNumberOfThreads (unsigned int nr_threads=0) 设置该算法如果采用openMP并行机制,能够创建线程数目 |

(3)pcl::HarrisKeypoint3D< PointInT, PointOutT, NormalT >

类HarrisKeypoint3D和HarrisKeypoint2D类似,但是没有在点云的强度空间检测关键点,而是利用点云的3D空间的信息表面法线向量来进行关键点检测,关于HarrisKeypoint3D的类与HarrisKeypoint2D相似,除了

HarrisKeypoint3D (ResponseMethod method=HARRIS, float radius=0.01f, float threshold=0.0f)

重构函数,method需要设置采样哪种关键点检测方法,有HARRIS,NOBLE,LOWE,WOMASI四种方法,默认为HARRIS,radius为法线估计的搜索半径,threshold为判断是否为关键点的感兴趣程度的阀值,小于该阀值的点忽略,大于则认为是关键点。

(4)pcl::HarrisKeypoint6D< PointInT, PointOutT, NormalT >

类HarrisKeypoint6D和HarrisKeypoint2D类似,只是利用了欧式空间域XYZ或者强度域来候选关键点,或者前两者的交集,即同时满足XYZ域和强度域的关键点为候选关键点,

HarrisKeypoint6D (float radius=0.01, float threshold=0.0) 重构函数,此处并没有方法选择的参数,而是默认采用了Tomsai提出的方法实现关键点的检测,radius为法线估计的搜索半径,threshold为判断是否为关键点的感兴趣程度的阀值,小于该阀值的点忽略,大于则认为是关键点。

(5)pcl::SIFTKeypoint< PointInT, PointOutT >

类SIFTKeypoint是将二维图像中的SIFT算子调整后移植到3D空间的SIFT算子的实现,输入带有XYZ坐标值和强度的点云,输出为点云中的SIFT关键点,其关键函数的说明如下:

| void | setScales (float min_scale, int nr_octaves, int nr_scales_per_octave) |

| 设置搜索时与尺度相关的参数,min_scale在点云体素尺度空间中标准偏差,点云对应的体素栅格中的最小尺寸 | |

| int nr_octaves是检测关键点时体素空间尺度的数目,nr_scales_per_octave为在每一个体素空间尺度下计算高斯空间的尺度所需要的参数 | |

| void | setMinimumContrast (float min_contrast) 设置候选关键点对应的对比度下限 |

(6)还有很多不再一一介绍

实例分析

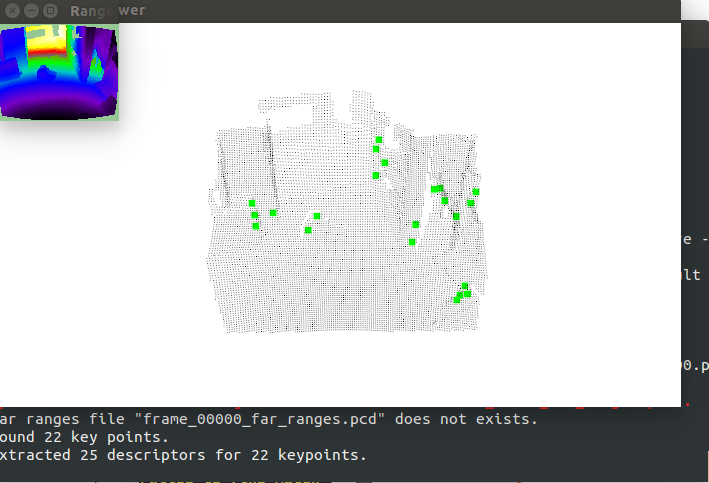

实验实现提取NARF关键点,并且用图像和3D显示的方式进行可视化,可以直观的观察关键点的位置和数量 narf_feature_extraction.cpp:

#include <iostream> #include <boost/thread/thread.hpp>

#include <pcl/range_image/range_image.h>

#include <pcl/io/pcd_io.h>

#include <pcl/visualization/range_image_visualizer.h>

#include <pcl/visualization/pcl_visualizer.h>

#include <pcl/features/range_image_border_extractor.h>

#include <pcl/keypoints/narf_keypoint.h>

#include <pcl/features/narf_descriptor.h>

#include <pcl/console/parse.h> typedef pcl::PointXYZ PointType; // --------------------

// -----Parameters-----

// --------------------

float angular_resolution = 0.5f; ////angular_resolution为模拟的深度传感器的角度分辨率,即深度图像中一个像素对应的角度大小

float support_size = 0.2f; //点云大小的设置

pcl::RangeImage::CoordinateFrame coordinate_frame = pcl::RangeImage::CAMERA_FRAME; //设置坐标系

bool setUnseenToMaxRange = false;

bool rotation_invariant = true; // --------------

// -----Help-----

// --------------

void

printUsage (const char* progName)

{

std::cout << "\n\nUsage: "<<progName<<" [options] <scene.pcd>\n\n"

<< "Options:\n"

<< "-------------------------------------------\n"

<< "-r <float> angular resolution in degrees (default "<<angular_resolution<<")\n"

<< "-c <int> coordinate frame (default "<< (int)coordinate_frame<<")\n"

<< "-m Treat all unseen points to max range\n"

<< "-s <float> support size for the interest points (diameter of the used sphere - "

"default "<<support_size<<")\n"

<< "-o <0/1> switch rotational invariant version of the feature on/off"

<< " (default "<< (int)rotation_invariant<<")\n"

<< "-h this help\n"

<< "\n\n";

} void

setViewerPose (pcl::visualization::PCLVisualizer& viewer, const Eigen::Affine3f& viewer_pose) //设置视口的位姿

{

Eigen::Vector3f pos_vector = viewer_pose * Eigen::Vector3f (, , ); //视口的原点pos_vector

Eigen::Vector3f look_at_vector = viewer_pose.rotation () * Eigen::Vector3f (, , ) + pos_vector; //旋转+平移look_at_vector

Eigen::Vector3f up_vector = viewer_pose.rotation () * Eigen::Vector3f (, -, ); //up_vector

viewer.setCameraPosition (pos_vector[], pos_vector[], pos_vector[], //设置照相机的位姿

look_at_vector[], look_at_vector[], look_at_vector[],

up_vector[], up_vector[], up_vector[]);

} // --------------

// -----Main-----

// --------------

int

main (int argc, char** argv)

{

// --------------------------------------

// -----Parse Command Line Arguments-----

// --------------------------------------

if (pcl::console::find_argument (argc, argv, "-h") >= )

{

printUsage (argv[]);

return ;

}

if (pcl::console::find_argument (argc, argv, "-m") >= )

{

setUnseenToMaxRange = true;

cout << "Setting unseen values in range image to maximum range readings.\n";

}

if (pcl::console::parse (argc, argv, "-o", rotation_invariant) >= )

cout << "Switching rotation invariant feature version "<< (rotation_invariant ? "on" : "off")<<".\n";

int tmp_coordinate_frame;

if (pcl::console::parse (argc, argv, "-c", tmp_coordinate_frame) >= )

{

coordinate_frame = pcl::RangeImage::CoordinateFrame (tmp_coordinate_frame);

cout << "Using coordinate frame "<< (int)coordinate_frame<<".\n";

}

if (pcl::console::parse (argc, argv, "-s", support_size) >= )

cout << "Setting support size to "<<support_size<<".\n";

if (pcl::console::parse (argc, argv, "-r", angular_resolution) >= )

cout << "Setting angular resolution to "<<angular_resolution<<"deg.\n";

angular_resolution = pcl::deg2rad (angular_resolution); // ------------------------------------------------------------------

// -----Read pcd file or create example point cloud if not given-----

// ------------------------------------------------------------------

pcl::PointCloud<PointType>::Ptr point_cloud_ptr (new pcl::PointCloud<PointType>);

pcl::PointCloud<PointType>& point_cloud = *point_cloud_ptr;

pcl::PointCloud<pcl::PointWithViewpoint> far_ranges;

Eigen::Affine3f scene_sensor_pose (Eigen::Affine3f::Identity ());

std::vector<int> pcd_filename_indices = pcl::console::parse_file_extension_argument (argc, argv, "pcd");

if (!pcd_filename_indices.empty ())

{

std::string filename = argv[pcd_filename_indices[]];

if (pcl::io::loadPCDFile (filename, point_cloud) == -)

{

cerr << "Was not able to open file \""<<filename<<"\".\n";

printUsage (argv[]);

return ;

}

scene_sensor_pose = Eigen::Affine3f (Eigen::Translation3f (point_cloud.sensor_origin_[], //场景传感器的位置

point_cloud.sensor_origin_[],

point_cloud.sensor_origin_[])) *

Eigen::Affine3f (point_cloud.sensor_orientation_);

std::string far_ranges_filename = pcl::getFilenameWithoutExtension (filename)+"_far_ranges.pcd";

if (pcl::io::loadPCDFile (far_ranges_filename.c_str (), far_ranges) == -)

std::cout << "Far ranges file \""<<far_ranges_filename<<"\" does not exists.\n";

}

else

{

setUnseenToMaxRange = true;

cout << "\nNo *.pcd file given => Genarating example point cloud.\n\n";

for (float x=-0.5f; x<=0.5f; x+=0.01f)

{

for (float y=-0.5f; y<=0.5f; y+=0.01f)

{

PointType point; point.x = x; point.y = y; point.z = 2.0f - y;

point_cloud.points.push_back (point);

}

}

point_cloud.width = (int) point_cloud.points.size (); point_cloud.height = ;

} // -----------------------------------------------

// -----Create RangeImage from the PointCloud-----

// -----------------------------------------------

float noise_level = 0.0;

float min_range = 0.0f;

int border_size = ;

boost::shared_ptr<pcl::RangeImage> range_image_ptr (new pcl::RangeImage);

pcl::RangeImage& range_image = *range_image_ptr;

range_image.createFromPointCloud (point_cloud, angular_resolution, pcl::deg2rad (360.0f), pcl::deg2rad (180.0f),

scene_sensor_pose, coordinate_frame, noise_level, min_range, border_size);

range_image.integrateFarRanges (far_ranges);

if (setUnseenToMaxRange)

range_image.setUnseenToMaxRange (); // --------------------------------------------

// -----Open 3D viewer and add point cloud-----

// --------------------------------------------

pcl::visualization::PCLVisualizer viewer ("3D Viewer");

viewer.setBackgroundColor (, , );

pcl::visualization::PointCloudColorHandlerCustom<pcl::PointWithRange> range_image_color_handler (range_image_ptr, , , );

viewer.addPointCloud (range_image_ptr, range_image_color_handler, "range image");

viewer.setPointCloudRenderingProperties (pcl::visualization::PCL_VISUALIZER_POINT_SIZE, , "range image");

//viewer.addCoordinateSystem (1.0f, "global");

//PointCloudColorHandlerCustom<PointType> point_cloud_color_handler (point_cloud_ptr, 150, 150, 150);

//viewer.addPointCloud (point_cloud_ptr, point_cloud_color_handler, "original point cloud");

viewer.initCameraParameters ();

setViewerPose (viewer, range_image.getTransformationToWorldSystem ()); // --------------------------

// -----Show range image-----

// --------------------------

pcl::visualization::RangeImageVisualizer range_image_widget ("Range image");

range_image_widget.showRangeImage (range_image);

/*********************************************************************************************************

创建RangeImageBorderExtractor对象,它是用来进行边缘提取的,因为NARF的第一步就是需要探测出深度图像的边缘, *********************************************************************************************************/

// --------------------------------

// -----Extract NARF keypoints-----

// --------------------------------

pcl::RangeImageBorderExtractor range_image_border_extractor; //用来提取边缘

pcl::NarfKeypoint narf_keypoint_detector; //用来检测关键点

narf_keypoint_detector.setRangeImageBorderExtractor (&range_image_border_extractor); //

narf_keypoint_detector.setRangeImage (&range_image);

narf_keypoint_detector.getParameters ().support_size = support_size; //设置NARF的参数 pcl::PointCloud<int> keypoint_indices;

narf_keypoint_detector.compute (keypoint_indices);

std::cout << "Found "<<keypoint_indices.points.size ()<<" key points.\n"; // ----------------------------------------------

// -----Show keypoints in range image widget-----

// ----------------------------------------------

//for (size_t i=0; i<keypoint_indices.points.size (); ++i)

//range_image_widget.markPoint (keypoint_indices.points[i]%range_image.width,

//keypoint_indices.points[i]/range_image.width); // -------------------------------------

// -----Show keypoints in 3D viewer-----

// -------------------------------------

pcl::PointCloud<pcl::PointXYZ>::Ptr keypoints_ptr (new pcl::PointCloud<pcl::PointXYZ>); pcl::PointCloud<pcl::PointXYZ>& keypoints = *keypoints_ptr; keypoints.points.resize (keypoint_indices.points.size ());

for (size_t i=; i<keypoint_indices.points.size (); ++i) keypoints.points[i].getVector3fMap () = range_image.points[keypoint_indices.points[i]].getVector3fMap ();

pcl::visualization::PointCloudColorHandlerCustom<pcl::PointXYZ> keypoints_color_handler (keypoints_ptr, , , );

viewer.addPointCloud<pcl::PointXYZ> (keypoints_ptr, keypoints_color_handler, "keypoints");

viewer.setPointCloudRenderingProperties (pcl::visualization::PCL_VISUALIZER_POINT_SIZE, , "keypoints"); // ------------------------------------------------------

// -----Extract NARF descriptors for interest points-----

// ------------------------------------------------------

std::vector<int> keypoint_indices2;

keypoint_indices2.resize (keypoint_indices.points.size ());

for (unsigned int i=; i<keypoint_indices.size (); ++i) // This step is necessary to get the right vector type

keypoint_indices2[i]=keypoint_indices.points[i];

pcl::NarfDescriptor narf_descriptor (&range_image, &keypoint_indices2);

narf_descriptor.getParameters ().support_size = support_size;

narf_descriptor.getParameters ().rotation_invariant = rotation_invariant;

pcl::PointCloud<pcl::Narf36> narf_descriptors;

narf_descriptor.compute (narf_descriptors);

cout << "Extracted "<<narf_descriptors.size ()<<" descriptors for "

<<keypoint_indices.points.size ()<< " keypoints.\n"; //--------------------

// -----Main loop-----

//--------------------

while (!viewer.wasStopped ())

{

range_image_widget.spinOnce (); // process GUI events

viewer.spinOnce ();

pcl_sleep(0.01);

}

}

运行结果:

未完待续**********************88888

有兴趣这可以扫描下面的二维码关注公众号与我交流,

PCL关键点(1)的更多相关文章

- PCL—关键点检测(iss&Trajkovic)低层次点云处理

博客转载自:http://www.cnblogs.com/ironstark/p/5069311.html 关键点检测往往需要和特征提取联合在一起,关键点检测的一个重要性质就是旋转不变性,也就是说,物 ...

- PCL—关键点检测(rangeImage)低层次点云处理

博客转载自:http://www.cnblogs.com/ironstark/p/5046479.html 关键点又称为感兴趣的点,是低层次视觉通往高层次视觉的捷径,抑或是高层次感知对低层次处理手段的 ...

- PCL—关键点检测(Harris)低层次点云处理

博客转载自:http://www.cnblogs.com/ironstark/p/5064848.html 除去NARF这种和特征检测联系比较紧密的方法外,一般来说特征检测都会对曲率变化比较剧烈的点更 ...

- PCL—关键点检测(NARF)低层次点云处理

博客转载自:http://www.cnblogs.com/ironstark/p/5051533.html 关键点检测本质上来说,并不是一个独立的部分,它往往和特征描述联系在一起,再将特征描述和识别. ...

- PCL—低层次视觉—关键点检测(rangeImage)

关键点又称为感兴趣的点,是低层次视觉通往高层次视觉的捷径,抑或是高层次感知对低层次处理手段的妥协. ——三维视觉关键点检测 1.关键点,线,面 关键点=特征点: 关键线=边缘: 关键面=foregro ...

- PCL—低层次视觉—关键点检测(iss&Trajkovic)

关键点检测往往需要和特征提取联合在一起,关键点检测的一个重要性质就是旋转不变性,也就是说,物体旋转后还能够检测出对应的关键点.不过说实话我觉的这个要求对机器人视觉来说是比较鸡肋的.因为机器人采集到的三 ...

- PCL—低层次视觉—关键点检测(NARF)

关键点检测本质上来说,并不是一个独立的部分,它往往和特征描述联系在一起,再将特征描述和识别.寻物联系在一起.关键点检测可以说是通往高层次视觉的重要基础.但本章节仅在低层次视觉上讨论点云处理问题,故所有 ...

- PCL—低层次视觉—关键点检测(Harris)

除去NARF这种和特征检测联系比较紧密的方法外,一般来说特征检测都会对曲率变化比较剧烈的点更敏感.Harris算法是图像检测识别算法中非常重要的一个算法,其对物体姿态变化鲁棒性好,对旋转不敏感,可以很 ...

- [CC]Plugin-提取ISS3D关键点

基于CloudCompare开发的提取ISS3D关键点. void qLxPluginPCL::doISS3D() { assert(m_app); if (!m_app) return; const ...

随机推荐

- 大家来找茬:富连网今天中午抢购二手iPhone时网站无法访问的问题

前几天在新闻区看到富士康卖二手iPhone的新闻,今天又看到说今天中午12点开抢.一大早就发现富连网无法访问了.前几天刚看到新闻的时候注册了个账号进去看了看,发现页面加载速度非常慢,今天中午基本无法打 ...

- sql server中根据地图经纬度算距离

从别的地方烤过来的,自己试了一下,可以计算 出来,不过正确不正确的就不太懂了. USE [niaoren]GO/****** Object: UserDefinedFunction [dbo].[f ...

- 【Unity】2.6 游戏视图(Game)

分类:Unity.C#.VS2015 创建日期:2016-03-29 一.简介 游戏视图 (Game View) 从游戏的相机 ((Camera(s)) 中呈现,代表所发布游戏的最终版.你将需要一台或 ...

- HTML5基础小结(二)——标签小例

watermark/2/text/aHR0cDovL2Jsb2cuY3Nkbi5uZXQvbGl1amlhaGFuNjI5NjI5/font/5a6L5L2T/fontsize/400/fill/I0 ...

- Robolectric使用教程

转载请标明出处:http://blog.csdn.net/shensky711/article/details/53561172 本文出自: [HansChen的博客] 概述 怎样使用 为项目加入依赖 ...

- tar.xz文件格式的压缩与解压

从网上下载了一个man的安装文件,格式为tar.xz,默认下载到当前目录下 //下载man源码并以原文件名保存,如果要指定保存的文件名用小写-o name指定 curl -O https://www. ...

- git mergetool 解决冲突的问题

git mergetool http://blog.csdn.net/u012150179/article/details/14047183

- c++11实现c++14的optional

c++14中将包含一个std::optional类,它的功能和用法和boost的optional类似.optional<T>内部存储空间可能存储了T类型的值也可能没有存储T类型的值,只有当 ...

- 每天一个linux命令(2):file 命令

作用:查看文件类型信息 格式:file[OPTIONS...] [FILE...] 主要参数: --help 显示帮助信息 -v,--version 输出版本信息并退出 -b,--brief ...

- android使用POI读写word doc文件

目录 1 读word doc文件 1.1 通过WordExtractor读文件 1.2 通过HWPFDocument读文件 2 写word doc文件 Apache p ...