hadoop NameNode 手动HA

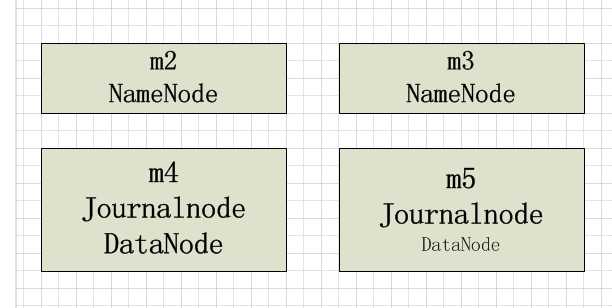

HDFS HA主要是通过Quorum Journal Manager (QJM)在Active NameNode和Standby NameNode之间共享edit logs

hdfs-site.xml的配置

dfs.nameservices - nameservice的逻辑名称,可以是任意的名称,此处配置为cluster

<property>

<name>dfs.nameservices</name>

<value>cluster</value>

</property>

dfs.ha.namenodes.[nameservice ID] - 配置nameservice中的每一个NameNode, NameNode的个数建议不超过5个,最好是3个,此处配置两个

<property>

<name>dfs.ha.namenodes.cluster</name>

<value>nn1,nn2</value>

</property>

dfs.namenode.rpc-address.[nameservice ID].[name node ID] - 配置NameNode的RPC具体地址,m2和m3为主机名

<property>

<name>dfs.namenode.rpc-address.cluster.nn1</name>

<value>m2:9820</value>

</property>

<property>

<name>dfs.namenode.rpc-address.cluster.nn2</name>

<value>m3:9820</value>

</property>

dfs.namenode.http-address.[nameservice ID].[name node ID] - 配置NameNode HTTP监听的地址

<property>

<name>dfs.namenode.http-address.cluster.nn1</name>

<value>m2:9870</value>

</property>

<property>

<name>dfs.namenode.http-address.cluster.nn2</name>

<value>m3:9870</value>

</property>

dfs.namenode.shared.edits.dir - 配置JournalNodes上NameNode读和写的edits文件URL地址,URL格式: qjournal://*host1:port1*;*host2:port2*;*host3:port3*/*journalId*.

<property>

<name>dfs.namenode.shared.edits.dir</name>

<value>qjournal://m4:8485;m5:8485;/mycluster</value>

</property>

dfs.client.failover.proxy.provider.[nameservice ID] - HDFS客户端联系Active NameNode的java类

<property>

<name>dfs.client.failover.proxy.provider.cluster</name>

<value>org.apache.hadoop.hdfs.server.namenode.ha.ConfiguredFailoverProxyPr

ovider</value>

</property>

dfs.ha.fencing.methods - 防止脑裂,两种方法,此处使用shell 这种方法

<property>

<name>dfs.ha.fencing.methods</name>

<value>shell(shell(/bin/true))</value>

</property>

dfs.journalnode.edits.dir - JournalNode存储本地状态的路径

<property>

<name>dfs.journalnode.edits.dir</name>

<value>/home/hadoop/app/hadoop-2.7.3/journalnode/data</value>

</property>

core-site.xml配置

<property>

<name>fs.defaultFS</name>

<value>hdfs://cluster</value>

</property> <property>

<name>hadoop.tmp.dir</name>

<value>/home/hadoop/app/hadoop-2.7.3/tmp/data</value>

</property>

至此配置已经结束,接下来启动集群。

1、首先启动journalnode,通过./hadoop-daemon.sh start journalnode命令启动journalnode(m4, m5节点)

jps:可以发现JournalNode进程

2、通过hdfs namenode -format命令初始化集群,格式化完成后拷贝元数据到另外一个namenode节点上

3、启动hadoop集群start-dfs.sh

4、通过hdfs haadmin手动切换namenode是否为active

hadoop NameNode 手动HA的更多相关文章

- 通过tarball形式安装HBASE Cluster(CDH5.0.2)——Hadoop NameNode HA 切换引起的Hbase错误,以及Hbase如何基于NameNode的HA进行配置

通过tarball形式安装HBASE Cluster(CDH5.0.2)——Hadoop NameNode HA 切换引起的Hbase错误,以及Hbase如何基于NameNode的HA进行配置 配置H ...

- hadoop namenode HA集群搭建

hadoop集群搭建(namenode是单点的) http://www.cnblogs.com/kisf/p/7456290.html HA集群需要zk, zk搭建:http://www.cnblo ...

- Hadoop记录-Hadoop NameNode 高可用 (High Availability) 实现解析

Hadoop NameNode 高可用 (High Availability) 实现解析 NameNode 高可用整体架构概述 在 Hadoop 1.0 时代,Hadoop 的两大核心组件 HDF ...

- Hadoop 高可用(HA)的自动容灾配置

参考链接 Hadoop 完全分布式安装 ZooKeeper 集群的安装部署 0. 说明 在 Hadoop 完全分布式安装 & ZooKeeper 集群的安装部署的基础之上进行 Hadoop 高 ...

- 大数据入门第十天——hadoop高可用HA

一.HA概述 1.引言 正式引入HA机制是从hadoop2.0开始,之前的版本中没有HA机制 2.运行机制 实现高可用最关键的是消除单点故障 hadoop-ha严格来说应该分成各个组件的HA机制——H ...

- Hadoop NameNode 高可用 (High Availability) 实现解析

转载自:http://reb12345reb.iteye.com/blog/2306818 在 Hadoop 的整个生态系统中,HDFS NameNode 处于核心地位,NameNode 的可用性直接 ...

- Hadoop NameNode 高可用 (High Availability) 实现解析[转]

NameNode 高可用整体架构概述 在 Hadoop 1.0 时代,Hadoop 的两大核心组件 HDFS NameNode 和 JobTracker 都存在着单点问题,这其中以 NameNode ...

- 【转载】Hadoop NameNode 高可用 (High Availability) 实现解析

转载:https://www.ibm.com/developerworks/cn/opensource/os-cn-hadoop-name-node/ NameNode 高可用整体架构概述 在 Had ...

- NameNode的HA

HDFS中的NameNode的HA怎么实现?(一言以蔽之) 在Hadoop集群中配置并启动两个NameNode进程,一个作为Active节点对外提供服务,另一个作为Standby的节点,两个NameN ...

随机推荐

- 修改编码格式MySQL

修改字符集的方法,就是使用mysql的命令 mysql> SET character_set_client = utf8 ; mysql> SET character_set_connec ...

- 【转】用JIRA管理你的项目

原文地址:http://snowolf.iteye.com/blog/875529

- 开发基础框架:mybatis-3.2.8 +hibernate4.0+spring3.0+struts2.3

一:项目下载地址(点击 Source code(zip)) https://github.com/fzxblgong/frame_2014-12-15/releases 版本:v1.2大小:20M 二 ...

- PHP里用户密码的回复和管理

1). In /etc/my.ini, add skip-grant-tables 2). mysql -u root -p (no password required) mys ...

- 每天学点GDB14

在上一篇文章中讲到了ptrace,那么我们完全可以用ptrace来写一个非常简单的trace工具,用以trace程序的具体运行过程. 用它可以很清楚的回答,使用glibc编译后的hello world ...

- PHP正则表达式及实例

PHP正则表达式及实例 博客分类: Php / Pear / Mysql / Node.js 正则表达式PHPWordPressFPApache 关联: 正则表达式 去除连续空白 + 获取url + ...

- 腾讯星座运势api

请求地址: http://app.data.qq.com/?umod=astro&act=astro&jsonp=1&func=TodatTpl&t=4&a=t ...

- 设计和实现OLAP解决方案

设计和实现OLAP解决方案 第一讲 简介首先,啥叫数据仓库? 数据仓库就是数据的仓库!用外文说叫Data Warehouse,简称DW. 是不是哐当倒下一片啊,要不咱换个专业点的说法? 数据仓库是 ...

- wordpress页面前端添加编辑按钮

<?php edit_post_link(__('Edit This')); ?> 在single.php或者page.php模板页面加入以上代码片段.当管理员登录后,可以直接点击编辑文章 ...

- Python中Unicode字符串

Python中Unicode字符串 字符串还有一个编码问题. 因为计算机只能处理数字,如果要处理文本,就必须先把文本转换为数字才能处理.最早的计算机在设计时采用8个比特(bit)作为一个字节(byte ...