【MobileNet-V1】-2017-CVPR-MobileNets Efficient Convolutional Neural Networks for Mobile Vision Applications-论文阅读

2017-CVPR-MobileNets Efficient Convolutional Neural Networks for Mobile Vision Applications

- Andrew Howard、Hartwig Adam(Google)

- GitHub: 1.4k stars

- Citation:4203

Introduction

本文介绍了一种新的网络结构,MobileNet(V1),网络结构上与VGG类似,都属于流线型架构,但使用了新的卷积层——深度可分离卷积(depthwise separable convonlution)替换了原始的全卷积层,使得网络参数和计算量都大大减小,在0.12倍的计算量和0.14倍的参数量的情况下,精度仅下降1%,引入两个超参数(宽度乘数、分辨率乘数),可以方便的构建更小的MobileNet,在模型大小和精度之间平衡。属于网络压缩中的轻量化网络设计的方法。

Motivation

随着深度学习的流行,卷积网络的计算开销越来越大,因此人们开始寻找减少网络参数/计算量的方法,设计更高效的模型。

Contribution

轻量化网络(较小的计算开销和存储开销)主流的方法有两种

- 减少模型参数,既可以减少模型计算开销,也可减少模型存储开销

- 量化模型参数,可以减少存储开销

MobileNet使用深度可分离卷积来替代传统的全卷积,有效的地降低了模型参数量和计算量。

Method

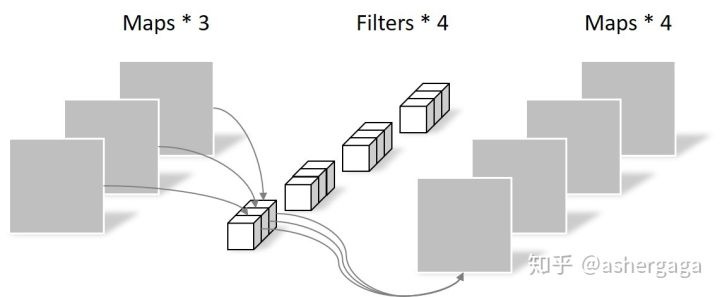

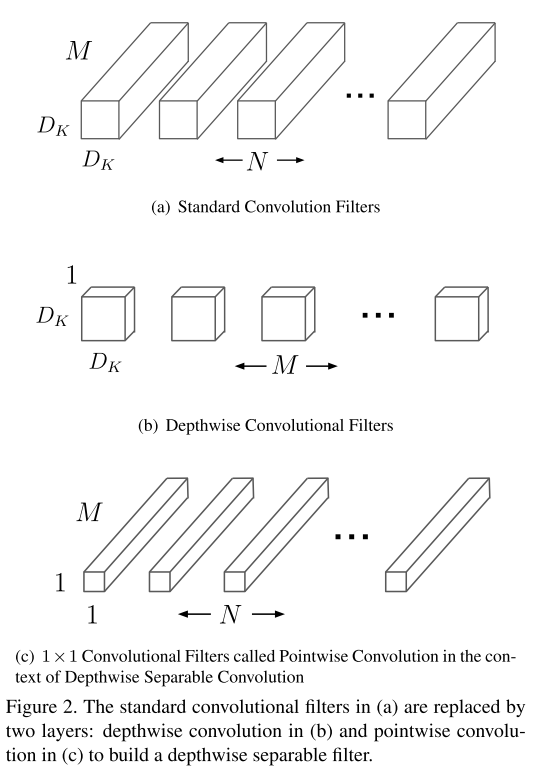

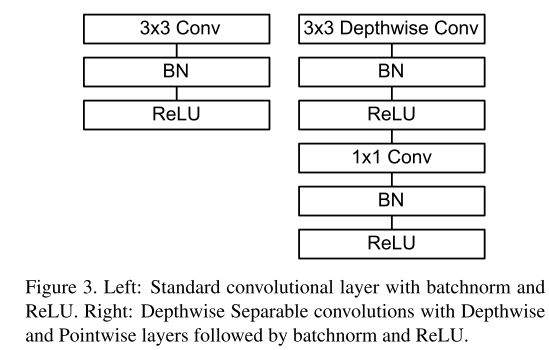

深度可分离卷积(depthwise separable convolution)

深度可分离卷积是MobileNet的核心。深度可分离卷积是因子卷积(将大卷积分解为小的卷积?)的一种,将标准的全卷积分解为通道深度卷积(depthwise convolution)+1x1逐点卷积(pointwise convolution);其中深度卷积是将同一个filter应用到所有的input channels上,点卷积是将1x1的卷积核,应用在深度卷积的output channels上。传统的conv是将滤波乘法(feature map元素乘法)和通道合并(将多个channels map整合成一个channels)两个步骤在一步完成;而深度可分离卷积是将两个步骤分开,一层用于滤波乘法,一层用于通道合并。

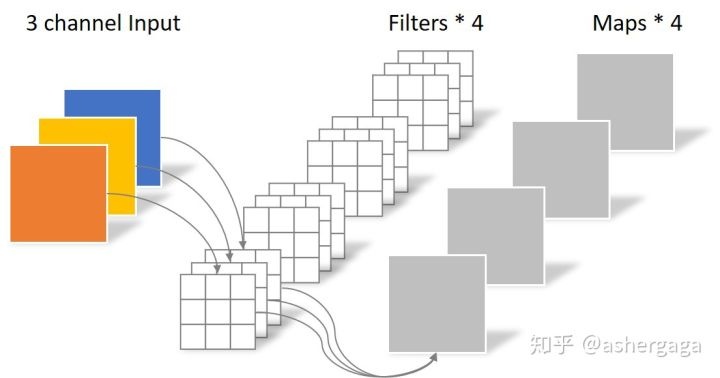

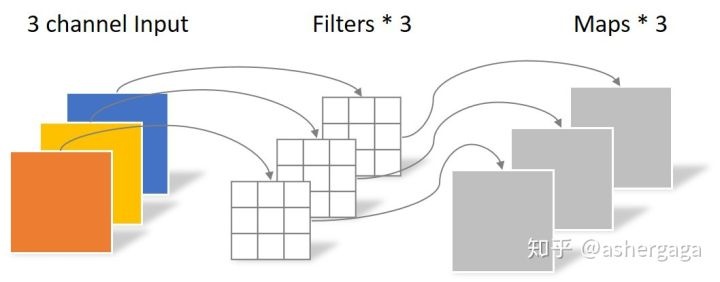

标准卷积:

通道卷积:

逐点卷积:

计算开销对比:

标准卷积的计算开销: \(D_{K} \cdot D_{K} \cdot M \cdot N \cdot D_{F} \cdot D_{F}\)

深度可分离卷积的计算开销: \(D_{K} \cdot D_{K} \cdot M \cdot D_{F} \cdot D_{F}+M \cdot N \cdot D_{F} \cdot D_{F}\)

&&计算开销的计算:参数数量×一个feature map的大小

计算开销对比: $\frac{D_{K} \cdot D_{K} \cdot M \cdot D_{F} \cdot D_{F}+M \cdot N \cdot D_{F} \cdot D_{F}}{D_{K} \cdot D_{K} \cdot M \cdot N \cdot D_{F} \cdot D_{F}} = \frac{1}{N}+\frac{1}{D_{K}^{2}} $

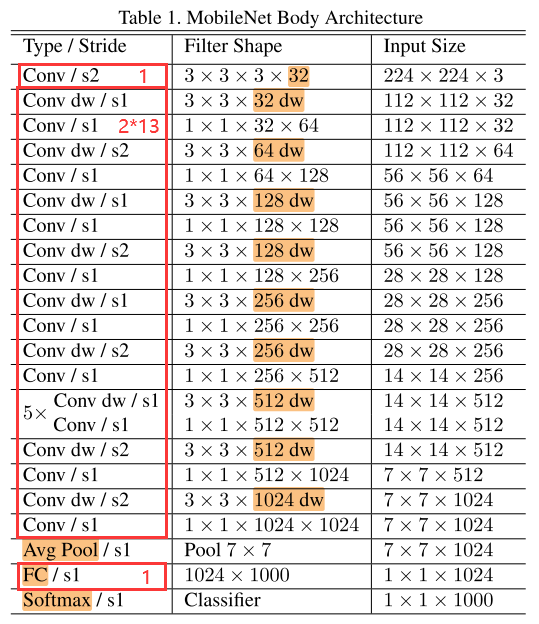

网络结构

MobileNet的除了第一个卷积层是标准卷积,其余的卷积层都是深度可分离卷积。

表1为MobileNet的网络结构,将通道卷积层和点卷积层看做单独的层,则MobileNet共有28层(1全卷积 + 2 × 13深度可分离卷积 + 1全连接 = 28)。

&&有参数的层才算入?

图3对比了标准卷积层和可分离卷积层(通道卷积层+逐点卷积层),每个卷积层后都跟着BN层和ReLU层。

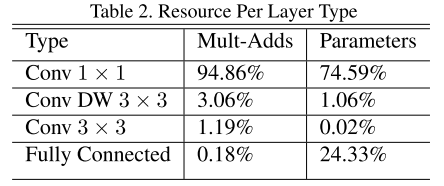

表2为MobileNet中不同类型的层的计算量和参数量对比:

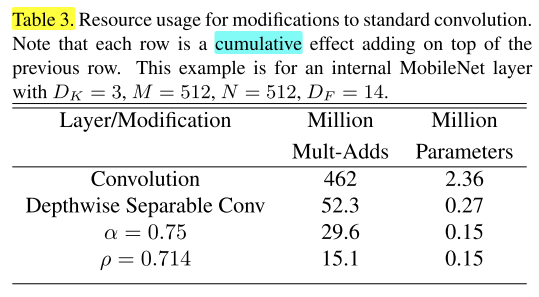

宽度乘数 \(\alpha\)(Width Multiplier)

为了构建更小的MobileNet,引入第一个超参数——Width Multiplier α,在α的作用下,网络的计算代价变为: \(D_{K} \cdot D_{K} \cdot \alpha M \cdot D_{F} \cdot D_{F}+\alpha M \cdot \alpha N \cdot D_{F} \cdot D_{F}\)

α的取值范围(0,1],取1时就是baseline MobileNet

应用宽度乘数可以将计算开销和存储开销变为为原来的 \(\alpha^2\) 倍

分辨率乘数 \(\rho\)(Resolution Multiplier)

分辨率乘数可以减小输入图片的分辨率,一般通过设置输入图片的分辨率来隐式地设置 \(\rho\)

同时应用宽度乘数和分辨率乘数,计算代价变为:

\(D_{K} \cdot D_{K} \cdot \alpha M \cdot \rho D_{F} \cdot \rho D_{F}+\alpha M \cdot \alpha N \cdot \rho D_{F} \cdot \rho D_{F}\)

其中,ρ∈(0, 1],通常隐式设置网络的输入分辨率为224、192、160或128。

应用宽度乘数可以将计算开销和存储开销变为为原来的 \(\rho^2\) 倍。

表3对比了全卷积、深度可分离卷积、应用了α和ρ的深度可分离卷积的模型的计算量和参数量:

Experiments

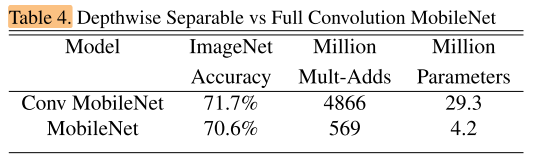

全卷积的MobileNet VS MobileNet:

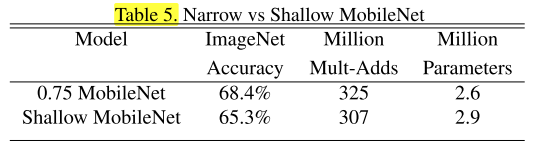

在相近的计算量下,瘦长的MobileNet 和 胖矮的MobileNet 的精度对比,瘦长的MobileNet效果更好,说明层数更重要(所以是使用宽度层数α,改变模型宽度,而不是减少模型的层数):

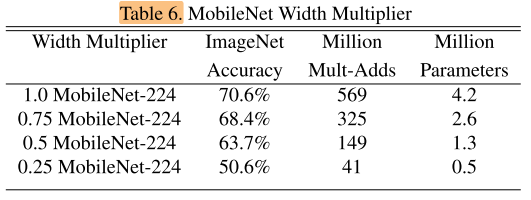

应用了宽度乘数α的MobileNet效果对比:

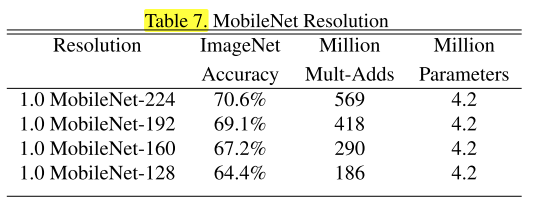

应用了分辨率乘数ρ(输入分辨率不同)的MobileNet效果对比:

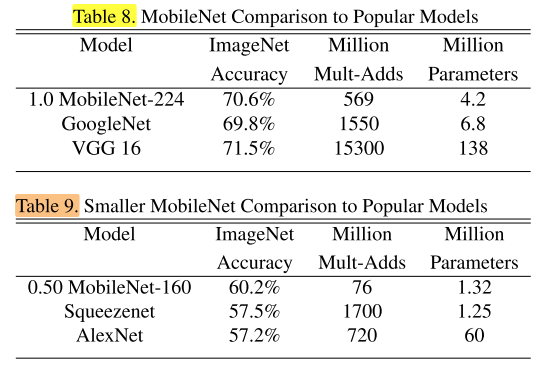

在ImageNet上与经典网络的对比:

在Stanford Dogs数据集上与经典网络的对比:

其他实验:

细粒度识别实验、大规模地理定位实验、Face Attributes实验、Object Detection实验、Face Embeddings实验

Conclusion

提出了新的轻量模型MobileNet,核心是使用深度可分离卷积代替标准全卷积,大大减少计算量和参数量

通过宽度乘数和分辨率乘数2个超参数很好的在baseline MobileNet的基础上构建更小的MobileNet模型

Summary

想法很简单,效果很好!

实验非常丰富!

Reference

【深度可分离卷积】https://zhuanlan.zhihu.com/p/92134485

【薰风读论文:MobileNet 详解深度可分离卷积,它真的又好又快吗?】https://zhuanlan.zhihu.com/p/80177088

【MobileNet-V1】-2017-CVPR-MobileNets Efficient Convolutional Neural Networks for Mobile Vision Applications-论文阅读的更多相关文章

- 【网络结构】MobileNets: Efficient Convolutional Neural Networks for Mobile Vision Applications论文解析

目录 0. Paper link 1. Overview 2. Depthwise Separable Convolution 2.1 architecture 2.2 computational c ...

- 【论文翻译】MobileNets: Efficient Convolutional Neural Networks for Mobile Vision Applications

MobileNets: Efficient Convolutional Neural Networks for Mobile Vision Applications 论文链接:https://arxi ...

- 深度学习论文翻译解析(十七):MobileNets: Efficient Convolutional Neural Networks for Mobile Vision Applications

论文标题:MobileNets: Efficient Convolutional Neural Networks for Mobile Vision Applications 论文作者:Andrew ...

- [论文阅读] MobileNets: Efficient Convolutional Neural Networks for Mobile Vision Applications (MobileNet)

论文地址:MobileNets: Efficient Convolutional Neural Networks for Mobile Vision Applications 本文提出的模型叫Mobi ...

- 论文笔记——MobileNets(Efficient Convolutional Neural Networks for Mobile Vision Applications)

论文地址:MobileNets: Efficient Convolutional Neural Networks for Mobile Vision Applications MobileNet由Go ...

- [论文理解] MobileNets: Efficient Convolutional Neural Networks for Mobile Vision Applications

MobileNets: Efficient Convolutional Neural Networks for Mobile Vision Applications Intro MobileNet 我 ...

- Paper | MobileNets: Efficient Convolutional Neural Networks for Mobile Vision Applications

目录 1. 故事 2. MobileNet 2.1 深度可分离卷积 2.2 网络结构 2.3 引入两个超参数 3. 实验 本文提出了一种轻量级结构MobileNets.其基础是深度可分离卷积操作. M ...

- MobileNets: Efficient Convolutional Neural Networks for Mobile Vision Applications

1. 摘要 作者提出了一系列应用于移动和嵌入式视觉的称之为 MobileNets 的高效模型,这些模型采用深度可分离卷积来构建轻量级网络. 作者还引入了两个简单的全局超参数来有效地权衡时延和准确率,以 ...

- 深度学习论文翻译解析(六):MobileNets:Efficient Convolutional Neural Networks for Mobile Vision Appliications

论文标题:MobileNets:Efficient Convolutional Neural Networks for Mobile Vision Appliications 论文作者:Andrew ...

随机推荐

- 对已经创建的docker container设置开机自启动

首先显示出所有的容器 docker ps -a #显示所有容器 设置已经建立的容器的开机自启动方法 docker update --restart=always <container ID 根据 ...

- CC2530ADC应用

ADC单通道外部电压采集 需要设置一个上机位命令控制字符. 系统时钟初始化——32MHZ晶振 串口0函数初始化——设置串口对应引脚,波特率,清楚中断标志 串口0接收中断响应函数——U0DBUF将控制命 ...

- Elasticsearch系列---Term Vector工具探查数据

概要 本篇主要介绍一个Term Vector的概念和基本使用方法. term vector是什么? 每次有document数据插入时,elasticsearch除了对document进行正排.倒排索引 ...

- SQL语言概况(4.1)

SQL语言概况(4.1) 目录 SQL语言概况(4.1) 4.1 SQL语言概况 4.1.1 历史及标准简介 4.1.2 SQL语言定义及特点 4.1.3 使用说明 参考资料: 数据库原理及设计(第3 ...

- webpack 和 webpack-cli 安装和使用中出现的问题

因为国内防火墙的原因,建议首先安装 cnpm: 使用 npm install cnpm -g 或者 npm install -g cnpm --registry=https://registry.np ...

- failed parsing overlays.

clearn + rebuild + 重新运行: 删掉模拟器进程 + 重新运行:

- 如何将Altera官方提供的CADENCE.OLB应用于altium Designer中

- python语法学习第一天--变量、运算符、数据类型

变量:计算机中的一块内存,给变量赋值意味着将值存入内存中 python中变量不用类型声明(根据赋的值决定类型),但使用时(创建时)必须赋值(=赋值). 多个变量的赋值: ①a=b=c=1; ②a,b, ...

- ReactNative报错:Can't find variable: __fbBatchedBridge

最近开始研究ReactNative,首先根据网上教程 http://www.codeceo.com/article/windows-react-native-android.html 一步一步来.完成 ...

- unittest详解 跳过用例的执行(skip)

在执行测试用例时,有时候有些用例是不需要执行的,那我们怎么办呢?难道删除这些用例?那下次执行时如果又需要执行这些用例时,又把它补回来?这样操作就太麻烦了. unittest提供了一些跳过指定用例的方法 ...