【Spark-core学习之四】 Spark任务提交

环境

虚拟机:VMware 10

Linux版本:CentOS-6.5-x86_64

客户端:Xshell4

FTP:Xftp4

jdk1.8

scala-2.10.4(依赖jdk1.8)

spark-1.6

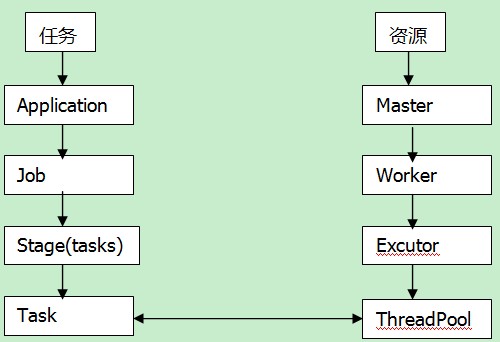

术语

Master(standalone):资源管理的主节点(进程)

Cluster Manager:在集群上获取资源的外部服务(例如standalone,Mesos,Yarn )

Worker Node(standalone):资源管理的从节点(进程) 或者说管理本机资源的进程

Application:基于Spark的⽤用户程序,包含了driver程序和运行在集群上的executor程序

Driver Program:用来连接工作进程(Worker)的程序

Executor:是在一个worker进程所管理的节点上为某Application启动的⼀一个进程,该进程负责运行任务,并且负责将数据存在内存或者磁盘上。每个应用都有各自独立的executors

Task:被送到某个executor上的工作单元

Job:包含很多任务(Task)的并行计算,可以看做和action对应

Stage:一个Job会被拆分很多组任务,每组任务被称为Stage(就像Mapreduce分map task和reduce task一样)

任务提交参数:

[root@PCS101 bin]# ./spark-submit

Usage: spark-submit [options] <app jar | python file> [app arguments]

Usage: spark-submit --kill [submission ID] --master [spark://...]

Usage: spark-submit --status [submission ID] --master [spark://...] Options:

--master MASTER_URL spark://host:port, mesos://host:port, yarn, or local.

--deploy-mode DEPLOY_MODE Whether to launch the driver program locally ("client") or

on one of the worker machines inside the cluster ("cluster")

(Default: client).

--class CLASS_NAME Your application's main class (for Java / Scala apps).

--name NAME A name of your application.

--jars JARS Comma-separated list of local jars to include on the driver

and executor classpaths.

--packages Comma-separated list of maven coordinates of jars to include

on the driver and executor classpaths. Will search the local

maven repo, then maven central and any additional remote

repositories given by --repositories. The format for the

coordinates should be groupId:artifactId:version.

--exclude-packages Comma-separated list of groupId:artifactId, to exclude while

resolving the dependencies provided in --packages to avoid

dependency conflicts.

--repositories Comma-separated list of additional remote repositories to

search for the maven coordinates given with --packages.

--py-files PY_FILES Comma-separated list of .zip, .egg, or .py files to place

on the PYTHONPATH for Python apps.

--files FILES Comma-separated list of files to be placed in the working

directory of each executor. --conf PROP=VALUE Arbitrary Spark configuration property.

--properties-file FILE Path to a file from which to load extra properties. If not

specified, this will look for conf/spark-defaults.conf. --driver-memory MEM Memory for driver (e.g. 1000M, 2G) (Default: 1024M).

--driver-java-options Extra Java options to pass to the driver.

--driver-library-path Extra library path entries to pass to the driver.

--driver-class-path Extra class path entries to pass to the driver. Note that

jars added with --jars are automatically included in the

classpath. --executor-memory MEM Memory per executor (e.g. 1000M, 2G) (Default: 1G). --proxy-user NAME User to impersonate when submitting the application. --help, -h Show this help message and exit

--verbose, -v Print additional debug output

--version, Print the version of current Spark Spark standalone with cluster deploy mode only:

--driver-cores NUM Cores for driver (Default: ). Spark standalone or Mesos with cluster deploy mode only:

--supervise If given, restarts the driver on failure.

--kill SUBMISSION_ID If given, kills the driver specified.

--status SUBMISSION_ID If given, requests the status of the driver specified. Spark standalone and Mesos only:

--total-executor-cores NUM Total cores for all executors. Spark standalone and YARN only:

--executor-cores NUM Number of cores per executor. (Default: in YARN mode,

or all available cores on the worker in standalone mode) YARN-only:

--driver-cores NUM Number of cores used by the driver, only in cluster mode

(Default: ).

--queue QUEUE_NAME The YARN queue to submit to (Default: "default").

--num-executors NUM Number of executors to launch (Default: ).

--archives ARCHIVES Comma separated list of archives to be extracted into the

working directory of each executor.

--principal PRINCIPAL Principal to be used to login to KDC, while running on

secure HDFS.

--keytab KEYTAB The full path to the file that contains the keytab for the

principal specified above. This keytab will be copied to

the node running the Application Master via the Secure

Distributed Cache, for renewing the login tickets and the

delegation tokens periodically.

--master

MASTER_URL, 可以是spark://host:port, mesos://host:port, yarn, yarn-cluster,yarn-client, local

--deploy-mode

DEPLOY_MODE, Driver程序运行的地方,client或者cluster,默认是client。

--class

CLASS_NAME, 主类名称,含包名

--jars

逗号分隔的本地JARS, Driver和executor依赖的第三方jar包

--files

用逗号隔开的文件列表,会放置在每个executor工作目录中

--conf

spark的配置属性

--driver-memory

Driver程序使用内存大小(例如:1000M,5G),默认1024M

--executor-memory

每个executor内存大小(如:1000M,2G),默认1G

Spark standalone with cluster deploy mode only:

--driver-cores

Driver程序的使用core个数(默认为1),仅限于Spark standalone模式

Spark standalone or Mesos with cluster deploy mode only:

--supervise

失败后是否重启Driver,仅限于Spark alone或者Mesos模式

Spark standalone and Mesos only:

--total-executor-cores

executor使用的总核数,仅限于SparkStandalone、Spark on Mesos模式

Spark standalone and YARN only:

--executor-cores

每个executor使用的core数,Spark on Yarn默认为1,standalone默认为worker上所有可用的core。

YARN-only:

--driver-cores

driver使用的core,仅在cluster模式下,默认为1。

--queue

QUEUE_NAME 指定资源队列的名称,默认:default

--num-executors

一共启动的executor数量,默认是2个。

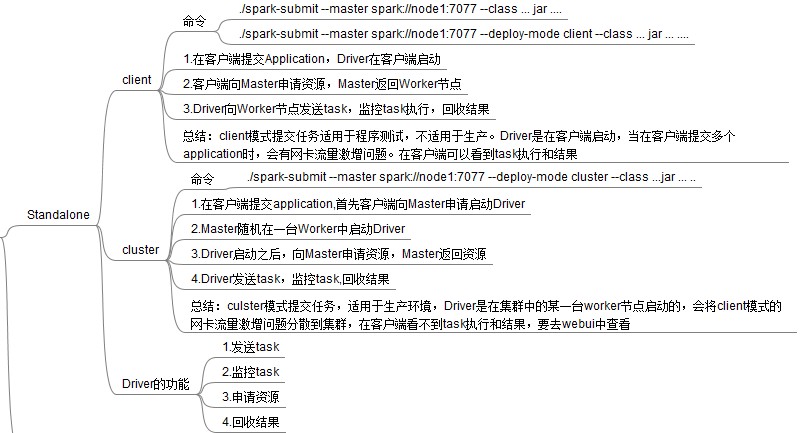

一、standalone任务提交

1、clinet

(1)执行原理图

(2)执行流程

(2.1)client模式提交任务后,会在客户端启动Driver进程。

(2.2)Driver会向Master申请启动Application启动的资源。

(2.3)资源申请成功,Driver端将task发送到worker端执行。

(2.4)worker将task执行结果返回到Driver端。

(3)总结

client模式适用于测试调试程序。Driver进程是在客户端启动的,这里的客户端就是指提交应用程序的当前节点。在Driver端可以看到task执行的情况。生产环境下不能使用client模式,是因为:假设要提交100个application到集群运行,Driver每次都会在client端启动,那么就会导致客户端100次网卡流量暴增的问题。

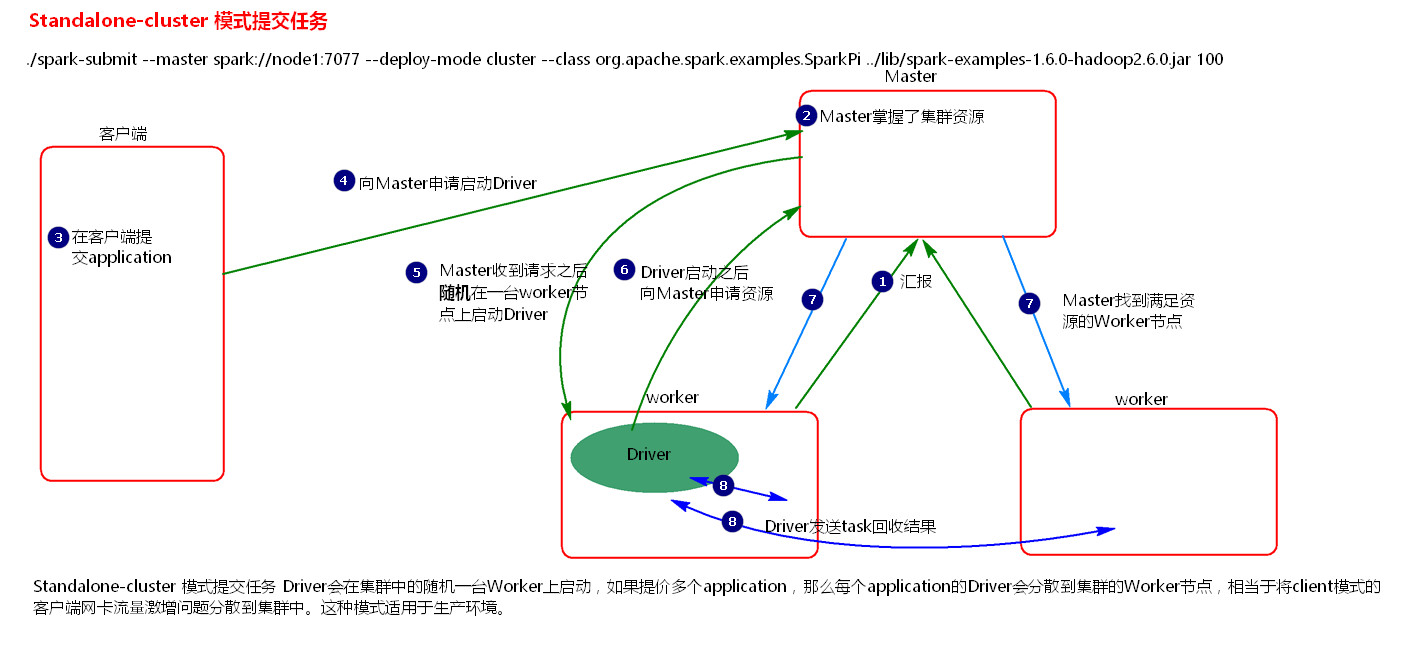

2、cluster

(1)执行原理图

(2)执行流程

(2.1)cluster模式提交应用程序后,会向Master请求启动Driver.

(2.2)Master接受请求,随机在集群一台节点启动Driver进程。

(2.3)Driver启动后为当前的应用程序申请资源。

(2.4)Driver端发送task到worker节点上执行。

(2.5)worker将执行情况和执行结果返回给Driver端。

(3)总结

Driver进程是在集群某一台Worker上启动的,在客户端是无法查看task的执行情况的。假设要提交100个application到集群运行,每次Driver会随机在集群中某一台Worker上启动,那么这100次网卡流量暴增的问题就散布在集群上。

总结Standalone两种方式提交任务,Driver与集群的通信包括:

(1)Driver负责应用程序资源的申请

(2)任务的分发。

(3)结果的回收。

(4)监控task执行情况。

二、YARN任务提交

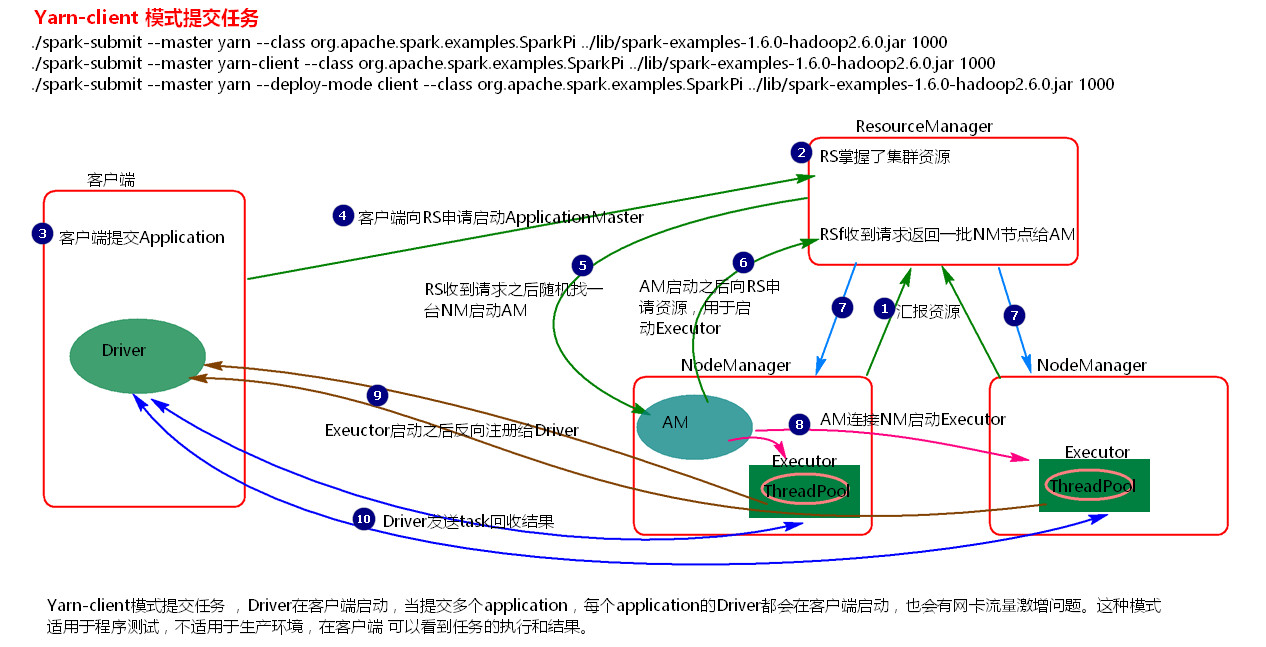

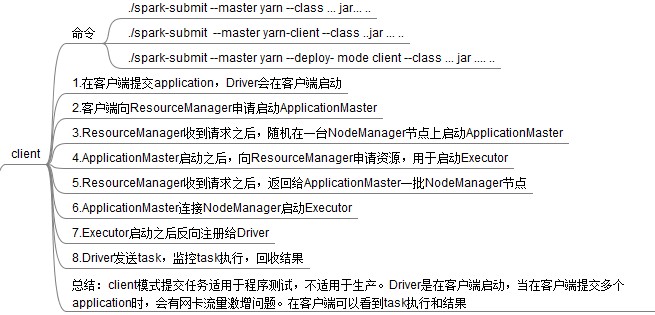

1、client

(1)执行原理图

(2)执行流程

(2.1)客户端提交一个Application,在客户端启动一个Driver进程。

(2.2)应用程序启动后会向RS(ResourceManager)发送请求,启动AM(ApplicationMaster)的资源。

(2.3)RS收到请求,随机选择一台NM(NodeManager)启动AM。这里的NM相当于Standalone中的Worker节点。

(2.4)AM启动后,会向RS请求一批container资源,用于启动Executor.

(2.5)RS会找到一批NM返回给AM,用于启动Executor。

(2.6)AM会向NM发送命令启动Executor。

(2.7)Executor启动后,会反向注册给Driver,Driver发送task到Executor,执行情况和结果返回给Driver端。

(3)总结

Yarn-client模式同样是适用于测试,因为Driver运行在本地,Driver会与yarn集群中的Executor进行大量的通信,会造成客户机网卡流量的大量增加.

ApplicationMaster的作用:

(1)为当前的Application申请资源

(2)给NameNode发送消息启动Executor。

注意:ApplicationMaster有launchExecutor和申请资源的功能,并没有作业调度的功能。

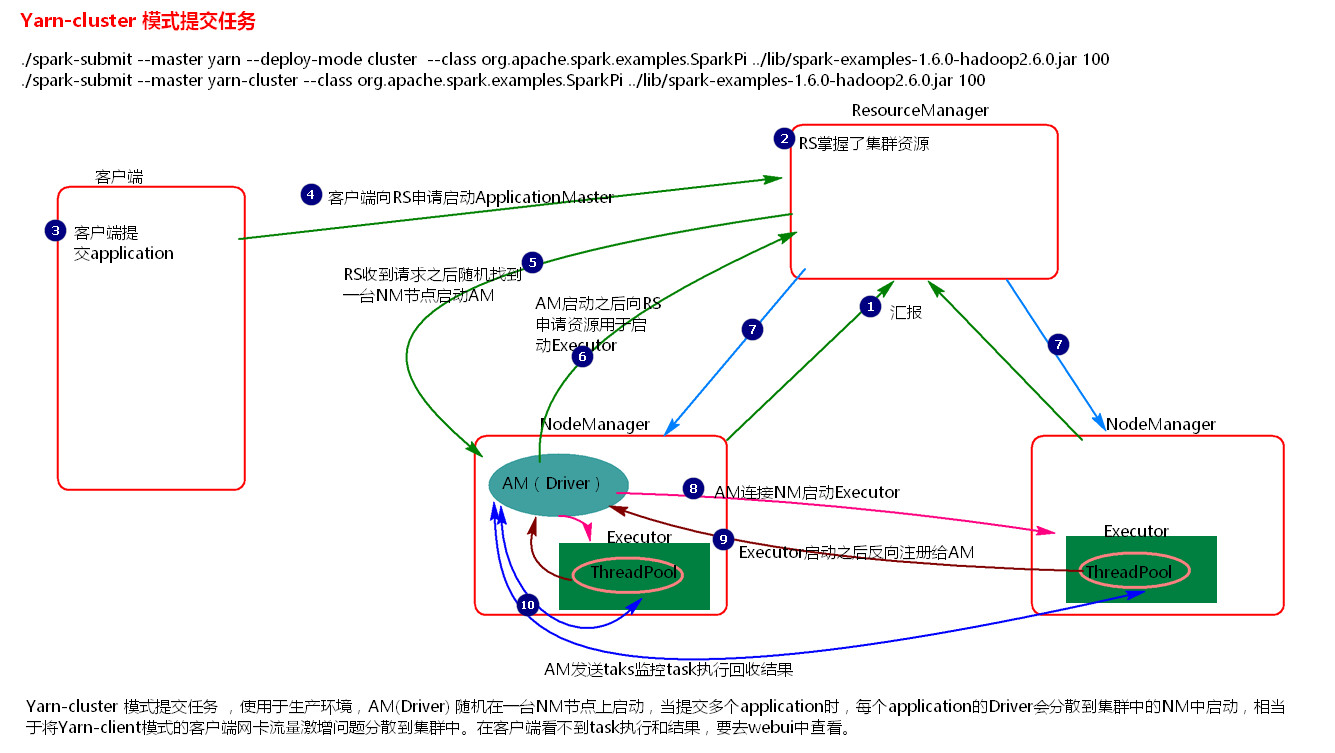

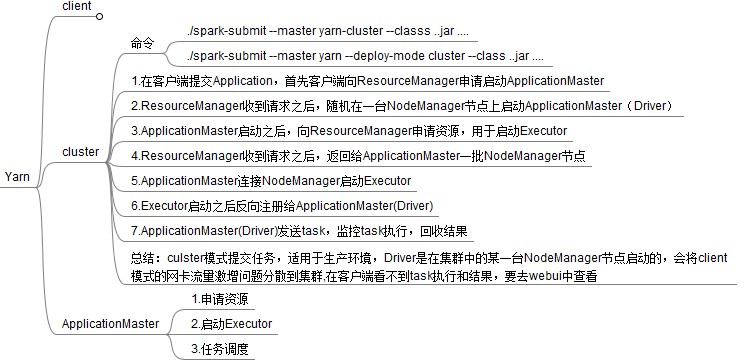

2、cluster

(1)执行原理图

(2)执行过程

(2.1)客户机提交Application应用程序,发送请求到RS(ResourceManager),请求启动AM(ApplicationMaster)。

(2.2)RS收到请求后随机在一台NM(NodeManager)上启动AM(相当于Driver端)。

(2.3)AM启动,AM发送请求到RS,请求一批container用于启动Executor。

(2.4)RS返回一批NM节点给AM。

(2.5)AM连接到NM,发送请求到NM启动Executor。

(2.6)Executor反向注册到AM所在的节点的Driver。Driver发送task到Executor。

(3)总结

Yarn-Cluster主要用于生产环境中,因为Driver运行在Yarn集群中某一台nodeManager中,每次提交任务的Driver所在的机器都是随机的,不会产生某一台机器网卡流量激增的现象,缺点是任务提交后不能看到日志。只能通过yarn查看日志。

ApplicationMaster的作用:

(1)为当前的Application申请资源

(2)给NameNode发送消息启动Excutor。

(3)任务调度。

停止集群任务命令:yarn application -kill applicationID

参考:

【Spark-core学习之四】 Spark任务提交的更多相关文章

- spark SQL学习(spark连接 mysql)

spark连接mysql(打jar包方式) package wujiadong_sparkSQL import java.util.Properties import org.apache.spark ...

- 【spark core学习---算子总结(java版本) (第1部分)】

map算子 flatMap算子 mapParitions算子 filter算子 mapParttionsWithIndex算子 sample算子 distinct算子 groupByKey算子 red ...

- Spark Core源代码分析: Spark任务运行模型

DAGScheduler 面向stage的调度层,为job生成以stage组成的DAG,提交TaskSet给TaskScheduler运行. 每个Stage内,都是独立的tasks,他们共同运行同一个 ...

- Spark Core源代码分析: Spark任务模型

概述 一个Spark的Job分为多个stage,最后一个stage会包含一个或多个ResultTask,前面的stages会包含一个或多个ShuffleMapTasks. ResultTask运行并将 ...

- ASP.NET Core学习之四 在CentOS上部署.net core

一.安装CentOs 以前在大学学过linux,但是对命令行总是有一种深深的排斥感,几年之后,还是又回来了. 1.下载 现在没法FQ,就算是FQ网速也是蜗牛一样慢,我使用阿里云的镜像站进行下载速度还是 ...

- spark SQL学习(spark连接hive)

spark 读取hive中的数据 scala> import org.apache.spark.sql.hive.HiveContext import org.apache.spark.sql. ...

- 【Spark Core】任务运行机制和Task源代码浅析1

引言 上一小节<TaskScheduler源代码与任务提交原理浅析2>介绍了Driver側将Stage进行划分.依据Executor闲置情况分发任务,终于通过DriverActor向exe ...

- Spark 3.x Spark Core详解 & 性能优化

Spark Core 1. 概述 Spark 是一种基于内存的快速.通用.可扩展的大数据分析计算引擎 1.1 Hadoop vs Spark 上面流程对应Hadoop的处理流程,下面对应着Spark的 ...

- 大数据笔记(二十七)——Spark Core简介及安装配置

1.Spark Core: 类似MapReduce 核心:RDD 2.Spark SQL: 类似Hive,支持SQL 3.Spark Streaming:类似Storm =============== ...

- ASP.NET Core学习系列

.NET Core ASP.NET Core ASP.NET Core学习之一 入门简介 ASP.NET Core学习之二 菜鸟踩坑 ASP.NET Core学习之三 NLog日志 ASP.NET C ...

随机推荐

- java interface接口的传值方法

A 类 package interface_test; public class A { private IPresenter ip; public A(IPresenter ip) { this.i ...

- AES和RSA加解密的Python用法

AES AES 是一种对称加密算法,用key对一段text加密,则用同一个key对密文解密, from Crypto import Random from Crypto.Hash import SHA ...

- js多个(N)个数组的的元素组合排序算法,多维数组的排列组合或多个数组之间的排列组合

现在有一批手机,其中颜色有['白色','黑色','金色','粉红色']:内存大小有['16G','32G','64G','128G'],版本有['移动','联通','电信'],要求写一个算法,实现[[ ...

- weblogic 整合cxf 报错:cannot create a secure XmlInputFactory

weblogic 整合cxf 报错:cannot create a secure XmlInputFactory ================================ ©Copyright ...

- Android8 自定义广播接收不到的问题

最近在用安卓广播的时候,按照流程进行操作,可是不管怎样都没有出现我接受的广播,网上查阅资料以后,发现在Android8中,如果是静态注册广播,需要在action中保留原来的静态广播,加入Compone ...

- sklearn中的模型评估-构建评估函数

1.介绍 有三种不同的方法来评估一个模型的预测质量: estimator的score方法:sklearn中的estimator都具有一个score方法,它提供了一个缺省的评估法则来解决问题. Scor ...

- MySql.Data.dll官网下载

Mysql.Data.dll官网下载 在项目开发中链接MySQL数据库经常要用到Mysql.Data.dll,网上虽然有很多,但是还是比较信赖官网的 今天就从官网下载一次记录一下过程 1.下载地址 官 ...

- 解决 nginx 出现 413 Request Entity Too Large 的问题

1.若nginx用所用的 php 请求解析服务是 fpm, 则检查 /etc/php5/fpm/php.ini 文件中的参数 upload_max_filesize = 20M post_max_si ...

- vue.config.js

const path = require('path'); const vConsolePlugin = require('vconsole-webpack-plugin'); // 引入 移动端模拟 ...

- STM32进入HardFault_Handler处理办法

STM32进入HardFault_Handler处理办法 HardFault_Handler出现的情况一般有两种: 一种是:数组越界 一种是:堆栈溢出,程序指针指飞 方法一 在中断HardFault_ ...