Hadoop 中的 (side data) 边数据

一、用途

边数据是作业所需的额外的只读数据,通常用来辅助主数据集;

二、方法

1、利用Configuration类来配置,利用setter()和getter()可方便的使用,方便存储一些基本的类型;

2、分布式缓存:

相比这下,分布式缓存更灵活,它能在任务运行过程中及时地将文件和存档复制到任务节点以供使用;

通常每个作业中,各个文件只需复制到一个节点一次。

原理:

当启动一个作业时,Hadoop会把由-files -archives -libjars添加的文件复制到分布式文件系统HDFS;

在任务运行之前,tasktracker 将文件从分布式文件系统复制到本地磁盘(缓存)使任务去访问到;

用法:

1、使用命令行参数,GenericOptionsParser可对命令行参数进行解析:

使用-files选项指定待分发文件,文件内参数包含以逗号隔开的URL列表。文件可以存放在本地文件系统/HDFS/S3等;默认是本地文件系统;

使用-archives 选项向自己的任务中复制存档文件(jar, zip, tar 等),这些文件会被解档到任务节点。

使用 -libjars 选项会把jar文件添加到mapper和 reducer任务的classpath类路径中

% hadoop jar hadoop-examples.jar MaxTemperatureByStationNameUsingDistributedCacheFile \

-files input/ncdc/metadata/stations-fixed-width.txt input/ncdc/all output //在作业代码中能直接获取到“ stations-fixed-width.txt ”文件

static class MaxTemperatureReducerWithStationLookup extends Reducer<Text, IntWritable, Text, IntWritable> {

private NcdcStationMetadata metadata; @Override

protected void setup(Context context) throws IOException, InterruptedException {

metadata = new NcdcStationMetadata();

metadata.initialize(new File("stations-fixed-width.txt"));

} @Override

protected void reduce(Text key, Iterable<IntWritable> values, Context context)

throws IOException, InterruptedException {

String stationName = metadata.getStationName(key.toString());

int maxValue = Integer.MIN_VALUE;

for (IntWritable value : values) {

maxValue = Math.max(maxValue, value.get());

}

context.write(new Text(stationName), new IntWritable(maxValue));

}

}

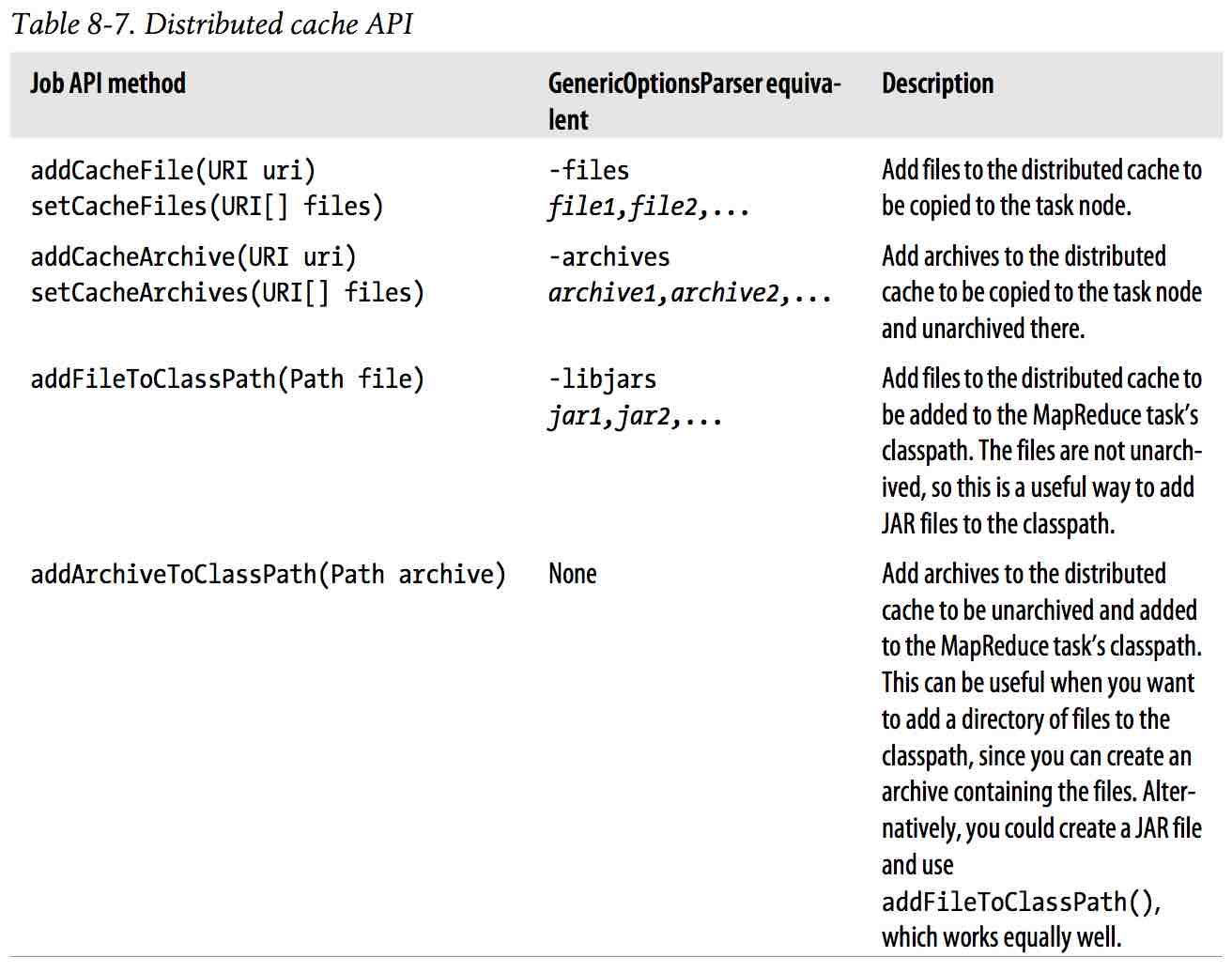

2、使用API,可以完成更多操作,Job中的方法:

public void addCacheFile(URI uri)

public void addCacheArchive(URI uri)

public void setCacheFiles(URI[] files)

public void setCacheArchives(URI[] archives)

public void addFileToClassPath(Path file)

public void addArchiveToClassPath(Path archive)

public void createSymlink()

使用命令行参数 和 API 的 对比:

a. API中使用的路径是指共享路径,比如HDFS上的路径;而命令行下的参数路径可以是本地,也可以是HDFS,如果是本地会复制到HDFS上去;

b. API中的add() set() 不会将文件复制到共享文件系统中去;

获取缓存的文件:

public Path[] getLocalCacheFiles() throws IOException;

public Path[] getLocalCacheArchives() throws IOException;

public Path[] getFileClassPaths();

public Path[] getArchiveClassPaths();

Hadoop 中的 (side data) 边数据的更多相关文章

- Hadoop 中利用 mapreduce 读写 mysql 数据

Hadoop 中利用 mapreduce 读写 mysql 数据 有时候我们在项目中会遇到输入结果集很大,但是输出结果很小,比如一些 pv.uv 数据,然后为了实时查询的需求,或者一些 OLAP ...

- hadoop中联结不同来源数据

装载自http://www.cnblogs.com/dandingyy/archive/2013/03/01/2938462.html 有时可能需要对来自不同源的数据进行综合分析: 如下例子: 有Cu ...

- 浅析 Hadoop 中的数据倾斜

转自:http://my.oschina.net/leejun2005/blog/100922 最近几次被问到关于数据倾斜的问题,这里找了些资料也结合一些自己的理解. 在并行计算中我们总希望分配的每一 ...

- 关于JQuery中$.data绑定数据原理或逻辑

问题: JQuery中,对于.data([key],[value])函数,当使用其进行数据绑定时,假设要绑定的数据是“引用数据类型”,也就是对象:那么.data函数绑定的是该对象的副本还是该对象的一个 ...

- 【转】Jmeter中使用CSV Data Set Config参数化不重复数据执行N遍

Jmeter中使用CSV Data Set Config参数化不重复数据执行N遍 要求: 今天要测试上千条数据,且每条数据要求执行多次,(模拟多用户多次抽奖) 1.用户id有175个,且没有任何排序规 ...

- 18.翻译系列:EF 6 Code-First 中的Seed Data(种子数据或原始测试数据)【EF 6 Code-First系列】

原文链接:https://www.entityframeworktutorial.net/code-first/seed-database-in-code-first.aspx EF 6 Code-F ...

- Jmeter===Jmeter中使用CSV Data Set Config参数化不重复数据执行N遍(转)

Jmeter中使用CSV Data Set Config参数化不重复数据执行N遍 要求: 今天要测试上千条数据,且每条数据要求执行多次,(模拟多用户多次抽奖) 1.用户id有175个,且没有任何排序规 ...

- Hadoop中客户端和服务器端的方法调用过程

1.Java动态代理实例 Java 动态代理一个简单的demo:(用以对比Hadoop中的动态代理) Hello接口: public interface Hello { void sayHello(S ...

- Hadoop 中疑问解析

Hadoop 中疑问解析 FAQ问题剖析 一.HDFS 文件备份与数据安全性分析1 HDFS 原理分析1.1 Hdfs master/slave模型 hdfs采用的是master/slave模型,一个 ...

随机推荐

- haskell 乱搞(2)之 Y-conbinator [原创]

Y-conbinator"有没有用"?并没有,在大多数支持函数式编程的语言里,你可以自由的使用递归,而这货只是作为理论基石弥散在函数式编程的血肉之中 这是数学笔记,这是数学笔记,这 ...

- 如何解决"The superclass "javax.servlet.http.HttpServlet" was not found on the Java Build Path"

今天我在eclipse上搭建新项目时,莫名其妙的出现这个错误,如下: The superclass "javax.servlet.http.HttpServlet" was not ...

- 【angularjs学习】简单的语法

<div ng-app="" ng-init="names=[{name:'Jani',country:'Norway'},{name:'Hege',country ...

- javaScriptCore 实战与小结

源码在这,看不懂的直接撸源码就行,转载声明出处 原生调用JS的大致流程,做了个思维简图 这是代码流程 // JS数据 func getJSVar() { let context: JSContex ...

- 【Vijos1412】多人背包(背包DP)

题意:求0/1背包的前K优解总和 k<=50 v<=5000 n<=200 思路:日常刷水 归并即可,不用排序 ; ..,..,..]of longint; w,c,a,b:..]o ...

- hdu 5012 bfs 康托展开

Dice Time Limit: 2000/1000 MS (Java/Others) Memory Limit: 65536/65536 K (Java/Others) Total Submi ...

- android 活动

一.Activity 声明周期 1 创建 把页面上的个元素加载到内存 onCreate 2 开始 把页面显示到屏幕 onStart 3 恢复 让页面在屏幕活动 onResume 4 暂停 停止页面动作 ...

- codevs——1690 开关灯

1690 开关灯 USACO 时间限制: 1 s 空间限制: 128000 KB 题目等级 : 钻石 Diamond 题解 题目描述 Description YYX家门前的街上有N( ...

- org.dom4j.IllegalAddException: No such namespace prefix: *** is in scope on: org.dom4j.tree.DefaultElement (dom4j写入XML文件,标签中带【:】(冒号)解决办法)

用dom4j操作写XML文件,标签中含有冒号,会报 org.dom4j.IllegalAddException: No such namespace prefix: *** is in scope o ...

- 【JSON注解】注解@JsonIgnoreProperties和@JsonIgnore的另一个使用情况

之前关于这两个注解,是用在JSON循环引用的情况上,那么现在关于这两个注解,还可以使用在另外一种情况上 即: 一般标记在属性或者方法上,返回的json数据即不包含该属性 关于这种情况在什么时候会遇到呢 ...