机器学习4- 多元线性回归+Python实现

1 多元线性回归

更一般的情况,数据集 \(D\) 的样本由 \(d\) 个属性描述,此时我们试图学得

\]

称为多元线性回归(multivariate linear regression)或多变量线性回归。

类似的,使用最小二乘法估计 \(\boldsymbol{w}\) 和 \(b\)。

由 \(f(\boldsymbol{x}_i) = \boldsymbol{w}^T\boldsymbol{x}_i+b\) 知:

f(\boldsymbol{x}_2) = w_1x_{21} + w_2x_{22} + ... + w_dx_{2d} + b \\

... ... \\

f(\boldsymbol{x}_m) = w_1x_{m1} + w_2x_{m2} + ... + w_dx_{md} + b \\

\]

我们记

\]

x_{11} & x_{12} & \cdots & x_{1d} & 1 \\

x_{21} & x_{22} & \cdots & x_{2d} & 1 \\

\vdots & \vdots & \ddots & \vdots & \vdots \\

x_{m1} & x_{m2} & \cdots & x_{md} & 1

\end{pmatrix}

=\begin{pmatrix}

\boldsymbol{x}_1^T & 1 \\

\boldsymbol{x}_2^T & 1 \\

\vdots & \vdots \\

\boldsymbol{x}_m^T & 1

\end{pmatrix}

\]

\]

可得:

\]

类似于前篇博客的式子 (2.3) 有:

\tag{1.2}

\]

令 \(E_{\hat{\boldsymbol{w}}} = (\boldsymbol{y}-\boldsymbol{X}\hat{\boldsymbol{w}})^T(\boldsymbol{y}-\boldsymbol{X}\hat{\boldsymbol{w}})\),对 \(\hat{\boldsymbol{w}}\) 求导得:

\tag{1.3}

\]

令上式为零,得到 \(\hat{\boldsymbol{w}}\) 最优解的闭式解。

当 \(\boldsymbol{X}^T\boldsymbol{X}\) 为满秩矩阵(full-rank matrix)或正定矩阵(positive define matrix)时,令式 (1.2) 为零可得:

\]

令 \(\hat{\boldsymbol{x}_i} = (\boldsymbol{x}_i, 1)\) 得到最终学得的多元线性回归模型为:

\]

当 \(\boldsymbol{X}^T\boldsymbol{X}\) 不是满秩矩阵时,可解出多个 \(\hat{\boldsymbol{w}}\) 使得均方误差最小。选择哪个解输出取决于学习算法的归纳偏好。常用做法是引入正则化(regularization)项。

2 多元线性回归的Python实现

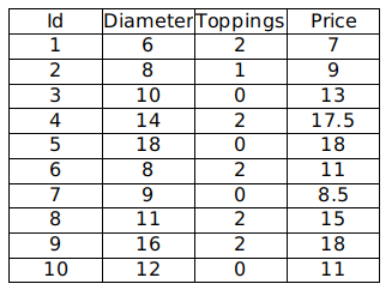

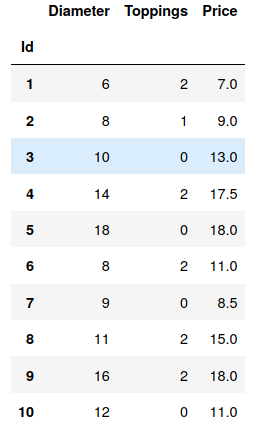

现有如下数据,我们希望通过分析披萨的直径、辅料数量与价格的线性关系,来预测披萨的价格:

2.1 手动实现

2.1.1 导入必要模块

import numpy as np

import pandas as pd

2.1.2 加载数据

pizza = pd.read_csv("pizza_multi.csv", index_col='Id')

pizza

2.1.3 计算系数

由公式

\]

可计算出 \(\hat{\boldsymbol{w}}^*\) 的值。

我们将后 5 行数据作为测试集,其他为测试集:

X = pizza.iloc[:-5, :2].values

y = pizza.iloc[:-5, 2].values.reshape((-1, 1))

print(X)

print(y)

[[ 6 2]

[ 8 1]

[10 0]

[14 2]

[18 0]]

[[ 7. ]

[ 9. ]

[13. ]

[17.5]

[18. ]]

ones = np.ones(X.shape[0]).reshape(-1,1)

X = np.hstack((X,ones))

X

array([[ 6., 2., 1.],

[ 8., 1., 1.],

[10., 0., 1.],

[14., 2., 1.],

[18., 0., 1.]])

w_ = np.dot(np.dot(np.linalg.inv(np.dot(X.T, X)), X.T), y)

w_

array([[1.01041667],

[0.39583333],

[1.1875 ]])

即:

\]

\]

b = w_[-1]

w = w_[:-1]

print(w)

print(b)

[[1.01041667]

[0.39583333]]

[1.1875]

2.1.4 预测

X_test = pizza.iloc[-5:, :2].values

y_test = pizza.iloc[-5:, 2].values.reshape((-1, 1))

print(X_test)

print(y_test)

[[ 8 2]

[ 9 0]

[11 2]

[16 2]

[12 0]]

[[11. ]

[ 8.5]

[15. ]

[18. ]

[11. ]]

y_pred = np.dot(X_test, w) + b

# y_pred = np.dot(np.hstack((X_test, ones)), w_)

print("目标值:\n", y_test)

print("预测值:\n", y_pred)

目标值:

[[11. ]

[ 8.5]

[15. ]

[18. ]

[11. ]]

预测值:

[[10.0625 ]

[10.28125 ]

[13.09375 ]

[18.14583333]

[13.3125 ]]

2.2 使用 sklearn

import numpy as np

import pandas as pd

from sklearn.linear_model import LinearRegression

# 读取数据

pizza = pd.read_csv("pizza_multi.csv", index_col='Id')

X = pizza.iloc[:-5, :2].values

y = pizza.iloc[:-5, 2].values.reshape((-1, 1))

X_test = pizza.iloc[-5:, :2].values

y_test = pizza.iloc[-5:, 2].values.reshape((-1, 1))

# 线性拟合

model = LinearRegression()

model.fit(X, y)

# 预测

predictions = model.predict(X_test)

for i, prediction in enumerate(predictions):

print('Predicted: %s, Target: %s' % (prediction, y_test[i]))

Predicted: [10.0625], Target: [11.]

Predicted: [10.28125], Target: [8.5]

Predicted: [13.09375], Target: [15.]

Predicted: [18.14583333], Target: [18.]

Predicted: [13.3125], Target: [11.]

# 模型评估

"""

使用 score 方法可以计算 R方

R方的范围为 [0, 1]

R方越接近 1,说明拟合程度越好

"""

print('R-squared: %.2f' % model.score(X_test, y_test))

R-squared: 0.77

此文原创禁止转载,转载文章请联系博主并注明来源和出处,谢谢!

作者: Raina_RLN https://www.cnblogs.com/raina/

机器学习4- 多元线性回归+Python实现的更多相关文章

- 【TensorFlow篇】--Tensorflow框架初始,实现机器学习中多元线性回归

一.前述 TensorFlow是谷歌基于DistBelief进行研发的第二代人工智能学习系统,其命名来源于本身的运行原理.Tensor(张量)意味着N维数组,Flow(流)意味着基于数据流图的计算,T ...

- 100天搞定机器学习|Day3多元线性回归

前情回顾 [第二天100天搞定机器学习|Day2简单线性回归分析][1],我们学习了简单线性回归分析,这个模型非常简单,很容易理解.实现方式是sklearn中的LinearRegression,我们也 ...

- coursera机器学习笔记-多元线性回归,normal equation

#对coursera上Andrew Ng老师开的机器学习课程的笔记和心得: #注:此笔记是我自己认为本节课里比较重要.难理解或容易忘记的内容并做了些补充,并非是课堂详细笔记和要点: #标记为<补 ...

- [机器学习Lesson4]多元线性回归

1. 多元线性回归定义 多元线性回归也被称为多元线性回归. 我们现在介绍方程的符号,我们可以有任意数量的输入变量. 这些多个特征的假设函数的多变量形式如下: hθ(x)=θ0+θ1x1+θ2x2+θ3 ...

- 梯度下降法的python代码实现(多元线性回归)

梯度下降法的python代码实现(多元线性回归最小化损失函数) 1.梯度下降法主要用来最小化损失函数,是一种比较常用的最优化方法,其具体包含了以下两种不同的方式:批量梯度下降法(沿着梯度变化最快的方向 ...

- 【机器学习】线性回归python实现

线性回归原理介绍 线性回归python实现 线性回归sklearn实现 这里使用python实现线性回归,没有使用sklearn等机器学习框架,目的是帮助理解算法的原理. 写了三个例子,分别是单变量的 ...

- day-12 python实现简单线性回归和多元线性回归算法

1.问题引入 在统计学中,线性回归是利用称为线性回归方程的最小二乘函数对一个或多个自变量和因变量之间关系进行建模的一种回归分析.这种函数是一个或多个称为回归系数的模型参数的线性组合.一个带有一个自变 ...

- 机器学习——Day 3 多元线性回归

写在开头 由于某些原因开始了机器学习,为了更好的理解和深入的思考(记录)所以开始写博客. 学习教程来源于github的Avik-Jain的100-Days-Of-MLCode 英文版:https:// ...

- 机器学习:单元线性回归(python简单实现)

文章简介 使用python简单实现机器学习中单元线性回归算法. 算法目的 该算法核心目的是为了求出假设函数h中多个theta的值,使得代入数据集合中的每个x,求得的h(x)与每个数据集合中的y的差值的 ...

随机推荐

- js 任意值变化封装

<!DOCTYPE html PUBLIC "-//W3C//DTD XHTML 1.0 Transitional//EN" "http://www.w3.org/ ...

- 把 GitHub 放入口袋,“开箱”官方客户端

GitHub 2019 开发者大会说要出的客户端,今天(2020.3.18)终于放出了下载.之前如果登记过的小伙伴应该也和我一样收到了下面样子的邮件: 好了,那么接下来我们就来"开箱&quo ...

- C++基础 学习笔记之一:源代码的格式化

C++基础 学习笔记之一:源代码的格式化 1. 源代码中的标记与空白 C++中的语句是以分号表示语句的结束.在C++中空格和回车以及制表符均为相同作用,即三者通常可以互相替代. 例如可以将一个简单的m ...

- 微服务系列之 Consul 注册中心

原文链接:https://mrhelloworld.com/posts/spring/spring-cloud/consul-service-registry/ Netflix Eureka 2.X ...

- express第三方中间件研究之bodyParser中间件

转载至:http://www.cnblogs.com/lianer/p/5178693.html 接触nodejs已有一段时间了,但最近才开始落实项目,于是使用express应用生成器生成了一个应用. ...

- sql优化,如何将in换为exists

原sql语句 -- 根据权限表查出该用户拥有的所有权限菜单 select * from tb_power where id in( select power_id from tb_role_power ...

- 数据库表结构查询SQL

今天给大家送上两个SQL查询的方法,也许在项目中你都用过,但是,没关系,仅仅记录下,以便后面不用去查找.针对与经常写SQL的同行来说,应该是非常简单的. 查询表结构数据 SELECT t.COLUMN ...

- Redis启动服务和String常用命令

Redis启动服务和String常用命令 1. 启动Redis服务 E:\redis>redis-server.exe redis.windows.conf _._ _.-``__ ''-._ ...

- Python之split()函数

在Python的高级特性里有切片(Slice)操作符,可以对字符串进行截取.Python还提供split()函数可以将一个字符串分裂成多个字符串组成的列表. split()的语法挺简单的: str.s ...

- Django之模板层细说

django的模板层,基于我们前面学习的内容,也知道主要语法是{{变量相关}}{%逻辑相关%},那么具体还有哪些内容呢?且听我娓娓道来. 模板层(模板语法) 标签 过滤器 自定义标签,过滤器,incl ...