3. Spark常见数据源

*以下内容由《Spark快速大数据分析》整理所得。

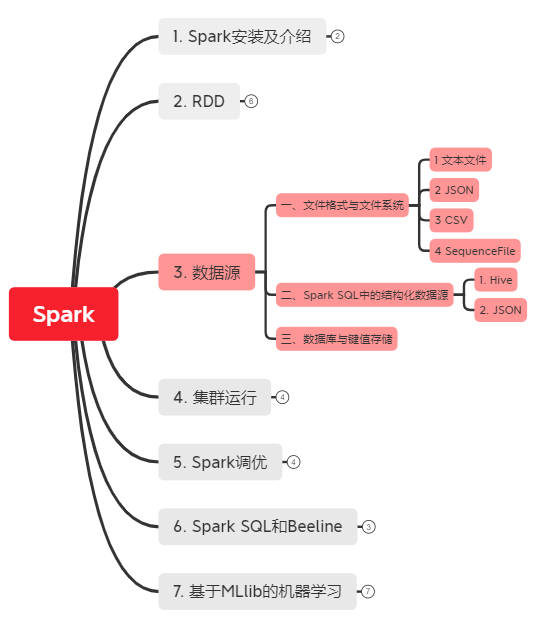

读书笔记的第三部分是讲的是Spark有哪些常见数据源?怎么读取它们的数据并保存。

Spark有三类常见的数据源:

- 文件格式与文件系统:它们是存储在本地文件系统或分布式文件系统(比如 NFS、HDFS、Amazon S3 等)中的 数据,例如:文本文件、JSON、SequenceFile, 以及 protocol buffer。

- Spark SQL中的结构化数据源:它针对包括JSON和Apache Hive在内的结构化数据源。

- 数据库与键值存储:Spark 自带的库和一些第三方库,它们可以用来连接Cassandra、HBase、Elasticsearch以及JDBC源。

一、文件格式与文件系统

1. 文本文件

2. JSON

3. CSV

4. SequenceFile

二、Spark SQL中的结构化数据源

1. Hive

2. JSON

三、数据库与键值存储

一、文件格式与文件系统

1. 文本文件

文本文件读取:

# 方法1:文本文件读取

input = sc.textFile("file://home/holden/repos/sparks/README.md")

# 方法2:如果文件足够小,同时读取整个文件,从而返回一个pair RDD,其中键时输入文件的文件名

input = sc.wholeTextFiles("file://home/holden/salesFiles")

文本文件保存:

result.saveAsTextFile(outputFile)

2. JSON

JSON读取:

# JSON读取

import json

data = input.map(lambda x: json.loads(x))

JSON保存:

# JSON保存 - 举例选出喜爱熊猫的人

(data.filter(lambda x: x["lovesPandas"]).map(lambda x: json.dumps(x)).saveAsTextFile(outputFile))

# 保存文本文件

result.SaveAsTextFile(outputFilePath)

3. CSV

CSV读取:

import csv

import StringIO

# CSV读取 - 如果数据字段均没有包括换行符,只能一行行读取

def loadRecord(line):

"""解析一行CSV记录"""

input = StringIO.StringIO(line)

reader = csv.DictReader(input, fieldnames=["name", "favouriteAnimal"])

return reader.next()

input = sc.textFile(inputFile).map(loadRecord)

# CSV读取 - 如果数据字段嵌有换行符,需要完整读入每个文件

def loadRecords(fileNameContents):

"""读取给定文件中的所有记录"""

input = StringIO.StringIO(fileNameContents[1])

reader = csv.DictReader(input, fieldnames=["name", "favoriteAnimal"])

return reader

fullFileData = sc.wholeTextFiles(inputFile).flatMap(loadRecords)

CSV保存:

# CSV保存

def writeRecords(records):

"""写出一些CSV记录"""

output = StringIO.StringIO()

writer = csv.DictWriter(output, fieldnames=["names", "favoriteAnimal"])

for record in records:

writer.writerow(record)

return [output.getvalue()] pandaLovers.mapPartitions(writeRecords).saveAsTextFile(outputFile)

4. SequenceFile

SequenceFile读取:

# sc.sequenceFile(path, keyClass, valueClass)

data = sc.sequenceFile(inFile, "org.apache.hadoop.io.Text", "org.apache.hadoop.io.IntWritable")

SequenceFile保存(用Scala):

val data = sc.parallelize(List(("Pandas", 3), ("Kay", 6), ("Snail", 2)))

data.saveAsSequenceFile(outputFile)

二、Spark SQL中的结构化数据源

用Spark SQL从多种数据源里读取数据:

1. Hive

用Spark SQL连接已有的Hive:

(1.1)需要将hive-site.xml文件复制到 Spark 的 ./conf/ 目录下;

(1.2)再创建出HiveContext对象,也就是 Spark SQL 的入口;

(1.3)使用Hive查询语言(HQL)来对你的表进行查询。

# 例子:用Python创建HiveContext并查询数据

from pyspark.sql import HiveContext hiveCtx = HiveContext(sc)

rows = hiveCtx.sql("SELECT name, age FROM users")

firstRow = rows.first()

print firstRow.name

2. JSON

(2.1)和使用Hive一样创建一个HiveContext。(不过在这种情况下我们不需要安装好Hive,也就是说你也不需要hive-site.xml文件。);

(2.2)使用HiveContext.jsonFile方法来从整个文件中获取由Row对象组成的RDD。

(2.3)除了使用整个Row对象,你也可以将RDD注册为一张表,然后从中选出特定的字段。

# 例子:在Python中使用Spark SQL读取JSON数据

tweets = hiveCtx.jsonFile("tweets.json")

tweets.registerTempTable("tweets")

results = hiveCtx.sql("SELECT user.name, text FROM tweets")

三、数据库与键值存储

关于Cassandra、HBase、Elasticsearch以及JDBC源的数据库连接,详情请参考书本81-86页内容。

3. Spark常见数据源的更多相关文章

- Spring:(三) --常见数据源及声明式事务配置

Spring自带了一组数据访问框架,集成了多种数据访问技术.无论我们是直接通过 JDBC 还是像Hibernate或Mybatis那样的框架实现数据持久化,Spring都可以为我们消除持久化代码中那些 ...

- Spark SQL数据源

[TOC] 背景 Spark SQL是Spark的一个模块,用于结构化数据的处理. ++++++++++++++ +++++++++++++++++++++ | SQL | | Dataset API ...

- Spark常见编程问题解决办法及优化

目录 1.数据倾斜 2.TopN 3.Join优化 预排序的join cross join 考虑Join顺序 4.根据HashMap.DF等数据集进行filter 5.Join去掉重复的列 6.展开N ...

- 4. Spark SQL数据源

4.1 通用加载/保存方法 4.1.1手动指定选项 Spark SQL的DataFrame接口支持多种数据源的操作.一个DataFrame可以进行RDDs方式的操作,也可以被注册为临时表.把DataF ...

- ODBC 常见数据源配置整理

目录 1. 简介 1.1 ODBC和JDBC 1.2 ODBC配置工具 1.3 ODBC 数据源连接配置 2. MySQL 数据源配置 2.1 配置步骤 2.2 链接参数配置 3. SQLServer ...

- spark之数据源之自动分区推断

在hadoop上创建目录/spark-study/users/gender=male/country=US/users.parquet(并且把文件put上去) code: package cn.spa ...

- Spark常见错误汇总

1. Spark Driver cannot bind on port0, SparkContext initialized failed 如果是通过spark-submit等命令行提交的任务,在sp ...

- spark常见错误【持续更新】

错误1.错误: 找不到或无法加载主类 idea.scala代码 idea 导入的scala工程,编写代码后报该错误. 原因:\src\main\scala 包路径下没有将scala这个包设置成Sour ...

- spark sql数据源--hive

使用的是idea编辑器 spark sql从hive中读取数据的步骤:1.引入hive的jar包 2.将hive-site.xml放到resource下 3.spark sql声明对hive的支持 案 ...

随机推荐

- 同一台电脑同时使用gitHub和gitLab

工作中我们有时可能会在同一台电脑上使用多个git账号,例如:公司的gitLab账号,个人的gitHub账号.怎样才能在使用gitlab与github时,切换成对应的账号,并且免密?这时我们需要使用ss ...

- 2016-12-04---tiny412平台下的iconv库的移植问题

一.解决问题 在arm开发板上使用framebuff,在汉字显示时,因为只有gb2312的16*16的汉字字库,而ubuntu16.04默认 的编码方式时utf-8,因此需要进行转码(ut ...

- 学不动了!微信官方推出 Web 前端和小程序统一框架 Kbone

听说最近微信官方推出了一个统一 Web 前端和小程序的框架 -- Kbone ,特意去看了下... 为什么微信要搞Kbone? 微信小程序的底层模型和 Web 端不同,开发者无法直接把 Web 端的代 ...

- 【最大匹配+二分答案】POJ 3057 Evacuation

题目大意 POJ链接 有一个\(X×Y\)的房间,X代表墙壁,D是门,.代表人.这个房间着火了,人要跑出去,但是每一个时间点只有一个人可以从门出去. 问最后一个人逃出去的最短时间,如果不能逃出去,输出 ...

- OpenCV开发笔记(七十一):红胖子8分钟带你深入级联分类器训练

前言 红胖子,来也! 做图像处理,经常头痛的是明明分离出来了(非颜色的),分为几块区域,那怎么知道这几块区域到底哪一块是我们需要的,那么这部分就涉及到需要识别了. 识别可以自己写模板匹配.特征 ...

- SQL 禁止在 .NET Framework 中执行用户代码。启用 "clr enabled" 配置选项

注:本文摘自:http://blog.csdn.net/heshengfen123/article/details/3597125 在执行SQL脚本过程中如果出现 禁止在 .NET Framework ...

- 解决Mac下AndroidStudio内容时卡顿

Mac下AndroidStudio在写代码的时候出现卡顿,小圆圈会一直转,此时我们应该检查下AndroidStudio的内存使用情况了. 1.点击左上角 AndroidStudio -- Prefer ...

- Codeforces Round #427 (Div. 2) E. The penguin's game (交互题,二进制分组)

E. The penguin's game time limit per test: 1 second memory limit per test: 256 megabytes input: stan ...

- Linux入门到放弃之七《进程管理》

进程管理 1.查看所有进程,并用全格式显示: 命令:ps -ef 2.用ps命令查看系统当前的进程,并把系统当前的进程保存到文件process中: 命令:ps aux >> process ...

- buuctf-misc 菜刀666

解压出一个666666.pcapng的文件,我们拖进wireshark 因为是菜刀吗?一般都是post连接,于是我们过滤post数据 http.request.method==POST 然后分析流量, ...