机器学习-线性分类-支持向量机SVM-SMO算法-14

1. SVM算法总结

选择 核函数 以及对应的 超参数

为什么要选择核函数?

升维 将线性问题不可分问题 升维后转化成 线性可分的问题

核函数 有那些? linea gauss polinormail tanh选择惩罚项系数C

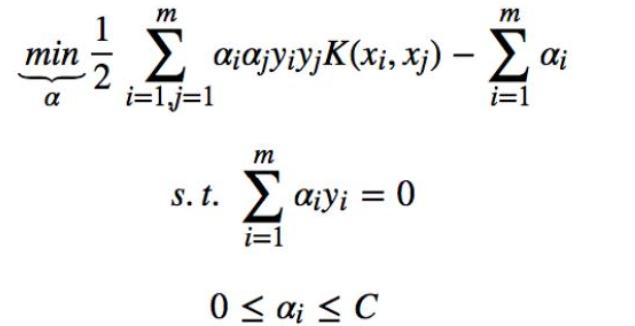

min ||w||2 + Csum(ei)构造优化问题:

利用SMO算法 计算 α*

根据α* 计算w*

根据α* 得到支撑向量 计算每个支撑向量 对应的bs*

bs* 求平均得到b*

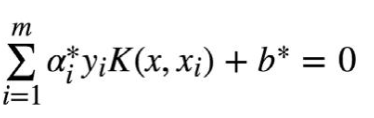

学得超平面:

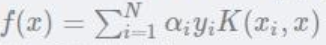

仔细观察这个式子就会发现:

其实只需要关注 支撑向量的C>α>0 非支撑向量的alpha为0

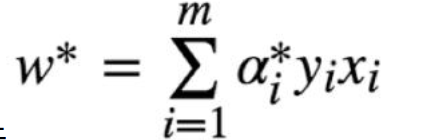

W*的计算:

其实也就只需要关注 是支撑向量的几个点,支撑向量对于W,b的求解起关键作用,其他的非支撑向量,对模型没起任何作用

- 得到最终的判别式

神奇的SMO算法到底是如何进行的?

2. SMO算法

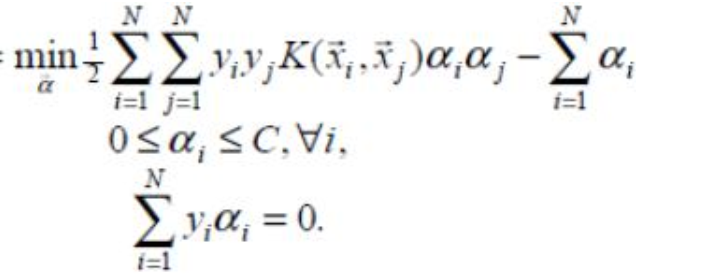

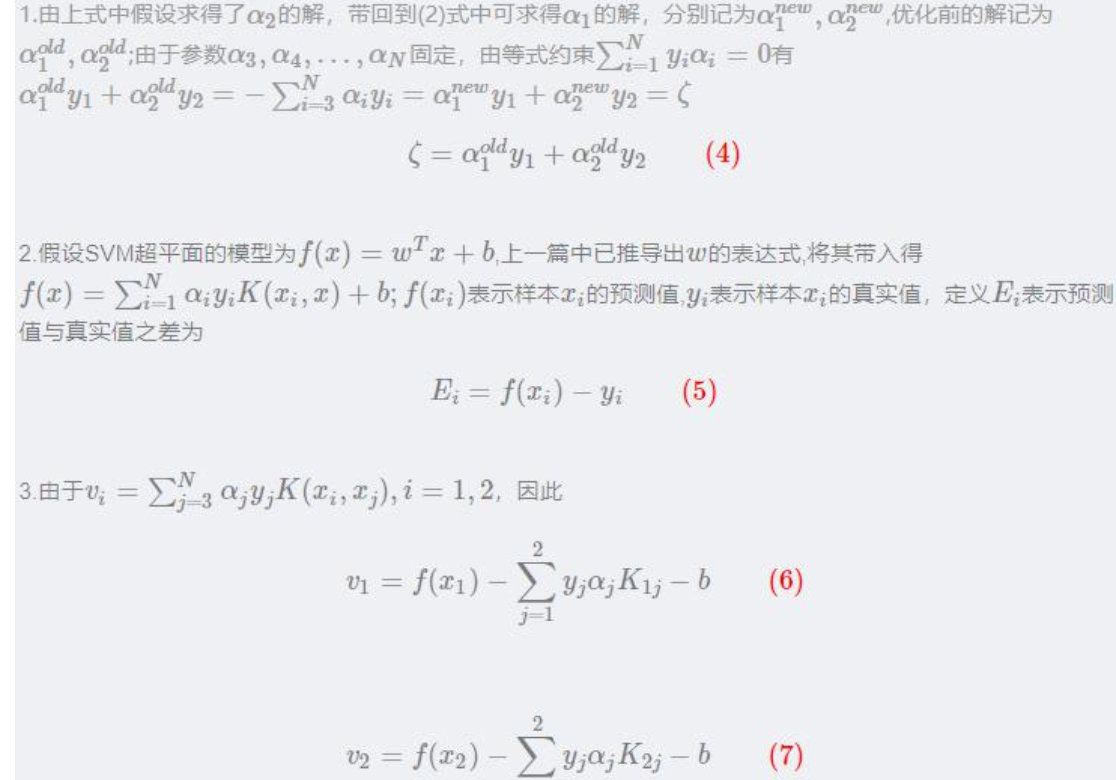

其中(xi,yi)表示训练样本数据,xi 为样本特征,yi∈{−1,1}为样本标签,C 为惩罚系数由自己设定。上述问题是要求解 N 个参数(α1,α2,α3,...,αN),其他参数均为已知

把原始求解 N 个参数二次规划问题分解成很多个子二次规划问题分别求解,每个子问题只需要求解 2 个参数,方法类似于坐标上升,节省时间成本和降低了内存需求。每次启发式选择两个变量进行优化,不断循环,直到达到函数最优值。

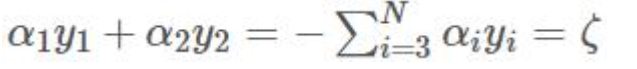

同时优化两个参数,固定其他 N-2 个参数,假设选择的变量为α1,α2,

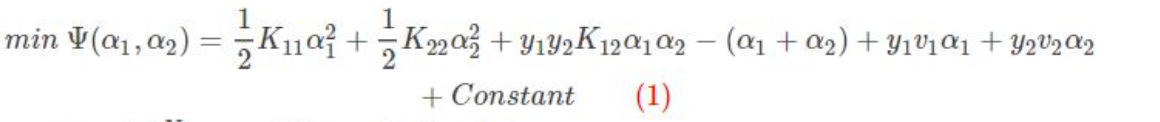

固定其他参数α3,α4,...,αN,由于参数α3,α4,...,αN 的固定, 可以简化目标函数为只关于α1,α2的二元函数,Constant 表示常数项(不包含变量α1,α2 的项)。

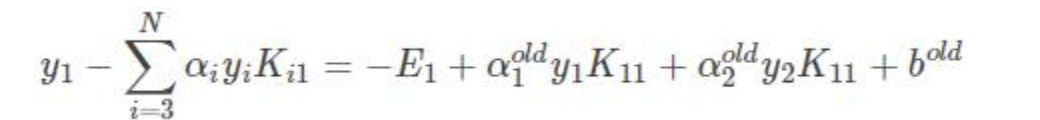

v1 表示 x1 与 3---N 之后所有的样本运算

v2 表示 x2 与 3---N 之后所有的样本运算

其中:

Kij表示 xi 与 xj 输入到核函数 进行运算的结果

两边同时乘以 y1, 任意的y*2 = 1

得到:

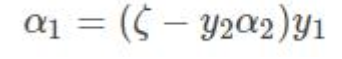

需要优化的目标函数转化成:

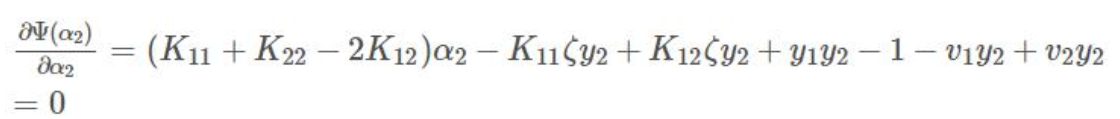

上式中是关于变量α2 的函数,对上式求导并令其为 0 得:

将4, 6, 7 带入求导=0 的式子

令η=K11+K22−2K12

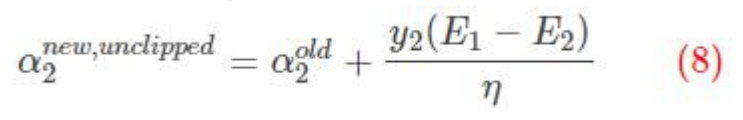

这里得到的α2 是未经过修建的alpha 不一定满足约束条件

翻译一下:

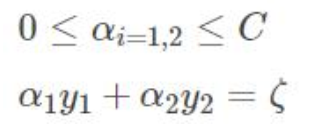

两个拉格朗日算子 0< α1 α2 < C限定必须在正方形盒子内部

α1y1+α2y2=固定值 限定了必须在直线上 最优解 必须是一条线段

新的α2 下限L 上限H

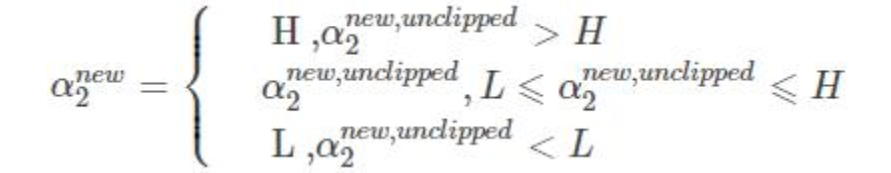

修建后的alpha

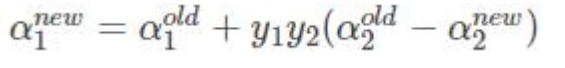

由于其他 N-2 个变量固定:

两边同时乘以y1:

选择α1 α2采用上述方法进行优化,直到不违反kkt条件

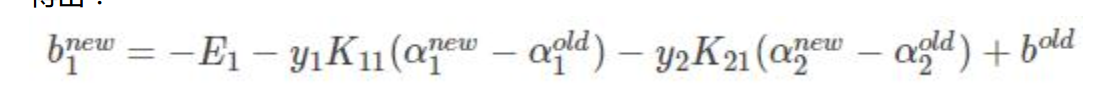

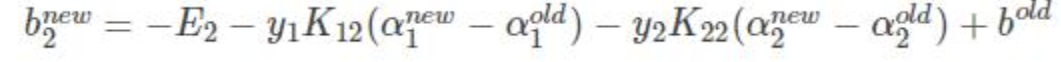

α1 α2优化的同时对b进行更新:

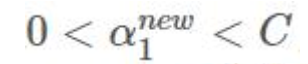

- 如果:

则 x1 y1 为支撑向量

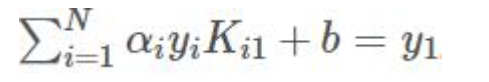

两边乘以y1:

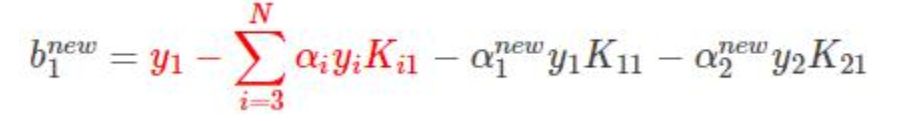

得到bnew:

只不过是拆成3部分而已

前两项可以替换为

得到:

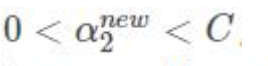

如果

同理:

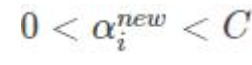

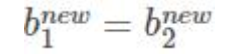

α1 α2 都满足:

取一个就行:

如果都不满足 他们的中点:

取1/2 *(α1 + α2)

机器学习-线性分类-支持向量机SVM-SMO算法-14的更多相关文章

- SVM-非线性支持向量机及SMO算法

SVM-非线性支持向量机及SMO算法 如果您想体验更好的阅读:请戳这里littlefish.top 线性不可分情况 线性可分问题的支持向量机学习方法,对线性不可分训练数据是不适用的,为了满足函数间隔大 ...

- 线性可分支持向量机--SVM(1)

线性可分支持向量机--SVM (1) 给定线性可分的数据集 假设输入空间(特征向量)为,输出空间为. 输入 表示实例的特征向量,对应于输入空间的点: 输出 表示示例的类别. 线性可分支持向量机的定义: ...

- 统计学习:线性可分支持向量机(SVM)

模型 超平面 我们称下面形式的集合为超平面 \[\begin{aligned} \{ \bm{x} | \bm{a}^{T} \bm{x} - b = 0 \} \end{aligned} \tag{ ...

- 机器学习算法整理(七)支持向量机以及SMO算法实现

以下均为自己看视频做的笔记,自用,侵删! 还参考了:http://www.ai-start.com/ml2014/ 在监督学习中,许多学习算法的性能都非常类似,因此,重要的不是你该选择使用学习算法A还 ...

- 机器学习笔记:支持向量机(svm)

支持向量机(svm)英文为Support Vector Machines 第一次接触支持向量机是2017年在一个在线解密游戏"哈密顿行动"中的一个关卡的二分类问题,用到了台湾教授写 ...

- 支持向量机的smo算法(MATLAB code)

建立smo.m % function [alpha,bias] = smo(X, y, C, tol) function model = smo(X, y, C, tol) % SMO: SMO al ...

- 吴裕雄--天生自然python机器学习:基于支持向量机SVM的手写数字识别

from numpy import * def img2vector(filename): returnVect = zeros((1,1024)) fr = open(filename) for i ...

- 机器学习:Python中如何使用支持向量机(SVM)算法

(简单介绍一下支持向量机,详细介绍尤其是算法过程可以查阅其他资) 在机器学习领域,支持向量机SVM(Support Vector Machine)是一个有监督的学习模型,通常用来进行模式识别.分类(异 ...

- 机器学习-支持向量机SVM

简介: 支持向量机(SVM)是一种二分类的监督学习模型,他的基本模型是定义在特征空间上的间隔最大的线性模型.他与感知机的区别是,感知机只要找到可以将数据正确划分的超平面即可,而SVM需要找到间隔最大的 ...

- 机器学习——支持向量机SVM

前言 学习本章节前需要先学习: <机器学习--最优化问题:拉格朗日乘子法.KKT条件以及对偶问题> <机器学习--感知机> 1 摘要: 支持向量机(SVM)是一种二类分类模型, ...

随机推荐

- 【Python微信机器人】第六篇:优化使用方式,可pip安装

优化内容 这篇不聊技术点,说一下优化后的Python机器人代码怎么使用,优化内容如下: 将hook库独立成一个库,发布到pypi,可使用pip安装 将微信相关的代码发布成另一个库,也可以pip安装 g ...

- hello Flask最简单的Flask项目

# 1.导包 from flask import Flask # 2.实例化Flask对象.一般变量名都叫app,大家都是这样用,很多扩展插件的文档也是叫app,所以统一都叫app. # __name ...

- 解决 VM with version 2.1.0 has multidex support ; VM has multidex support, MultiDex support library is disabled.问题

发布打包完之后,android studio提示 VM with version 2.1.0 has multidex support I/MultiDex: installI/MultiDex: V ...

- HTML之CSS Animation 属性常用动画

引入下面的样式表后 -webkit-animation: tada 1s ease 0.3s infinite both; -webkit-animation: name duration timin ...

- 火爆全网的Log4j 漏洞复现GetShell

目录: 一.搭建环境 1. 首先拉一个docker镜像 2. 然后启动环境 二.获取shell 首先,试验一下DNSLog 1. 准备JNDI注入工具 下载 进入目录打包成jar包 2. 利用 生成p ...

- 斯坦福 UE4 C++ ActionRoguelike游戏实例教程 09.第二个游戏规则:玩家重生

斯坦福课程 UE4 C++ ActionRoguelike游戏实例教程 0.绪论 概述 本文对应课程15章,60 - Refining Player Respawns. 在本篇文章中,将会为游戏新增加 ...

- 文心一言 VS 讯飞星火 VS chatgpt (25)-- 算法导论4.2 7题

七.设计算法,仅使用三次实数乘法即可完成复数 a+bi和c+di 相乘.算法需接收a.b.c和d 为输入,分别生成实部 ac-bd 和虚部ad+bc. 文心一言: 可以使用如下算法来计算复数 a+bi ...

- ModelArts黑科技揭秘|弹性训练,让训练资源张弛有度

摘要:AI进入产业的门槛变高,开发者想要做出优秀的AI模型就不得不在算力和成本之间折中,怎么办? 为帮助企业在AI落地过程中进一步实现降本增效,华为云推出AI黑科技--弹性训练. 今年,AI界最被热议 ...

- 分布式缓存服务DCS:企业版性能更强,稳定性更高

摘要:企业版性能指标达到业界TOP1,行业领先30%,内核态实现真正多线程. 一.背景介绍 近年来,随着各行业业务需求急速增加,数据量和并发访问量呈指数级增长,原来只能依附于关系型数据库的传统&quo ...

- “互联网+”大赛之AI创新应用赛题攻略:大胆脑洞,共绘智慧生活蓝图

摘要:本次"互联网+"大赛AI创新应用赛题的设置是希望学生可以从日常实际应用需求出发,结合自己的奇思妙想,提升智能终端用户的使用体验,为构建万物互联的智能世界贡献一份力量. 本文分 ...