k8s集群中部署prometheus server

1、概述

本文档主要介绍如何在k8s集群中部署prometheus server用来作为监控的数据采集服务器,这样做可以很方便的对k8s集群中的指标、pod的、节点的指标进行采集和监控。

2、下载镜像并且上传到本地的habor

可以先将prometheus server的镜像下载并且导入到本地的镜像仓库中。

镜像版本信息

docker pull prom/prometheus:v2.33.13、节点添加标签

为了保证prometheus的数据可以在重启或者重新调度之后依然在一个主机上,可以考虑设置节点标签,然后通过标签的方式将pod绑定到该节点上,当然也可以用pvc的方式。

3.1、查看节点的标签

[root@nccztsjb-node-23 ~]# kubectl get nodes --show-labels

NAME STATUS ROLES AGE VERSION LABELS

nccztsjb-node-23 Ready control-plane,master 23d v1.23.2 beta.kubernetes.io/arch=amd64,beta.kubernetes.io/os=linux,kubernetes.io/arch=amd64,kubernetes.io/hostname=nccztsjb-node-23,kubernetes.io/os=linux,node-role.kubernetes.io/control-plane=,node-role.kubernetes.io/master=,node.kubernetes.io/exclude-from-external-load-balancers=

nccztsjb-node-24 Ready <none> 23d v1.23.2 beta.kubernetes.io/arch=amd64,beta.kubernetes.io/os=linux,kubernetes.io/arch=amd64,kubernetes.io/hostname=nccztsjb-node-24,kubernetes.io/os=linux

nccztsjb-node-25 Ready ingress 23d v1.23.2 beta.kubernetes.io/arch=amd64,beta.kubernetes.io/os=linux,kubernetes.io/arch=amd64,kubernetes.io/hostname=nccztsjb-node-25,kubernetes.io/os=linux,node-role.kubernetes.io/ingress=

[root@nccztsjb-node-23 ~]# 3.2、在nccztsjb-node-25加入标签

[root@nccztsjb-node-23 ~]# kubectl label node nccztsjb-node-25 node-role.kubernetes.io/prometheus-server=

node/nccztsjb-node-25 labeled

[root@nccztsjb-node-23 ~]# kubectl get nodes

NAME STATUS ROLES AGE VERSION

nccztsjb-node-23 Ready control-plane,master 23d v1.23.2

nccztsjb-node-24 Ready <none> 23d v1.23.2

nccztsjb-node-25 Ready ingress,prometheus-server 23d v1.23.2标签已经增加。

4、创建yaml配置文件

cat >prometheus.yaml <<EOF

---

# 创建命名空间

apiVersion: v1

kind: Namespace

metadata:

name: monitoring

---

# 创建serviceaccount

apiVersion: v1

kind: ServiceAccount

metadata:

name: prometheus

namespace: monitoring

---

# 对serviceaccount进行授权绑定,给cluster-admin角色权限

apiVersion: rbac.authorization.k8s.io/v1

kind: ClusterRoleBinding

metadata:

name: prometheus

roleRef:

apiGroup: rbac.authorization.k8s.io

kind: ClusterRole

name: cluster-admin

subjects:

- kind: ServiceAccount

name: prometheus

namespace: monitoring

---

# 创建configmap用来指定配置,本例主要是获取cadvisor数据即容器数据

apiVersion: v1

kind: ConfigMap

metadata:

name: prometheus-config

labels:

name: prometheus-config

namespace: monitoring

data:

prometheus.yml: |-

global:

scrape_interval: 5s

evaluation_interval: 5s

rule_files:

- /etc/prometheus/prometheus.rules

alerting:

alertmanagers:

- scheme: http

static_configs:

- targets:

- "alertmanager.monitoring.svc:9093"

scrape_configs:

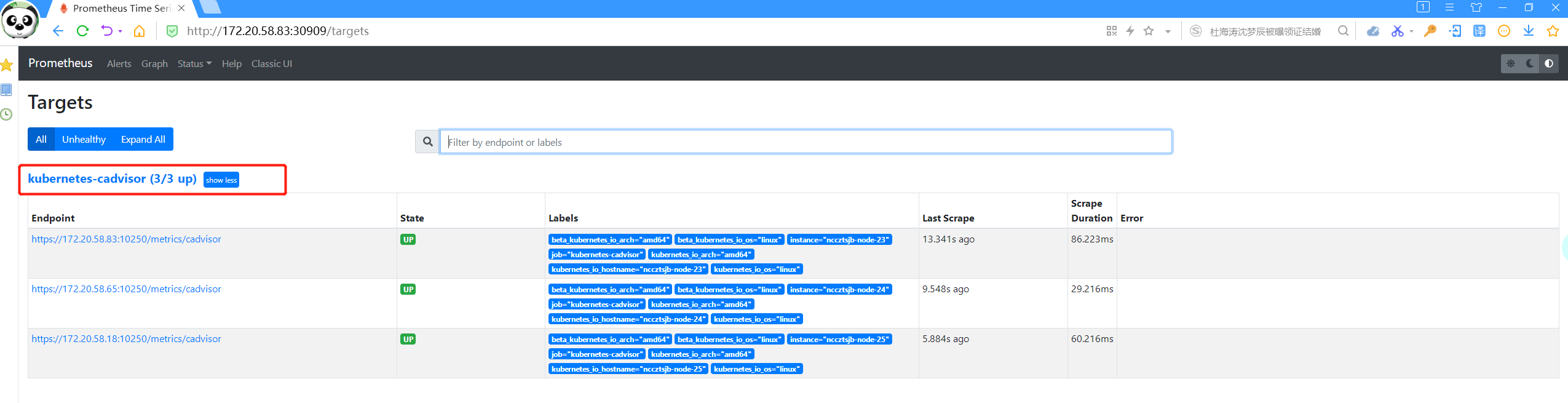

- job_name: "kubernetes-cadvisor"

scrape_interval: 10s

scrape_timeout: 10s

scheme: https #要加,否则默认使用http的协议

metrics_path: /metrics/cadvisor

tls_config:

ca_file: /var/run/secrets/kubernetes.io/serviceaccount/ca.crt

insecure_skip_verify: true

authorization:

credentials_file: /var/run/secrets/kubernetes.io/serviceaccount/token

kubernetes_sd_configs:

- role: node

relabel_configs:

- action: labelmap

regex: __meta_kubernetes_node_label_(.+)

---

#创建deployment

apiVersion: apps/v1

kind: Deployment

metadata:

name: prometheus

namespace: monitoring

spec:

selector:

matchLabels:

app: prometheus

replicas: 1

template:

metadata:

labels:

app: prometheus

spec:

securityContext:

runAsUser: 0

runAsGroup: 0

fsGroup: 0

serviceAccountName: prometheus

containers:

- name: prometheus

image: 172.20.58.152/prom/prometheus:v2.33.1

ports:

- containerPort: 9090

name: default

resources:

requests:

cpu: 500m

memory: 500M

limits:

cpu: 1

memory: 1Gi

volumeMounts:

- name: config-volume

mountPath: /etc/prometheus

- name: prometheus-data

mountPath: /prometheus

volumes:

- name: config-volume

configMap:

name: prometheus-config

- name: prometheus-data #设置数据存储盘在本地

hostPath:

path: /data/prometheus/data

type: ""

nodeSelector:

node-role.kubernetes.io/prometheus-server: "" #使用3中创建的标签

---

# 创建service可以用于外部的访问,端口30909

kind: Service

apiVersion: v1

metadata:

name: prometheus

namespace: monitoring

spec:

selector:

app: prometheus

type: LoadBalancer

ports:

- protocol: TCP

port: 9090

targetPort: 9090

nodePort: 30909

EOF5、安装delployment

基于4中创建的yaml配置文件来部署deploymetn

[root@nccztsjb-node-23 ~]# kubectl apply -f prometheus.yaml

namespace/monitoring created

serviceaccount/prometheus created

clusterrolebinding.rbac.authorization.k8s.io/prometheus created

configmap/prometheus-config created

deployment.apps/prometheus created

service/prometheus created查看创建的pod

[root@nccztsjb-node-23 ~]# kubectl get pod -n monitoring -o wide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES

prometheus-55b9769449-2tq4l 1/1 Running 0 51s 172.39.21.81 nccztsjb-node-25 <none> <none>

[root@nccztsjb-node-23 ~]# 已经运行并且是运行在节点nccztsjb-node-25上的。

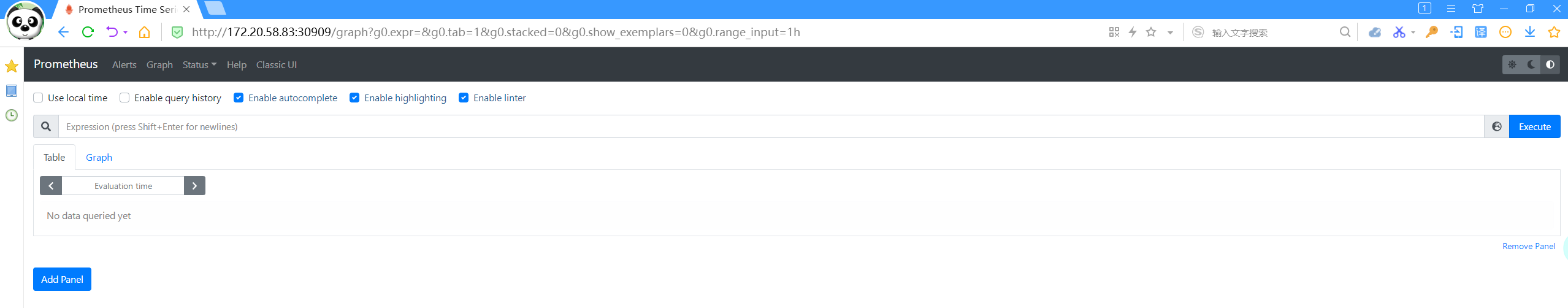

6、访问prometheus

prometheus本身是包含了一个web界面的,可以通过service直接访问。

查看service

[root@nccztsjb-node-23 ~]# kubectl get svc -n monitoring

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

prometheus LoadBalancer 10.98.172.41 <pending> 9090:30909/TCP 2m28s

[root@nccztsjb-node-23 ~]# 使用任意的节点IP:30909进行访问

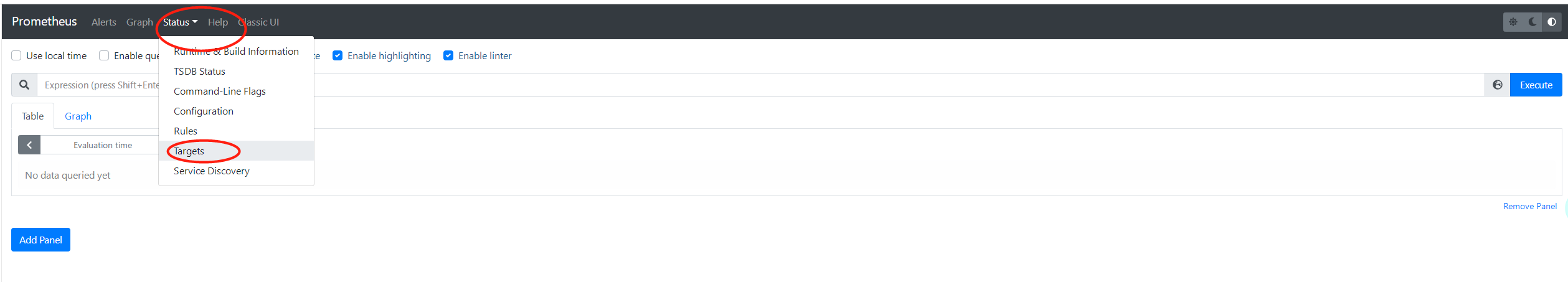

status->targets可以看到target的信息

OK,可以看到配置的job的信息。

以上就是在k8s中部署prometheus server的过程,如果想要更改prometheus.yml的配置,修改configmap就可以。

后面会有部署node export和通过grafana显示的部署过程。

k8s集群中部署prometheus server的更多相关文章

- 终于解决 k8s 集群中部署 nodelocaldns 的问题

自从开始在 kubernetes 集群中部署 nodelocaldns 以提高 dns 解析性能以来,一直被一个问题困扰,只要一部署 nodelocaldns ,在 coredns 中添加的 rewr ...

- 实操教程丨如何在K8S集群中部署Traefik Ingress Controller

注:本文使用的Traefik为1.x的版本 在生产环境中,我们常常需要控制来自互联网的外部进入集群中,而这恰巧是Ingress的职责. Ingress的主要目的是将HTTP和HTTPS从集群外部暴露给 ...

- k8s集群中部署Rook-Ceph高可用集群

先决条件 为确保您有一个准备就绪的 Kubernetes 集群Rook,您可以按照这些说明进行操作. 为了配置 Ceph 存储集群,至少需要以下本地存储选项之一: 原始设备(无分区或格式化文件系统) ...

- 使用Kubeadm创建k8s集群之部署规划(三十)

前言 上一篇我们讲述了使用Kubectl管理k8s集群,那么接下来,我们将使用kubeadm来启动k8s集群. 部署k8s集群存在一定的挑战,尤其是部署高可用的k8s集群更是颇为复杂(后续会讲).因此 ...

- K8S集群安装部署

K8S集群安装部署 参考地址:https://www.cnblogs.com/xkops/p/6169034.html 1. 确保系统已经安装epel-release源 # yum -y inst ...

- docker swarm英文文档学习-8-在集群中部署服务

Deploy services to a swarm在集群中部署服务 集群服务使用声明式模型,这意味着你需要定义服务的所需状态,并依赖Docker来维护该状态.该状态包括以下信息(但不限于): 应该运 ...

- k8s 集群中的etcd故障解决

一次在k8s集群中创建实例发现etcd集群状态出现连接失败状况,导致创建实例失败.于是排查了一下原因. 问题来源 下面是etcd集群健康状态: [root@docker01 ~]# cd /opt/k ...

- 将 master 节点服务器从 k8s 集群中移除并重新加入

背景 1 台 master 加入集群后发现忘了修改主机名,而在 k8s 集群中修改节点主机名非常麻烦,不如将 master 退出集群改名并重新加入集群(前提是用的是高可用集群). 操作步骤 ssh 登 ...

- k8s集群中遇到etcd集群故障的排查思路

一次在k8s集群中创建实例发现etcd集群状态出现连接失败状况,导致创建实例失败.于是排查了一下原因. 问题来源 下面是etcd集群健康状态: 1 2 3 4 5 6 7 8 9 10 11 [roo ...

随机推荐

- 基于ShardingJDBC的分库分表及读写分离整理

ShardingJDBC的核心流程主要分成六个步骤,分别是:SQL解析->SQL优化->SQL路由->SQL改写->SQL执行->结果归并,流程图如下: sharding ...

- 第10组 Beta冲刺 (2/5)

1.1基本情况 ·队名:今晚不睡觉 ·组长博客:https://www.cnblogs.com/cpandbb/p/14015412.html ·作业博客:https://edu.cnblogs.co ...

- Mysql高性能优化

一.背景 最近公司项目添加新功能,上线后发现有些功能的列表查询时间很久.原因是新功能用到旧功能的接口,而这些旧接口的 SQL 查询语句关联5,6张表且编写不够规范,导致 MySQL 在执行 SQL 语 ...

- vue使用npm安装sass

npm install --save-dev sass-loader style-loader css-loader npm install --save-dev extract-text-webpa ...

- 【漏洞复现】CVE-2022–21661 WordPress核心框架WP_Query SQL注入漏洞原理分析与复现

影响版本 wordpress < 5.8.3 分析 参考:https://blog.csdn.net/qq_46717339/article/details/122431779 在 5.8.3 ...

- Android官方文档翻译 二 1.Building Your First App

Building Your First App 创建你的第一个App项目 Dependencies and prerequisites 依赖关系和先决条件 * Android SDK * ADT Pl ...

- Javascript中常用事件集合和事件使用方法

Javascript中常用事件集合和事件使用方法 一.事件绑定 格式: 事件源 . on事件类型=事件处理函数 事件绑定三要素 1.事件源:和谁绑定 2.事件类型:什么事件 3.事件处理函数:触发了要 ...

- JavaScript DOM 基础操作

JavaScript DOM 基础操作 一.获取元素的六方式 document.getElementById('id名称') //根据id名称获取 document.getElementsByclas ...

- 打印十字码 DataMatrix

nuget 安装 DataMatrix.net //示例 DmtxImageEncoder Die = new DmtxImageEncoder(); DataMatrix.net.DmtxImage ...

- 【算法】Manacher算法

最长回文串问题 manacher算法是用来求解最长回文串的问题.最长回文串的解法一般有暴力法.动态规划.中心扩展法和manacher算法. 暴力法的时间复杂度为\(O(n^3)\),一般都会超时: 动 ...