python爬虫(2)——urllib、get和post请求、异常处理、浏览器伪装

urllib基础

urlretrieve()

urlretrieve(网址,本地文件存储地址) 直接下载网页到本地

import urllib.request

#urlretrieve(网址,本地文件存储地址) 直接下载网页到本地

urllib.request.urlretrieve("http://www.baidu.com","dld.html")

urlcleanup()

清除缓存

urllib.request.urlcleanup()

info()

查看网页简介

file=urllib.request.urlopen("http://www.baidu.com")

print(file.info())

getcode()

输出网页爬取状态码,200为正常,其他都不正常

file=urllib.request.urlopen("http://www.baidu.com")

print(file.getcode())

geturl()

获取当前访问的网页的url

file=urllib.request.urlopen("http://www.baidu.com")

print(file.geturl())

超时设置

timeout设置为多少秒才判断超时

import urllib.request

for i in range(1000):

try:

file = urllib.request.urlopen("https://www.cnblogs.com/mcq1999/", timeout=1)

print(len(file.read().decode("utf-8")))

except Exception as e:

print("出现异常")

自动模拟HTTP请求

get请求

模拟百度搜索python:

import urllib.request

import re

keywd="python"

url="http://www.baidu.com/s?wd="+keywd

data=urllib.request.urlopen(url).read().decode("utf-8")

pat='{"title":"(.*?)",'

res=re.compile(pat).findall(data)

print(res)

关键字为中文:

import urllib.request

import re

keywd="百度"

keywd=urllib.request.quote(keywd) #如果有中文

url="http://www.baidu.com/s?wd="+keywd

data=urllib.request.urlopen(url).read().decode("utf-8")

pat='{"title":"(.*?)",'

res=re.compile(pat).findall(data)

print(res)

提取前1~10页:

import urllib.request

import re

keywd="百度"

keywd=urllib.request.quote(keywd) #如果有中文

# 页码公式:page=(num-1)*10

for i in range(1,11):

url="http://www.baidu.com/s?wd="+keywd+"&pn="+str((i-1)*10)

data=urllib.request.urlopen(url).read().decode("utf-8")

pat='{"title":"(.*?)",'

res=re.compile(pat).findall(data)

for j in range(len(res)):

print(res[j])

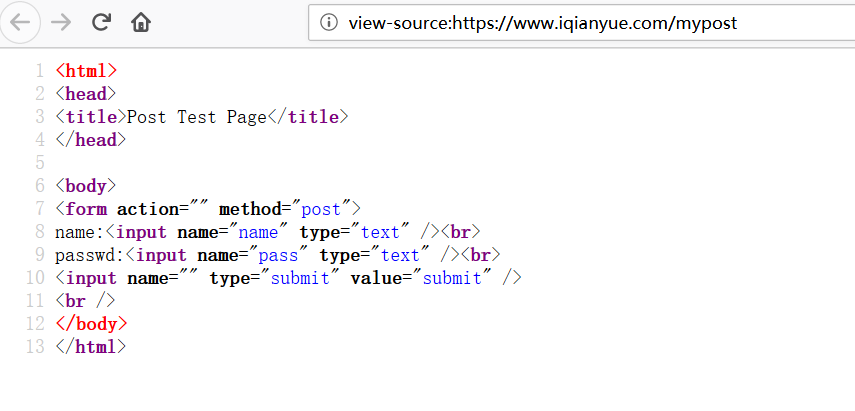

post请求

import urllib.request

import urllib.parse

posturl="https://www.iqianyue.com/mypost"

postdata=urllib.parse.urlencode({

"name":"mcq@163.com",

"pass":"123456",

}).encode("utf-8")

#进行post,需要使用urllib.request下面的Request(真实post地址,post数据)

req=urllib.request.Request(posturl,postdata)

res=urllib.request.urlopen(req).read().decode("utf-8")

print(res)

fh=open("post.html","w")

fh.write(res)

爬虫的异常处理

如果没有异常处理,爬虫遇到异常时就会直接崩溃停止运行,下次再次运行时,又会从头开始,所以,要开发一个具有顽强生命力的爬虫,必须要进行异常处理。

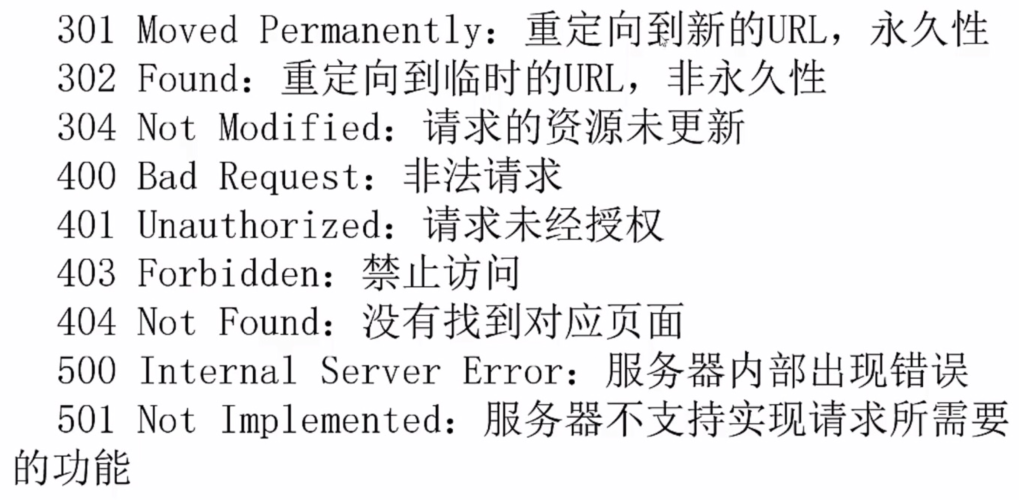

常见状态码及含义

HTTPError和URLError

两者都是异常处理的类,HTTPError是URLError的子类,HTTPError有异常状态码与异常原因,URLError没有异常状态码,所以在处理的时候,不能使用URLError直接代替HTTPError。如果要代替,必须要判断是否有状态码属性。

URLError出现的原因:

- 连不上服务器

- 远程url不存在

- 无网络

- 触发HTTPError

import urllib.request

import urllib.error

for i in range(20):

try:

urllib.request.urlopen("https://www.cnblogs.com/mcq1999/p/python_Crawler_1.html")

print("gg")

except urllib.error.URLError as e:

if hasattr(e,"code"):

print(e.code)

if hasattr(e,"reason"):

print(e.reason)

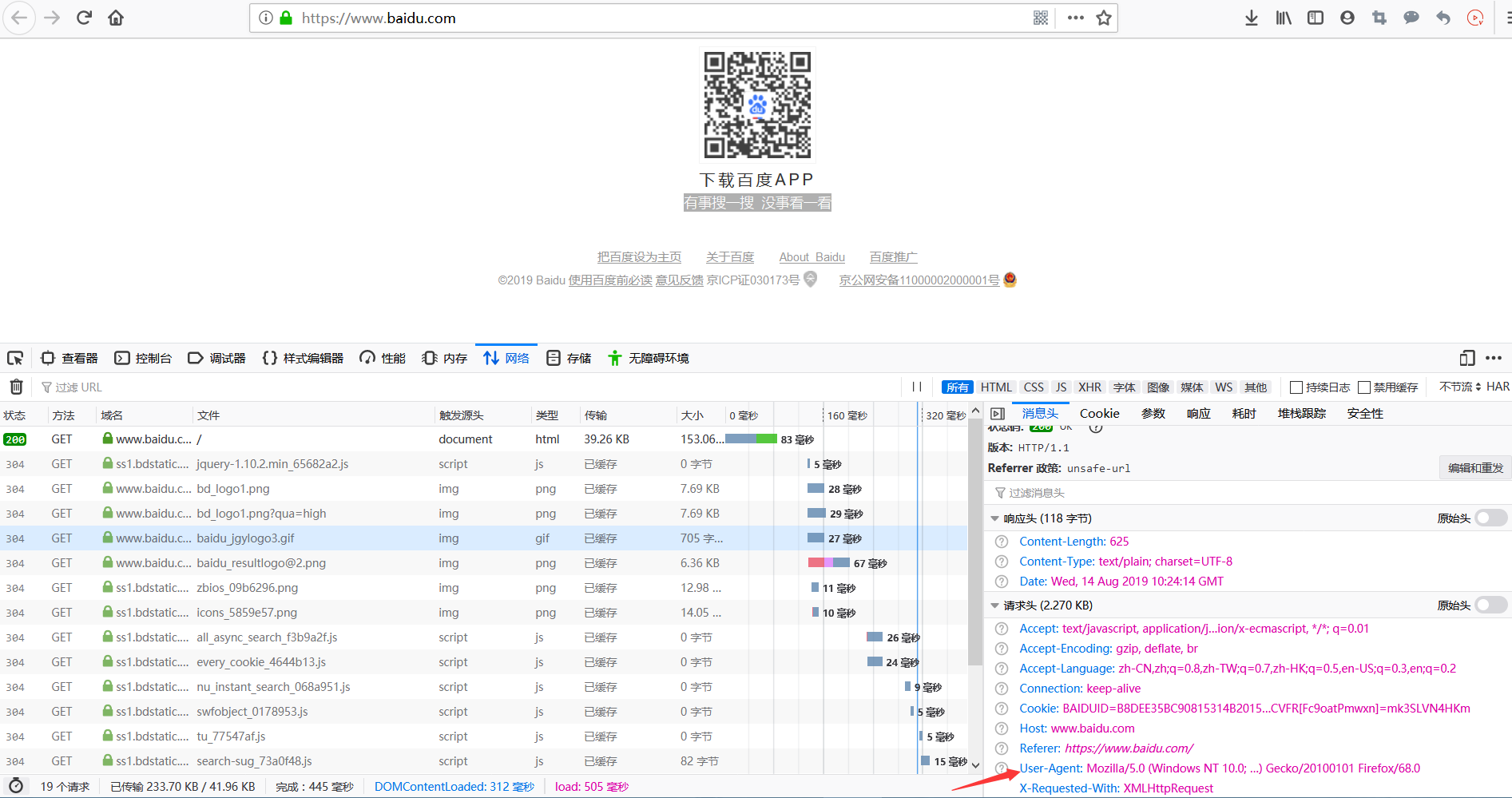

浏览器伪装技术

有的网站爬取的时候会返回403,因为对方服务器会对爬虫进行屏蔽。此时,我们要伪装成浏览器才能爬取。

浏览器伪装一般通过报头实现。

由于urlopen()对于一些HTTP的高级功能不支持,所以要修改报头,可以使用urllib.request.build_opener()或urllib.request.Request()下的add_header()实现浏览器的模拟。

opener的全局安装在下面的糗事百科爬虫里有应用

import urllib.request

url="https://blog.csdn.net/"

#头文件格式header=("User-Agent",具体用户代理制)

headers=("User-Agent","Mozilla/5.0 (Windows NT 10.0; Win64; x64; rv:68.0) Gecko/20100101 Firefox/68.0")

opener=urllib.request.build_opener()

opener.addheaders=[headers]

data=opener.open(url).read()

fh=open("ua.html","wb")

fh.write(data)

fh.close()

python新闻爬虫实战

需求:将新浪新闻首页所有新闻都爬倒本地

思路:先爬首页,通过正则表达式获取所有新闻链接,然后依次爬各新闻,并存储到本地

import urllib.request

import re

url="https://news.sina.com.cn/"

data=urllib.request.urlopen(url).read().decode("utf-8","ignore") #忽略有异常的编码

pat1='<a target="_blank" href="(.*?)"'

alllink=re.compile(pat1).findall(data)

for i in range(len(alllink)):

thislink=alllink[i]

urllib.request.urlopen(thislink).read().decode("utf-8","ignore")

urllib.request.urlretrieve(thislink,"news/"+str(i)+".html")

糗事百科爬取

目标1:爬取糗事百科首页的内容(包括视频、图片)

涉及伪装浏览器、opener安装为全局等知识

import urllib.request

import re

url="https://www.qiushibaike.com/"

#测试是否需要伪装浏览器

try:

urllib.request.urlopen(url)

except Exception as e:

print(e)

#显示Remote end closed connection without response,要伪装

headers=("User-Agent","Mozilla/5.0 (Windows NT 10.0; Win64; x64; rv:68.0) Gecko/20100101 Firefox/68.0")

opener=urllib.request.build_opener()

opener.addheaders=[headers]

urllib.request.install_opener(opener) #安装为全局

data=urllib.request.urlopen(url).read().decode("utf-8","ignore")

pat='<a class="recmd-content" href="/(.*?)"'

alllink=re.compile(pat).findall(data)

for i in range(len(alllink)):

realurl=url+alllink[i]

print(realurl)

urllib.request.urlretrieve(realurl,"糗事百科/"+str(i)+".html")

目标2:爬取1~10页的文章

import urllib.request

import re

headers=("User-Agent","Mozilla/5.0 (Windows NT 10.0; Win64; x64; rv:68.0) Gecko/20100101 Firefox/68.0")

opener=urllib.request.build_opener()

opener.addheaders=[headers]

urllib.request.install_opener(opener) #安装为全局

for i in range(10):

thisurl="https://www.qiushibaike.com/text/page/"+str(i+1)+"/";

data=urllib.request.urlopen(thisurl).read().decode("utf-8","ignore")

pat='<div class="content">.*?<span>(.*?)</span>.*?</div>'

res=re.compile(pat,re.S).findall(data)

for j in range(len(res)):

print(res[j])

print('---------------------')

python爬虫(2)——urllib、get和post请求、异常处理、浏览器伪装的更多相关文章

- python爬虫之urllib库(三)

python爬虫之urllib库(三) urllib库 访问网页都是通过HTTP协议进行的,而HTTP协议是一种无状态的协议,即记不住来者何人.举个栗子,天猫上买东西,需要先登录天猫账号进入主页,再去 ...

- python爬虫之urllib库(二)

python爬虫之urllib库(二) urllib库 超时设置 网页长时间无法响应的,系统会判断网页超时,无法打开网页.对于爬虫而言,我们作为网页的访问者,不能一直等着服务器给我们返回错误信息,耗费 ...

- python爬虫之urllib库(一)

python爬虫之urllib库(一) urllib库 urllib库是python提供的一种用于操作URL的模块,python2中是urllib和urllib2两个库文件,python3中整合在了u ...

- Python爬虫之urllib模块2

Python爬虫之urllib模块2 本文来自网友投稿 作者:PG-55,一个待毕业待就业的二流大学生. 看了一下上一节的反馈,有些同学认为这个没什么意义,也有的同学觉得太简单,关于Beautiful ...

- Python爬虫之urllib模块1

Python爬虫之urllib模块1 本文来自网友投稿.作者PG,一个待毕业待就业二流大学生.玄魂工作室未对该文章内容做任何改变. 因为本人一直对推理悬疑比较感兴趣,所以这次爬取的网站也是平时看一些悬 ...

- Python爬虫之urllib.parse详解

Python爬虫之urllib.parse 转载地址 Python 中的 urllib.parse 模块提供了很多解析和组建 URL 的函数. 解析url 解析url( urlparse() ) ur ...

- 第三百二十八节,web爬虫讲解2—urllib库爬虫—状态吗—异常处理—浏览器伪装技术、设置用户代理

第三百二十八节,web爬虫讲解2—urllib库爬虫—状态吗—异常处理—浏览器伪装技术.设置用户代理 如果爬虫没有异常处理,那么爬行中一旦出现错误,程序将崩溃停止工作,有异常处理即使出现错误也能继续执 ...

- python爬虫之urllib库介绍

一.urllib库 urllib是Python自带的一个用于爬虫的库,其主要作用就是可以通过代码模拟浏览器发送请求.其常被用到的子模块在Python3中的为urllib.request和urllib. ...

- 小白学 Python 爬虫(32):异步请求库 AIOHTTP 基础入门

人生苦短,我用 Python 前文传送门: 小白学 Python 爬虫(1):开篇 小白学 Python 爬虫(2):前置准备(一)基本类库的安装 小白学 Python 爬虫(3):前置准备(二)Li ...

- Python 爬虫之urllib库的使用

urllib库 urllib库是Python中一个最基本的网络请求库.可以模拟浏览器的行为,向指定的服务器发送一个请求,并可以保存服务器返回的数据. urlopen函数: 在Python3的urlli ...

随机推荐

- Raspberry Pi (树莓派) 更换源 - stretch 版本

Raspberry Pi 默认更新源访问速度慢,更换国内源速度提升.更换软件更新源 (/etc/apt/sources.list),更换系统更新源 (/etc/apt/sources.d/raspi. ...

- 使用scale等比例缩放图片

功能需求: 在下拉框中选择你所需要缩放的比例, 选择好了之后,图片会按照你选择的比例进行缩放 1==>如何获取select中option选中的值 在select添加事件change 和双向绑定v ...

- R-3 t分布--t置信区间--t检验

本节内容: 1:t分布存在的意义是什么 2:t分布的置信区间 3:t分布检验 一.t分布存在的意义是什么 数据分析中有一块很大的版图是属于均值对比的,应用广泛. 例如:对比试验前后病人的症状,证明某种 ...

- export 与 export default区别

export 输出对应 import 语句需要使用大括号 { } export 命令后面是输出指定对外接口,实质是在接口名与模块内部变量之间建立一一对应的关系 export 命令可以出现在模块的任何位 ...

- LeetCode 1243 数组变换

地址 https://leetcode-cn.com/contest/biweekly-contest-12/problems/array-transformation/ 首先,给你一个初始数组 ar ...

- 【Sublime Text】sublime修改默认浏览器及使用不同浏览器打开网页的快捷键设置

#第一步:安装SideBarEnhancements插件 下载插件,需要“翻墙”,故提供一下该插件的github地址:https://github.com/titoBouzout/SideBarEnh ...

- C++入门到理解阶段二基础篇(1)——简介与环境安装

1.C++ 简介 C++ 是一种静态类型的.编译式的.通用的.大小写敏感的.不规则的编程语言,支持过程化编程.面向对象编程和泛型编程. C++ 被认为是一种中级语言,它综合了高级语言和低级语言的特点. ...

- Flink中Idle停滞流机制(源码分析)

前几天在社区群上,有人问了一个问题 既然上游最小水印会决定窗口触发,那如果我上游其中一条流突然没有了数据,我的窗口还会继续触发吗? 看到这个问题,我蒙了???? 对哈,因为我是选择上游所有流中水印最小 ...

- cl_demo_output=>display 介绍

Methods of CL_DEMO_OUTPUT PS:自己测试是display后的内表不能带表头. 类CL_DEMO_OUTPUT 在示例程序中创造了很多简单的数据输出的方法而不需要经典的list ...

- 深入理解AbstractQueuedSynchronizer(AQS)

本人免费整理了Java高级资料,涵盖了Java.Redis.MongoDB.MySQL.Zookeeper.Spring Cloud.Dubbo高并发分布式等教程,一共30G,需要自己领取.传送门:h ...