python爬取豆瓣视频信息代码

这里是爬取豆瓣视频信息,用pyquery库(jquery的python库)。

一:代码

from urllib.request import quote

from pyquery import PyQuery as pq

import requests

import pandas as pd

def get_text_page(movie_name):

'''

函数功能:获得指定电影名的源代码

参数:电影名

返回值:电影名结果的源代码

'''

url = 'https://www.douban.com/search?q=' + movie_name

headers = {

'Host' : 'www.douban.com',

'User-Agent': 'Mozilla/5.0 (Windows NT 6.1; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/75.0.3770.90 Safari/537.36',

}

r = requests.get(url,headers = headers,timeout=5)

return r.text

def get_last_url(this_text):

'''

函数功能:根据指定的源代码得到最终的网页地址

参数:搜索结果源代码

返回值:最终的网页地址

'''

doc = pq(this_text)

lis = doc('.title a').items()

k = 0

this_str = ''

for i in lis:

# print('豆瓣搜索结果为:{0}'.format(i.text()))

# print('地址为:{0}'.format(i.attr.href))

# print('\n')

if k == 0:

this_str = i.attr.href

k += 1

return this_str

def the_last_page(this_url):

'''

函数功能:获得最终电影网页的源代码

参数:最终的地址

返回值:最终电影网页的源代码

'''

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 6.1; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/75.0.3770.90 Safari/537.36',

}

r = requests.get(this_url,headers = headers,timeout=20)

return r.text

def the_last_text(this_text,movie_name):

'''

函数功能:获得每一项的数据

参数:爬取页面的源代码

返回值:返回空

'''

doc = pq(this_text)

# 获取标题

title = doc('#content h1').text()

# 获取海报

photo = doc('.nbgnbg img')

photo_url = photo.attr.src

r = requests.get(photo_url)

with open('{m}.jpg'.format(m = movie_name),'wb') as f:

f.write(r.content)

# 电影信息

message = doc('#info').text()

# 豆瓣评分

grade = doc('#interest_sectl').text()

# 剧情

things = doc('.related-info').text()

with open('{0}.txt'.format(movie_name),'w+') as f:

try:

f.writelines([title,'\n','\n\n',message,'\n\n',grade,'\n\n',things])

except:

f.writelines([title,'\n','\n\n',message,'\n\n',grade])

# 演员

# 演员名

name = []

person_name = doc('.info').items()

for i in person_name:

name.append(i.text())

# 演员图片地址

person_photo = doc('#celebrities')

j = 0

for i in person_photo .find('.avatar').items():

m = i.attr('style')

person_download_url = m[m.find('(') + 1:m.find(')')]

# 下载演员地址

r = requests.get(person_download_url)

try:

with open('{name}.jpg'.format(name = name[j]),'wb') as f:

f.write(r.content)

except:

continue

j += 1

def lookUrl(this_text,my_str):

'''

函数功能:获得观看链接

参数:爬取页面的源代码

返回值:返回空

'''

doc = pq(this_text)

all_url = doc('.bs li a').items()

movie_f = []

movie_url = []

for i in all_url:

movie_f.append(i.text())

movie_url.append(i.attr.href)

dataframe = pd.DataFrame({'观看平台':movie_f,'观看地址':movie_url})

dataframe.to_csv("{movie_name}的观看地址.csv".format(movie_name = my_str),index=False,encoding = 'utf_8_sig',sep=',')

def main():

name = input('')

my_str = name

movie_name = quote(my_str)

page_text = get_text_page(movie_name) # 得指定电影名的源代码

last_url = get_last_url(page_text) # 根据指定的源代码得到最终的网页地址

page_text2 = the_last_page(last_url) # 获得最终电影网页的源代码

the_last_text(page_text2,my_str) # 获得每一项的数据

lookUrl(page_text2,my_str) # 得到并处理观看链接

main()

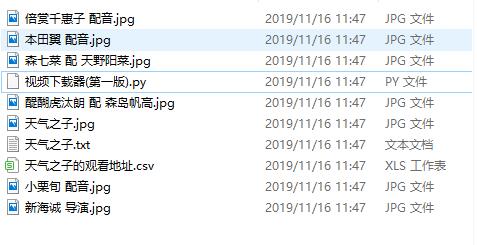

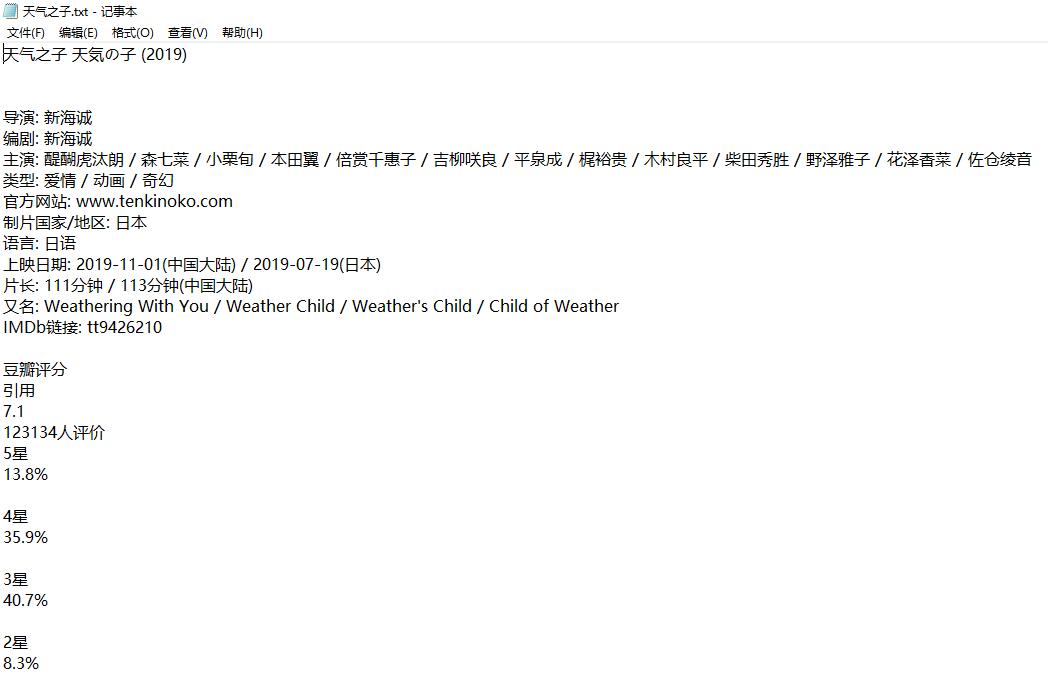

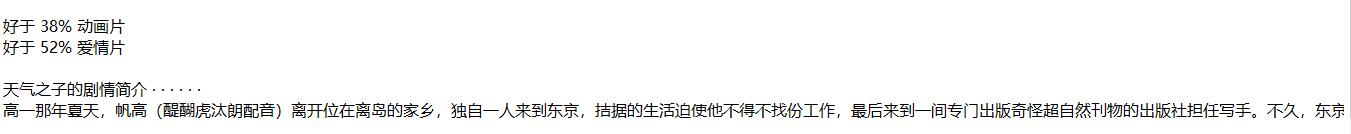

二:结果如下(部分例子)

1.输入天气之子

2.输入百变小樱魔法卡

必须是已经上映的电影才有观看地址

3.独立日

python爬取豆瓣视频信息代码的更多相关文章

- python 爬取豆瓣书籍信息

继爬取 猫眼电影TOP100榜单 之后,再来爬一下豆瓣的书籍信息(主要是书的信息,评分及占比,评论并未爬取).原创,转载请联系我. 需求:爬取豆瓣某类型标签下的所有书籍的详细信息及评分 语言:pyth ...

- python爬取豆瓣电影信息数据

题外话+ 大家好啊,最近自己在做一个属于自己的博客网站(准备辞职回家养老了,明年再战)在家里 琐事也很多, 加上自己 一回到家就懒了(主要是家里冷啊! 广东十几度,老家几度,躲在被窝瑟瑟发抖,) 由于 ...

- python 爬取bilibili 视频信息

抓包时发现子菜单请求数据时一般需要rid,但的确存在一些如游戏->游戏赛事不使用rid,对于这种未进行处理,此外rid一般在主菜单的响应中,但有的如番剧这种,rid在子菜单的url中,此外返回的 ...

- 利用Python爬取豆瓣电影

目标:使用Python爬取豆瓣电影并保存MongoDB数据库中 我们先来看一下通过浏览器的方式来筛选某些特定的电影: 我们把URL来复制出来分析分析: https://movie.douban.com ...

- python爬取网页的通用代码框架

python爬取网页的通用代码框架: def getHTMLText(url):#参数code缺省值为‘utf-8’(编码方式) try: r=requests.get(url,timeout=30) ...

- Python爬取豆瓣《复仇者联盟3》评论并生成乖萌的格鲁特

代码地址如下:http://www.demodashi.com/demo/13257.html 1. 需求说明 本项目基于Python爬虫,爬取豆瓣电影上关于复仇者联盟3的所有影评,并保存至本地文件. ...

- Python爬取豆瓣电影top

Python爬取豆瓣电影top250 下面以四种方法去解析数据,前面三种以插件库来解析,第四种以正则表达式去解析. xpath pyquery beaufifulsoup re 爬取信息:名称 评分 ...

- Python爬取豆瓣指定书籍的短评

Python爬取豆瓣指定书籍的短评 #!/usr/bin/python # coding=utf-8 import re import sys import time import random im ...

- 零基础爬虫----python爬取豆瓣电影top250的信息(转)

今天利用xpath写了一个小爬虫,比较适合一些爬虫新手来学习.话不多说,开始今天的正题,我会利用一个案例来介绍下xpath如何对网页进行解析的,以及如何对信息进行提取的. python环境:pytho ...

随机推荐

- CAD画三维图怎么渲染?一分钟教你快速操作

从事过CAD相关工作的都知道,CAD绘制的方式有二维平面图以及三维图形,三维图形,画三维图方式也是比较简单的.那当然三维图画完后一般还需要进行渲染操作,步骤也是比较简洁的.下面就来给大家操作一下CAD ...

- 深入浅出js实现继承的7种方式

给大家介绍7中js继承的方法 有些人认为JavaScript并不是真正的面向对象语言,在经典的面向对象语言中,您可能倾向于定义类对象,然后您可以简单地定义哪些类继承哪些类(参考C++ inherita ...

- weblogic新增域并进行Jconsole监听

一.创建域: 第一步,打开域配置界面: [bofm@UAT02-BIZ-ZJCG-AP-002 bin]$ cd /home/software/weblogic/Oracle/Middleware/w ...

- win10让屏幕壁纸动态变化某文件夹下的图片

首先,请大家在Win10系统中,点击桌面上的“开始菜单”,在开始菜单中,选择“设置”选项,进入Win10系统设置页面. 进入Win10系统设置页面以后,点击页面中的“个性化”选项,进入系统个性化页 ...

- 配置文件对数据库url的配置

jdbc:mysql://localhost:3306/db_film?serverTimezone=UTC&useUnicode=true&characterEncoding=utf ...

- Linux下环境变量(.bash_profile和.bashrc的区别)

在linux系统下,如果下载并安装了应用程序,在启动时很有可能在键入它的名称时出现"command not found"的提示内容.如果每次都到安装目标文件夹内,找到可执行文件来进 ...

- 2019 Multi-University Training Contest 1 E Path(最短路+最小割)

题意 链接:https://vjudge.net/problem/HDU-6582 给定一个有向图,可以有重边,每条边上有一个权值表示删掉这条边的代价,问最少花费多少代价能使从s到t节点的最短路径增大 ...

- js 构造函数中的 return

本文链接:https://blog.csdn.net/qq_36209248/article/details/89190978 默认情况下,没有return的函数的返回值为undefined(即没有定 ...

- 【转】Redis常见面试题

介绍:Redis 是一个开源的使用 ANSI C 语言编写.遵守 BSD 协议.支持网络.可基于内存亦可持久化的日志型.Key-Value 数据库,并提供多种语言的 API的非关系型数据库. 传统数据 ...

- git 推送本地项目到远程库

git 推送本地项目到远程库 1@DESKTOP-3H9092J MINGW64 /e/mozq/00store/01/SmartCard_MS $ git init Initialized empt ...