hadoop-hdfs编程

1、开发环境搭建

一、新建一个普通的java工程

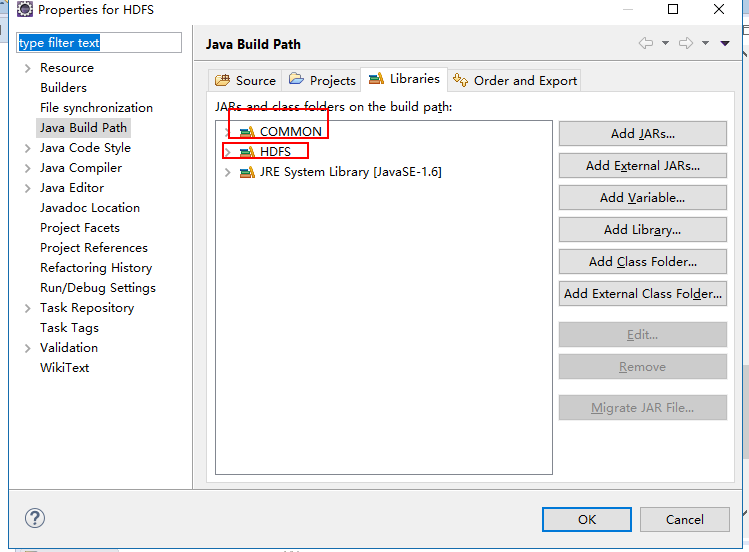

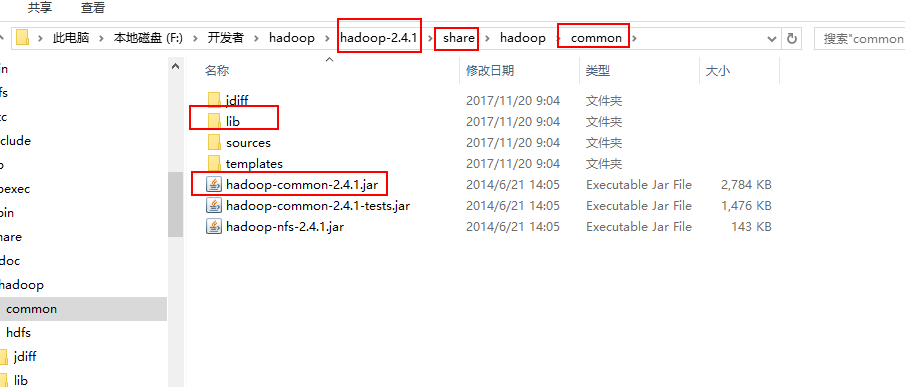

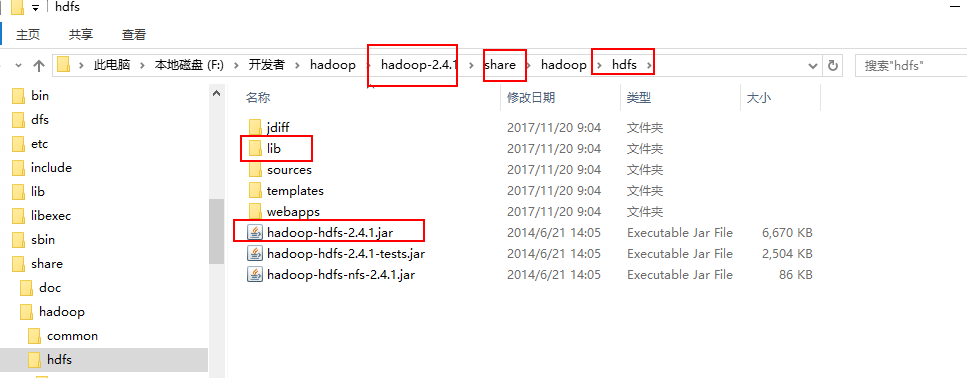

二、引入hdfs相关的jar包

需要引入的jar包:

common下的jar

hdfs下的jar

2、编写HDFS相关的程序

package com.cvicse.ump.hadoop.hdfs; import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FSDataOutputStream;

import org.apache.hadoop.fs.FileStatus;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path; public class FileOperation { //创建文件

public static void createFile(String dst,byte[] contents) throws Exception{

Configuration conf = new Configuration();

FileSystem fs = FileSystem.get(conf);

Path dstPath = new Path(dst);

FSDataOutputStream outputStream = fs.create(dstPath);;

outputStream.write(contents);

outputStream.close();

fs.close();

System.out.println(dst+",文件创建成果");

} //上传文件

public static void uploadFile(String src,String dst) throws Exception{

Configuration conf = new Configuration();

FileSystem fs = FileSystem.get(conf);

Path srcPath = new Path(src);

Path dstPath = new Path(dst);

fs.copyFromLocalFile(srcPath, dstPath);

System.out.println("Upload to "+conf.get("fs.default.name"));

System.out.println("------list files---------"+"\n");

FileStatus[] fileStatus = fs.listStatus(dstPath);

for(FileStatus file:fileStatus){

System.out.println(file.getPath());

}

fs.close(); } //删除目录

public static void delete(String filePath)throws Exception{ Configuration conf = new Configuration();

FileSystem fs = FileSystem.get(conf);

Path path = new Path(filePath);

boolean isOk = fs.deleteOnExit(path);

if(isOk){

System.out.println("delete OK.");

}else{

System.out.println("delete failure.");

}

fs.close(); }

//创建目录

public static void mkdir(String path)throws Exception{

Configuration conf = new Configuration();

FileSystem fs = FileSystem.get(conf);

Path srcPath = new Path(path);

boolean isOK = fs.mkdirs(srcPath);

if(isOK){

System.out.println("create dir ok!");

}else{

System.out.println("create dir failure!");

}

fs.close();

} //下载文件

public static void downFile(String src,String dst)throws Exception{

Configuration conf = new Configuration();

FileSystem fs = FileSystem.get(conf);

Path srcPath = new Path(src);

Path dstPath = new Path(dst); fs.copyToLocalFile(srcPath, dstPath);

System.out.println("down load over"); } public static void main(String[] args) throws Exception {

/*String dst = args[0];

byte[] contents = "hello,dyh".getBytes();

createFile(dst, contents);*/ /*String src = args[0];

String dst = args[1];

uploadFile(src, dst);*/ /*String filePath = args[0];

delete(filePath);*/ /*String path = args[0];

mkdir(path);*/ String src = args[0];

String dst = args[1];

downFile(src, dst);

} }

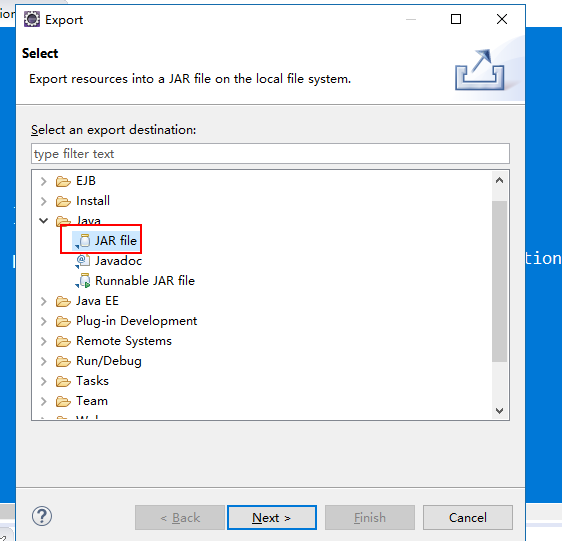

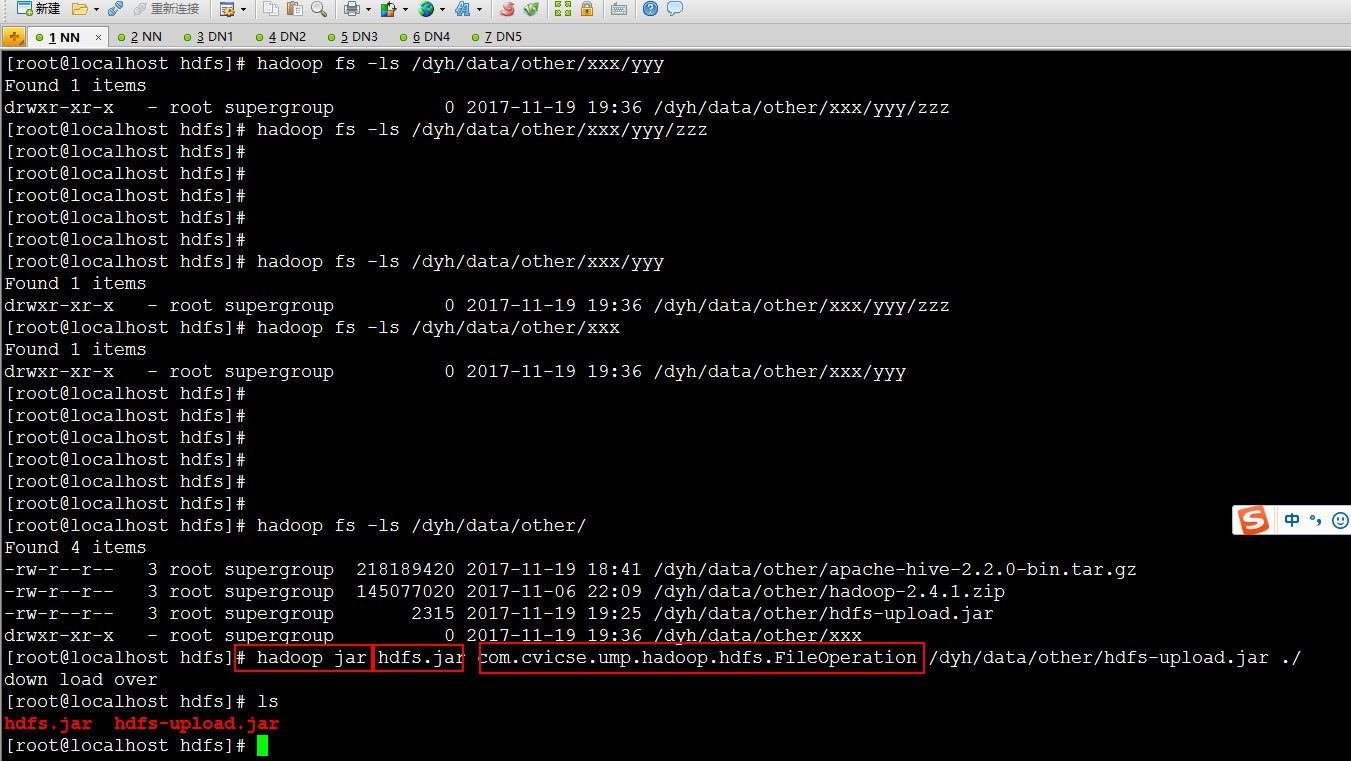

导出jar包

上传jar到HADOOP运行环境,并执行

执行命令:hadoop jar jar包名字 main函数所在的类

hadoop-hdfs编程的更多相关文章

- Hadoop HDFS编程 API入门系列之HDFS_HA(五)

不多说,直接上代码. 代码 package zhouls.bigdata.myWholeHadoop.HDFS.hdfs3; import java.io.FileInputStream;import ...

- Hadoop HDFS编程 API入门系列之简单综合版本1(四)

不多说,直接上代码. 代码 package zhouls.bigdata.myWholeHadoop.HDFS.hdfs4; import java.io.IOException; import ja ...

- Hadoop HDFS编程 API入门系列之HdfsUtil版本2(七)

不多说,直接上代码. 代码 package zhouls.bigdata.myWholeHadoop.HDFS.hdfs1; import java.io.FileInputStream;import ...

- Hadoop HDFS编程 API入门系列之HdfsUtil版本1(六)

不多说,直接上代码. 代码 package zhouls.bigdata.myWholeHadoop.HDFS.hdfs2; import java.io.FileOutputStream;impor ...

- Hadoop HDFS编程 API入门系列之合并小文件到HDFS(三)

不多说,直接上代码. 代码 package zhouls.bigdata.myWholeHadoop.HDFS.hdfs7; import java.io.IOException;import ja ...

- Hadoop HDFS编程 API入门系列之路径过滤上传多个文件到HDFS(二)

不多说,直接上代码. 代码 package zhouls.bigdata.myWholeHadoop.HDFS.hdfs6; import java.io.IOException;import jav ...

- Hadoop HDFS编程 API入门系列之从本地上传文件到HDFS(一)

不多说,直接上代码. 代码 package zhouls.bigdata.myWholeHadoop.HDFS.hdfs5; import java.io.IOException; import ja ...

- Hadoop HDFS编程 API入门系列之RPC版本2(九)

不多说,直接上代码. 代码 package zhouls.bigdata.myWholeHadoop.RPC.rpc2; public class LoginServiceImpl implement ...

- Hadoop HDFS编程 API入门系列之RPC版本1(八)

不多说,直接上代码. 代码 package zhouls.bigdata.myWholeHadoop.RPC.rpc1; import java.io.IOException;import java. ...

- Hadoop MapReduce编程 API入门系列之压缩和计数器(三十)

不多说,直接上代码. Hadoop MapReduce编程 API入门系列之小文件合并(二十九) 生成的结果,作为输入源. 代码 package zhouls.bigdata.myMapReduce. ...

随机推荐

- 使用iTextSharp导出PDF

/// <summary> /// 导出至PDF /// </summary> /// <param name="dt">数据源</par ...

- validator js验证器

转自:https://github.com/jaywcjlove/validator.js 轻量级的JavaScript表单验证,字符串验证.没有依赖,支持UMD 导入js库 <script t ...

- select for update引发死锁分析

本文针对MySQL InnoDB中在Repeatable Read的隔离级别下使用select for update可能引发的死锁问题进行分析. 1. 业务案例 业务中需要对各种类型的实体进行编号,例 ...

- Sketch webView方式插件开发技术总结

相信大家都对Sketch有一定的了解和认识.除了基础的矢量设计功能以外,插件更是让Sketch保持强大的独门秘籍.Sketch开放了第三方插件接口,设计师可以在几百种的插件中轻松找到适合自己工作方式的 ...

- arcgis javascript api 事件的监听及移除

On Style Events 方式 var mapExtentChange = map.on("extent-change", changeHandler); function ...

- 用JQuery操作元素的style属性

可以直接利用css()方法获取元素的样式属性,JQuery代码如下: 1 $("p").css("color"); //获取p元素的样式颜色 无论color属 ...

- css理论

1css语法 2css的四种引入方式 3css选择器 4css四种属性操作 5float属性操作 6盒子模型 1 css语法 CSS 规则由两个主要的部分构成:选择器,以及一条或多条声明. '' se ...

- MyCat读写分离、分库分表

系统开发中,数据库是非常重要的一个点.除了程序的本身的优化,如:SQL语句优化.代码优化,数据库的处理本身优化也是非常重要的.主从.热备.分表分库等都是系统发展迟早会遇到的技术问题问题.Mycat是一 ...

- SSM 搭建精美实用的管理系统

课程介绍 SSM 框架即 SpringMVC+Spring+Mybatis,相信各位朋友在投递简历时已直观感受到它的重要性,JavaWeb 相关工作的招聘要求中基本都包括了这三项技术能力. 由于其轻量 ...

- HTML5 canvas getImageData() 方法

下面的代码通过 getImageData() 复制画布上指定矩形的像素数据,然后通过 putImageData() 将图像数据放回画布: var c=document.getElementById(& ...