Hadoop学习笔记(2)-HDFS的基本操作(Shell命令)

在这里我给大家继续分享一些关于HDFS分布式文件的经验哈,其中包括一些hdfs的基本的shell命令的操作,再加上hdfs java程序设计。在前面我已经写了关于如何去搭建hadoop这样一个大数据平台,还没搭好环境的童鞋可以转到我写的这篇文章Hadoop在Ubuntu的安装,接下来就开始我们本次的经验分享啦。

HDFS的Shell命令操作

HDFS的格式化与启动

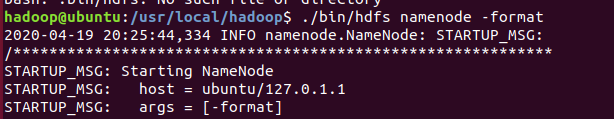

首次使用HDFS时,需要使用format 命令进行格式化

./bin/hdfs namenode -format

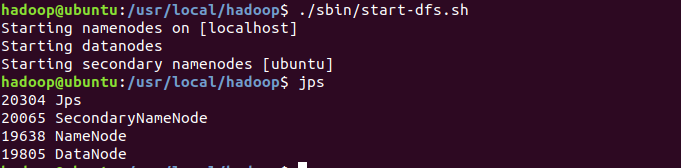

使用start-dfs.sh命令启动HDFS,可 使用JPS命令查看是否成功启动

./sbin/start-dfs.sh

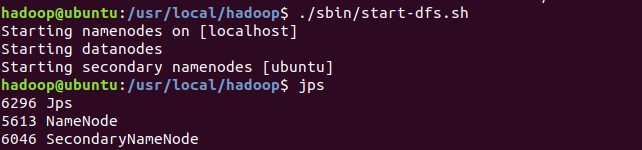

下面的图片是启动失败的截图,那么怎么解决这个问题呢。

HDFS启动失败

首先需要停止hdfs,这也是操作完hdfs的必要步骤。

./sbin/stop-dfs.sh

删除tmp/dfs目录下的data文件夹

rm -r ./tmp/dfs/data

最后重新执行HDFS的格式化与启动操作。

启动成功包括出现NameNode、SecondDaryNameNode、以及DataNode。

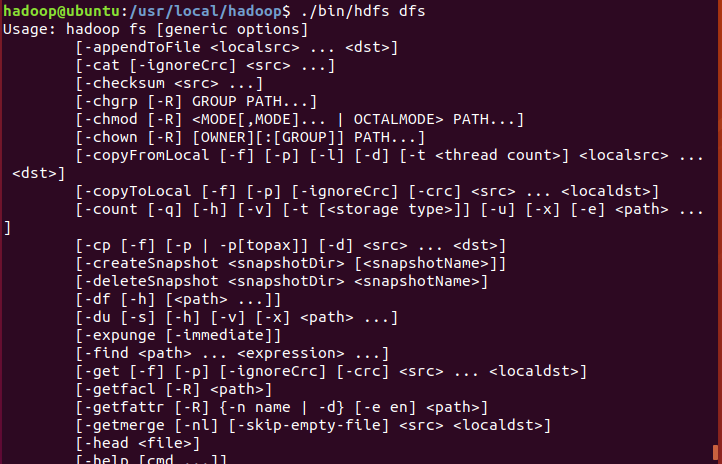

HDFS支持的命令

查看hdfs支持的所有命令

./bin/hdfs dfs

Ps:查看hadoop下put的使用方法

./bin/hadoop fs -help put

HDFS文件系统中目录创建操作

创建用户目录

Hadoop系统安装好以后,第一次使用HDFS时,需要首先在HDFS中创建用户目录。

./bin/hdfs dfs -mkdir -p /user/hadoop

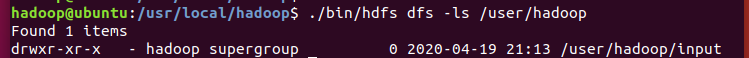

用查询命令查看我们在路径user下面创建的文件夹hadoop

./bin/hdfs dfs -ls /user

创建二级目录

在hadoop目录下再创建一个input文件夹

./bin/hdfs dfs -mkdir /user/hadoop/input

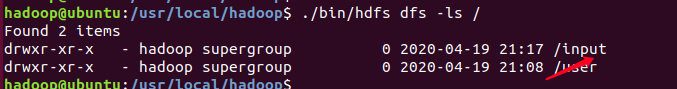

根目录下创建目录

在hadoop根目录下创建一个input文件夹

./bin/hdfs dfs -mkdir /input

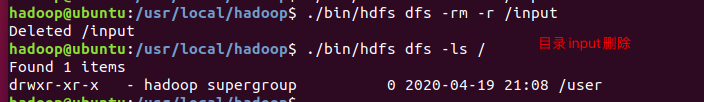

HDFS文件系统中目录删除操作

删除在hadoop根目录下面创建的input文件夹

./bin/hdfs dfs -rm -r /input

可以看到,hadoop根目录下的input文件夹已经被我们成功删除,现在只有存在user目录。

Hadoop的文件操作

创建文件的方式

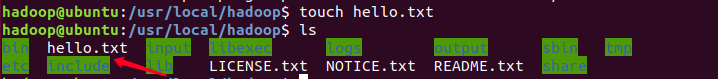

在当前环境目录下创建hello.txt文件,这里介绍两种方法。

number one

touch hello.txt

打开hello.txt文件,并写入如下内容并保存。

hello world

gedit hello.txt

number t two

利用vim编辑创建hello.txt。

vim hello.txt

关于vim怎么建立简单的文本文件我就不在这里解释了,不会的童鞋可以找找度娘。

传输文件

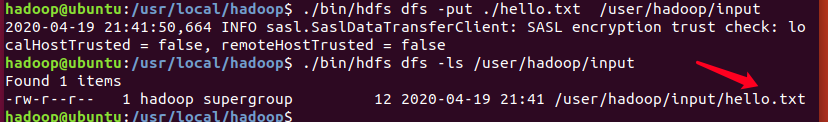

利用put命令将创建的hello.txt文件上传到user/hadoop/input的目录

./bin/hdfs dfs -put ./hello.txt /user/hadoop/input

/bin/hdfs dfs -ls /user/hadoop/input

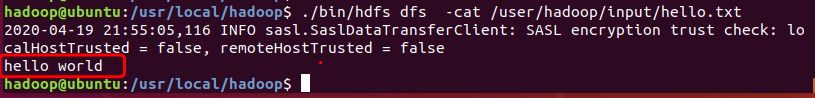

在user/hadoop/input目录下利用cat命令查看hello.txt文件内容

./bin/hdfs dfs -cat /user/hadoop/input/hello.txt

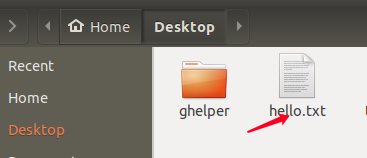

HDFS中的文件下载到本地文件系统

使用-get命令将HDFS中的hello.txt文件下载到本地文件系统中的/home/hadoop/Desktop这个目录下:

./bin/hdfs dfs -get /user/hadoop/input/hello.txt /home/hadoop/Desktop

本次给大家分享的内容就到这里啦,觉得还不错的点个赞支持一下小编,你的肯定就是小编前进的动力。另外如果想了解更多计算机专业的知识和技巧的,献上我的个人博客北徯,另外需要各种资料的童鞋,可以关注我的微信公众号北徯,免费的PPT模板,各种资料等你来领。

Hadoop学习笔记(2)-HDFS的基本操作(Shell命令)的更多相关文章

- 吴裕雄--天生自然HADOOP操作实验学习笔记:hdfs简单的shell命令

实验目的 了解bin/hadoop脚本的原理 学会使用fs shell脚本进行基本操作 学习使用hadoop shell进行简单的统计计算 实验原理 1.hadoop的shell脚本 当hadoop集 ...

- Hadoop学习笔记: HDFS

注:该文内容部分来源于ChinaHadoop.cn上的hadoop视频教程. 一. HDFS概述 HDFS即Hadoop Distributed File System, 源于Google发表于200 ...

- Hadoop学习笔记(三) ——HDFS

参考书籍:<Hadoop实战>第二版 第9章:HDFS详解 1. HDFS基本操作 @ 出现的bug信息 @-@ WARN util.NativeCodeLoader: Unable to ...

- hadoop学习笔记贰 --HDFS及YARN的启动

1.初始化HDFS :hadoop namenode -format 看到如下字样,说明初始化成功. 启动HDFS,start-dfs.sh 终于启动成功了,原来是core-site.xml 中配置 ...

- Hadoop学习笔记之HBase Shell语法练习

Hadoop学习笔记之HBase Shell语法练习 作者:hugengyong 下面我们看看HBase Shell的一些基本操作命令,我列出了几个常用的HBase Shell命令,如下: 名称 命令 ...

- hadoop学习笔记(四):HDFS文件权限,安全模式,以及整体注意点总结

本文原创,转载注明作者和原文链接! 一:总结注意点: 到现在为止学习到的角色:三个NameNode.SecondaryNameNode.DataNode 1.存储的是每一个文件分割存储之后的元数据信息 ...

- Hadoop学习笔记(两)设置单节点集群

本文描写叙述怎样设置一个单一节点的 Hadoop 安装.以便您能够高速运行简单的操作,使用 Hadoop MapReduce 和 Hadoop 分布式文件系统 (HDFS). 參考官方文档:Hadoo ...

- Hadoop学习笔记—22.Hadoop2.x环境搭建与配置

自从2015年花了2个多月时间把Hadoop1.x的学习教程学习了一遍,对Hadoop这个神奇的小象有了一个初步的了解,还对每次学习的内容进行了总结,也形成了我的一个博文系列<Hadoop学习笔 ...

- Hadoop学习笔记(2)

Hadoop学习笔记(2) ——解读Hello World 上一章中,我们把hadoop下载.安装.运行起来,最后还执行了一个Hello world程序,看到了结果.现在我们就来解读一下这个Hello ...

随机推荐

- Codeforce219C-Color Stripe

E. Color Stripe time limit per test 2 seconds memory limit per test 256 megabytes input standard inp ...

- 多线程之旅(ThreadPool 线程池)

一.什么是ThreadPool 线程池(源码) 1.线程池顾名思义,有我们的系统创建一个容器装载着我们的线程,由CLR控制的所有AppDomain共享.线程池可用于执行任务.发送工作项.处理异步 I/ ...

- 洛谷5026 Lycanthropy 差分套差分

题目链接 https://www.luogu.com.cn/problem/P5026 题意 在一个长度为m的序列中,每次给一个下标x,和一个权值v,然后从x-v*3到x-v*2单调递增,从x-v*2 ...

- 使用Keras构建深度图像搜索引擎

动机 想象一下,如果有数十万到数百万张图像的数据集,却没有描述每张图像内容的元数据.我们如何建立一个系统,能够找到这些图像的子集来更好地回答用户的搜索查询? 我们基本上需要的是一个搜索引擎,它能够根据 ...

- Centos 8 上安装 Consul

/* 1. 下载二进制安装文件 */下载地址:https://www.consul.io/downloads.html /* 2. 解压缩安装包 */unzip consul_1.6.2_linux_ ...

- ios shell打包脚本 gym

#! /bin/bash project_path=$() project_config=Release output_path=~/Desktop build_scheme=YKTicketsApp ...

- SpringCloud入门(八): Zuul 过滤器详解

Zuul 过滤器 zuul 有四种过滤器类型,分别是: 1.Pre:过滤器在请求被路由之前调用.我们可利用这种过滤器实现身份验证.在集群中选择请求的微服务.记录调试信息等: 2.Routing:过滤器 ...

- 通俗易懂.NET GC垃圾回收机制(适用于小白面试,大牛勿喷)

情景:你接到xx公司面试邀请,你怀着激动忐忑的心坐在对方公司会议室,想着等会的技术面试.技术总监此时走来,与你简单交谈后.... 技术:你对GC垃圾回收机制了解的怎么样? 你:还行,有简单了解过. 技 ...

- iOS开发 - 开发版+企业版无线发布一键打包

背景:项目进入快速迭代期,需要快速地交付出AdHoc版本和企业无线发布版本.每次打包都要来回切换bundle identifier和code signing,浪费很多时间. 示例项目名称名称为Test ...

- 新安装的eclipse配置好了环境变量后,打开还是出现A Java runtime environment错误

新安装的eclipse配置好了环境变量后,打开还是出现如下图的A Java runtime environment错误; 解决方法: 第一步: Windows环境下:把C:\Users\你的用户名 目 ...