deep_learning_Function_tf.train.ExponentialMovingAverage()滑动平均

近来看batch normalization的代码时,遇到tf.train.ExponentialMovingAverage()函数,特此记录。

tf.train.ExponentialMovingAverage()函数实现滑动平均模型和计算变量的移动平均值。

TensorFlow官网上对于这个方法的介绍:

Some training algorithms, such as GradientDescent and Momentum often benefit from maintaining a moving average of variables during optimization. Using the moving averages for evaluations often improve results significantly.

一些训练算法,如梯度下降(GradientDescent)和动量(Momentum),经常受益于在优化过程中保持变量的移动平均。使用移动平均线进行评估通常会显著改善结果。

# 类,用于计算滑动平均

tf.train.ExponentialMovingAverage __init__(

decay,

num_updates=None,

zero_debias=False,

name='ExponentialMovingAverage')

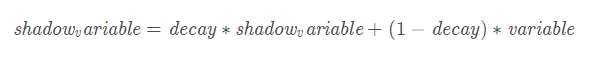

decay是衰减率。在创建ExponentialMovingAverage对象时,需要指定衰减率(decay),用于控制模型的更新速度。影子变量的初始值与训练变量的初始值相同。当运行变量更新时,每个影子变量都会更新为:

shadowvariable=decay∗shadowvariable+(1−decay)∗variable

num_updates是ExponentialMovingAverage提供用来动态设置decay的参数,当初始化时,函数提供了num_updates参数,即不为none时,每次的衰减率是:

apply()方法添加了训练变量的影子副本,并保持了其影子副本中训练变量的移动平均值操作。在每次训练之后调用此操作,更新移动平均值。average()和average_name()方法可以获取影子变量及其名称。

decay设置为接近1的值比较合理,通常为:0.999,0.9999等,decay越大模型越稳定,因为decay越大,参数更新的速度就越慢,趋于稳定。

官网中的示例:

# 创建variables.

var0 = tf.Variable(...)

var1 = tf.Variable(...)

# ... 使用variables去创建一个训练模型...

...

# 创建一个使用the optimizer对的op.

# 这是我们通常会使用作为一个training op.

opt_op = opt.minimize(my_loss, [var0, var1]) # 创建一个ExponentialMovingAverage object

ema = tf.train.ExponentialMovingAverage(decay=0.9999) # 创建the shadow variables,然后把ops加到maintain moving averages of var0 and var1.

maintain_averages_op = ema.apply([var0, var1]) # 创建一个op,在每次训练之后用来更新the moving averages.

# 用来代替the usual training op.

with tf.control_dependencies([opt_op]):

training_op = tf.group(maintain_averages_op)

# run这个op获取当前时刻 ema_value

get_var0_average_op = ema.average(var0)

例子:

import tensorflow as tf

import numpy as np v1 = tf.Variable(0, dtype=tf.float32)

step = tf.Variable(tf.constant(0)) ema = tf.train.ExponentialMovingAverage(0.99, step)

maintain_average = ema.apply([v1]) with tf.Session() as sess:

init = tf.initialize_all_variables()

sess.run(init)

print(sess.run([v1, ema.average(v1)])) #初始的值都为0 sess.run(tf.assign(v1, 5)) #把v1变为5

sess.run(maintain_average)

print(sess.run([v1, ema.average(v1)]))

# decay=min(0.99, 1/10)=0.1, v1=0.1*0+0.9*5=4.5 sess.run(tf.assign(step, 10000)) # steps=10000

sess.run(tf.assign(v1, 10)) # v1=10

sess.run(maintain_average)

print(sess.run([v1, ema.average(v1)]))

# decay=min(0.99,(1+10000)/(10+10000))=0.99, v1=0.99*4.5+0.01*10=4.555 sess.run(maintain_average)

print(sess.run([v1, ema.average(v1)]))

# decay=min(0.99,(1+10000)/(10+10000))=0.99, v1=0.99*4.555+0.01*10=4.60945

> [0.0, 0.0]

> [5.0, 4.5]

> [10.0, 4.555]

> [10.0, 4.60945]

每次更新完之后,影子变量(shadow_variable)的值就会更新,varible的值就是我们设定的值。如果在下一次运行这个函数的时候我们不再指定新的值,那varible的值就不变,影子变量更新。如果指定varible的值,那variable就改变为对应的指定值,相应的影子变量也改变。

原文链接:https://blog.csdn.net/tefuirnever/article/details/88902132

deep_learning_Function_tf.train.ExponentialMovingAverage()滑动平均的更多相关文章

- tensorflow 下的滑动平均模型 —— tf.train.ExponentialMovingAverage

在采用随机梯度下降算法训练神经网络时,使用 tf.train.ExponentialMovingAverage 滑动平均操作的意义在于提高模型在测试数据上的健壮性(robustness). tenso ...

- Tensorflow滑动平均模型tf.train.ExponentialMovingAverage解析

觉得有用的话,欢迎一起讨论相互学习~Follow Me 移动平均法相关知识 移动平均法又称滑动平均法.滑动平均模型法(Moving average,MA) 什么是移动平均法 移动平均法是用一组最近的实 ...

- 理解滑动平均(exponential moving average)

1. 用滑动平均估计局部均值 滑动平均(exponential moving average),或者叫做指数加权平均(exponentially weighted moving average),可以 ...

- 『TensorFlow』滑动平均

滑动平均会为目标变量维护一个影子变量,影子变量不影响原变量的更新维护,但是在测试或者实际预测过程中(非训练时),使用影子变量代替原变量. 1.滑动平均求解对象初始化 ema = tf.train.Ex ...

- tensorflow随机梯度下降算法使用滑动平均模型

在采用随机梯度下降算法训练神经网络时,使用滑动平均模型可以提高最终模型在测试集数据上的表现.在Tensflow中提供了tf.train.ExponentialMovingAverage来实现滑动平均模 ...

- tensorflow入门笔记(二) 滑动平均模型

tensorflow提供的tf.train.ExponentialMovingAverage 类利用指数衰减维持变量的滑动平均. 当训练模型的时候,保持训练参数的滑动平均是非常有益的.评估时使用取平均 ...

- tensorflow笔记之滑动平均模型

tensorflow使用tf.train.ExponentialMovingAverage实现滑动平均模型,在使用随机梯度下降方法训练神经网络时候,使用这个模型可以增强模型的鲁棒性(robust),可 ...

- TensorFlow+实战Google深度学习框架学习笔记(11)-----Mnist识别【采用滑动平均,双层神经网络】

模型:双层神经网络 [一层隐藏层.一层输出层]隐藏层输出用relu函数,输出层输出用softmax函数 过程: 设置参数 滑动平均的辅助函数 训练函数 x,y的占位,w1,b1,w2,b2的初始化 前 ...

- (转)理解滑动平均(exponential moving average)

转自:理解滑动平均(exponential moving average) 1. 用滑动平均估计局部均值 滑动平均(exponential moving average),或者叫做指数加权平均(exp ...

随机推荐

- WCF绑定(Binding)

一个Binding由一个有序的binding元素栈所组成,其中的每一个元素都指定了连接到ServiceEndpoint的一个方面.在这个栈中的最底两层都是必须要有的.最底下的一层是传输binding元 ...

- [git]查看一个git项目的仓库位置

项目文件夹的根目录下查找.git文件夹.打开config文件,里面的remote部分就是: [core] repositoryformatversion = 0 filemode = false ba ...

- FAQ_2

FAQ-2 1.LoadRunner超时错误: 在录制Web服务器端,如果超过120秒服务器协议脚本回放时超时情况经常出现,产生错误的原因也有很多,解决的方法也不同. 错误现象1:Action.c(1 ...

- Swift基础知识点的学习

每一个程序员都有一颗不满足当下知识的学习,学习Swift更是每一个iOS程序员必学技能!!! 一说道基础点的学习,当然涵盖的方面也是很多很多啦....然而每一个小知识点的学习,写一个博客,我也觉得没什 ...

- 061. Rotate List

题目链接:https://leetcode.com/problems/rotate-list/description/ Example 1: Input: 1->2->3->4-&g ...

- open_basedir restriction in effect,解决php引入文件权限问题 解决方法

如下: 出现问题的原因: 查看问题描述以及资料,发现是php open_basedir 配置的问题,PHP不能引入其授权目录上级及其以上的文件: 一般情况下是不会出现这种问题的,之所以出现这个问题绝大 ...

- collections(python常用内建模块)

文章来源:https://www.liaoxuefeng.com/wiki/897692888725344/973805065315456 collections collections是Python ...

- 应用安全 - 工具|平台 - Elasticsearch- 漏洞 - 汇总

未授权访问 (1)/_cat/indices #Index个数查询 (2)/_mapping?pretty=true #type个数查询 (3)根据Index和type查询表数据 (4)/_river ...

- json字段为null时输出空字符串

Map < String , Object > jsonMap = new HashMap< String , Object>(); jsonMap.put(); jsonMa ...

- solr设置分片和副本

numShards:分片数 replicationFactor:每个分片下的副本数 maxShardsPerNode:当numShards为1,replicationFactor为3时,maxShar ...