lvs+keepalived 高可用及负载均衡

一、环境准备

VIP:10.18.43.30

dr1:10.18.43.10

dr2:10.18.43.20

web1:10.18.43.13

web2:10.18.43.14

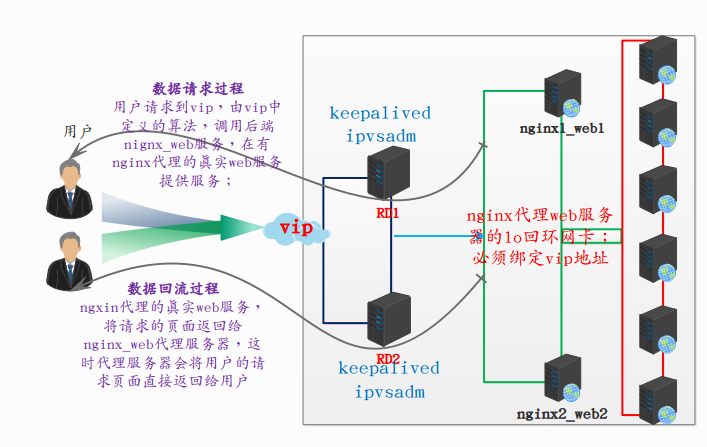

结构图

(一)、预处理

(1)、关闭所有机器selinux,

vim /etc/selinux/config

# This file controls the state of SELinux on the system.

# SELINUX= can take one of these three values:

# enforcing - SELinux security policy is enforced.

# permissive - SELinux prints warnings instead of enforcing.

# disabled - No SELinux policy is loaded.

SELINUX=disabled

# SELINUXTYPE= can take one of three two values:

# targeted - Targeted processes are protected,

# minimum - Modification of targeted policy. Only selected processes are protected.

# mls - Multi Level Security protection.

SELINUXTYPE=targeted

-------------------------------------------------------------

setenforce #退出保存,执行setenforce 当前生效

(2)、关闭所有机器firewalld

systemctl stop firewalld.service

(3)、添加网卡

在DR1与DR2机器添加个添加一张网卡,(也可以不用添加使用本机网卡,主机有两块网卡,其中一块可以用来检测心跳,MASTER和BACKUP如果无法接收到彼此的组播通知,但是两个节点实际上都处于工作状态,这时两个节点均为MASTER强行绑定虚拟IP,从而导致脑裂。)

(二)、部署处理

部署要使用的相关软件;

可以在nginx 上做七层负载均衡,将四层负载均衡的请求在次分发给后端真实提供web服务的集群,根聚七层负载均衡的算法,调用一台真实wen服务器,来给用户提供服务;(这里没有做七层)

(1)、后端部署

nginx编译安装,(在web1和web2执行相同的操作,此处省略web2操作步骤)

groupadd nginx #创建nginx组

useradd -r -g nginx -s /bin/nologin nginx #创建nginx用户并取消shell

wget http://nginx.org/download/nginx-1.14.0.tar.gz #下载nginx软件包

tar xf nginx-1.14..tar.gz -C /tpm/ #解压nginx源码包

cd /tmp/nginx-1.14./

./configure \

--prefix=/usr/local/nginx \

--without-select_module \

--without-poll_module \

--with-debug \

--with-http_ssl_module \

--with-http_realip_module \

--with-http_addition_module \

--with-http_sub_module \

--with-http_dav_module \

--with-http_flv_module \

--with-http_xslt_module \

--with-http_gzip_static_module \

--with-http_random_index_module \

--with-http_secure_link_module \

--with-http_degradation_module \

--with-http_stub_status_module \

--with-cc=`which gcc` make -j && make install

(2)、启动nginx服务

cd /usr/local/nginx/

sbin/nginx

[root@web1-1 nginx]# lsof -i:

COMMAND PID USER FD TYPE DEVICE SIZE/OFF NODE NAME nginx root 6u IPv4 0t0 TCP *:http (LISTEN) nginx nginx 6u IPv4 0t0 TCP *:http (LISTEN)

(3)、设置lo回环地址

(在web1和web2,执行相同的操作)

[root@web1-1 ~]# echo > /proc/sys/net/ipv4/conf/all/arp_announce

[root@web1-1 ~]# echo > /proc/sys/net/ipv4/conf/all/arp_ignore

[root@web1- ~]# ip a a dev lo 10.18.43.30/

[root@web1- ~]# ip a

: lo: <LOOPBACK,UP,LOWER_UP> mtu qdisc noqueue state UNKNOWN group default qlen

link/loopback ::::: brd :::::

inet 127.0.0.1/ scope host lo

valid_lft forever preferred_lft forever

inet 10.18.43.30/ scope global lo

valid_lft forever preferred_lft forever

inet6 ::/ scope host

valid_lft forever preferred_lft forever

: eth0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu qdisc pfifo_fast state UP group default qlen

link/ether :::ed:d6: brd ff:ff:ff:ff:ff:ff

inet 10.18.43.13/ brd 10.18.43.255 scope global noprefixroute eth0

valid_lft forever preferred_lft forever

inet6 fe80:::ff:feed:d671/ scope link

valid_lft forever preferred_lft forever

测试后端web服务是否正常,(web1,web2执行相同操作)

[root@web1- ~]# curl 10.18.43.13

web1

(4)、高可用

下载ipvsadm,keepalived,

yum -y install ipvsadm keepalived

(5)、keepalived部署详解

[root@DR-1- ]# vim /etc/keepalived/keepalived.conf

global_defs {

router_id lvs #全局配置

} vrrp_instance lvs_keepalived { #库名称

state BACKUP #角色:MASTER BACKUP

interface eth0 #网卡:这里我们拿eth0做为心跳测试,检测另一台BACKUP存活状态

virtual_router_id #小组段:默认是51

priority # 服务的优先权最高255

nopreempt # BACKUP 不抢IP

advert_int

authentication {

auth_type PASS

auth_pass #小组密码

}

virtual_ipaddress {

10.18.43.30/32 dev eth1 # 虚拟ip

}

} virtual_server 10.18.43.30 {

delay_loop #延时环 6秒

lb_algo rr #轮询规则rr

lb_kind DR #使用的工作模式

persistence_timeout #连接超时 时间

protocol TCP #使用的协议 real_server 10.18.43.13 {

weight #权重

TCP_CHECK {

connect_port #监听端口

connect_timeout #连接超时3秒

nb_get_retry #重试连接3次

delay_before_retry #连接超时3重试连接3次

}

}

real_server 10.18.43.14 {

weight

TCP_CHECK {

connect_port

connect_timeout

nb_get_retry

delay_before_retry

}

}

}

将这份配置发给dr2,只需要修改优先级;

[root@DR-2- ]# vim /etc/keepalived/keepalived.conf

global_defs {

router_id lvs #全局配置,全局必须一致

} vrrp_instance lvs_keepalived { #库名称

state BACKUP #角色:MASTER BACKUP

interface eth0 #网卡:这里我们拿eth0做为心跳测试,检测另一台BACKUP存活状态

virtual_router_id #小组段:默认是51

priority #注意这里的优先级

nopreempt # BACKUP 不抢IP

advert_int

authentication {

auth_type PASS

auth_pass #小组密码

}

virtual_ipaddress {

10.18.43.30/ dev eth1 # 虚拟ip

}

} virtual_server 10.18.43.30 {

delay_loop #延时环 6秒

lb_algo rr #轮询规则rr

lb_kind DR #使用的工作模式

persistence_timeout #连接超时 时间

protocol TCP #使用的协议 real_server 10.18.43.13 {

weight #权重

TCP_CHECK {

connect_port #监听端口

connect_timeout #连接超时3秒

nb_get_retry #重试连接3次

delay_before_retry #连接超时3重试连接3次

}

}

real_server 10.18.43.14 {

weight

TCP_CHECK {

connect_port

connect_timeout

nb_get_retry

delay_before_retry

}

}

}

(6)、启动keepalived

(在DR1和DR2执行相同操作)

[root@DR-- ~]# systemctl start keepalived.service

[root@DR-2- ~]# systemctl start keepalived.service

(7)、查看结果

DR1与RD2先启动那个机器,虚拟VIP就会在那个主机的第二张网卡上,(第一张网卡是用来做心跳测试的,)

[root@DR-- keepalived]# ip a

: lo: <LOOPBACK,UP,LOWER_UP> mtu qdisc noqueue state UNKNOWN qlen

link/loopback ::::: brd :::::

inet 127.0.0.1/ scope host lo

valid_lft forever preferred_lft forever

inet6 ::/ scope host

valid_lft forever preferred_lft forever

: eth0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu qdisc pfifo_fast state UP qlen

link/ether :::c9:8e: brd ff:ff:ff:ff:ff:ff

inet 10.18.43.10/ brd 10.18.43.255 scope global dynamic eth0

valid_lft 41215sec preferred_lft 41215sec

inet6 fe80::70de::c4c6:aa/ scope link

valid_lft forever preferred_lft forever

: eth1: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu qdisc pfifo_fast state UP qlen

link/ether ::::4b:4f brd ff:ff:ff:ff:ff:ff

inet 10.18.43.12/ brd 10.18.43.255 scope global dynamic eth1

valid_lft 43069sec preferred_lft 43069sec

inet 10.18.43.30/32 scope global eth1

valid_lft forever preferred_lft forever

inet6 fe80::e958:18e::b3f/ scope link

valid_lft forever preferred_lft forever

二、概念补充

(1)、脑裂

一般来说,脑裂的发生,有一下几种原因;

1、高可用服务器对之间心跳线链路发生故障,导致无法正常通信;

2、因心跳线坏了,(包括断了,老化等一些物理上的原因)

3、因网卡及相关驱动坏了,IP配置及冲突问题(网卡直连)

4、因心跳线间链接的设备故障(网卡及交换机)

5、因仲裁的机器出问题(采用仲裁的方案)

6、高可用服务器上开启了iptables防火强阻挡了心跳消息传输

7、高可用服务器上心跳网卡地址等信息配置不正确,导致心跳失败;

8、其他服务配置不当等原因,如心跳方式不同,心跳广播冲突,软件Bug等。

提示:keepalived配置里同一VRRP实例如果virtual_router_id两端参数配置不一致也后悔导致脑裂问题发生;

(2)、常见解决方案

在实际生产环境中,我们可以从以下几个方面来防止脑裂问题的发生;

1、同时使用串行电缆和以太网电缆链接,同时使用两跳心跳线路,这样一条线路坏了,另一条还是好的,依然能传送心跳消息

2、当检测到脑裂时,强行关闭一个心跳节点,

3、做好对脑裂的监控报警,在问题发生时人为第一时间介入仲裁,降低损失。

(3)、keepalived配置

在这里主要解释一下我的配置没有写入MASTER,在有nopreempt参数的情况下,是可以不要MASTER,为了确保vip在一台机器上的稳定性,我们需要在配置文件中添加nopreempt参数,而且取消MASTER角色;

如果MASTER角色存在,那么MASTER角色宕机之后,他的vip会漂移到BACKUP角色主机上,这时如果是以为网络抖动的原因造成的,当MASTER服务链接正常时,MASTER角色就会将原有的vip抢回来,反复来回几次之后,keepalived就会宕机,造成不可设想的后果;

如果取消MASTER角色,添加nopreempt参数,vip会按照服务启动的先回顺序和优先级来决定他在那台机器上,有一台keepalived宕机,vip就会漂移到另一台BACKUP机器上,当另一台keepalived正常只会,他不会去抢vip,这样就不会造成vip来回在keepalived机器上飘来飘去;

lvs+keepalived 高可用及负载均衡的更多相关文章

- 4、keepalived高可用nginx负载均衡

keepalived: HTTP_GET //使用keepalived获取后端real server健康状态检测 SSL_GET(https) //这里以为这后端使用的是http协议 ...

- keepalived高可用haproxy负载均衡varnish缓存wordpress的动静分离(第一次配置成功)

haproxy和nginx都可以作为七层和四层反代服务器对外提供服务,此文通过haproxy和keealived配置varnish搭建wordpress的动静分离站点 一.实验环境 五台虚拟机: ha ...

- nginx+keepalived高可用web负载均衡

一:安装环境 准备2台虚拟机,都安装好环境 centos 7keepalived:vip: 192.168.1.112192.168.1.110 nginxip 192.168.1.109 maste ...

- 测试LVS+Keepalived高可用负载均衡集群

测试LVS+Keepalived高可用负载均衡集群 1. 启动LVS高可用集群服务 此时查看Keepalived服务的系统日志信息如下: [root@localhost ~]# tail -f /va ...

- LVS+Keepalived高可用负载均衡集群架构实验-01

一.为什么要使用负载均衡技术? 1.系统高可用性 2. 系统可扩展性 3. 负载均衡能力 LVS+keepalived能很好的实现以上的要求,LVS提供负载均衡,keepalived提供健康检查, ...

- Ubuntu构建LVS+Keepalived高可用负载均衡集群【生产环境部署】

1.环境说明: 系统版本:Ubuntu 14.04 LVS1物理IP:14.17.64.2 初始接管VIP:14.17.64.13 LVS2物理IP:14.17.64.3 初始接管VIP:14 ...

- 高可用与负载均衡(7)之聊聊Lvs-DR+Keepalived的解决方案

今天直接开门见山了,直接说配置吧.首先介绍下我这的环境 如有问题,请联系我18500777133@sina.cn IP 安装软件 192.168.1.7 lvs1+keepalived master角 ...

- 搭建Keepalived+LNMP架构web动态博客 实现高可用与负载均衡

环境准备: 192.168.193.80 node1 192.168.193.81 node2 关闭防火墙 [root@node1 ~]# systemctl stop firewalld #两台都 ...

- Dubbo入门到精通学习笔记(十六):Keepalived+Nginx实现高可用Web负载均衡

文章目录 Keepalived+Nginx实现高可用Web负载均衡 Keepalived+Nginx实现高可用Web负载均衡 高可用架构篇 Keepalived + Nginx 实现高可用 Web 负 ...

随机推荐

- SFTP数据迁移

背景 服务器部署到aliyun上,之前sftp数据又是在系统盘上,由于现在数据量越来越大,导致系统盘无法满足现有要求,所以需要对sftp相关数据进行迁移至数据盘. 方案 方案一:原数据复制到新磁盘中, ...

- Hive入门(四)查询优化

1 本地模式 0.7版本后Hive开始支持任务执行选择本地模式(local mode). 大多数的Hadoop job是需要hadoop提供的完整的可扩展性来处理大数据的.不过,有时hive的输入数据 ...

- HDU 5616:Jam's balance(背包DP)

http://acm.hdu.edu.cn/showproblem.php?pid=5616 题意:有n个物品,每个重量为w[i],有一个天平,你可以把物品放在天平的左边或者右边,接下来m个询问,问是 ...

- Elasticsearch(一)开启外网访问

1. 设置Elasticsearch对外访问的Host 修改Elasticsearch配置文件 elasticsearch.yml : network.host: 128.24.108.84 //在 ...

- nodejs中文乱码问题

node.js暂时不支持GBK或gb2312,所以编程文件(js)需要修改为utf-8格式. 另外如需要返回html代码,在 writeHead 方法中加入 "charset=utf-8&q ...

- watch 和 computed

<template> <div class="hello"> <h1>{{ msg }}</h1> <h2>Essent ...

- 自己实现IOC容器,java代码实现简易版IOC容器,IOC容器实现的步骤分解

一.需求 实现一个简易的IOC容器,管理Bean,从IOC容器的BeanFactory中获取实例,从而取代自己new实例的做法. 二.实现步骤分析 三.具体代码实现 自定义注解类 MyComponen ...

- vs2010编译zapline-zapline.systemoptimization 注释工程中的//#define abs(value) (value >= 0 ? value : -(value))即可

vs2010编译zapline-zapline.systemoptimization-8428e72c88e0.zip出错 1>d:\program files (x86)\microsoft ...

- TensorFlow笔记-初识

深度学习: 转换编程的思维(和传统的机器学习的编程方式不太一样) 测试链接 TensorFlow的安装 CPU版本: 只支持程序在CPU上计算/运算,默认运行就是CPU上运行 卸载: pip unin ...

- git,github,gitlab,码云的区别

git 是版本控制工具. github https://github.com/和gitlab https://about.gitlab.com/都是基于git仓库的web开发流程代码托管平台.两者的区 ...