spark 源码分析之十四 -- broadcast 是如何实现的?

本篇文章主要剖析broadcast 的实现机制。

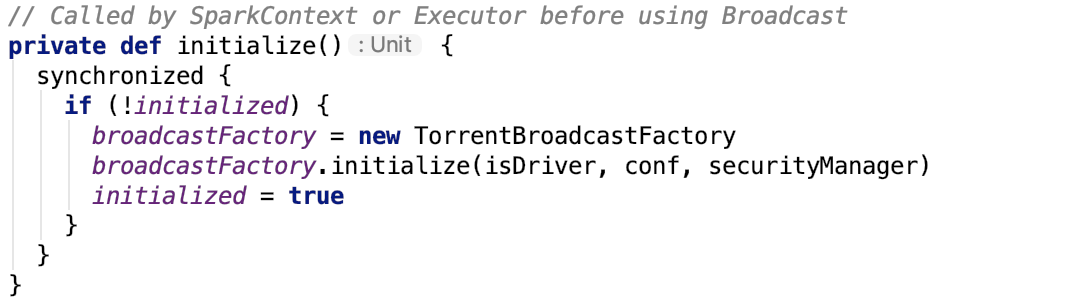

BroadcastManager初始化

BroadcastManager初始化方法源码如下:

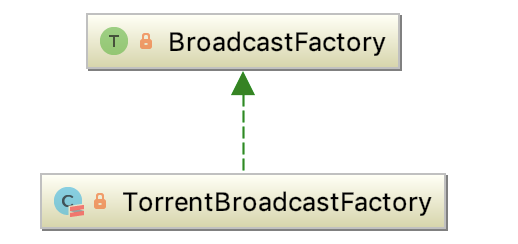

TorrentBroadcastFactory的继承关系如下:

BroadcastFactory

An interface for all the broadcast implementations in Spark (to allow multiple broadcast implementations). SparkContext uses a BroadcastFactory implementation to instantiate a particular broadcast for the entire Spark job.

即它是Spark中broadcast中所有实现的接口。SparkContext使用BroadcastFactory实现来为整个Spark job实例化特定的broadcast。它有唯一子类 -- TorrentBroadcastFactory。

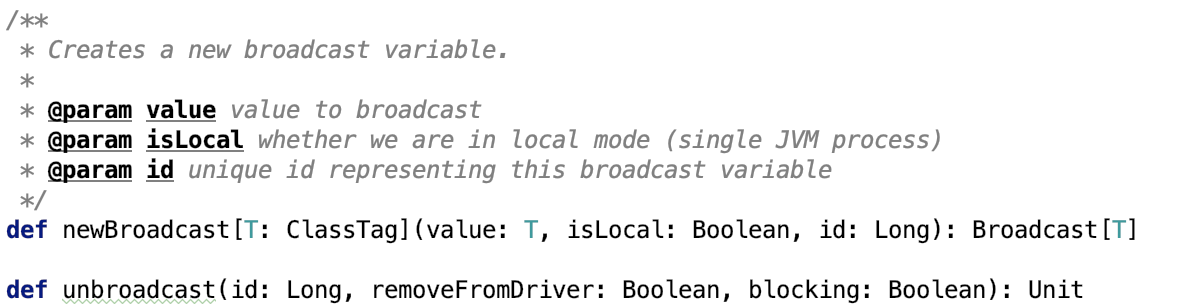

它有两个比较重要的方法:

newBroadcast 方法负责创建一个broadcast变量。

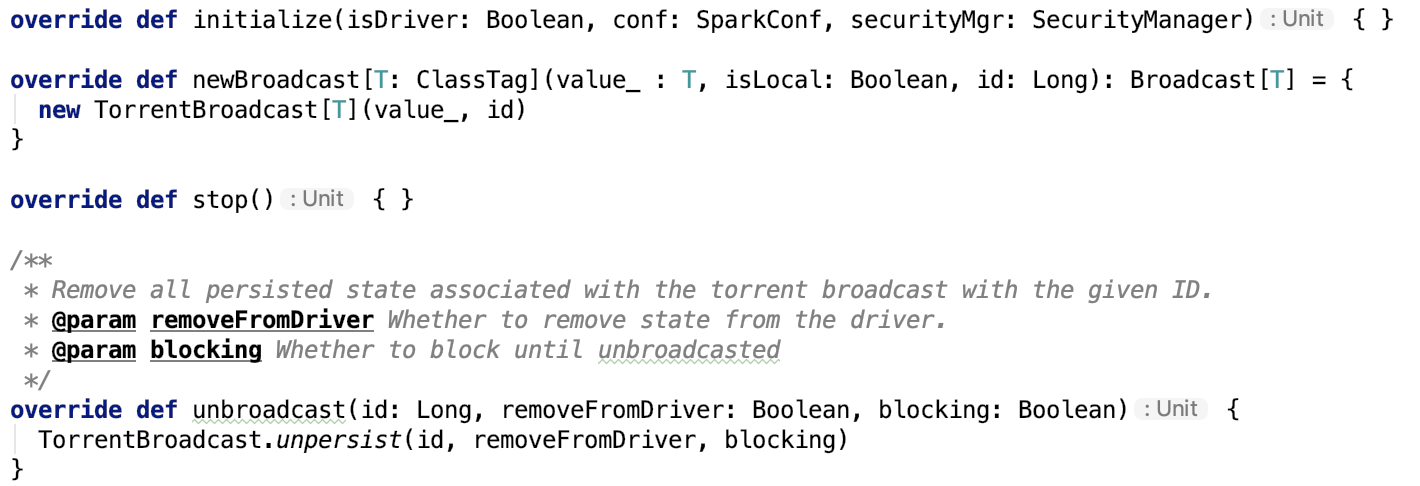

TorrentBroadcastFactory

其主要方法如下:

newBroadcast其实例化TorrentBroadcast类。

unbroadcast方法调用了TorrentBroadcast 类的 unpersist方法。

TorrentBroadcast父类Broadcast

官方说明如下:

A broadcast variable. Broadcast variables allow the programmer to keep a read-only variable cached on each machine rather than shipping a copy of it with tasks.

They can be used, for example, to give every node a copy of a large input dataset in an efficient manner. Spark also attempts to distribute broadcast variables using efficient broadcast algorithms to reduce communication cost. Broadcast variables are created from a variable v by calling org.apache.spark.SparkContext.broadcast. The broadcast variable is a wrapper around v, and its value can be accessed by calling the value method.

The interpreter session below shows this: scala> val broadcastVar = sc.broadcast(Array(1, 2, 3))

broadcastVar: org.apache.spark.broadcast.Broadcast[Array[Int]] = Broadcast(0) scala> broadcastVar.value

res0: Array[Int] = Array(1, 2, 3) After the broadcast variable is created, it should be used instead of the value v in any functions run on the cluster so that v is not shipped to the nodes more than once. In addition, the object v should not be modified after it is broadcast in order to ensure that all nodes get the same value of the broadcast variable (e.g. if the variable is shipped to a new node later).

即广播变量允许编程者将一个只读变量缓存到每一个机器上,而不是随任务一起发送它的副本。它们可以被用来用一种高效的方式拷贝输入的大数据集。Spark也尝试使用高效的广播算法来减少交互代价。它通过调用SparkContext的broadcast 方法创建,broadcast变量是对真实变量的包装,它可以通过broadcast对象的value方法返回真实对象。一旦真实对象被广播了,要确保对象不会被改变,以确保该数据在所有节点上都是一致的。

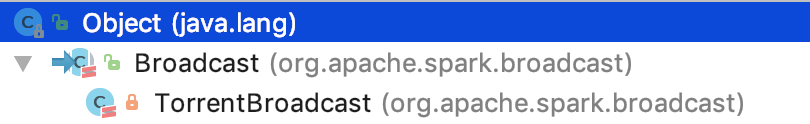

TorrentBroadcast继承关系如下:

TorrentBroadcast 是 Broadcast 的唯一子类。

TorrentBroadcast

其说明如下:

A BitTorrent-like implementation of org.apache.spark.broadcast.Broadcast.

The mechanism is as follows:

The driver divides the serialized object into small chunks and stores those chunks in the BlockManager of the driver.

On each executor, the executor first attempts to fetch the object from its BlockManager.

If it does not exist, it then uses remote fetches to fetch the small chunks from the driver and/or other executors if available.

Once it gets the chunks, it puts the chunks in its own BlockManager, ready for other executors to fetch from.

This prevents the driver from being the bottleneck in sending out multiple copies of the broadcast data (one per executor).

When initialized, TorrentBroadcast objects read SparkEnv.get.conf.

实现机制:

driver 将数据拆分成多个小的chunk并将这些小的chunk保存在driver的BlockManager中。在每一个executor节点上,executor首先先从它自己的blockmanager获取数据,如果不存在,它使用远程抓取,从driver或者是其他的executor中抓取数据。一旦它获取到chunk,就将其放入到自己的BlockManager中,准备被其他的节点请求获取。这使得driver发送多个副本到多个executor节点的瓶颈不复存在。

driver 端写数据

广播数据的保存有两种形式:

1. 数据保存在memstore中一份,需要反序列化后存入;保存在磁盘中一份,磁盘中的那一份先使用 SerializerManager序列化为字节数组,然后保存到磁盘中。

2. 将对象根据blockSize(默认为4m,可以通过spark.broadcast.blockSize 参数指定),compressCodec(默认是启用的,可以通过 spark.broadcast.compress参数禁用。压缩算法默认是lz4,可以通过 spark.io.compression.codec 参数指定)将数据写入到outputStream中,进而拆分为几个小的chunk,最终将数据持久化到blockManager中,也是memstore一份,不需要反序列化;磁盘一份。

其中,TorrentBroadcast 的 blockifyObject 方法如下:

压缩的Outputstream对 ChunkedByteBufferOutputStream 做了装饰。

driver或executor读数据

broadcast 方法调用 value 方法时, 会调用 TorrentBroadcast 的 getValue 方法,如下:

_value 字段声明如下:

private lazy val _value: T = readBroadcastBlock()

接下来看一下 readBroadcastBlock 这个方法:

private def readBroadcastBlock(): T = Utils.tryOrIOException {

TorrentBroadcast.synchronized {

val broadcastCache = SparkEnv.get.broadcastManager.cachedValues

Option(broadcastCache.get(broadcastId)).map(_.asInstanceOf[T]).getOrElse {

setConf(SparkEnv.get.conf)

val blockManager = SparkEnv.get.blockManager

blockManager.getLocalValues(broadcastId) match {

case Some(blockResult) =>

if (blockResult.data.hasNext) {

val x = blockResult.data.next().asInstanceOf[T]

releaseLock(broadcastId)

if (x != null) {

broadcastCache.put(broadcastId, x)

}

x

} else {

throw new SparkException(s"Failed to get locally stored broadcast data: $broadcastId")

}

case None =>

logInfo("Started reading broadcast variable " + id)

val startTimeMs = System.currentTimeMillis()

val blocks = readBlocks()

logInfo("Reading broadcast variable " + id + " took" + Utils.getUsedTimeMs(startTimeMs))

try {

val obj = TorrentBroadcast.unBlockifyObject[T](

blocks.map(_.toInputStream()), SparkEnv.get.serializer, compressionCodec)

// Store the merged copy in BlockManager so other tasks on this executor don't

// need to re-fetch it.

val storageLevel = StorageLevel.MEMORY_AND_DISK

if (!blockManager.putSingle(broadcastId, obj, storageLevel, tellMaster = false)) {

throw new SparkException(s"Failed to store $broadcastId in BlockManager")

}

if (obj != null) {

broadcastCache.put(broadcastId, obj)

}

obj

} finally {

blocks.foreach(_.dispose())

}

}

}

}

}

对源码作如下解释:

第3行:broadcastManager.cachedValues 保存着所有的 broadcast 的值,它是一个Map结构的,key是强引用,value是虚引用(在垃圾回收时会被清理掉)。

第4行:根据 broadcastId 从cachedValues 中取数据。如果没有,则执行getOrElse里的 default 方法。

第8行:从BlockManager的本地获取broadcast的值(从memstore或diskstore中,获取的数据是完整的数据,不是切分之后的小chunk),若有,则释放BlockManager的锁,并将获取的值存入cachedValues中;若没有,则调用readBlocks将chunk 数据读取到并将数据转换为 broadcast 的value对象,并将该对象放入cachedValues中。

其中, readBlocks 方法如下:

/** Fetch torrent blocks from the driver and/or other executors. */

private def readBlocks(): Array[BlockData] = {

// Fetch chunks of data. Note that all these chunks are stored in the BlockManager and reported

// to the driver, so other executors can pull these chunks from this executor as well.

val blocks = new Array[BlockData](numBlocks)

val bm = SparkEnv.get.blockManager for (pid <- Random.shuffle(Seq.range(0, numBlocks))) {

val pieceId = BroadcastBlockId(id, "piece" + pid)

logDebug(s"Reading piece $pieceId of $broadcastId")

// First try getLocalBytes because there is a chance that previous attempts to fetch the

// broadcast blocks have already fetched some of the blocks. In that case, some blocks

// would be available locally (on this executor).

bm.getLocalBytes(pieceId) match {

case Some(block) =>

blocks(pid) = block

releaseLock(pieceId)

case None =>

bm.getRemoteBytes(pieceId) match {

case Some(b) =>

if (checksumEnabled) {

val sum = calcChecksum(b.chunks(0))

if (sum != checksums(pid)) {

throw new SparkException(s"corrupt remote block $pieceId of $broadcastId:" +

s" $sum != ${checksums(pid)}")

}

}

// We found the block from remote executors/driver's BlockManager, so put the block

// in this executor's BlockManager.

if (!bm.putBytes(pieceId, b, StorageLevel.MEMORY_AND_DISK_SER, tellMaster = true)) {

throw new SparkException(

s"Failed to store $pieceId of $broadcastId in local BlockManager")

}

blocks(pid) = new ByteBufferBlockData(b, true)

case None =>

throw new SparkException(s"Failed to get $pieceId of $broadcastId")

}

}

}

blocks

}

源码解释如下:

第14行:根据pieceid从本地BlockManager 中获取到 chunk

第15行:如果获取到了chunk,则释放锁。

第18行:如果没有获取到chunk,则从远程根据pieceid获取远程获取chunk,获取到chunk后做checksum校验,之后将chunk存入到本地BlockManager中。

注:本篇文章没有对BroadcastManager中关于BlockManager的操作做进一步更详细的说明,下一篇文章会专门剖析Spark的存储体系。

spark 源码分析之十四 -- broadcast 是如何实现的?的更多相关文章

- spark 源码分析之十五 -- Spark内存管理剖析

本篇文章主要剖析Spark的内存管理体系. 在上篇文章 spark 源码分析之十四 -- broadcast 是如何实现的?中对存储相关的内容没有做过多的剖析,下面计划先剖析Spark的内存机制,进而 ...

- spark 源码分析之十九 -- Stage的提交

引言 上篇 spark 源码分析之十九 -- DAG的生成和Stage的划分 中,主要介绍了下图中的前两个阶段DAG的构建和Stage的划分. 本篇文章主要剖析,Stage是如何提交的. rdd的依赖 ...

- spark 源码分析之十六 -- Spark内存存储剖析

上篇spark 源码分析之十五 -- Spark内存管理剖析 讲解了Spark的内存管理机制,主要是MemoryManager的内容.跟Spark的内存管理机制最密切相关的就是内存存储,本篇文章主要介 ...

- spark 源码分析之十八 -- Spark存储体系剖析

本篇文章主要剖析BlockManager相关的类以及总结Spark底层存储体系. 总述 先看 BlockManager相关类之间的关系如下: 我们从NettyRpcEnv 开始,做一下简单说明. Ne ...

- spark 源码分析之十九 -- DAG的生成和Stage的划分

上篇文章 spark 源码分析之十八 -- Spark存储体系剖析 重点剖析了 Spark的存储体系.从本篇文章开始,剖析Spark作业的调度和计算体系. 在说DAG之前,先简单说一下RDD. 对RD ...

- spark 源码分析之十二 -- Spark内置RPC机制剖析之八Spark RPC总结

在spark 源码分析之五 -- Spark内置RPC机制剖析之一创建NettyRpcEnv中,剖析了NettyRpcEnv的创建过程. Dispatcher.NettyStreamManager.T ...

- spark 源码分析之十--Spark RPC剖析之TransportResponseHandler、TransportRequestHandler和TransportChannelHandler剖析

spark 源码分析之十--Spark RPC剖析之TransportResponseHandler.TransportRequestHandler和TransportChannelHandler剖析 ...

- Vue.js 源码分析(二十四) 高级应用 自定义指令详解

除了核心功能默认内置的指令 (v-model 和 v-show),Vue 也允许注册自定义指令. 官网介绍的比较抽象,显得很高大上,我个人对自定义指令的理解是:当自定义指令作用在一些DOM元素或组件上 ...

- Android源码分析(十四)----如何使用SharedPreferencce保存数据

一:SharedPreference如何使用 此文章只是提供一种数据保存的方式, 具体使用场景请根据需求情况自行调整. EditText添加saveData点击事件, 保存数据. diff --git ...

随机推荐

- 原生Js监听普通dom尺寸变化

原生Js监听普通dom尺寸变化 具体做法有以下几种: 初始化项目后,轮询,反复查看 dom 尺寸是否变化,这种一听就感觉不好,开销太大. 监听元素的滚动事件,在 目标 dom 里面包裹一个同等大小的 ...

- UwpDesktop!WPF也能开发Surface Dial

原文:UwpDesktop!WPF也能开发Surface Dial 前段时间巨硬发布了一款新的输入设备Surface Dial,配合Surface Studio使用简直炫酷到没朋友. 本人由于公司业务 ...

- Java底层知识学习:Bytecode and JMM

最近在跟着耗子哥的程序员练级指南学习Java底层知识,结合<深入理解Java虚拟机>这本书在看,写笔记,看资料,成长中…… 目前看完了第二章JMM和各内存区OOM的情况 一篇图文并茂介绍字 ...

- 如何计算memcache的容量

在容量足够的情况下,当然是越大越好,但这样会造成浪费.不考虑这种情况.我们一般的情况是: memcache集群一开始创建会根据存储的数据量与访问量进行容量大小的估算.再算一个20%的冗余. 在网站快速 ...

- java的static类(静态内部类)(转载)

转载自:http://www.jb51.net/article/74838.htm java中的类可以是static吗?答案是可以.在java中我们可以有静态实例变量.静态方法.静态块.类也可以是静态 ...

- Delphi 10.2的 更新说明,所有官方资料:新特征和Bugfix列表,所有工具开发说明

TMS东京版控件更新情况http://www.tmssoftware.com/site/radstudio10_2tokyo.asp RAD Studio 10.2 更新说明http://blog.q ...

- 用Delphi开发视频聊天软件

摘要:目前网上视频聊天软件.视频会议软件.可视IP电话软件随处可见,你是否想自己做一个玩玩?其实这类软件无非是视频加上网络而建成的.如果熟悉视频捕捉和网络传输技术,根本就难不倒你.微软为软件开发人员提 ...

- Qt在各平台上的搭建qt-everywhere(Qt for windows7-64bit, Ubuntu 12.04-32bit, 嵌入式x86平台, 嵌入式arm平台)

下载地址:http://download.qt.io/ 当进入解压好的源码包后,使用./configure –help命令,可以获得相应帮助,前面是*号的表示默认参数. +号表示该功能要求被评估,评估 ...

- 怎么看待php 面向对象思想

面向对象的程序设计思路是现代程序设计由面向过程演变面向对象的必然趋势,所以面向对象的而设计思路必然有它不同的时代意义,必然有着不同面向过程的不同历史使命,而php 5以后成功添加面向对象的设计思路其实 ...

- Python时间戳的一些使用

Python时间戳的一些使用 为什么写下这篇文档? 由于我本身是做Python爬虫的,在爬取网站的过程当中,会遇到形形色色的验证码,目前对于自己而言,可能简单的验证码可以进行自己识别 发现大多数的网站 ...