Iris Classification on Tensorflow

Iris Classification on Tensorflow

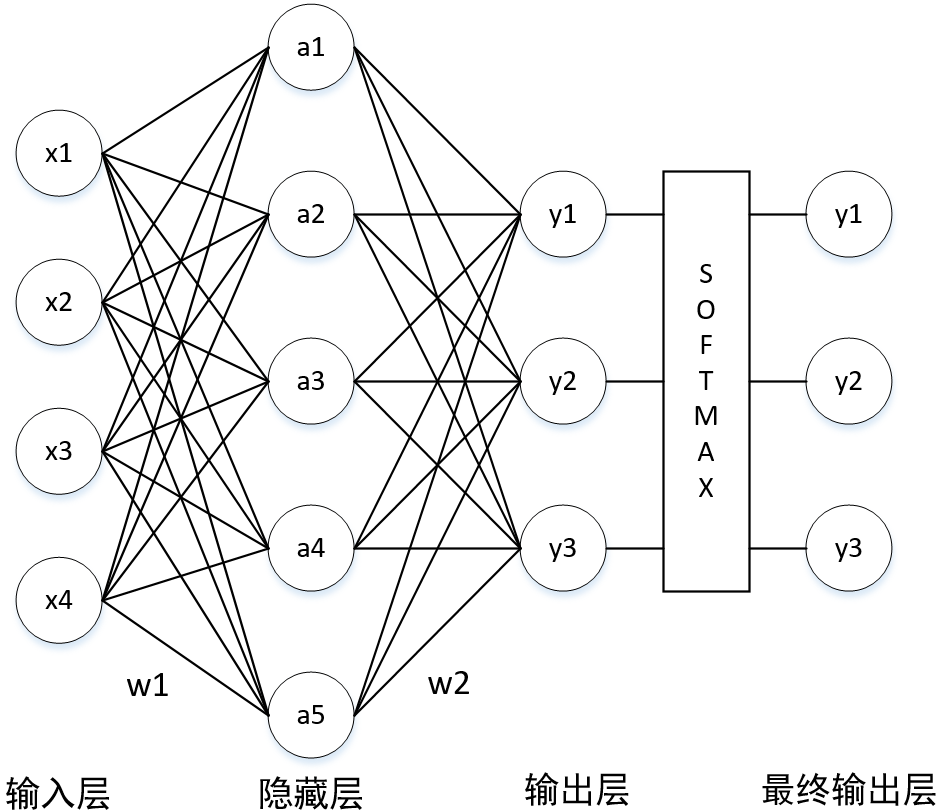

Neural Network

formula derivation

a & = x \cdot w_1 \\

y & = a \cdot w_2 \\

& = x \cdot w_1 \cdot w_2 \\

y & = softmax(y)

\end{align}

\]

code (training only)

y = a \cdot w_2

\]

w1 = tf.Variable(tf.random_normal([4,5], stddev=1, seed=1))

w2 = tf.Variable(tf.random_normal([5,3], stddev=1, seed=1))

x = tf.placeholder(tf.float32, shape=(None, 4), name='x-input')

a = tf.matmul(x, w1)

y = tf.matmul(a, w2)

既然是有监督学习,那就在训练阶段必须要给出 label,以此来计算交叉熵

# 用来存储数据的标签

y_ = tf.placeholder(tf.float32, shape=(None, 3), name='y-input')

隐藏层的激活函数是 sigmoid

y = tf.sigmoid(y)

softmax 与 交叉熵(corss entropy) 的组合函数,损失函数是交叉熵的均值

# softmax & corss_entropy

cross_entropy = tf.nn.softmax_cross_entropy_with_logits_v2(labels=y_, logits=y)

# mean

cross_entropy_mean = tf.reduce_mean(cross_entropy)

为了防止神经网络过拟合,需加入正则化项,一般选取 “L2 正则化”

loss = cross_entropy_mean + \

tf.contrib.layers.l2_regularizer(regulation_lamda)(w1) + \

tf.contrib.layers.l2_regularizer(regulation_lamda)(w2)

为了加速神经网络的训练过程,需加入“指数衰减”技术

表示训练过程的计算图,优化方法选择了 Adam 算法,本质是反向传播算法。还可以选择“梯度下降法”(GradientDescentOptimizer)

train_step = tf.train.AdamOptimizer(learning_rate=learning_rate).minimize(loss)

训练阶段

with tf.Session() as sess: # Session 最好在“上下文机制”中开启,以防资源泄露

init_op = tf.global_variables_initializer() # 初始化网络中节点的参数,主要是 w1,w2

sess.run(init_op)

steps = 10000

for i in range(steps):

beg = (i * batch_size) % dataset_size # 计算 batch

end = min(beg+batch_size, dataset_size) # 计算 batch

sess.run(train_step, feed_dict={x:X[beg:end], y_:Y[beg:end]}) # 反向传播,训练网络

if i % 1000 == 0:

total_corss_entropy = sess.run( # 计算交叉熵

cross_entropy_mean, # 计算交叉熵

feed_dict={x:X, y_:Y} # 计算交叉熵

)

print("After %d training steps, cross entropy on all data is %g" % (i, total_corss_entropy))

在训练阶段中,需要引入“滑动平均模型”来提高模型在测试数据上的健壮性(这是书上的说法,而我认为是泛化能力)

全部代码

# -*- encoding=utf8 -*-

from sklearn.datasets import load_iris

import tensorflow as tf

def label_convert(Y):

l = list()

for y in Y:

if y == 0:

l.append([1,0,0])

elif y == 1:

l.append([0, 1, 0])

elif y == 2:

l.append([0, 0, 1])

return l

def load_data():

iris = load_iris()

X = iris.data

Y = label_convert(iris.target)

return (X,Y)

if __name__ == '__main__':

X,Y = load_data()

learning_rate = 0.001

batch_size = 10

dataset_size = 150

regulation_lamda = 0.001

w1 = tf.Variable(tf.random_normal([4,5], stddev=1, seed=1))

w2 = tf.Variable(tf.random_normal([5,3], stddev=1, seed=1))

x = tf.placeholder(tf.float32, shape=(None, 4), name='x-input')

y_ = tf.placeholder(tf.float32, shape=(None, 3), name='y-input')

a = tf.matmul(x, w1)

y = tf.matmul(a, w2)

y = tf.sigmoid(y)

cross_entropy = tf.nn.softmax_cross_entropy_with_logits_v2(labels=y_, logits=y)

cross_entropy_mean = tf.reduce_mean(cross_entropy)

loss = cross_entropy_mean + \

tf.contrib.layers.l2_regularizer(regulation_lamda)(w1) + \

tf.contrib.layers.l2_regularizer(regulation_lamda)(w2)

train_step = tf.train.AdamOptimizer(learning_rate=learning_rate).minimize(loss)

with tf.Session() as sess:

init_op = tf.global_variables_initializer()

sess.run(init_op)

steps = 10000

for i in range(steps):

beg = (i * batch_size) % dataset_size

end = min(beg+batch_size, dataset_size)

sess.run(train_step, feed_dict={x:X[beg:end], y_:Y[beg:end]})

if i % 1000 == 0:

total_corss_entropy = sess.run(

cross_entropy_mean,

feed_dict={x:X, y_:Y}

)

print("After %d training steps, cross entropy on all data is %g" % (i, total_corss_entropy))

print(sess.run(w1))

print(sess.run(w2))

Experiment Result

random split cross validation

Iris Classification on Tensorflow的更多相关文章

- Iris Classification on Keras

Iris Classification on Keras Installation Python3 版本为 3.6.4 : : Anaconda conda install tensorflow==1 ...

- Implementing a CNN for Text Classification in TensorFlow

参考: 1.Understanding Convolutional Neural Networks for NLP 2.Implementing a CNN for Text Classificati ...

- [转] Implementing a CNN for Text Classification in TensorFlow

Github上的一个开源项目,文档讲得极清晰 Github - https://github.com/dennybritz/cnn-text-classification-tf 原文- http:// ...

- Iris Classification on PyTorch

Iris Classification on PyTorch code # -*- coding:utf8 -*- from sklearn.datasets import load_iris fro ...

- CNN tensorflow text classification CNN文本分类的例子

from:http://deeplearning.lipingyang.org/tensorflow-examples-text/ TensorFlow examples (text-based) T ...

- python tensorflow model

step01_formula # -*- coding: utf-8 -*- """ 단순 선형회귀방정식 : x(1) -> y - y = a*X + b (a ...

- Chinese-Text-Classification,用卷积神经网络基于 Tensorflow 实现的中文文本分类。

用卷积神经网络基于 Tensorflow 实现的中文文本分类 项目地址: https://github.com/fendouai/Chinese-Text-Classification 欢迎提问:ht ...

- TensorFlow 中文资源全集,官方网站,安装教程,入门教程,实战项目,学习路径。

Awesome-TensorFlow-Chinese TensorFlow 中文资源全集,学习路径推荐: 官方网站,初步了解. 安装教程,安装之后跑起来. 入门教程,简单的模型学习和运行. 实战项目, ...

- 在 TensorFlow 中实现文本分类的卷积神经网络

在TensorFlow中实现文本分类的卷积神经网络 Github提供了完整的代码: https://github.com/dennybritz/cnn-text-classification-tf 在 ...

随机推荐

- Linux修改SSH登录端口

Linux的默认登录端口为:22,为系统安全运维都会将端口改成其它端口. 假如我们修改的端口为:3000 1.首先要配置防火墙,允许此端口通行. /sbin/iptables -A INPUT -p ...

- MyBatis基础入门《十五》ResultMap子元素(collection)

MyBatis基础入门<十五>ResultMap子元素(collection) 描述: 见<MyBatis基础入门<十四>ResultMap子元素(association ...

- Linux 7.x 设置主机名称

Linux 7.x 设置主机名称 在Linux7.x 版本中,临时设置主机名称使用指令:hostnamectrl set-name 主机名称 [root@localhost ~]# hostname ...

- jQuery-插入内容-新增内容

<!DOCTYPE html PUBLIC "-//W3C//DTD XHTML 1.0 Transitional//EN" "http://www.w3.org/ ...

- netframework转core时文件响应流问题

做将framework webapi项目转成netcore平台上的webapi项目时,发现原来的返回文件响应流在netcore平台下失效.代码如下,返回pdf文件响应流,供前端显示 /// <s ...

- report源码分析——report_object和report_message

uvm的report机制,主要涉及uvm_report_object,uvm_report_handle,uvm_report_server这三个类: uvm_report_object主要是提供uv ...

- WIN32窗口类风格和窗口风格(备查询)

一.WNDCLASS typedef struct { UINT cbSize //这个结构体的长度,一般用sizeof(WNDCLASSEX)设置 UINT style //窗口式样 WNDPROC ...

- 2-1:math库与random库

一.math库: math库是python语言中常用的一个函数库,它包含了一批数学函数,下面我们看一下这个函数库 由于math库中的函数与数学中的函数比较一致,相对比较简单,请同学们自行练习一下: 二 ...

- mysql主从配置,读写分离

Mysql主从配置,实现读写分离 大型网站为了软解大量的并发访问,除了在网站实现分布式负载均衡,远远不够.到了数据业务层.数据访问层,如果还是传统的数据结构,或者只是单单靠一台服务器扛,如此多的数据库 ...

- jQuery文档操作--append()、prepend()、after()和before()

append(content|fn) 概述 向每个匹配的元素内部追加内容,这个操作与对指定的元素执行appendChild方法,将它们添加到文档中的情况类似 参数 content 要追 ...