Flink Table API & SQL 自定义Redis Sink 代码实现

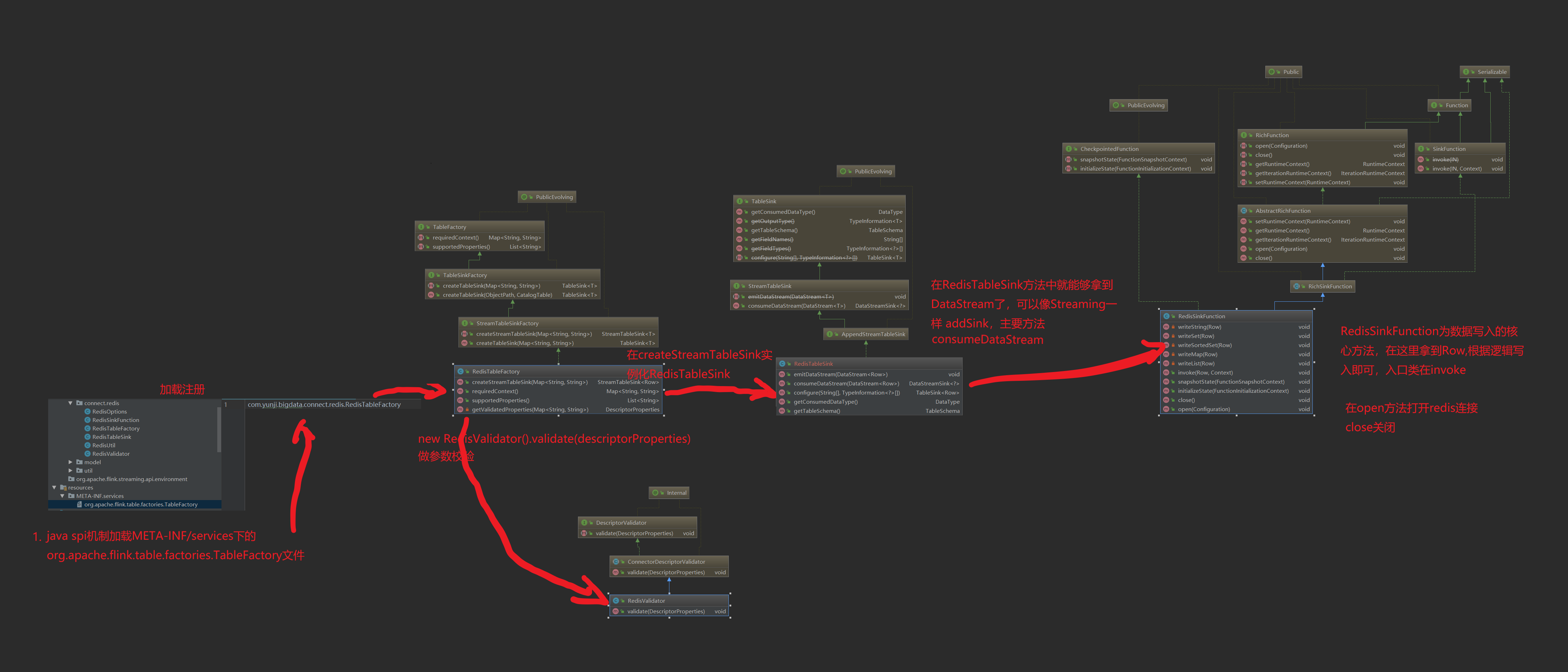

在自定义source&sink这一块官方给的说明并不是很多,需要去看源代码熟悉,自己实现一个redis sink主要需要实现StreamTableSinkFactory,RichSinkFunction和AppendStreamTableSink/RetractStreamTableSink/UpsertStreamTableSink,代码逻辑依赖主要如下

1.定义TableFactory

定义一个TableSinkFactory需要实现以下一个或者多个接口,在这里只实现StreamTableSinkFactory

- BatchTableSourceFactory: Creates a batch table source.

- BatchTableSinkFactory: Creates a batch table sink.

- StreamTableSourceFactory: Creates a stream table source.

- StreamTableSinkFactory: Creates a stream table sink.

- DeserializationSchemaFactory: Creates a deserialization schema format.

- SerializationSchemaFactory: Creates a serialization schema forma

createStreamTableSink():在这里能够拿到ddl的with参数,我们通过getValidatedProperties进行合法性校验,再将参数构建为一个RedisOptions供后续方法使用,tableSchema主要包含ddl语句字段信息,最后返回实例化的RedisTableSink

requiredContext():指定已为此工厂实现的上下文。该框架保证仅在满足指定的属性和值集的情况下才与此工厂匹配。典型的属性可能是connector.type,format.type或update-mode。 为将来的向后兼容情况保留了诸如connect.property-version和format.property-version之类的属性键。

supportedProperties():此工厂可以处理的属性键的列表。此方法将用于验证。如果传递了该工厂无法处理的属性,则将引发异常。该列表不得包含上下文指定的键。

getValidatedProperties():构建DescriptorProperties并作合法性校验

2.定义TableSink

定义一个TableSink可以实现BatchTableSink、RetractStreamTableSink、UpsertStreamTableSink或者AppendStreamTableSink,redis的数据写入,我们按照来一条写一条的思路来实现,不涉及到数据的删除,所以只需要继承AppendStreamTableSink

consumeDataStream():在这里能够拿到数据流,在addSink的时候将实例化的RedisSinkFunction写入方法传进去即可

emitDataStream():已经废弃

configure():拿到的是sql返回字段和类型,在这里我们和tableSchema做一致性校验,必须完全对应才能通过

getConsumedDataType():返回Consumed数据类型

getTableSchema():返回tableSchema信息

3.定义RedisSinkFunction

定义RedisSinkFunction需要继承RichSinkFunction,如果需要在Checkpoint时候做一些事情还可以实现CheckpointedFunction

open():可以在这里构建jedis方法

close():在这里执行销毁或者关闭方法

invoke():数据写入的执行方法,我们这里根据ddl的connector.data.type类型来确定调用的方法,目前先实现了string,set,list,map,sortedset五种

snapshotState():如果是mysql或者hbase那种定时/定量写入方式,可以在这里调用写入方法

4.创建java spi发现目录和文件

在resources目录下创建META-INF/services文件夹,创建一个名为org.apache.flink.table.factories.TableFactory的文件,将com.bigdata.connect.redis.RedisTableFactory写入,如果还有自定义的其他source/sink也一起写在这里

5.打包发布

注意打包的时候一定要确认把com.bigdata.connect.redis.RedisTableFactory打进去了,最好打包完反编译一下看时候被覆盖。我使用maven-assembly-plugin打包就会出现被覆盖的问题,后面改为maven-shade-plugin打包就没问题,所以一定要检查下。

6.遇到的问题

org.apache.flink.table.api.TableException: Table sink does not implement a table schema.

在RedisTableSink中忘记重写getTableSchema方法

org.apache.flink.table.api.TableException: Table sink does not implement a consumed data type.

在RedisTableSink中忘记重写getConsumedDataType方法

org.apache.flink.api.common.InvalidProgramException: root

|-- pay_hour: STRING

|-- item_id: STRING

is not serializable. The object probably contains or references non serializable fields.

在RedisTableSink的emitDataStream方法中将tableSchema传到RedisSinkFunction方法中去,而TableSchema未实现Serializable,出现序列化的问题

org.apache.flink.client.program.ProgramInvocationException: The main method caused an error: The StreamTableSink#consumeDataStream(DataStream) must be implemented and return the sink transformation DataStreamSink. However, com.bigdata.connect.redis.RedisTableSink doesn't implement this method.

使用了废弃的emitDataStream方法,而且没有重写consumeDataStream

7.使用方式

sink使用方法:

参考文档

https://ci.apache.org/projects/flink/flink-docs-release-1.10/dev/table/sourceSinks.html

Flink Table API & SQL 自定义Redis Sink 代码实现的更多相关文章

- 【翻译】Flink Table Api & SQL — 自定义 Source & Sink

本文翻译自官网: User-defined Sources & Sinks https://ci.apache.org/projects/flink/flink-docs-release-1 ...

- Flink Table Api & SQL 翻译目录

Flink 官网 Table Api & SQL 相关文档的翻译终于完成,这里整理一个安装官网目录顺序一样的目录 [翻译]Flink Table Api & SQL —— Overv ...

- 【翻译】Flink Table Api & SQL — SQL客户端Beta 版

本文翻译自官网:SQL Client Beta https://ci.apache.org/projects/flink/flink-docs-release-1.9/dev/table/sqlCl ...

- 【翻译】Flink Table Api & SQL —— 概念与通用API

本文翻译自官网:https://ci.apache.org/projects/flink/flink-docs-release-1.9/dev/table/common.html Flink Tabl ...

- 【翻译】Flink Table Api & SQL —— 连接到外部系统

本文翻译自官网:Connect to External Systems https://ci.apache.org/projects/flink/flink-docs-release-1.9/dev ...

- 【翻译】Flink Table Api & SQL — SQL

本文翻译自官网:SQL https://ci.apache.org/projects/flink/flink-docs-release-1.9/dev/table/sql.html Flink Tab ...

- 【翻译】Flink Table Api & SQL — Hive —— Hive 函数

本文翻译自官网:Hive Functions https://ci.apache.org/projects/flink/flink-docs-release-1.9/dev/table/hive/h ...

- 【翻译】Flink Table Api & SQL —— Overview

本文翻译自官网:https://ci.apache.org/projects/flink/flink-docs-release-1.9/dev/table/ Flink Table Api & ...

- 【翻译】Flink Table Api & SQL —— 数据类型

本文翻译自官网:https://ci.apache.org/projects/flink/flink-docs-release-1.9/dev/table/types.html Flink Table ...

- 【翻译】Flink Table Api & SQL —Streaming 概念 ——在持续查询中 Join

本文翻译自官网 : Joins in Continuous Queries https://ci.apache.org/projects/flink/flink-docs-release-1.9 ...

随机推荐

- drf-day7——认证组件、权限组件、频率组件、过滤排序、分页

目录 一.认证组件 1.1 登录接口 1.2 认证组件使用步骤 1.3 整体代码 1.4认证时cookie的获取方式 二.权限组件 2.1需求分析: 2.2 权限的使用 2.3代码 三.频率组件 3. ...

- CSS 3 所有的选择器整理(2023.2)

你知道的和你不知道的所有选择器.不包含尚未广泛实现的,也不包含已弃用的. 基本的选择器规则(Selector) 类型(Type)选择器 直接用标签匹配特定的元素 span { ... } p { .. ...

- 【踩坑记录】@Transactional注解回滚不生效问题

@Transactional属于是Spring的常用事务处理注解了,最近在开发时偶然发现这个东西竟然不是100%生效的. 问题重现: 测试一个批处理方法,方法上加了@Transactional后执行, ...

- Illegal mix of collations (latin1_swedish_ci,IMPLICIT) and (utf8_general_ci,COERCIBLE) for operation

1.出现问题 查询数据时报如题错误 2.解决方案 建表时需指定字符集,例如: -- ---------------------------- -- Table structure for testTa ...

- python_添加中文编码和脚本

#!/usr/bin/env python 根据环境设置寻找python路径,必须放在第一行 # coding=utf-8 添加中文编码

- 关于联想对Jim博士的质疑

对Jim博士质疑的质疑 因为关注司马南,从他的空间里看到Jim博士和其龃龉,大致看了Jim博士头条里的文章,因为看到自己常用的EPICS,上午匆忙就写了上面的文. Jim博士是去年在头条上看到的,因为 ...

- 【TS】枚举

ts中,枚举类型就是,枚举里面的每个数据值都可以叫做元素,每个元素都有自己的编号,编号是从0开始的,依次递增加1 , 语法: enum 枚举名 {} 此处定义一个枚举类型,例如: enum Color ...

- selenium结合tenacity的retry实现验证码失败重试

说在前面 验证码登录的demo后续可以单独讲解,VIP学员对这部分应该都是掌握的,此处不再赘述 本文假设了一个场景 你通过OCR识别的验证码是有一定的错误几率的 本文是通过识别后的验证码去加一个随机字 ...

- Openfoam Pstream类探索

对于数值仿真而言,无论是商软或者开源并行计算都是非常重要的,而且想把自身数值仿真能力提升一个层次,必须对并行计算有很好的理解与应用 openfoam并行通信主要通过Pstream类完成 本篇文章进行说 ...

- CF1638E Colorful Operations

\(\text{Solution}\) \(\text{code}\) #include <cstdio> #include <iostream> #include <s ...