哈工大LTP基本使用-分词、词性标注、依存句法分析、命名实体识别、角色标注

代码

import os

from pprint import pprint

from pyltp import Segmentor, Postagger, Parser, NamedEntityRecognizer, SementicRoleLabeller

class LtpParser:

def __init__(self):

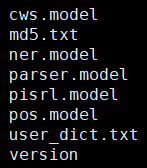

LTP_DIR = "../model/ltp_data_v3.4.0/"

self.segmentor = Segmentor()

# load_with_lexicon用于加载自定义的词典

self.segmentor.load_with_lexicon(os.path.join(LTP_DIR, "cws.model"),os.path.join(LTP_DIR, "user_dict.txt"))

self.postagger = Postagger()

self.postagger.load_with_lexicon(os.path.join(LTP_DIR, "pos.model"),os.path.join(LTP_DIR, "user_dict.txt"))

self.parser = Parser()

self.parser.load(os.path.join(LTP_DIR, "parser.model"))

self.recognizer = NamedEntityRecognizer()

self.recognizer.load(os.path.join(LTP_DIR, "ner.model"))

self.labeller = SementicRoleLabeller()

self.labeller.load(os.path.join(LTP_DIR, 'pisrl.model'))

def analyse(self, text):

# 分词

segmentor_res = self.segmentor.segment(text)

print(list(segmentor_res))

# 词性标注,传入的是分词的结果

postagger_res = self.postagger.postag(segmentor_res)

print(list(postagger_res))

# 命名实体识别,传入的是分词、词性标注的结果

# 依存句法分析,传入的是分词、词性标注的结果

arcs = self.parser.parse(segmentor_res, postagger_res)

# print("\t".join("%d:%s" % (arc.head, arc.relation) for arc in arcs))

arcs_res = []

for word, arc in zip(list(segmentor_res), arcs):

tmp = {}

if arc.head == 0:

tmp['dep'] = word

tmp['gov'] = 'ROOT'

tmp['pos'] = arc.relation

else:

tmp['dep'] = word

tmp['gov'] = segmentor_res[arc.head-1]

tmp['pos'] = arc.relation

arcs_res.append(tmp)

pprint(arcs_res)

# 语义角色标注,传入的是分词、词性标注、句法分析结果

labeller_res = self.labeller.label(segmentor_res, postagger_res, arcs)

for role in labeller_res:

print (role.index, "\t".join(["%s:(%d,%d)-(%s)" % (arg.name, arg.range.start, arg.range.end, "".join(list(segmentor_res)[arg.range.start:arg.range.end+1])) for arg in role.arguments]))

if __name__ == '__main__':

ltpParser = LtpParser()

text = "中国是一个自由、和平的国家"

ltpParser.analyse(text)

结果

['中国', '是', '一个', '自由', '、', '和平', '的', '国家']

['ns', 'v', 'm', 'a', 'wp', 'a', 'u', 'n']

['S-Ns', 'O', 'O', 'O', 'O', 'O', 'O', 'O']

[{'dep': '中国', 'gov': '是', 'pos': 'SBV'},

{'dep': '是', 'gov': 'ROOT', 'pos': 'HED'},

{'dep': '一个', 'gov': '国家', 'pos': 'ATT'},

{'dep': '自由', 'gov': '国家', 'pos': 'ATT'},

{'dep': '、', 'gov': '和平', 'pos': 'WP'},

{'dep': '和平', 'gov': '自由', 'pos': 'COO'},

{'dep': '的', 'gov': '自由', 'pos': 'RAD'},

{'dep': '国家', 'gov': '是', 'pos': 'VOB'}]

1 A0:(0,0)-(中国) A1:(2,7)-(一个自由、和平的国家)

哈工大LTP基本使用-分词、词性标注、依存句法分析、命名实体识别、角色标注的更多相关文章

- 学习笔记CB007:分词、命名实体识别、词性标注、句法分析树

中文分词把文本切分成词语,还可以反过来,把该拼一起的词再拼到一起,找到命名实体. 概率图模型条件随机场适用观测值条件下决定随机变量有有限个取值情况.给定观察序列X,某个特定标记序列Y概率,指数函数 e ...

- 使用哈工大LTP进行文本命名实体识别并保存到txt

版权声明:本文为博主原创文章,遵循 CC 4.0 BY-SA 版权协议,转载请附上原文出处链接和本声明.本文链接:https://blog.csdn.net/broccoli2/article/det ...

- HMM(隐马尔科夫模型)与分词、词性标注、命名实体识别

转载自 http://www.cnblogs.com/skyme/p/4651331.html HMM(隐马尔可夫模型)是用来描述隐含未知参数的统计模型,举一个经典的例子:一个东京的朋友每天根据天气{ ...

- HMM与分词、词性标注、命名实体识别

http://www.hankcs.com/nlp/hmm-and-segmentation-tagging-named-entity-recognition.html HMM(隐马尔可夫模型)是用来 ...

- PyTorch 高级实战教程:基于 BI-LSTM CRF 实现命名实体识别和中文分词

前言:译者实测 PyTorch 代码非常简洁易懂,只需要将中文分词的数据集预处理成作者提到的格式,即可很快的就迁移了这个代码到中文分词中,相关的代码后续将会分享. 具体的数据格式,这种方式并不适合处理 ...

- ZH奶酪:哈工大LTP云平台标记含义及性能

从官网搬过来的 囧rz 哈工大讯飞语言云 由哈工大 和科大讯飞 联合研发的中文自然语言处理云服务平台.结合了哈工大“语言技术平台——LTP” 高效.精准的自然语言处理核心技术和讯飞公司在全国性大规模云 ...

- HanLP分词命名实体提取详解

HanLP分词命名实体提取详解 分享一篇大神的关于hanlp分词命名实体提取的经验文章,文章中分享的内容略有一段时间(使用的hanlp版本比较老),最新一版的hanlp已经出来了,也可以去看看新版 ...

- nlp 总结 分词,词义消歧,词性标注,命名体识别,依存句法分析,语义角色标注

分词 中文分词 (Word Segmentation, WS) 指的是将汉字序列切分成词序列. 因为在汉语中,词是承载语义的最基本的单元.分词是信息检索.文本分类.情感分析等多项中文自然语言处理任务的 ...

- 3. 哈工大LTP解析

1. 通俗易懂解释知识图谱(Knowledge Graph) 2. 知识图谱-命名实体识别(NER)详解 3. 哈工大LTP解析 1. 前言 哈工大语言技术平台Language Technology ...

随机推荐

- Oracle数据库的函数

一.字符函数upper和lower (1).upper和lower upper把小写的字符转换成大小的字符 ,lower把大写字符变成小写字符 . select upper('yes') from d ...

- DRF的封装:APIView类及五大模块

目录 一.drf框架的封装特点 1.APIView类 二.drf的基础组件 1.请求模块 1.1 请求模块做了什么 1.2 请求request参数 2.解析模块 3.响应模块 4.渲染模块(了解) 5 ...

- TextView 的append后面 马上调用fullScroll(),会发现无法滚动到真正的底部

如果在TextView的append后面马上调用fullScroll,会发现无法滚动到真正的底部,这是因为Android下很多(如果不是全部的话)函数都是基于消息的,用消息队列来保证同步,所以函数调用 ...

- 解决springboot项目打成jar包部署到linux服务器后上传图片无法访问的问题

前言:目前大三,自己也在学习和摸索的阶段.在和学校的同学一起做前后端分离项目的时候,我们发现将后端打包成jar,然后部署到服务器中通过java -jar xxx.jar运行项目以后,项目中存在文件上传 ...

- 2020年12月-第02阶段-前端基础-CSS字体样式

CSS字体样式属性调试工具 应用 使用css字体样式完成对字体的设置 使用css外观属性给页面元素添加样式 1.font字体 1.1 font-size:大小 作用: font-size属性用于设置字 ...

- Apache配置 11. 访问控制-user_agent

(1)介绍 user_agent是指用户浏览器端的信息.比如你是用IE的还是Firefox浏览器的.有些网站会根据这个来调整打开网站的类型,如是手机的就打开wap,显示非手机的就打开PC常规页面. ( ...

- SPOJ QTree【树链剖分】

一 题目 QTREE 二 分析 第一道树链剖分的题,写的好艰难啊. 题意还是比较好理解的,就是在树上操作. 对于修改,题中要求的是单点修改,就算是直接树上操作也是非常简单的. 对于查询,查询的时候,是 ...

- 2019 GDUT Rating Contest I : Problem A. The Bucket List

题面: A. The Bucket List Input file: standard input Output file: standard output Time limit: 1 second Me ...

- 正则表达式-Python实现

1.概述: Regular Expression.缩写regex,regexp,R等: 正则表达式是文本处理极为重要的工具.用它可以对字符串按照某种规则进行检索,替换. Shell编程和高级编程语言中 ...

- 让你的浏览器变成Siri一样的语音助手

最近业余时间浏览技术文章的时候,看到了一篇关于语音朗读的文章:Use JavaScript to Make Your Browser Speak(用Javascript让你的浏览器说话),文章中提到可 ...