Hadoop框架:HDFS读写机制与API详解

本文源码:GitHub·点这里 || GitEE·点这里

一、读写机制

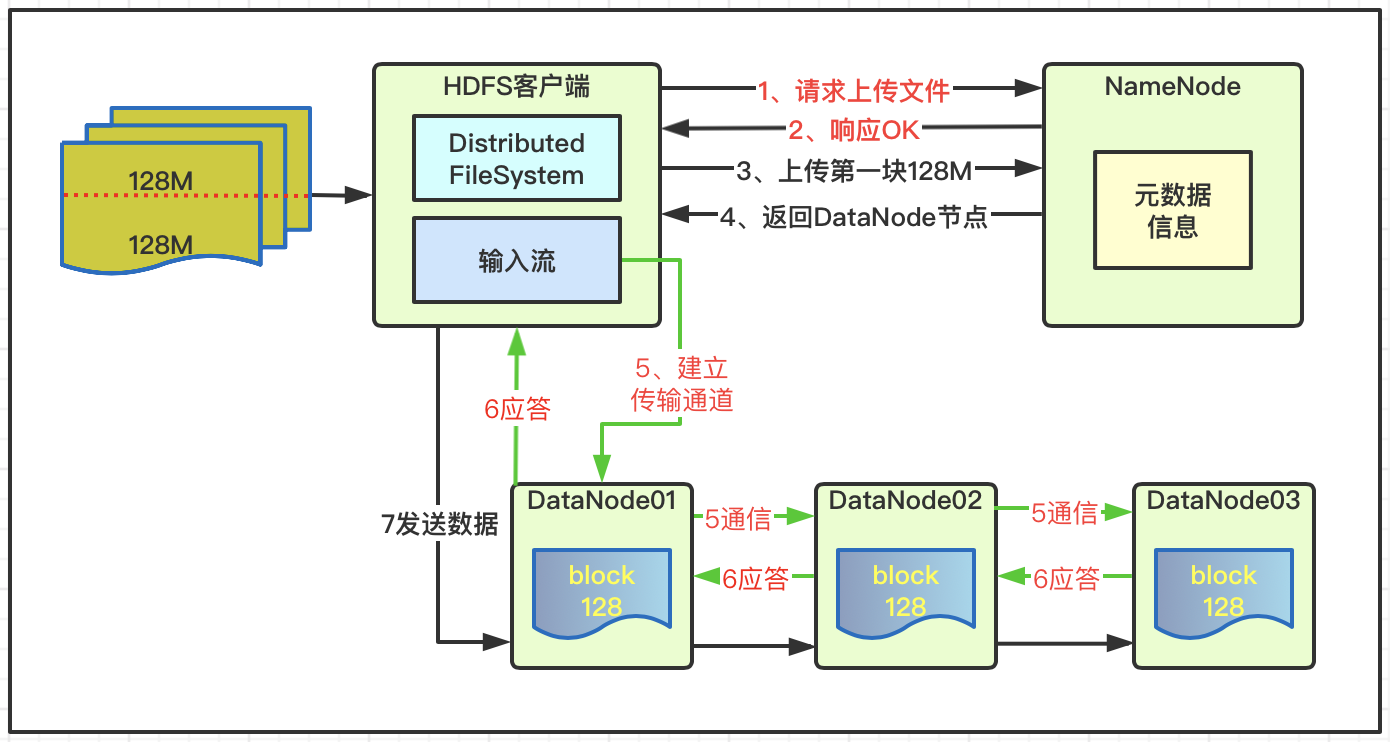

1、数据写入

- 客户端访问NameNode请求上传文件;

- NameNode检查目标文件和目录是否已经存在;

- NameNode响应客户端是否可以上传;

- 客户端请求NameNode文件块Block01上传服务位置;

- NameNode响应返回3个DataNode节点;

- 客户端通过输入流建立DataNode01传输通道;

- DataNode01调用DataNode02,DataNode02调用DataNode03,通信管道建立完成;

- DataNode01、DataNode02、DataNode03逐级应答客户端。

- 客户端向DataNode01上传第一个文件块Block;

- DataNode01接收后传给DataNode02,DataNode02传给DataNode03;

- Block01传输完成之后,客户端再次请求NameNode上传第二个文件块;

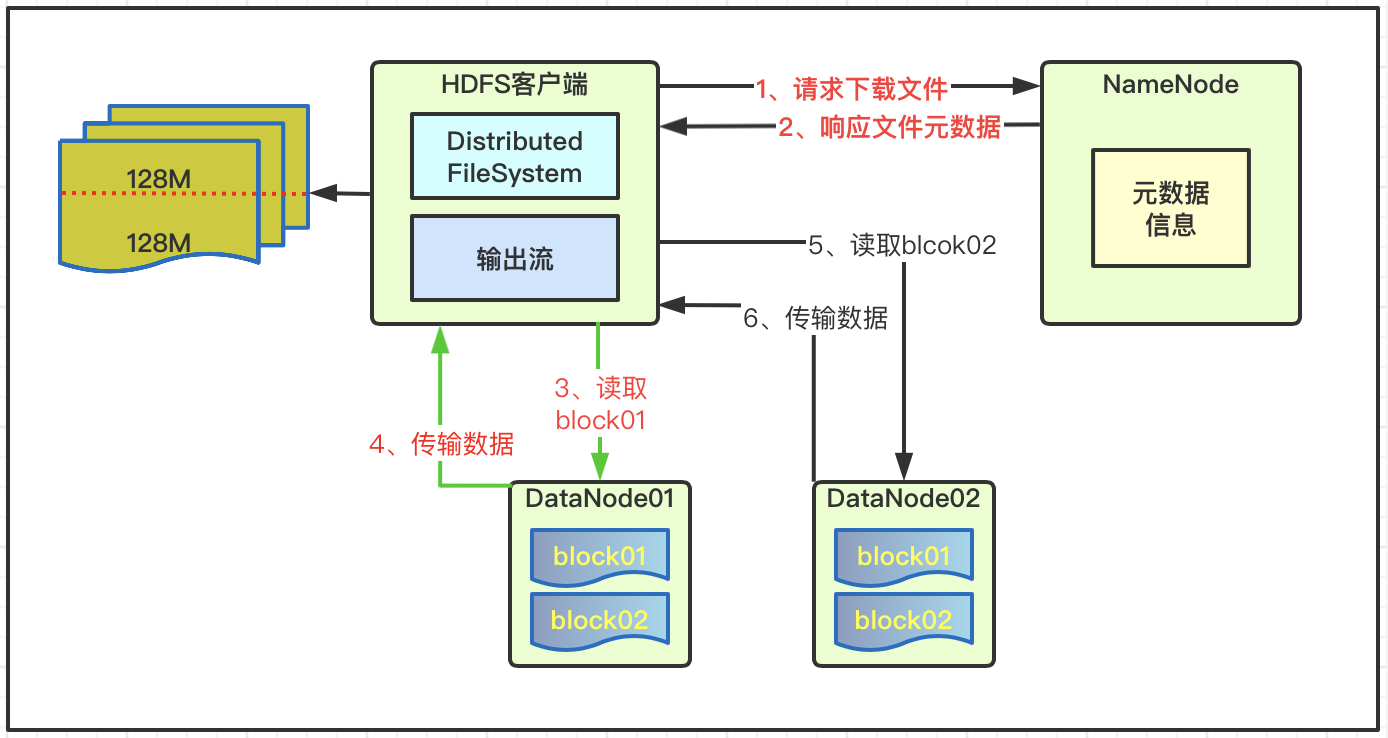

2、数据读取

- 客户端通过向NameNode请求下载文件;

- NameNode查询获取文件元数据并返回;

- 客户端通过元数据信息获取文件DataNode地址;

- 就近原则选择一台DataNode服务器,请求读取数据;

- DataNode传输数据返回给客户端;

- 客户端以本地处理目标文件;

二、基础API案例

1、基础演示接口

public interface HdfsFileService {

// 创建文件夹

void mkdirs(String path) throws Exception ;

// 文件判断

void isFile(String path) throws Exception ;

// 修改文件名

void reName(String oldFile, String newFile) throws Exception ;

// 文件详情

void fileDetail(String path) throws Exception ;

// 文件上传

void copyFromLocalFile(String local, String path) throws Exception ;

// 拷贝到本地:下载

void copyToLocalFile(String src, String dst) throws Exception ;

// 删除文件夹

void delete(String path) throws Exception ;

// IO流上传

void ioUpload(String path, String local) throws Exception ;

// IO流下载

void ioDown(String path, String local) throws Exception ;

// 分块下载

void blockDown(String path, String local1, String local2) throws Exception ;

}

2、命令API用法

@Service

public class HdfsFileServiceImpl implements HdfsFileService {

@Resource

private HdfsConfig hdfsConfig ;

@Override

public void mkdirs(String path) throws Exception {

// 1、获取文件系统

Configuration configuration = new Configuration();

FileSystem fileSystem = FileSystem.get(new URI(hdfsConfig.getNameNode()),

configuration, "root");

// 2、创建目录

fileSystem.mkdirs(new Path(path));

// 3、关闭资源

fileSystem.close();

}

@Override

public void isFile(String path) throws Exception {

// 1、获取文件系统

Configuration configuration = new Configuration();

FileSystem fileSystem = FileSystem.get(new URI(hdfsConfig.getNameNode()),

configuration, "root");

// 2、判断文件和文件夹

FileStatus[] fileStatuses = fileSystem.listStatus(new Path(path));

for (FileStatus fileStatus : fileStatuses) {

if (fileStatus.isFile()) {

System.out.println("文件:"+fileStatus.getPath().getName());

}else {

System.out.println("文件夹:"+fileStatus.getPath().getName());

}

}

// 3、关闭资源

fileSystem.close();

}

@Override

public void reName(String oldFile, String newFile) throws Exception {

// 1、获取文件系统

Configuration configuration = new Configuration();

FileSystem fileSystem = FileSystem.get(new URI(hdfsConfig.getNameNode()),

configuration, "root");

// 2、修改文件名

fileSystem.rename(new Path(oldFile), new Path(newFile));

// 3、关闭资源

fileSystem.close();

}

@Override

public void fileDetail(String path) throws Exception {

// 1、获取文件系统

Configuration configuration = new Configuration();

FileSystem fileSystem = FileSystem.get(new URI(hdfsConfig.getNameNode()),

configuration, "root");

// 2、读取文件详情

RemoteIterator<LocatedFileStatus> listFiles =

fileSystem.listFiles(new Path(path), true);

while(listFiles.hasNext()){

LocatedFileStatus status = listFiles.next();

System.out.println("文件名:"+status.getPath().getName());

System.out.println("文件长度:"+status.getLen());

System.out.println("文件权限:"+status.getPermission());

System.out.println("所属分组:"+status.getGroup());

// 存储块信息

BlockLocation[] blockLocations = status.getBlockLocations();

for (BlockLocation blockLocation : blockLocations) {

// 块存储的主机节点

String[] hosts = blockLocation.getHosts();

for (String host : hosts) {

System.out.print(host+";");

}

}

System.out.println("==============Next==============");

}

// 3、关闭资源

fileSystem.close();

}

@Override

public void copyFromLocalFile(String local, String path) throws Exception {

// 1、获取文件系统

Configuration configuration = new Configuration();

FileSystem fileSystem = FileSystem.get(new URI(hdfsConfig.getNameNode()),

configuration, "root");

// 2、执行上传操作

fileSystem.copyFromLocalFile(new Path(local), new Path(path));

// 3、关闭资源

fileSystem.close();

}

@Override

public void copyToLocalFile(String src,String dst) throws Exception {

// 1、获取文件系统

Configuration configuration = new Configuration();

FileSystem fileSystem = FileSystem.get(new URI(hdfsConfig.getNameNode()),

configuration, "root");

// 2、执行下载操作

// src 服务器文件路径 ; dst 文件下载到的路径

fileSystem.copyToLocalFile(false, new Path(src), new Path(dst), true);

// 3、关闭资源

fileSystem.close();

}

@Override

public void delete(String path) throws Exception {

// 1、获取文件系统

Configuration configuration = new Configuration();

FileSystem fileSystem = FileSystem.get(new URI(hdfsConfig.getNameNode()),

configuration, "root");

// 2、删除文件或目录 是否递归

fileSystem.delete(new Path(path), true);

// 3、关闭资源

fileSystem.close();

}

@Override

public void ioUpload(String path, String local) throws Exception {

// 1、获取文件系统

Configuration configuration = new Configuration();

FileSystem fileSystem = FileSystem.get(new URI(hdfsConfig.getNameNode()),

configuration, "root");

// 2、输入输出流

FileInputStream fis = new FileInputStream(new File(local));

FSDataOutputStream fos = fileSystem.create(new Path(path));

// 3、流对拷

IOUtils.copyBytes(fis, fos, configuration);

// 4、关闭资源

IOUtils.closeStream(fos);

IOUtils.closeStream(fis);

fileSystem.close();

}

@Override

public void ioDown(String path, String local) throws Exception {

// 1、获取文件系统

Configuration configuration = new Configuration();

FileSystem fileSystem = FileSystem.get(new URI(hdfsConfig.getNameNode()),

configuration, "root");

// 2、输入输出流

FSDataInputStream fis = fileSystem.open(new Path(path));

FileOutputStream fos = new FileOutputStream(new File(local));

// 3、流对拷

IOUtils.copyBytes(fis, fos, configuration);

// 4、关闭资源

IOUtils.closeStream(fos);

IOUtils.closeStream(fis);

fileSystem.close();

}

@Override

public void blockDown(String path,String local1,String local2) throws Exception {

readFileSeek01(path,local1);

readFileSeek02(path,local2);

}

private void readFileSeek01(String path,String local) throws Exception {

// 1、获取文件系统

Configuration configuration = new Configuration();

FileSystem fileSystem = FileSystem.get(new URI(hdfsConfig.getNameNode()),

configuration, "root");

// 2、输入输出流

FSDataInputStream fis = fileSystem.open(new Path(path));

FileOutputStream fos = new FileOutputStream(new File(local));

// 3、部分拷贝

byte[] buf = new byte[1024];

for(int i =0 ; i < 1024 * 128; i++){

fis.read(buf);

fos.write(buf);

}

// 4、关闭资源

IOUtils.closeStream(fos);

IOUtils.closeStream(fis);

fileSystem.close();

}

private void readFileSeek02(String path,String local) throws Exception {

// 1、获取文件系统

Configuration configuration = new Configuration();

FileSystem fileSystem = FileSystem.get(new URI(hdfsConfig.getNameNode()),

configuration, "root");

// 2、输入输出流

FSDataInputStream fis = fileSystem.open(new Path(path));

// 定位输入数据位置

fis.seek(1024*1024*128);

FileOutputStream fos = new FileOutputStream(new File(local));

// 3、流拷贝

IOUtils.copyBytes(fis, fos, configuration);

// 4、关闭资源

IOUtils.closeStream(fos);

IOUtils.closeStream(fis);

fileSystem.close();

}

}

3、合并切割文件

cat hadoop-2.7.2.zip.block1 hadoop-2.7.2.zip.block2 > hadoop.zip

三、机架感知

Hadoop2.7的文档说明

第一个副本和client在一个节点里,如果client不在集群范围内,则这第一个node是随机选取的;第二个副本和第一个副本放在相同的机架上随机选择;第三个副本在不同的机架上随机选择,减少了机架间的写流量,通常可以提高写性能,机架故障的概率远小于节点故障的概率,因此该策略不会影响数据的稳定性。

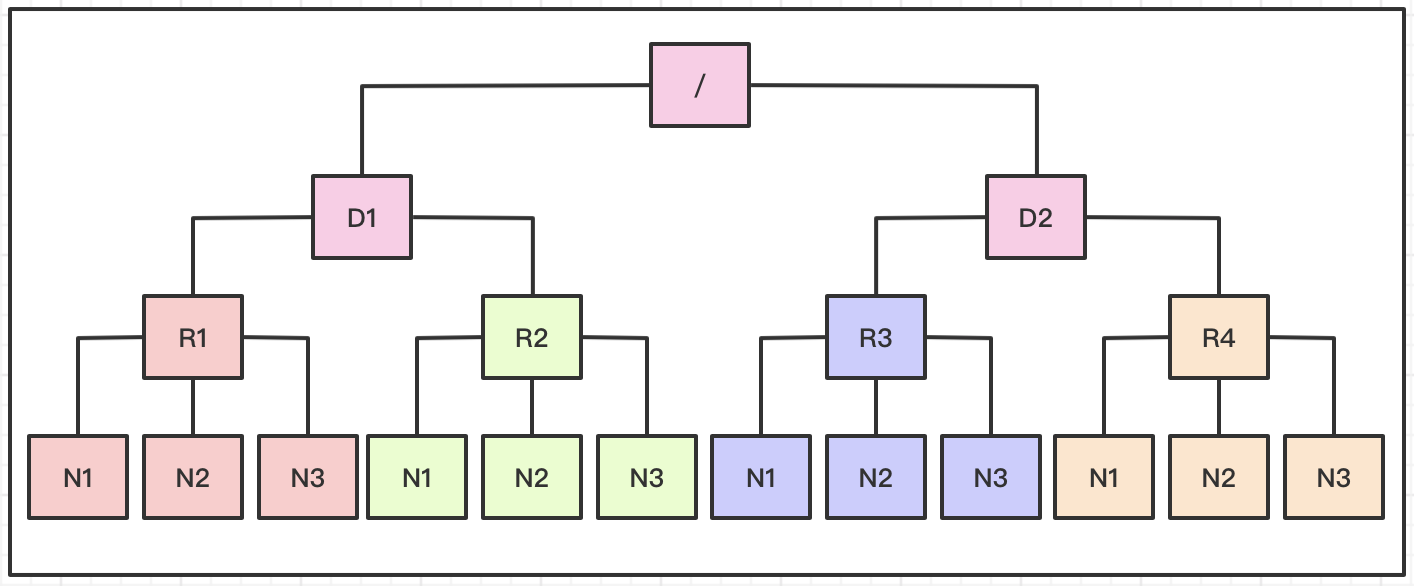

四、网络拓扑

HDFS写数据的过程中,NameNode会选择距离待上传数据最近距离的DataNode接收数据,基于机架感知,NameNode就可以画出上图所示的datanode网络拓扑图。D1,R1都是交换机,最底层是datanode。

Distance(/D1/R1/N1,/D1/R1/N1)=0 相同的节点

Distance(/D1/R1/N1,/D1/R1/N2)=2 同一机架下的不同节点

Distance(/D1/R1/N1,/D1/R2/N1)=4 同一IDC下的不同datanode

Distance(/D1/R1/N1,/D2/R3/N1)=6 不同IDC下的datanode

五、源代码地址

GitHub·地址

https://github.com/cicadasmile/big-data-parent

GitEE·地址

https://gitee.com/cicadasmile/big-data-parent

推荐阅读:编程体系整理

| 序号 | 项目名称 | GitHub地址 | GitEE地址 | 推荐指数 |

|---|---|---|---|---|

| 01 | Java描述设计模式,算法,数据结构 | GitHub·点这里 | GitEE·点这里 | ☆☆☆☆☆ |

| 02 | Java基础、并发、面向对象、Web开发 | GitHub·点这里 | GitEE·点这里 | ☆☆☆☆ |

| 03 | SpringCloud微服务基础组件案例详解 | GitHub·点这里 | GitEE·点这里 | ☆☆☆ |

| 04 | SpringCloud微服务架构实战综合案例 | GitHub·点这里 | GitEE·点这里 | ☆☆☆☆☆ |

| 05 | SpringBoot框架基础应用入门到进阶 | GitHub·点这里 | GitEE·点这里 | ☆☆☆☆ |

| 06 | SpringBoot框架整合开发常用中间件 | GitHub·点这里 | GitEE·点这里 | ☆☆☆☆☆ |

| 07 | 数据管理、分布式、架构设计基础案例 | GitHub·点这里 | GitEE·点这里 | ☆☆☆☆☆ |

| 08 | 大数据系列、存储、组件、计算等框架 | GitHub·点这里 | GitEE·点这里 | ☆☆☆☆☆ |

Hadoop框架:HDFS读写机制与API详解的更多相关文章

- 大数据学习笔记——Spark工作机制以及API详解

Spark工作机制以及API详解 本篇文章将会承接上篇关于如何部署Spark分布式集群的博客,会先对RDD编程中常见的API进行一个整理,接着再结合源代码以及注释详细地解读spark的作业提交流程,调 ...

- Hadoop(9)-HDFS的NameNode和SecondaryNameNode详解

1.NN和2NN工作机制 首先,我们做个假设,如果存储在NameNode节点的磁盘中,因为经常需要进行随机访问,还有响应客户请求,必然是效率过低.因此,元数据需要存放在内存中.但如果只存在内存中,一旦 ...

- HDFS常用的Java Api详解

转自:http://blog.csdn.net/michaelwubo/article/details/50879832 一.使用Hadoop URL读取数据 package hadoop; impo ...

- hibernate框架学习笔记3:API详解

Configuration对象: package api; import org.hibernate.SessionFactory; import org.hibernate.cfg.Configur ...

- 百度地图API详解之事件机制,function“闭包”解决for循环和监听器冲突的问题:

原文:百度地图API详解之事件机制,function"闭包"解决for循环和监听器冲突的问题: 百度地图API详解之事件机制 2011年07月26日 星期二 下午 04:06 和D ...

- 转】Mahout推荐算法API详解

原博文出自于: http://blog.fens.me/mahout-recommendation-api/ 感谢! Posted: Oct 21, 2013 Tags: itemCFknnMahou ...

- SDN 网络系统之 Mininet 与 API 详解

SDN 网络系统之 Mininet 与 API 详解 Mininet 是轻量级的软件定义网络系统平台,同时提供了对 OpenFlow 协议的支持.本文主要介绍了 Mininet 的相关概念与特性,并列 ...

- Webdriver之API详解(1)

说明 Webdriver API详解,基于python3,unittest框架,driver版本和浏览器自行选择. 本内容需要对python3的unittest框架有一个简单的了解,这里不再赘述,不了 ...

- Java8学习笔记(五)--Stream API详解[转]

为什么需要 Stream Stream 作为 Java 8 的一大亮点,它与 java.io 包里的 InputStream 和 OutputStream 是完全不同的概念.它也不同于 StAX 对 ...

随机推荐

- Java高级特性——反射机制(第二篇)

在Java高级特性——反射机制(第一篇)中,写了很多反射的实例,可能对于Class的了解还是有点迷糊,那么我们试着从内存角度去分析一下. Java内存 从上图可以看出,Java将内存分为堆.栈.方法区 ...

- [CSP-S2019]划分 题解

CSP-S2 2019 D2T2 考场上读完题感觉是DP就直接扔了开T3了,考完才发现部分分好像不难拿,枯了 题意分析 给出一个数列,要求将其分成几段,使每段的和非严格递增,求最小的每段的和的平方和. ...

- 使用 Postman 做 API 自动化测试

Postman 最基本的功能用来重放请求,并且配合良好的 response 格式化工具. 高级点的用法可以使用 Postman 生成各个语言的脚本,还可以抓包,认证,传输文件. 仅仅做到这些还不能够满 ...

- 深入理解C++中的new/delete和malloc/free动态内存管理

malloc/free和new/delete的区别 malloc/free是C/C++标准库的函数:new/delete是C++操作符. malloc/free只是动态分配内存空间/释放空间:new/ ...

- QT_QGIS_基本使用

QT_QGIS_基本使用 1.新建画布 2.添加矢量图层 1.打开矢量图层 2.新建矢量图层 1.添加几何要素--点 2.添加几何要素--线 3.添加栅格图层 1.打开栅格图层 小 ...

- APM姿态控制流程

对初学者了解控制流程有一定帮助 在主循环执行过程中(比如Pixhawk的任务调度周期2.5ms,400Hz:APM2.x为10ms,100Hz),每一个周期,程序会按下述步骤执行:• 首先,高层次文件 ...

- 前端修仙之路---一、如何用gulp搭建一套web前端开发框架

引言 相信从事web前端开发的朋友都知道,现在流行的Vue.AngularJS等框架中,它们都有独立的脚手架来创建项目,比如Vue有vue-cli,Angular有angula-cli.脚手架可以一键 ...

- Labview学习之路(八)如何让控件显示在修饰符的前面

在Labview2017版本中,前面板选择修饰控件,会出现部分修饰控件会掩盖其他控件,情况如下: 我们右键点击和属性中都没有相关属性的改变,为什么是这样我也不清除: 上网查了一下,看到其他版本会有显示 ...

- SpringBoot中JPA,返回List排序

这里简单示例,利用query,根据“createtime”字段,进行 desc 排序,最近日期的数据在最前面. public List<StatusEvent> findAll(Speci ...

- 关于java的二维码的生成与解析

本文说的是通过zxing实现二维码的生成与解析,看着很简单,直接上代码 import java.io.File; import java.io.IOException; import java.nio ...